时隔六年!OpenAI 首发 GPT-OSS 120B / 20B 开源模型:性能、安全与授权细节全解

为什么这次开放值得关注?

OpenAI 时隔六年再次“放权重”,一次性公布 gpt-oss-120b 与 gpt-oss-20b 两个尺寸,并允许商业化二次开发 —— 采用 Apache 2.0 许可且可直接在 Hugging Face 下载(WIRED)。官方表示,开放旨在 降低门槛、扩大安全研究样本,同时给社区更大的定制自由(WIRED)。

一、发布概览:首次开源级权重释放

-

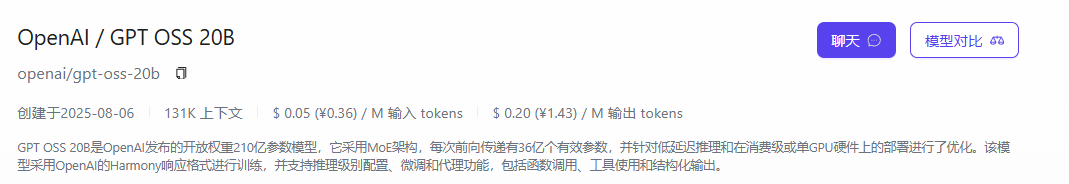

双版本:gpt-oss-120b(≈117 B 参数、36 层 MoE)与 gpt-oss-20b(≈21 B 参数、24 层),全部模型权重可自由下载。OpenAI

-

许可证:两款模型均采用 Apache 2.0,允许商业部署、再分发及二次微调,无需回馈源代码。WIRED

-

开放意义:这是 OpenAI 自 GPT-2 以来首度开放主流语言模型权重,意在降低开发门槛、鼓励社区安全研究与定制化创新。WIRED

二、性能:小体积对标中端专有模型

| 关键基准 | gpt-oss-120b | gpt-oss-20b | 对比参考 |

| 复杂推理 (MMLU) | ≈ o4-mini 同级 | ≈ o3-mini 同级 | 竞品 LLAMA 4 |

| 竞赛数学 (AIME 2024/25) | 超越 o4-mini | 逼近 o3-mini | – |

| 代码能力 (Codeforces) | 追平 o4-mini | 超过 o3-mini | – |

官方评测显示,120B 版在推理、代码、健康问答等任务上可与 o4-mini 持平或小幅领先;20B 版则在 16 GB 消费级 GPU 上跑出 o3-mini 级成绩,适合边缘部署与本地迭代。OpenAIReuters

三、部署与成本:单卡即可落地

-

硬件需求:120B 版在 80 GB GPU 即可单卡推理;20B 版仅需 16 GB 显存即可桌面级运行。OpenAIReuters

-

效率设计:MoE 架构仅激活 3.6–5.1 B 活跃参数,配合 MXFP-4 量化,显著降低显存占用与功耗。Hugging Face

-

多场景可用:OpenAI 与 Azure、Hugging Face、vLLM、llama.cpp 等生态已完成适配,开发者可一键部署。OpenAI

四、安全基线与风险缓解

-

安全训练:在 RLHF 阶段加入“最坏情况微调”测试,并通过 OpenAI Preparedness Framework 审核,未触达到高风险阈值。OpenAI+1

-

公开红队挑战:OpenAI 同步启动 50 万美元赏金计划,鼓励社区发现潜在滥用路径。OpenAI

-

开发者须知:开权重意味着您必须自行加装内容过滤、速率限制与监控,才能复现 API 级安全防护。OpenAI

五、授权细节与合规要点

| 条款 | Apache 2.0 要点 | 对开发者影响 |

| 商用许可 | 可商业化、闭源发行,无版税 | 直接嵌入自家产品或服务 |

| 责任声明 | 免除作者责任,用户自担风险 | 部署方需承担合规审核 |

| 变更与分发 | 允许修改、再分发 | 可结合私有数据微调后再出售 |

与 CC BY-SA、GPL 等“传染式”协议不同,Apache 2.0 没有代码开源义务,是当前最宽松的 LLM 许可证之一。

六、快速上手的两条典型路径

1.自建 —— 适合已有 GPU 资源的团队:

-

使用 vLLM + TensorRT-LLM 加速 MoE 路由。

-

按需启用 4-bit 量化,16 GB 卡亦可推理 20B。

2.托管 —— 不想运维集群?可直接接入国内多云算力聚合平台。

-

例如 胜算云 提供“一键 Key” 统一调用 GPT-OSS 与百余款模型;

-

智能路由与秒级弹性调度,实践中 模型算力成本可削减至自建的 50 % – 80 %。

-

对初创团队意味着 零预租、随用随付,也能在峰值并发下保持低延迟体验。

GPT-OSS 120B / 20B API 快速调用示例:

打开VS Code——搜索Cline-中文版或Cline-Chinese——按照插件点击获取API——完成注册自动填入API——选择GPT-OSS 120B / 20B.

结语

GPT-OSS 的开放让“可重训练、可私有化”的高性能语言模型正式进入主流视野。无论你是打算在消费级设备上跑 20B,还是需要大型生产环境的 120B,趁着 Apache 2.0 的宽松条款与成熟的云端生态,把握窗口期,才是抓住下一轮 AI 创新的关键。如果想省去运维、聚焦业务逻辑,像胜算云这类聚合平台也为“开权重”时代提供了更轻盈的落地选项。