大模型备案材料—《安全评估报告》撰写指南

大模型备案已经是个老生常谈的话题了,但是备案材料一直都是大家比较头疼的点。我最近有5家客户刚好通过了大模型备案,结合经验,给大家分享下大模型备案中最重要的材料——《安全评估报告》内容详解。

撰写大模型安全评估报告需遵循 “合规导向、逻辑清晰、内容详实、证据支撑” 原则,严格对标《生成式人工智能服务安全基本要求》、《生成式人工智能服务管理暂行办法》等法规标准,确保报告具备专业性、可追溯性和可验证性。

一、安全评估报告的核心框架

(1)评估基础信息

核心作用:明确报告背景、对象、范围,为后续评估定调

必备要素:评估主体、评估对象、评估依据、评估时间 / 周期

(2)评估方法与工具

核心作用:证明评估过程的科学性、客观性,避免主观判断

必备要素:评估方法、工具(如漏洞扫描器)、样本来源

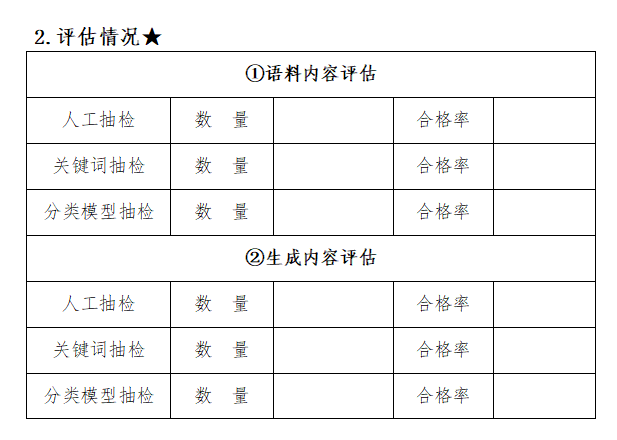

(3)分项安全评估

核心作用:按合规要求拆解评估维度,逐一验证安全性

必备要素:每个维度的 “风险点 - 措施 - 验证结果”

(4)安全事件应急能力

核心作用:评估风险应对的有效性,体现持续保障能力

必备要素:应急预案、演练记录、资源储备

(5)合规性验证

核心作用:锚定法律法规要求,证明无合规漏洞

必备要素:对标条款、符合性说明、佐证材料

(6)风险汇总与整改

核心作用:梳理未解决风险,提出可落地的改进方案

必备要素:风险等级(高 / 中 / 低)、整改责任人、时限

(7)评估结论

核心作用:明确大模型是否满足备案安全要求

必备要素:结论需 “非黑即白”(如 “符合安全要求” 或 “需整改后复核”)

二、安全评估报告必须包含的内容

(1)数据隐私保护

评估大模型处理用户数据时采取的隐私保护措施,像数据加密、匿名化处理、访问控制等,判断其能否保障用户数据不被泄露、滥用。

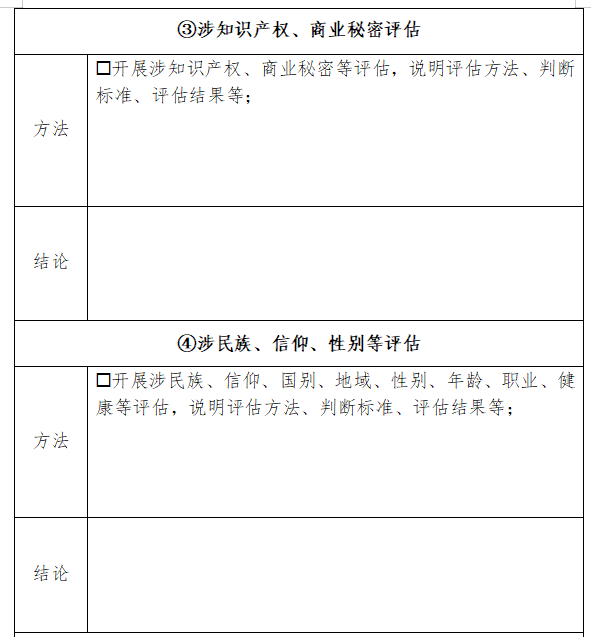

(2)算法偏见识别与纠正

分析模型有无潜在偏见,会不会对特定群体造成不公平影响。若存在偏见需阐述纠正措施,保障模型生成内容公正客观。

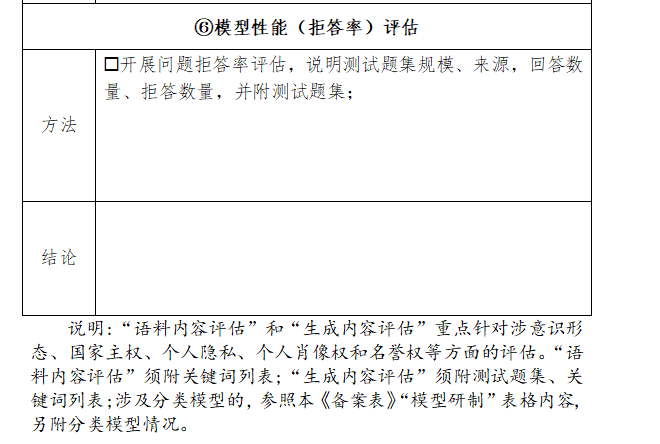

(3)有害信息过滤机制

检查模型有无有效的有害信息识别及过滤机制,以避免传播暴力、色情、恐怖主义等违法或不良信息。

(4)应急响应预案

评价模型面临安全事件时的应急处置能力,包含应急预案的完整性、应急资源的充足性、应急流程的合理性等,确保能及时控制并处理安全问题。

(5)合规性检查

验证模型的运行与应用是否契合国家法律法规和行业标准,比如遵循《数据安全法》《个人信息保护法》及《生成式人工智能服务管理暂行办法》等相关规定。

(6)风险评估

全面剖析模型可能遭遇的安全风险,像是网络攻击风险、数据泄露风险等,并给出针对性的风险控制和缓解策略。

(7)用户权益保护

核查模型是否采用必要手段保护用户的知情权、选择权、退出权等,使用户可清楚了解数据使用状况,并能按意愿管理个人数据。

三、撰写安全评估报告的注意事项

(1)证据支撑优先

每个结论需对应具体 “测试数据、日志截图、协议文档”,避免 “口头表述”

(2)语言专业且通俗

既要使用行业术语体现专业性,又要避免过度技术化导致审核方理解困难,关键术语可简要注释。

(3)合规性无遗漏

需覆盖 “数据、算法、内容、用户、应急” 全维度,尤其注意《生成式人工智能服务安全基本要求》中 “动态风险评估”“供应链安全” 等易忽略条款(如模型使用的第三方插件需评估安全性)。

(4)格式规范统一

建议采用 A4 纸排版,字体为宋体 / 仿宋,标题加粗,关键数据用表格呈现;附件需按 “附件 1:评估资质证明、附件 2:数据授权协议” 等编号整理,便于审核方查阅。

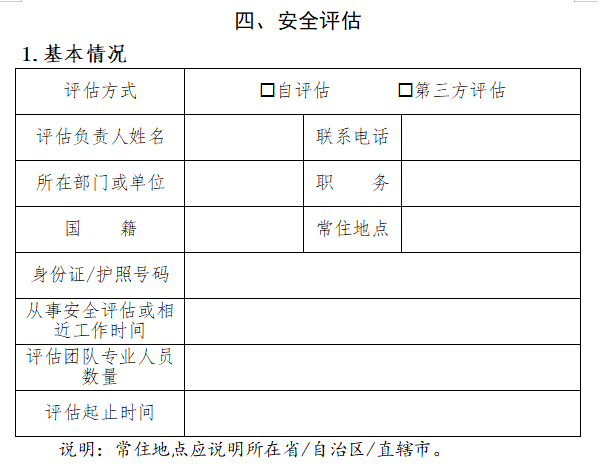

四、安全评估报告基础评估信息

(1)评估主体信息

明确谁开展的评估(如企业内部安全团队、第三方权威机构),若为第三方需附资质证明(如 ISO 27001 认证、网络安全等级保护测评资质)。

(2)评估对象信息

- 大模型基本信息:模型名称、版本号、训练框架、部署方式(公有云 / 私有部署)、服务场景(如内容生成、智能客服)

- 核心参数:训练数据量、参数量、推理延迟、服务并发量(体现模型规模与应用场景匹配度)。

(3)评估依据

列出具体法规 / 标准名称及条款,避免笼统表述,例如:《生成式人工智能服务管理暂行办法》(国家网信办等 7 部门,2023 年)第五条(数据安全)、第七条(有害信息过滤)

(4)评估范围与周期

明确评估覆盖的环节(如训练数据采集、模型训练、推理服务、用户数据交互)、评估起止时间、关键时间节点(如测试启动日、漏洞整改完成日)。

以上就是本篇文章的全部内容,希望对有备案需求的小伙伴们有所帮助,大家有其他备案问题欢迎在评论区交流~