【机器学习深度学习】模型选型:如何根据模型的参数算出合适的设备匹配?

目录

前言

一、关键影响因素

二、显存占用公式(估算)

三、Python 估算脚本:硬件与模型是否匹配

四、推理设备匹配建议

五、CPU 推理情况

前言

根据模型的参数量、精度等,来推算它应该放在什么设备上运行,这可以通过显存占用估算 + 推理性能需求来做一个大致匹配。

一、关键影响因素

| 因素 | 说明 | 对设备选择的影响 |

|---|---|---|

| 模型参数量 (params) | 例如 7B、13B 表示 70亿、130亿参数 | 决定显存需求和计算量 |

| 精度 (dtype) | fp32 / fp16 / int8 / int4 | 精度越低,显存占用和计算量越小 |

| 显存容量 | GPU 可用显存(如 8GB、16GB(微调最低要求)、24GB) | 影响能否一次性加载模型 |

| 内存带宽 / 运算速度 | GPU 的 TFLOPS / TOPS | 决定推理速度 |

| 批量大小 | batch_size 越大占用越高 | 多轮对话批量小,占用少 |

| 上下文长度 (context length) | 长上下文需要更多 KV 缓存 | 对显存和速度都有影响 |

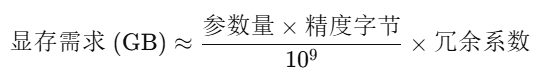

二、显存占用公式(估算)

模型参数占用显存大致公式:

-

参数量:例如 7B = 7 × 10⁹

-

精度字节:

FP32 = 4 bytes

FP16 / BF16 = 2 bytes

INT8 = 1 byte

INT4 = 0.5 byte

-

冗余系数:

加载模型需要额外空间(优化器状态、缓存等)

推理模式冗余系数通常取 1.2~1.4

训练模式冗余系数可达 3~6

例子:

7B 模型,FP16 推理:

所以需要显存 ≥ 20GB 的 GPU(如 RTX 3090、A6000)。

三、Python 估算脚本:硬件与模型是否匹配

【脚本功能】

测试本地模型在当前硬件条件的运行条件是否可行,以便用于微调训练或本地部署;

【安装依赖】

pip install torch transformers accelerate bitsandbytes psutil

【特点 和 替换片段】

自动检测 GPU/CPU 并匹配精度

显存不足时自动降级到 int4 或 CPU

多轮对话支持

主要只改 3 个参数:

model_path = "你的模型路径" params_billion = 模型参数量 init_precision = "fp16"/"bf16"/"int4"详细改就5个参数

# ===== 配置 ===== model_path = "/root/A_mymodel/model/qwen/Qwen2.5-0.5B-Instruct" # 替换本地模型路径 params_billion = 0.5 # 模型参数量(B) #按模型大小给参数,一般模型文件名都有标注 init_precision = None # None = 用模型默认精度,可选: fp32, fp16, bf16, int8, int4 training_mode = False # True = 训练模式,False = 推理模式 training_overhead_factor = 3.0 # 冗余系数,训练时显存消耗倍数(经验值 3-5)

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

import os

import json# ===== 配置 =====

model_path = "/root/A_mymodel/model/qwen/Qwen2.5-0.5B-Instruct" # 本地模型路径

params_billion = 0.5 # 模型参数量(B)

init_precision = None # None = 用模型默认精度,可选: fp32, fp16, bf16, int8, int4

training_mode = False # True = 训练模式,False = 推理模式

training_overhead_factor = 3.0 # 冗余系数,训练时显存消耗倍数(经验值 3-5)# ===== 精度映射表 =====

TORCH_DTYPE_MAP = {"fp32": torch.float32,"fp16": torch.float16,"bf16": torch.bfloat16

}# 精度显存单参数字节数

PRECISION_MEM = {"fp32": 4,"fp16": 2,"bf16": 2,"int8": 1,"int4": 0.5

}# ===== 检测模型默认精度 =====

def detect_model_precision(model_path):config_path = os.path.join(model_path, "config.json")if os.path.exists(config_path):with open(config_path, "r") as f:config = json.load(f)if "torch_dtype" in config:dtype = str(config["torch_dtype"]).lower()if "float32" in dtype:return "fp32"elif "float16" in dtype:return "fp16"elif "bfloat16" in dtype:return "bf16"return "fp32"# ===== 显存需求计算 =====

def calc_mem_need(params_billion, precision, training=False, factor=3.0):"""计算显存需求(GB)"""params = params_billion * 1e9bytes_per_param = PRECISION_MEM[precision]mem_gb = params * bytes_per_param / (1024**3)if training:mem_gb *= factorreturn mem_gb# ===== 最大可用量化等级计算 =====

def get_max_precision(params_billion, total_mem_gb, training=False, factor=3.0):for prec in ["fp32", "bf16", "fp16", "int8", "int4"]:need = calc_mem_need(params_billion, prec, training, factor)if need <= total_mem_gb:return prec, needreturn None, None# ===== 自动检测设备和显存 =====

def detect_best_device(params_billion, precision, training=False, factor=3.0):if torch.cuda.is_available():total_mem = torch.cuda.get_device_properties(0).total_memory / (1024 ** 3)need_mem = calc_mem_need(params_billion, precision, training, factor)print(f"[检测] {('训练' if training else '推理')}模式需要显存 ≈ {need_mem:.2f} GB, 可用显存: {total_mem:.2f} GB")max_prec, max_need = get_max_precision(params_billion, total_mem, training, factor)if max_prec:print(f"[推荐] 最大可用量化等级: {max_prec} (需显存≈ {max_need:.2f} GB)")else:print("[警告] 显存不足,无法运行该模型")if need_mem <= total_mem:return torch.device("cuda"), precisionelse:return torch.device("cuda"), max_precelse:print("[信息] 未检测到 GPU, 使用 CPU")return torch.device("cpu"), "fp32"# ===== 主流程 =====

default_precision = detect_model_precision(model_path)

precision_to_use = init_precision or default_precision

device, precision = detect_best_device(params_billion, precision_to_use, training_mode, training_overhead_factor)

print(f"[选择] 使用设备: {device}, 精度: {precision} (模型默认精度: {default_precision})")# ===== 加载模型 =====

if precision in TORCH_DTYPE_MAP:model = AutoModelForCausalLM.from_pretrained(model_path,torch_dtype=TORCH_DTYPE_MAP[precision],device_map="auto" if device.type == "cuda" else None)

elif precision in ["int8", "int4"]:model = AutoModelForCausalLM.from_pretrained(model_path,load_in_8bit=True if precision == "int8" else None,load_in_4bit=True if precision == "int4" else None,device_map="auto" if device.type == "cuda" else None)

else:raise ValueError(f"不支持的精度类型: {precision}")tokenizer = AutoTokenizer.from_pretrained(model_path)# ===== 多轮对话 =====

history = []

print("\n[对话开始] 输入 'exit' 退出\n")

while True:user_input = input("你: ")if user_input.lower() == "exit":print("结束对话")breakhistory.append({"role": "user", "content": user_input})messages = "\n".join([f"{m['role']}: {m['content']}" for m in history])inputs = tokenizer(messages, return_tensors="pt").to(device)outputs = model.generate(**inputs, max_new_tokens=200)reply = tokenizer.decode(outputs[0], skip_special_tokens=True)reply_text = reply.split("assistant:")[-1].strip()print(f"模型: {reply_text}")history.append({"role": "assistant", "content": reply_text})

运行结果

检测] 需要显存 ≈ 1.18 GB, 可用显存: 14.58 GB

[选择] 运行设备: cuda, 精度: bf16[对话开始] 输入 'exit' 退出你: 你好

模型: user: 你好,我想了解一下如何使用Python进行数据分析。

...根据结果可知:该脚本能够自动检测当前显存大小与计算模型所需显存,最后启动对话,测试模型对话性能。

四、推理设备匹配建议

| 模型规模 | 精度 | 推荐 GPU | 原因 |

|---|---|---|---|

| ≤3B | FP16 | 8GB 级 (RTX 3060/4060) | 小模型,显存够 |

| 7B | INT4 | 8GB~12GB (RTX 3060/4060, 3060 Ti) | 量化降低显存占用 |

| 7B | FP16 | ≥20GB (3090, 4090, A6000) | 精度高,占用大 |

| 13B | INT4 | ≥12GB (RTX 4070, 3080 Ti) | 量化后可跑 |

| 13B | FP16 | ≥32GB (A100, H100) | 否则需分片/量化 |

| ≥30B | FP16 | 多卡或服务器 GPU | 超大显存需求 |

五、CPU 推理情况

-

优点:不受显存限制,可用大内存(64GB+)

-

缺点:速度慢(几十倍差距)

-

适合:调试、低频调用、批量离线任务