CV 医学影像分类、分割、目标检测,之【腹腔多器官语义分割】项目拆解

CV 医学影像分类、分割、目标检测,之【腹腔多器官语义分割】项目拆解

- 第1行:`import os`

- 第2-3行:`import math` 和 `import numpy as np`

- 第4行:`import glob`

- 第5-7行:pandas、matplotlib、PIL导入

- 第8-9行:`import random` 和 `import time`

- 第10行:`import cv2`

- 第11-13行:PyTorch相关导入

- 第14-15行:数据加载相关

- 第17行:`path='./data/CHAOS_Train/Train_Sets/MR/'`

- 第18行:`dirs=glob.glob(path+'*')`

- 第19-20行:初始化路径列表

- 第21行:`for i in dirs:`

- 第22-23行:构建具体路径

- 第24-29行:收集文件路径

- 第30-32行:检查结果

- 第34-37行:读取DICOM文件

- 第38-40行:显示图像

- 第42-45行:读取掩码图像

- 第46行:`np.unique(cv2.imread(mask_path[25]))`

- 第48-52行:分析掩码结构

- 第53-60行:定义像素值映射

- 第62-72行:像素值转换函数

- 第74-76行:测试转换函数

- 第78-83行:定义图像变换

- 第87-88行:定义数据集类

- 第89-93行:初始化参数

- 第94行:定义获取单个样本的方法

- 第95-97行:获取文件路径

- 第99-102行:读取DICOM图像

- 第103-105行:转换为PIL并应用变换

- 第107-109行:读取掩码图像

- 第110-112行:掩码像素值转换

- 第113-116行:掩码变换处理

- 第117-120行:转换为张量

- 第122-125行:注释掉的代码

- 第126行:返回样本

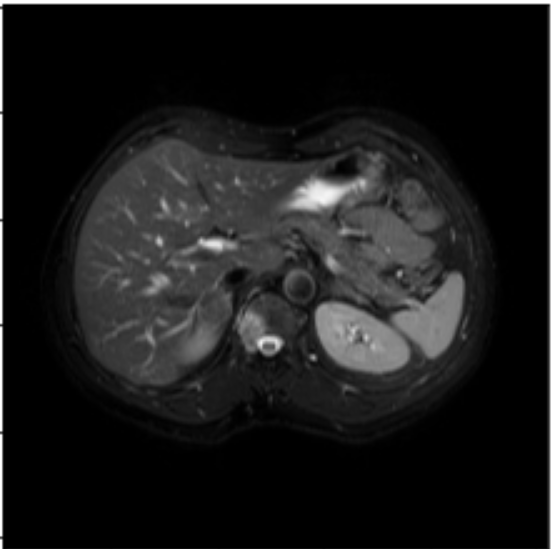

- 第128-130行:定义数据集长度

- 第133-137行:数据集分割

- 第139-140行:创建数据集对象

- 第141行:检查数据集大小

- 第143-144行:创建数据加载器

- 第146-147行:测试数据加载

- 第149-150行:再次测试并检查标签

- 第153-162行:可视化数据

- 第164行:导入分割模型库

- 第166-171行:创建UNet模型

- 第173-175行:测试模型输出

- 第178行:模型移至GPU

- 第181行:定义损失函数

- 第183行:定义优化器

- 第185行:导入进度条库

- 第186行:定义训练函数

- 第187-190行:初始化训练指标

- 第192行:设置训练模式

- 第193行:开始训练循环

- 第195-196行:数据移至GPU

- 第197-201行:计算损失和反向传播

- 第202行:开始无梯度计算

- 第203-206行:计算预测类别和准确率

- 第208-211行:计算IoU指标

- 第213-214行:计算训练指标

- 第217-219行:初始化测试指标

- 第221行:设置评估模式

- 第222行:测试时的无梯度计算

- 第223-230行:测试循环(与训练类似)

- 第232-235行:计算测试IoU

- 第238-239行:计算测试平均指标

- 第242-250行:打印训练结果

- 第252行:返回指标

- 第255行:设置训练轮数

- 第257-260行:初始化记录列表

- 第262-270行:主训练循环

- 第272-274行:获取测试批次

- 第275-277行:模型预测

- 第279-285行:处理预测结果

- 第287-295行:可视化预测结果

- 第297-311行:测试集可视化(重复代码)

- 总结性问题

第1行:import os

问1:为什么要导入os?

答1:os是操作系统接口模块,用来与文件系统交互。

问2:文件系统交互具体指什么?

答2:读取文件路径、列出目录内容、检查文件是否存在等操作。

问3:在这个医学项目中,os主要用来做什么?

答3:遍历CHAOS数据集的文件夹结构,找到所有的医学图像和标注文件。

问4:CHAOS数据集是什么?

答4:一个肝脏CT/MRI医学图像分割竞赛的数据集,包含原始图像和对应的分割标注。

第2-3行:import math 和 import numpy as np

问5:math和numpy都是数学库,为什么要导入两个?

答5:math处理基础数学函数(如sqrt、sin),numpy处理数组和矩阵运算。

问6:在图像处理中,为什么数组运算这么重要?

答6:因为图像本质上就是数值矩阵,每个像素都是数值。

问7:医学图像和普通照片在数据结构上有什么区别?

答7:医学图像通常是灰度图(单通道),普通照片是RGB彩色图(三通道)。

第4行:import glob

问8:glob是做什么的?

答8:用通配符模式匹配文件路径,比如找到所有以某种格式结尾的文件。

问9:为什么不直接用os.listdir()?

答9:glob可以用*、?等通配符进行复杂的模式匹配,更灵活。

问10:在这个项目中,glob具体会匹配什么?

答10:匹配CHAOS数据集中所有患者文件夹的路径。

第5-7行:pandas、matplotlib、PIL导入

问11:为什么需要这么多不同的库?

答11:每个库都有专门用途:pandas处理表格数据,matplotlib绘图,PIL处理图像。

问12:PIL的Image和cv2都能处理图像,为什么要用两个?

答12:PIL擅长基础图像操作,cv2(OpenCV)擅长计算机视觉算法,各有所长。

问13:在医学图像中,可视化为什么重要?

答13:医生和研究者需要直观看到分割结果,判断算法是否正确识别了器官边界。

第8-9行:import random 和 import time

问14:在机器学习中为什么需要random?

答14:用于数据打乱、随机采样、权重初始化等,保证训练的随机性。

问15:随机性对模型训练有什么好处?

答15:防止模型记住数据顺序,提高泛化能力,避免过拟合。

问16:time模块在这里的作用是什么?

答16:可能用于记录训练时间、设置随机种子、或者控制程序执行节奏。

问17:为什么要控制训练的随机性?

答17:既要保证随机性带来的好处,又要保证实验结果可重现。

第10行:import cv2

问18:cv2是什么的缩写?

答18:OpenCV 2,一个强大的计算机视觉库。

问19:OpenCV在医学图像处理中有什么特殊优势?

答19:提供了丰富的图像预处理、形态学操作、边缘检测等算法。

问20:为什么医学图像需要特殊的预处理?

答20:医学图像通常有噪声、对比度低、需要标准化等问题。

问21:OpenCV和PIL在功能上有什么本质区别?

答21:PIL偏向基础图像操作,OpenCV偏向算法实现和性能优化。

第11-13行:PyTorch相关导入

import torch

import torch.nn as nn

import torch.nn.functional as F

问22:PyTorch是什么?

答22:一个深度学习框架,用于构建和训练神经网络。

问23:为什么选择PyTorch而不是TensorFlow?

答23:PyTorch更灵活、调试友好,特别适合研究和原型开发。

问24:torch.nn是做什么的?

答24:提供神经网络的基础组件,如卷积层、全连接层等。

问25:nn和functional有什么区别?

答25:nn提供有状态的层(有参数),functional提供无状态的函数。

问26:在医学图像分割中,为什么要用深度学习?

答26:传统方法难以处理复杂的器官形状和边界,深度学习能自动学习特征。

第14-15行:数据加载相关

from torch.utils.data import Dataset, DataLoader

from torchvision import transforms

问27:Dataset和DataLoader的作用分别是什么?

答27:Dataset定义数据的获取方式,DataLoader负责批量加载和打乱数据。

问28:为什么要分批次(batch)加载数据?

答28:内存限制、梯度计算稳定性、并行计算效率。

问29:transforms是做什么的?

答29:对图像进行预处理变换,如缩放、归一化、数据增强等。

问30:医学图像的transforms和自然图像有什么不同?

答30:医学图像不能随意旋转(会改变解剖结构),需要保持空间关系的准确性。

第17行:path='./data/CHAOS_Train/Train_Sets/MR/'

问31:这个路径结构告诉我们什么信息?

答31:这是CHAOS数据集的MR(磁共振)图像训练集路径。

问32:MR是什么意思?

答32:Magnetic Resonance,磁共振成像,一种医学成像技术。

问33:为什么要区分Train_Sets?

答33:机器学习需要将数据分为训练集、验证集、测试集。

问34:./data/表示什么?

答34:当前目录下的data文件夹,.表示当前目录。

问35:为什么用相对路径而不是绝对路径?

答35:相对路径更灵活,代码在不同环境下都能运行。

第18行:dirs=glob.glob(path+'*')

问36:path+'*'这个表达式的含义是什么?

答36:在路径后加通配符*,匹配该路径下的所有子目录。

问37:glob.glob()返回什么类型的数据?

答37:返回一个列表,包含所有匹配的路径字符串。

问38:为什么要获取所有子目录?

答38:每个子目录代表一个患者的数据,需要遍历所有患者。

问39:CHAOS数据集的目录结构是怎样的?

答39:每个患者一个文件夹,文件夹内包含不同序列的图像和标注。

第19-20行:初始化路径列表

img_path=[]

mask_path=[]

问40:为什么要分别存储图像路径和掩码路径?

答40:训练需要成对的输入图像和标注掩码,分开存储便于配对。

问41:什么是掩码(mask)?

答41:标注图像,每个像素标记该位置属于哪个器官或组织。

问42:在医学图像分割中,掩码通常包含什么信息?

答42:不同的像素值代表不同的组织类别,如肝脏、肾脏、背景等。

问43:空列表[]的作用是什么?

答43:初始化容器,后续用append()方法添加路径。

第21行:for i in dirs:

问44:这个循环在做什么?

答44:遍历每个患者的文件夹,提取其中的图像和标注文件。

问45:变量i代表什么?

答45:代表每个患者文件夹的完整路径。

问46:为什么要用for循环而不是其他方式?

答46:需要对每个患者文件夹进行相同的操作,循环是最自然的方式。

问47:dirs中大概会有多少个元素?

答47:取决于数据集大小,可能是几十到几百个患者文件夹。

第22-23行:构建具体路径

img_dir=i+'/T2SPIR/DICOM_anon'

mask_dir=i+'/T2SPIR/Ground'

问48:T2SPIR是什么意思?

答48:T2 SPIR是一种MRI序列,T2加权抑制脂肪信号的成像方式。

问49:DICOM_anon中的anon代表什么?

答49:anonymous,匿名化,去除了患者身份信息的DICOM文件。

问50:为什么要匿名化医学数据?

答50:保护患者隐私,符合医学数据使用的伦理和法律要求。

问51:Ground在这里是什么意思?

答51:Ground truth,真实标注,专家手动标记的正确答案。

问52:为什么叫Ground truth?

答52:ground表示基础、真实,truth表示真相,即最可靠的标准答案。

第24-29行:收集文件路径

for file in os.listdir(img_dir):img=img_dir+'/{}'.format(file)img_path.append(img)

for file in os.listdir(mask_dir):mask=mask_dir+'/{}'.format(file)mask_path.append(mask)

问53:os.listdir()和glob.glob()有什么区别?

答53:listdir()列出目录中的所有文件名,glob()用模式匹配特定文件。

问54:‘{}’.format(file)是什么语法?

答54:Python字符串格式化,将file变量插入到{}位置。

问55:为什么用format而不直接用+连接?

答55:format更清晰、可读性更好,特别是多个变量时。

问56:img_path.append(img)在做什么?

答56:将完整的图像文件路径添加到列表末尾。

问57:为什么要收集所有文件路径而不是直接处理?

答57:先收集路径便于后续随机打乱、分割训练测试集等操作。

问58:这种嵌套循环的时间复杂度是多少?

答58:O(n*m),n是患者数,m是每个患者的平均图像数。

第30-32行:检查结果

mask_path

len(img_path)

问59:为什么要打印mask_path?

答59:检查路径收集是否正确,这是调试代码的常见做法。

问60:len(img_path)能告诉我们什么信息?

答60:总共有多少张图像,用于验证数据集大小。

问61:为什么要检查数据集大小?

答61:确保数据加载正确,防止路径错误导致数据丢失。

问62:在Jupyter中,单独一行变量名会发生什么?

答62:会直接显示变量内容,相当于print()。

第34-37行:读取DICOM文件

import pydicom

from pydicom import dcmread

im=pydicom.read_file(img_path[25])

img_array=im.pixel_array

问63:pydicom是什么?

答63:专门用于读取和处理DICOM医学图像格式的Python库。

问64:DICOM格式有什么特殊性?

答64:不仅包含图像数据,还有患者信息、扫描参数等元数据。

问65:为什么选择index[25]?

答65:随机选择一个样本进行测试,25只是一个任意的索引值。

问66:pixel_array属性包含什么?

答66:图像的像素值矩阵,通常是numpy数组格式。

问67:医学图像的像素值范围通常是多少?

答67:取决于成像设备,CT通常-1000到3000,MRI变化较大。

第38-40行:显示图像

plt.imshow(img_array,cmap='gray')

img_array

问68:cmap='gray’的作用是什么?

答68:使用灰度色彩映射,因为医学图像通常是单通道灰度图。

问69:为什么医学图像多用灰度而不是彩色?

答69:医学成像设备记录的是组织密度等物理特性,天然是单一数值。

问70:plt.imshow()和cv2.imshow()有什么区别?

答70:plt用于静态显示和保存,cv2用于实时显示和交互。

问71:为什么要在Jupyter中显示图像?

答71:直观检查数据质量,确保图像读取正确。

第42-45行:读取掩码图像

mask=Image.open(mask_path[25])

plt.imshow(mask,cmap='gray')

im=cv2.imread(mask_path[255])

np.max(cv2.imread(mask_path[22]))

问72:为什么掩码用Image.open而图像用pydicom?

答72:原始图像是DICOM格式需要专门库,掩码通常是PNG/JPG等标准格式。

问73:为什么要检查不同index的掩码?

答73:验证数据一致性,确保每个样本的掩码都正常。

问74:np.max()用来检查什么?

答74:查看掩码中的最大像素值,了解有多少个分类。

问75:掩码图像的像素值有什么特殊含义?

答75:每个像素值代表一个类别,如0=背景,1=肝脏,2=肾脏等。

第46行:np.unique(cv2.imread(mask_path[25]))

问76:np.unique()的作用是什么?

答76:返回数组中的唯一值,去除重复元素。

问77:为什么要查看掩码的唯一值?

答77:了解数据集中有哪些类别,每个类别用什么数值表示。

问78:这对后续模型设计有什么影响?

答78:决定模型输出通道数,需要与类别数量匹配。

问79:如果掩码中有意外的像素值怎么办?

答79:可能是标注错误或数据损坏,需要清理数据。

第48-52行:分析掩码结构

mask=Image.open(mask_path[25])

aa=np.array(mask)

ak=np.unique(aa)

ak

# x=torch.from_numpy(aa)

问80:为什么要将PIL图像转换为numpy数组?

答80:numpy提供更丰富的数组操作功能,便于数据分析。

问81:注释掉的torch.from_numpy()说明什么?

答81:作者在尝试不同的数据转换方式,这是开发过程的痕迹。

问82:为什么不直接用torch处理图像?

答82:numpy在数据预处理阶段更方便,torch主要用于模型训练。

问83:变量名aa、ak看起来随意,这样好吗?

答83:临时变量可以简短,但关键变量应该有意义的命名。

第53-60行:定义像素值映射

# 0, 63, 126, 189 252

idx={'0':0,'63':1,'126':2,'189':3,'252':4,

}

问84:为什么要进行像素值映射?

答84:将原始的任意像素值转换为连续的类别ID(0,1,2,3,4)。

问85:为什么类别ID要从0开始连续?

答85:深度学习模型通常要求类别标签是连续整数,便于计算损失函数。

问86:字典的键为什么是字符串?

答86:后续代码将像素值转为字符串进行映射,保持数据类型一致。

问87:这5个类别分别代表什么?

答87:通常0是背景,1-4是不同的器官或组织区域。

问88:如果遇到字典中没有的像素值会怎样?

答88:会抛出KeyError异常,说明数据中有意外值需要处理。

第62-72行:像素值转换函数

def pixel_to_Id(array):ix,jx=array.shapearray=array.astype(str)for i in range(ix):for j in range(jx):pixel=array[i][j]pixelid=idx[pixel]array[i][j]=pixelidarray=array.astype("int32")return array

问89:ix,jx=array.shape在做什么?

答89:获取数组的高度和宽度,ix是行数,jx是列数。

问90:为什么要先转换为字符串?

答90:因为字典的键是字符串,需要类型匹配才能查找。

问91:双重for循环遍历每个像素的效率如何?

答91:效率较低,numpy的向量化操作会更快。

问92:为什么最后要转换为int32?

答92:深度学习模型的标签通常需要整数类型,int32是常用格式。

问93:这个函数有什么潜在问题?

答93:直接修改原数组、效率低、异常处理不足。

问94:有没有更好的实现方式?

答94:可以用numpy的向量化操作或者预先构建映射表。

第74-76行:测试转换函数

ax=pixel_to_Id(aa)

np.unique(ax)

问95:为什么要测试转换函数?

答95:验证像素值映射是否正确,确保所有值都转换为期望的类别ID。

问96:ax变量名的含义是什么?

答96:可能是array transformed的缩写,表示转换后的数组。

问97:期望看到什么结果?

答97:应该看到[0,1,2,3,4]这样的连续整数,对应5个类别。

问98:如果结果不是期望值说明什么?

答98:可能原始数据有问题,或者映射字典不完整。

第78-83行:定义图像变换

img_transformer=transforms.Compose([transforms.Resize((256,256)),transforms.ToTensor(),

])

label_transformer=transforms.Compose([transforms.Resize((256,256)),

])

问99:transforms.Compose的作用是什么?

答99:将多个变换操作串联起来,按顺序依次执行。

问100:为什么要Resize到(256,256)?

答100:统一图像尺寸,便于批量处理,256是常用的2的幂次方尺寸。

问101:ToTensor()做了什么?

答101:将PIL图像或numpy数组转换为PyTorch张量,并归一化到[0,1]。

问102:为什么图像和标签的变换不同?

答102:图像需要归一化,标签保持原始像素值不变。

问103:标签为什么不用ToTensor()?

答103:ToTensor()会改变数值范围,标签需要保持精确的类别值。

问104:256x256的分辨率对医学图像够用吗?

答104:取决于任务需求,分割任务通常需要更高分辨率保持细节。

第87-88行:定义数据集类

class Liverdataset(Dataset):def __init__(self,img,mask,transformer,label_tranformer):

问105:为什么要继承Dataset类?

答105:PyTorch的标准做法,提供统一的数据加载接口。

问106:类名Liverdataset说明什么?

答106:这是专门处理肝脏分割数据的数据集类。

问107:__init__方法的作用是什么?

答107:初始化对象,存储图像路径、掩码路径和变换操作。

问108:为什么要传入transformer?

答108:不同阶段可能需要不同的数据增强,保持灵活性。

问109:label_tranformer拼写错误说明什么?

答109:代码可能是快速原型,没有仔细检查拼写。

第89-93行:初始化参数

self.img=img

self.mask=mask

self.transformer=transformer

self.label_tranformer=label_tranformer

问110:self关键字的作用是什么?

答110:指向当前对象实例,用于存储和访问对象属性。

问111:为什么要将参数赋值给self?

答111:使得这些参数在整个类中都可以访问和使用。

问112:这种设计模式叫什么?

答112:构造函数模式,用于初始化对象状态。

问113:如果不用self会怎样?

答113:参数只在__init__方法内有效,其他方法无法访问。

第94行:定义获取单个样本的方法

def __getitem__(self,index):

问114:__getitem__是什么特殊方法?

答114:Python的魔法方法,使对象支持索引操作,如dataset[0]。

问115:PyTorch为什么需要这个方法?

答115:DataLoader需要通过索引获取单个样本来构建批次。

问116:index参数代表什么?

答116:要获取的样本在数据集中的索引位置。

问117:这个方法应该返回什么?

答117:应该返回一个样本的输入图像和对应标签。

第95-97行:获取文件路径

img=self.img[index]

mask=self.mask[index]

问118:这里的img和mask是什么类型?

答118:是字符串类型的文件路径。

问119:为什么要用index索引?

答119:根据给定索引获取对应的图像和掩码文件路径。

问120:如果index超出范围会怎样?

答120:会抛出IndexError异常,需要确保index有效。

问121:为什么不直接在init中加载所有图像?

答121:节省内存,只在需要时才加载具体图像。

第99-102行:读取DICOM图像

img_open=pydicom.read_file(img)

img_arrayR=img_open.pixel_array

img_arrayR = np.array(img_arrayR, dtype=np.float32)

###读取为PIL

问122:为什么要转换为float32?

答122:深度学习通常用float32,提供足够精度且节省内存。

问123:img_arrayR中的R代表什么?

答123:可能表示Raw(原始),区别于后续处理的版本。

问124:注释###读取为PIL说明什么?

答124:作者在标记代码功能,便于理解处理流程。

问125:为什么医学图像要用float32而不是uint8?

答125:医学图像动态范围大,uint8可能损失精度。

第103-105行:转换为PIL并应用变换

img_arrayPIC=Image.fromarray(img_arrayR)

#转换resize

img_tensor=self.transformer(img_arrayPIC)##resize

问126:为什么要转换为PIL格式?

答126:torchvision的transforms主要设计用于PIL图像。

问127:fromarray()需要什么类型的输入?

答127:需要numpy数组,且数值范围要适合图像格式。

问128:float32数组能直接转换为PIL吗?

答128:需要先归一化到合适范围,通常是[0,255]或[0,1]。

问129:注释##resize说明什么?

答129:作者标记这一步主要是为了调整图像尺寸。

第107-109行:读取掩码图像

###读取图片

mask_open=Image.open(mask)

mask_array=np.array(mask_open)

问130:为什么掩码用Image.open而不是pydicom?

答130:掩码通常保存为标准图像格式(PNG/TIFF),不是DICOM。

问131:掩码的数据类型通常是什么?

答131:通常是uint8,值在0-255范围内表示不同类别。

问132:为什么注释写的是"读取图片"而不是"读取掩码"?

答132:可能是复制粘贴导致的不准确注释。

第110-112行:掩码像素值转换

###矩阵像素转label

mask_pixel_to_id=pixel_to_Id(mask_array)

###读取为PIL

问133:为什么要进行像素值转换?

答133:将原始的像素值映射为连续的类别ID。

问134:这个转换的必要性在哪里?

答134:深度学习的交叉熵损失函数要求标签是连续整数。

问135:转换后的数据类型是什么?

答135:根据前面的函数定义,应该是int32。

第113-116行:掩码变换处理

mask_label=Image.fromarray(mask_pixel_to_id)

##reisze

mask_label=self.label_tranformer(mask_label)

mask_label=np.array(mask_label)

问136:为什么掩码也要转换为PIL?

答136:使用相同的transforms接口进行尺寸调整。

问137:掩码resize时需要注意什么?

答137:要用最近邻插值,避免产生新的类别值。

问138:为什么要转回numpy数组?

答138:便于后续转换为PyTorch张量。

问139:这种PIL→numpy→PIL→numpy的转换效率如何?

答139:效率较低,理想情况下应该减少格式转换次数。

第117-120行:转换为张量

#numpy tensor

mask_tensor=torch.from_numpy(mask_label)

mask_tensor=torch.squeeze(mask_tensor).type(torch.long)

问140:torch.from_numpy()的作用是什么?

答140:将numpy数组转换为PyTorch张量,共享内存。

问141:torch.squeeze()做了什么?

答141:移除尺寸为1的维度,如(1,256,256)变成(256,256)。

问142:为什么要转换为torch.long?

答142:交叉熵损失函数要求标签是长整型(int64)。

问143:共享内存意味着什么?

答143:张量和原数组指向同一块内存,修改一个会影响另一个。

第122-125行:注释掉的代码

# mask_tensor=self.transformer(mask_open)

# mask_tensor=torch.squeeze(mask_tensor)

问144:为什么这部分代码被注释掉了?

答144:作者尝试了不同的处理方式,这是之前的实现版本。

问145:这种处理方式有什么问题?

答145:直接对掩码应用图像变换可能会改变像素值,破坏类别信息。

问146:保留注释代码的意义是什么?

答146:记录开发过程,便于回溯和比较不同方案。

问147:在生产代码中应该如何处理这种情况?

答147:应该删除无用代码,保持代码整洁,或用版本控制系统管理。

第126行:返回样本

return img_tensor,mask_tensor

问148:为什么要返回元组?

答148:PyTorch的DataLoader期望每个样本返回(输入, 标签)的格式。

问149:返回的张量形状分别是什么?

答149:img_tensor可能是(C,H,W),mask_tensor是(H,W)。

问150:这个返回值会被谁使用?

答150:被DataLoader调用,用于构建训练批次。

问151:如果返回格式不对会怎样?

答151:DataLoader无法正确处理,训练时会报错。

第128-130行:定义数据集长度

def __len__(self):return len(self.img)

问152:__len__是什么特殊方法?

答152:Python魔法方法,使对象支持len()函数调用。

问153:PyTorch为什么需要知道数据集长度?

答153:DataLoader需要知道总样本数来计算批次数量和采样策略。

问154:返回什么值?

答154:返回图像列表的长度,即数据集中的样本总数。

问155:为什么用self.img而不是self.mask?

答155:两者长度应该相同,用哪个都可以,img更直观。

第133-137行:数据集分割

s=500

train_img=img_path[:s]

train_label=mask_path[:s]

test_img=img_path[s:]

test_label=mask_path[s:]

问156:为什么选择500作为分割点?

答156:可能是根据数据集大小经验选择的训练集大小。

问157:这种分割方式有什么问题?

答157:没有随机打乱,可能导致训练集和测试集分布不均。

问158:[😒]和[s:]的含义分别是什么?

答158:[😒]取前s个元素,[s:]取从第s个到末尾的元素。

问159:为什么不用sklearn的train_test_split?

答159:这是简单的固定分割,可能是为了快速测试。

问160:医学数据分割时需要考虑什么特殊因素?

答160:要确保同一患者的数据不会同时出现在训练集和测试集中。

第139-140行:创建数据集对象

train_data=Liverdataset(train_img,train_label,img_transformer,label_transformer)

test_data=Liverdataset(test_img,test_label,img_transformer,label_transformer)

问161:为什么训练集和测试集用相同的变换?

答161:这里只做了基础变换,实际应用中训练集通常需要更多数据增强。

问162:数据增强对医学图像有什么特殊要求?

答162:不能改变解剖结构,如旋转、翻转需要谨慎使用。

问163:创建对象时发生了什么?

答163:执行__init__方法,存储路径和变换参数。

问164:这时图像数据被加载了吗?

答164:没有,只存储了路径,实际加载在__getitem__时进行。

第141行:检查数据集大小

len(train_data)

问165:这行代码的作用是什么?

答165:验证训练数据集的大小是否正确。

问166:期望看到什么结果?

答166:应该返回500,与前面设置的分割点一致。

问167:如果结果不是500说明什么?

答167:可能路径收集有问题,或者数据集创建失败。

第143-144行:创建数据加载器

dl_train=DataLoader(train_data,batch_size=8,shuffle=True)

dl_test=DataLoader(test_data,batch_size=8,shuffle=True)

问168:batch_size=8意味着什么?

答168:每次训练使用8个样本,这是小批量梯度下降。

问169:为什么选择8而不是其他数值?

答169:可能受到GPU内存限制,医学图像通常占用较多内存。

问170:shuffle=True的作用是什么?

答170:每个epoch随机打乱数据顺序,避免模型记住数据顺序。

问171:测试集为什么也要shuffle?

答171:测试时不需要shuffle,这里可能是复制粘贴导致的。

问172:DataLoader还做了什么其他工作?

答172:自动调用__getitem__和__len__,处理批次拼接等。

第146-147行:测试数据加载

img,label=next(iter(dl_test))

img.shape

问173:next(iter())是什么操作?

答173:获取数据加载器的第一个批次,用于测试。

问174:返回的img和label是什么?

答174:img是图像批次张量,label是标签批次张量。

问175:img.shape会显示什么?

答175:应该是(8, C, H, W),8是批次大小。

问176:为什么要检查shape?

答176:验证数据加载和批次构建是否正确。

第149-150行:再次测试并检查标签

img,label=next(iter(dl_test))

torch.unique(label[2])

问177:为什么要多次调用next(iter())?

答177:验证数据加载的一致性和随机性。

问178:label[2]表示什么?

答178:批次中第3个样本的标签图像。

问179:torch.unique(label[2])的目的是什么?

答179:查看该样本包含哪些类别,验证标签处理是否正确。

问180:期望看到什么结果?

答180:应该看到0-4范围内的整数,代表不同类别。

第153-162行:可视化数据

img,label=next(iter(dl_train))

plt.figure(figsize=(12,8))

for i,(img,label) in enumerate(zip(img[:4],label[:4])):img=torch.squeeze(img).numpy()label=label.numpy()plt.subplot(2,4,i+1)plt.imshow(img,cmap='gray')plt.subplot(2,4,i+5)plt.imshow(label)

问181:为什么只显示前4个样本?

答181:便于在有限空间内查看多个样本,4个是常见选择。

问182:enumerate()和zip()的作用分别是什么?

答182:enumerate提供索引,zip将图像和标签配对。

问183:torch.squeeze(img).numpy()做了什么?

答183:移除单维度并转换为numpy数组,便于显示。

问184:subplot(2,4,i+1)的布局是什么?

答184:2行4列的子图布局,上行显示图像,下行显示标签。

问185:为什么要可视化训练数据?

答185:检查数据预处理是否正确,图像和标签是否对应。

第164行:导入分割模型库

import segmentation_models_pytorch as smp

问186:segmentation_models_pytorch是什么?

答186:一个专门用于图像分割的PyTorch库,提供预训练模型。

问187:为什么使用第三方库而不是自己实现?

答187:节省开发时间,使用经过验证的高质量实现。

问188:smp库有什么优势?

答188:提供多种架构(UNet、DeepLab等)和预训练权重。

问189:在医学图像分割中,使用预训练模型合适吗?

答189:需要谨慎,因为预训练通常基于自然图像,域差异较大。

第166-171行:创建UNet模型

model = smp.Unet(encoder_name="resnet34", # choose encoder, e.g. mobilenet_v2 or efficientnet-b7#encoder_weights="imagenet", # use `imagenet` pre-trained weights for encoder initializationin_channels=1, # model input channels (1 for gray-scale images, 3 for RGB, etc.)classes=5, # model output channels (number of classes in your dataset)

)

问190:UNet是什么模型架构?

答190:一种编码器-解码器结构,专门为医学图像分割设计。

问191:为什么选择resnet34作为编码器?

答191:ResNet34提供良好的特征提取能力,且计算量适中。

问192:为什么注释掉了encoder_weights?

答192:可能发现ImageNet预训练权重对医学图像效果不好。

问193:in_channels=1说明什么?

答193:输入是单通道灰度图像,符合医学图像特点。

问194:classes=5对应什么?

答194:5个分割类别,与之前定义的像素值映射一致。

问195:UNet的编码器-解码器结构有什么优势?

答195:能够捕获多尺度特征,保持空间细节信息。

第173-175行:测试模型输出

img,label=next(iter(dl_test))

y_pred = model(img)

y_pred.shape

问196:为什么要测试模型输出?

答196:验证模型能否正常前向传播,输出形状是否正确。

问197:y_pred.shape应该是什么?

答197:应该是(8, 5, 256, 256),批次×类别×高×宽。

问198:此时的y_pred是什么含义?

答198:每个像素对每个类别的未归一化预测分数(logits)。

问199:如果shape不对说明什么?

答199:模型配置有误,需要检查输入输出设置。

第178行:模型移至GPU

model = model.to('cuda')

问200:为什么要移动到GPU?

答200:利用GPU并行计算能力,大幅加速训练过程。

问201:如果没有GPU会怎样?

答201:会报错,应该先检查CUDA是否可用。

问202:.to(‘cuda’)做了什么?

答202:将模型的所有参数和缓存移动到GPU内存。

问203:数据也需要移动到GPU吗?

答203:是的,训练时需要确保模型和数据在同一设备上。

第181行:定义损失函数

loss_fn=nn.CrossEntropyLoss()

问204:为什么选择交叉熵损失?

答204:适合多类分类问题,医学图像分割本质上是像素级分类。

问205:交叉熵损失如何计算?

答205:-log(softmax(predicted_class)),惩罚错误预测。

问206:医学图像分割还有其他损失函数选择吗?

答206:有Dice Loss、Focal Loss等,专门处理类别不平衡问题。

问207:为什么不用Dice Loss?

答207:交叉熵更通用,Dice Loss在某些情况下可能不稳定。

第183行:定义优化器

optimizer=torch.optim.Adam(model.parameters(),lr=0.001)

问208:为什么选择Adam优化器?

答208:Adam结合了动量和自适应学习率,通常收敛更快更稳定。

问209:lr=0.001是如何选择的?

答209:这是常用的默认学习率,可能需要根据实际情况调整。

问210:model.parameters()包含什么?

答210:包含模型中所有可训练的权重和偏置参数。

问211:学习率过大或过小会怎样?

答211:过大可能不收敛,过小可能收敛太慢或陷入局部最优。

第185行:导入进度条库

from tqdm import tqdm

问212:tqdm的作用是什么?

答212:显示循环进度条,让用户了解训练进度。

问213:为什么需要进度条?

答213:深度学习训练时间长,进度条提供视觉反馈。

问214:tqdm对性能有影响吗?

答214:影响很小,但在性能关键场景下可以关闭。

第186行:定义训练函数

def fit(epoch, model, trainloader, testloader):

问215:为什么要定义训练函数?

答215:封装训练逻辑,便于重复调用和代码组织。

问216:参数中epoch的作用是什么?

答216:当前训练轮次,用于日志输出和学习率调度。

问217:为什么同时传入训练和测试加载器?

答217:每个epoch既要训练又要验证,评估模型性能。

第187-190行:初始化训练指标

correct = 0

total = 0

running_loss = 0

epoch_iou = []

问218:这些变量分别记录什么?

答218:correct记录正确像素数,total记录总像素数,running_loss累计损失,epoch_iou记录IoU分数。

问219:为什么要统计这些指标?

答219:监控训练效果,判断模型是否正常学习。

问220:IoU是什么指标?

答220:Intersection over Union,交并比,衡量分割质量的常用指标。

问221:为什么用列表存储IoU?

答221:每个批次计算一次IoU,最后求平均值。

第192行:设置训练模式

model.train()

问222:model.train()的作用是什么?

答222:将模型设置为训练模式,启用Dropout、BatchNorm等训练行为。

问223:训练模式和评估模式有什么区别?

答223:训练模式下Dropout起作用,BatchNorm使用当前批次统计。

问224:忘记设置训练模式会怎样?

答224:可能导致训练效果差,特别是使用Dropout的模型。

第193行:开始训练循环

for x, y in tqdm(trainloader):

问225:这个循环在做什么?

答225:遍历训练数据的每个批次,进行前向传播和反向传播。

问226:x和y分别代表什么?

答226:x是输入图像批次,y是对应的标签批次。

问227:tqdm(trainloader)有什么效果?

答227:显示训练进度条,展示当前批次和剩余时间。

第195-196行:数据移至GPU

x, y = x.to('cuda'), y.to('cuda')

y_pred = model(x)

问228:为什么要将数据移到GPU?

答228:确保数据和模型在同一设备上,才能进行计算。

问229:.to(‘cuda’)是否会复制数据?

答229:如果数据已在GPU上则不复制,否则会复制到GPU。

问230:model(x)执行了什么操作?

答230:模型的前向传播,计算预测结果。

第197-201行:计算损失和反向传播

loss = loss_fn(y_pred, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

问231:loss_fn(y_pred, y)计算的是什么?

答231:预测结果和真实标签之间的交叉熵损失。

问232:optimizer.zero_grad()为什么是必要的?

答232:PyTorch默认累积梯度,需要清零上一步的梯度。

问233:loss.backward()做了什么?

答233:反向传播,计算所有参数相对于损失的梯度。

问234:optimizer.step()的作用是什么?

答234:根据计算出的梯度更新模型参数。

问235:这四步的顺序能否改变?

答235:不能,这是标准的训练步骤,顺序固定。

第202行:开始无梯度计算

with torch.no_grad():

问236:torch.no_grad()的作用是什么?

答236:禁用梯度计算,节省内存和计算时间。

问237:为什么在训练中要禁用梯度?

答237:计算指标时不需要梯度,可以提高效率。

问238:这个上下文管理器何时结束?

答238:直到对应的代码块结束,通常是计算完指标后。

第203-206行:计算预测类别和准确率

y_pred = torch.argmax(y_pred, dim=1)

correct += (y_pred == y).sum().item()

total += y.size(0)

running_loss += loss.item()

问239:torch.argmax(y_pred, dim=1)做了什么?

答239:沿着类别维度找到最大值的索引,得到预测类别。

问240:dim=1为什么对应类别维度?

答240:y_pred形状是(N,C,H,W),dim=1是类别通道。

问241:(y_pred == y).sum().item()计算什么?

答241:预测正确的像素总数。

问242:y.size(0)代表什么?

答242:批次大小,即当前批次的样本数量。

问243:loss.item()的作用是什么?

答243:将tensor转换为Python数值,便于累积。

第208-211行:计算IoU指标

intersection = torch.logical_and(y, y_pred)

union = torch.logical_or(y, y_pred)

batch_iou = torch.sum(intersection) / torch.sum(union)

epoch_iou.append(batch_iou.item())

问244:这里计算的IoU有什么问题?

答244:将所有类别合并计算,应该分别计算每个类别的IoU。

问245:torch.logical_and()的作用是什么?

答245:逐元素逻辑与操作,找到预测和真实都为真的像素。

问246:为什么要除以union?

答246:IoU定义为交集除以并集,衡量重叠程度。

问247:这种IoU计算方式适合多类分割吗?

答247:不太适合,应该计算每个类别的IoU再平均。

第213-214行:计算训练指标

epoch_loss = running_loss / len(trainloader.dataset)

epoch_acc = correct / (total*256*256)

问248:为什么除以len(trainloader.dataset)?

答248:计算每个样本的平均损失。

问249:total256256表示什么?

答249:总像素数,total是样本数,256*256是每个样本的像素数。

问250:这种准确率计算有什么问题?

答250:像素级准确率可能高估性能,因为背景像素通常占大部分。

问251:更好的评估指标是什么?

答251:应该使用类别平衡的指标,如mIoU、Dice系数等。

第217-219行:初始化测试指标

test_correct = 0

test_total = 0

test_running_loss = 0

epoch_test_iou = []

问252:为什么要单独计算测试指标?

答252:评估模型在未见过数据上的泛化性能。

问253:测试指标和训练指标有什么区别?

答253:测试时模型不更新参数,纯粹评估性能。

第221行:设置评估模式

model.eval()

问254:model.eval()做了什么?

答254:设置为评估模式,关闭Dropout,BatchNorm使用全局统计。

问255:为什么测试时要用eval模式?

答255:确保模型行为一致,获得可重复的测试结果。

问256:忘记设置eval模式会怎样?

答256:Dropout仍然起作用,测试结果会有随机性。

第222行:测试时的无梯度计算

with torch.no_grad():

问257:测试时为什么要禁用梯度?

答257:测试不需要更新参数,禁用梯度节省内存和计算。

问258:这和训练时的no_grad有什么区别?

答258:测试时整个前向传播都不需要梯度,训练时只是指标计算不需要。

第223-230行:测试循环(与训练类似)

for x, y in tqdm(testloader):x, y = x.to('cuda'), y.to('cuda')y_pred = model(x)loss = loss_fn(y_pred, y)y_pred = torch.argmax(y_pred, dim=1)test_correct += (y_pred == y).sum().item()test_total += y.size(0)test_running_loss += loss.item()

问259:测试循环和训练循环有什么主要区别?

答259:没有反向传播步骤(zero_grad、backward、step)。

问260:为什么测试时也要计算loss?

答260:监控模型在验证集上的损失变化,判断是否过拟合。

第232-235行:计算测试IoU

intersection = torch.logical_and(y, y_pred)

union = torch.logical_or(y, y_pred)

batch_iou = torch.sum(intersection) / torch.sum(union)

epoch_test_iou.append(batch_iou.item())

问261:测试IoU和训练IoU计算方式相同吗?

答261:是的,使用相同的计算逻辑。

问262:这种一致性有什么好处?

答262:确保训练和测试指标可比较。

第238-239行:计算测试平均指标

epoch_test_loss = test_running_loss / len(testloader.dataset)

epoch_test_acc = test_correct / (test_total*256*256)

问263:这些计算和训练指标一致吗?

答263:是的,保持计算方式一致便于比较。

第242-250行:打印训练结果

print('epoch: ', epoch, 'loss: ', round(epoch_loss, 3),'accuracy:', round(epoch_acc, 3),'IOU:', round(np.mean(epoch_iou), 3),'test_loss: ', round(epoch_test_loss, 3),'test_accuracy:', round(epoch_test_acc, 3),'test_iou:', round(np.mean(epoch_test_iou), 3))

问264:为什么要打印这些指标?

答264:监控训练进度,及时发现问题。

问265:round(, 3)的作用是什么?

答265:保留3位小数,使输出更易读。

问266:np.mean(epoch_iou)计算什么?

答266:当前epoch所有批次IoU的平均值。

问267:如何判断训练是否正常?

答267:损失下降,准确率上升,训练测试指标差距不大。

第252行:返回指标

return epoch_loss, epoch_acc, epoch_test_loss, epoch_test_acc

问268:为什么要返回这些值?

答268:便于主训练循环记录和绘制训练曲线。

问269:还有其他指标值得返回吗?

答269:IoU指标也应该返回,用于更全面的性能分析。

第255行:设置训练轮数

epochs = 100

问270:为什么选择100个epoch?

答270:这是一个经验值,具体应根据验证集性能来早停。

问271:如何判断epoch数是否合适?

答271:观察验证集损失,当开始上升时说明过拟合,应停止训练。

问272:医学图像分割通常需要多少epoch?

答272:取决于数据量和模型复杂度,通常几十到几百个epoch。

问273:epoch过多会导致什么问题?

答273:过拟合,模型在训练集表现好但泛化能力差。

第257-260行:初始化记录列表

train_loss = []

train_acc = []

test_loss = []

test_acc = []

问274:为什么要记录这些历史数据?

答274:绘制训练曲线,分析训练过程,判断模型收敛情况。

问275:这些列表最终会包含多少个元素?

答275:每个列表包含100个元素,对应100个epoch的结果。

问276:还应该记录哪些指标?

答276:学习率变化、IoU变化、训练时间等。

第262-270行:主训练循环

for epoch in range(epochs):epoch_loss, epoch_acc, epoch_test_loss, epoch_test_acc = fit(epoch,model,dl_train,dl_test)train_loss.append(epoch_loss)train_acc.append(epoch_acc)test_loss.append(epoch_test_loss)test_acc.append(epoch_test_acc)

问277:这个循环的执行顺序是什么?

答277:每个epoch调用fit函数,然后记录返回的指标。

问278:fit函数的调用为什么跨多行?

答278:参数较多,分行书写提高可读性。

问279:如果训练中断怎么办?

答279:应该添加模型保存和恢复机制。

问280:如何优化这个训练循环?

答280:添加早停、学习率调度、模型检查点保存等。

第272-274行:获取测试批次

image, mask = next(iter(dl_train))

image=image.to('cuda')

model.eval()

问281:为什么训练完后要测试?

答281:可视化最终模型的预测效果。

问282:为什么用dl_train而不是dl_test?

答282:可能是想看模型在训练数据上的拟合效果。

问283:model.eval()的作用是什么?

答283:切换到评估模式,确保预测结果稳定。

第275-277行:模型预测

pred_mask = model(image)

image=torch.squeeze(image)

image.shape

问284:pred_mask包含什么?

答284:模型对每个像素每个类别的预测概率(logits)。

问285:为什么要squeeze image?

答285:移除批次维度,便于单张图像显示。

问286:image.shape用来确认什么?

答286:确认维度变换是否正确。

第279-285行:处理预测结果

mask=torch.squeeze(mask)

mask.shape

pred_mask

pred_mask.shape

pred_mask=pred_mask.cpu()

pred_mask.shape

问287:为什么要将pred_mask移到CPU?

答287:matplotlib显示需要CPU上的numpy数组。

问288:为什么要多次检查shape?

答288:调试代码,确保每一步的数据变换正确。

问289:这种调试方式是否高效?

答289:对于学习和调试有帮助,生产代码中应该简化。

第287-295行:可视化预测结果

num=3

plt.figure(figsize=(10, 10))

for i in range(num):plt.subplot(num, 3, i*num+1)plt.imshow(image[i].cpu().numpy(),cmap='gray')plt.subplot(num, 3, i*num+2)plt.imshow(mask[i].cpu().numpy())plt.subplot(num, 3, i*num+3)plt.imshow(torch.argmax(pred_mask[i].permute(1,2,0), axis=-1).detach().numpy())

问290:num=3表示显示几个样本?

答290:显示3个样本,每个样本3列(原图、真实标签、预测结果)。

问291:i*num+1的计算逻辑是什么?

答291:第i行第1列的子图索引,创建3x3的网格布局。

问292:为什么要permute(1,2,0)?

答292:将(C,H,W)转换为(H,W,C),适合argmax在最后一维操作。

问293:torch.argmax(axis=-1)做了什么?

答293:在类别维度上找最大值,得到每个像素的预测类别。

问294:.detach()的作用是什么?

答294:断开梯度连接,确保tensor可以转换为numpy。

问295:这种可视化能看出什么?

答295:模型的分割效果,是否正确识别了器官边界。

第297-311行:测试集可视化(重复代码)

image, mask = next(iter(dl_test))

image=image.to('cuda')

model.eval()

pred_mask = model(image)

image=torch.squeeze(image)

image.shape

mask=torch.squeeze(mask)

mask.shape

pred_mask

pred_mask.shape

pred_mask=pred_mask.cpu()

pred_mask.shape

num=3

plt.figure(figsize=(10, 10))

for i in range(num):plt.subplot(num, 3, i*num+1)plt.imshow(image[i].cpu().numpy(),cmap='gray')plt.subplot(num, 3, i*num+2)plt.imshow(mask[i].cpu().numpy())plt.subplot(num, 3, i*num+3)plt.imshow(torch.argmax(pred_mask[i].permute(1,2,0), axis=-1).detach().numpy())

问296:为什么要重复相同的可视化代码?

答296:分别查看训练集和测试集的预测效果。

问297:这种代码重复有什么问题?

答297:违反DRY原则,应该封装成函数。

问298:如何改进这段代码?

答298:定义一个可视化函数,接受数据加载器作为参数。

问299:测试集和训练集的可视化结果有什么意义?

答299:比较模型在已见和未见数据上的表现差异。

问300:如果测试集效果明显比训练集差说明什么?

答300:可能存在过拟合,需要调整模型或增加正则化。

总结性问题

问301:这段代码的整体流程是什么?

答301:数据加载→预处理→模型定义→训练→验证→可视化。

问302:代码中有哪些可以改进的地方?

答302:添加异常处理、代码去重、更好的评估指标、早停机制等。

问303:对于医学图像分割,这个实现有什么局限性?

答303:IoU计算不准确、缺少类别平衡处理、没有考虑医学图像特性等。

问304:如果要部署到生产环境,还需要什么?

答304:模型优化、推理加速、错误处理、性能监控等。

问305:从这个代码能学到什么深度学习的核心概念?

答305:数据预处理、模型训练循环、损失函数、优化器使用、评估指标等基础概念。