容器运行时支持GPU,并使用1panel安装ollama

前言

安装Docker请看之前博文:Docker实战中1panel方式安装Docker。

安装 NVIDIA 容器工具包

https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html

安装

先决条件

- 阅读有关平台支持的部分。

- 为您的 Linux 发行版安装 NVIDIA GPU 驱动程序。NVIDIA 建议使用发行版对应的软件包管理器安装驱动程序。有关使用软件包管理器安装驱动程序的信息,请参阅NVIDIA 驱动程序安装快速入门指南。或者,您也可以通过下载安装程序来安装驱动程序

.run。

在使用 cgroup 驱动程序的系统上存在一个已知问题,systemd该问题会导致容器在运行时失去对所请求 GPU 的访问权限 。请参阅故障排除文档了解更多信息。systemctl daemon reload

使用apt:Ubuntu,Debian(不可用)

- 配置生产存储库:

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

(可选)配置存储库以使用实验包:

sed -i -e '/experimental/ s/^#//g' /etc/apt/sources.list.d/nvidia-container-toolkit.list

- 从存储库更新软件包列表:

sudo apt-get update

- 安装 NVIDIA Container Toolkit 软件包:

export NVIDIA_CONTAINER_TOOLKIT_VERSION=1.17.8-1sudo apt-get install -y \nvidia-container-toolkit=${NVIDIA_CONTAINER_TOOLKIT_VERSION} \nvidia-container-toolkit-base=${NVIDIA_CONTAINER_TOOLKIT_VERSION} \libnvidia-container-tools=${NVIDIA_CONTAINER_TOOLKIT_VERSION} \libnvidia-container1=${NVIDIA_CONTAINER_TOOLKIT_VERSION}

很不幸,结果报错:

错误:7 [https://nvidia.github.io/libnvidia-container/stable/deb/amd64](https://nvidia.github.io/libnvidia-container/stable/deb/amd64) InRelease Could not handshake: Error in the pull function. [IP: 185.199.110.153 443]

错误:8 [https://nvidia.github.io/libnvidia-container/experimental/deb/amd64](https://nvidia.github.io/libnvidia-container/experimental/deb/amd64) InRelease Could not handshake: Error in the pull function. [IP: 185.199.110.153 443] 正在读取软件包列表... 完成

W: 无法下载 [https://nvidia.github.io/libnvidia-container/stable/deb/amd64/InRelease](https://nvidia.github.io/libnvidia-container/stable/deb/amd64/InRelease) Could not handshake: Error in the pull function. [IP: 185.199.110.153 443]

W: 无法下载 [https://nvidia.github.io/libnvidia-container/experimental/deb/amd64/InRelease](https://nvidia.github.io/libnvidia-container/experimental/deb/amd64/InRelease) Could not handshake: Error in the pull function. [IP: 185.199.110.153 443]

W: 部分索引文件下载失败。如果忽略它们,那将转而使用旧的索引文件。

下载deb后安装(可用)

- 首先查看上面安装命令里面的这个链接

https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list

deb https://nvidia.github.io/libnvidia-container/stable/deb/$(ARCH) /

#deb https://nvidia.github.io/libnvidia-container/experimental/deb/$(ARCH) /

-

点进去https://nvidia.github.io/libnvidia-container/stable/deb

页面显示Unsupported distribution or misconfigured repository settings -

在这个页面找到GitHub Pages repository structure

stable/deb: https://github.com/NVIDIA/libnvidia-container/tree/gh-pages/stable/debexperimental/deb: https://github.com/NVIDIA/libnvidia-container/tree/gh-pages/experimental/debstable/rpm: https://github.com/NVIDIA/libnvidia-container/tree/gh-pages/stable/rpmexperimental/rpm: https://github.com/NVIDIA/libnvidia-container/tree/gh-pages/experimental/rpm

-

好嘛,找到老巢了

https://github.com/NVIDIA/libnvidia-container/tree/gh-pages/stable/deb/amd64 -

下载下面几个文件,安装即可

sudo dpkg -i nvidia-container-toolkit_1.17.7-1_amd64.deb nvidia-container-toolkit-base_1.17.7-1_amd64.deb libnvidia-container1_1.17.7-1_amd64.deb libnvidia-container-tools_1.17.7-1_amd64.deb

配置

先决条件

- 您安装了受支持的容器引擎(Docker、Containerd、CRI-O、Podman)。

- 您安装了 NVIDIA Container Toolkit。

配置Docker

- 使用以下

nvidia-ctk命令配置容器运行时:

sudo nvidia-ctk runtime configure --runtime=docker

该nvidia-ctk命令会修改/etc/docker/daemon.json主机上的文件。该文件已更新,以便 Docker 可以使用 NVIDIA 容器运行时。

{"runtimes": {"nvidia": {"args": [],"path": "nvidia-container-runtime"}}

}

- 重新启动 Docker 守护进程:

sudo systemctl restart docker

配置 containerd(用于 Kubernetes)

- 使用以下

nvidia-ctk命令配置容器运行时:

sudo nvidia-ctk runtime configure --runtime=containerd

该nvidia-ctk命令会修改/etc/containerd/config.toml主机上的文件。该文件已更新,以便 containerd 可以使用 NVIDIA 容器运行时。

- 重启containerd:

sudo systemctl restart containerd

运行示例工作负载

https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/sample-workload.html

安装和配置工具包并安装 NVIDIA GPU 驱动程序后,您可以通过运行示例工作负载来验证您的安装。

- 运行示例 CUDA 容器:

sudo docker run --rm --runtime=nvidia --gpus all ubuntu nvidia-smi

您的输出应类似于以下输出:

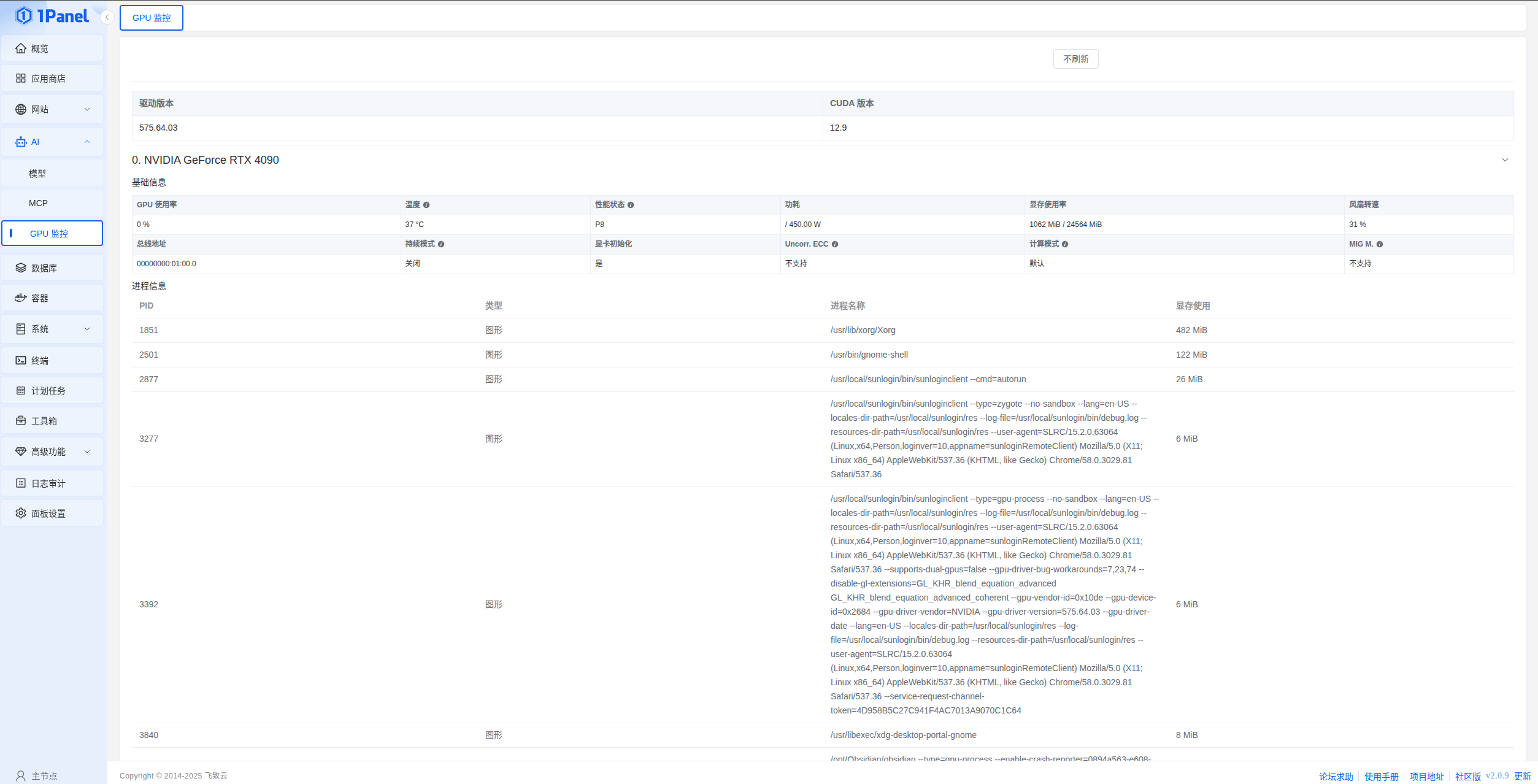

Thu Aug 14 13:54:11 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 575.64.03 Driver Version: 575.64.03 CUDA Version: 12.9 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce RTX 4090 Off | 00000000:01:00.0 On | Off |

| 31% 37C P8 34W / 450W | 1280MiB / 24564MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------++-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| No running processes found |

+-----------------------------------------------------------------------------------------+

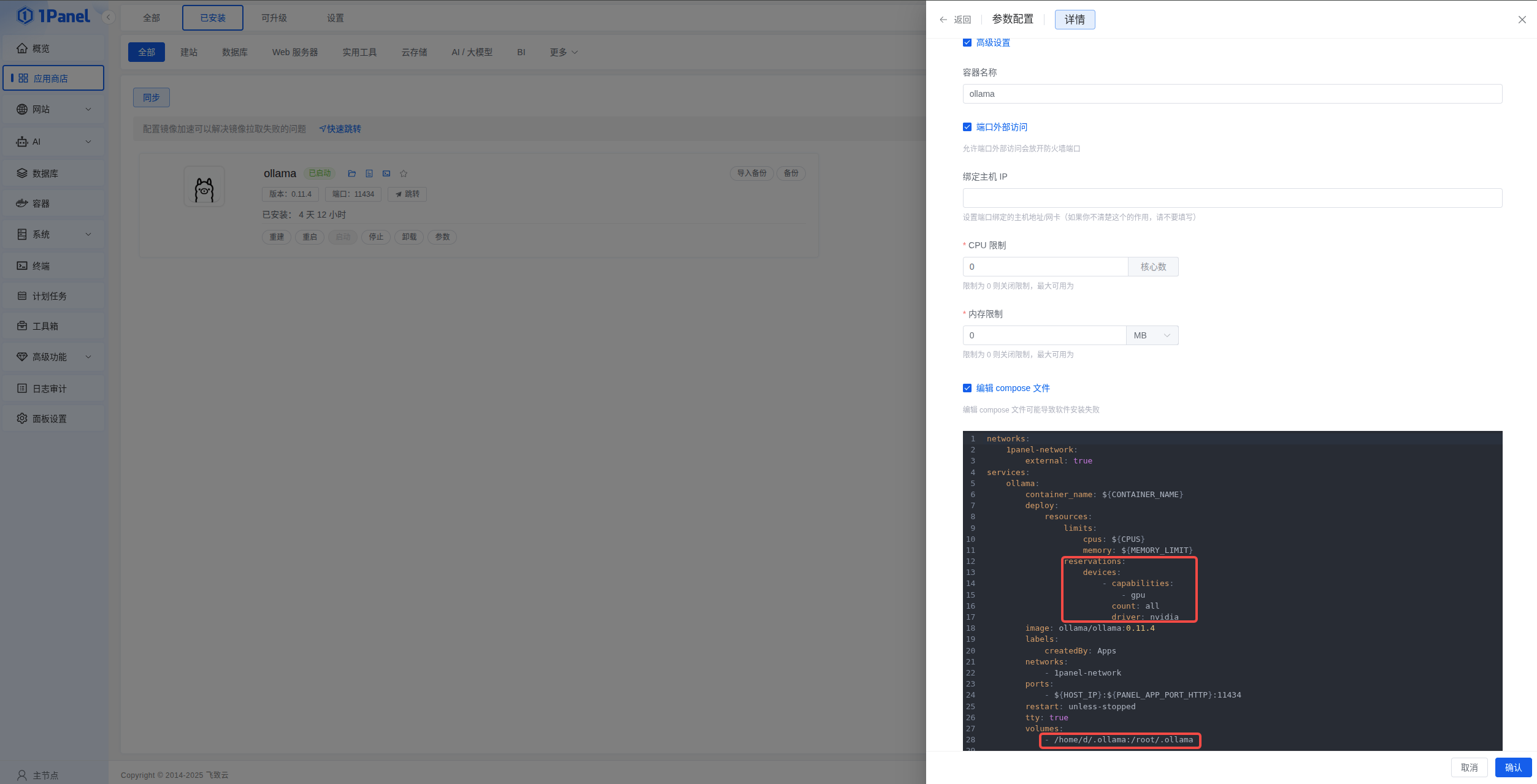

1panel安装docker版ollama

从应用商店安装

- 端口外部访问勾选上

- GPU配置如下:

reservations:devices:- capabilities:- gpucount: alldriver: nvidia

- 模型挂载换了下路径:

volumes:- /home/d/.ollama:/root/.ollama

GPU监控

很是方便,妈妈再也不用担心忘记敲:nvidia-smi

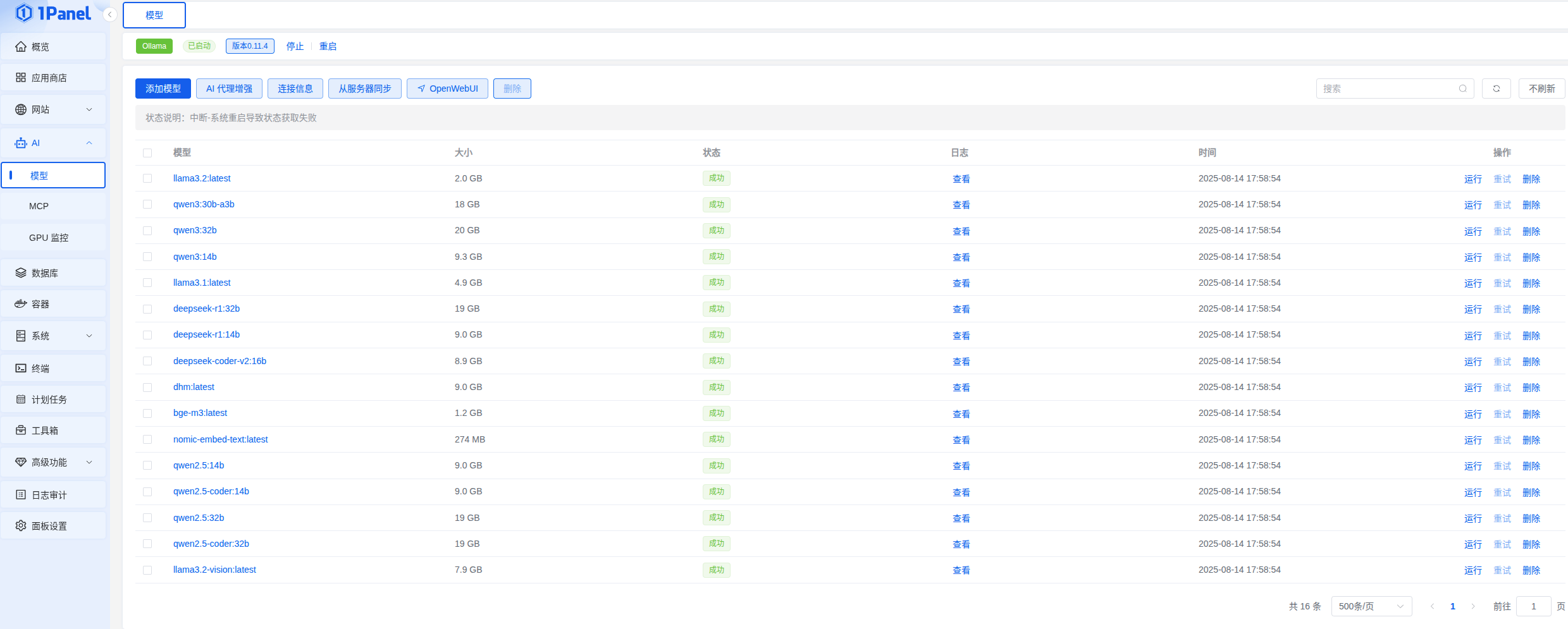

模型

之前写过一篇直接安装ollama的博文:使用ollama部署本地大模型(没有GPU也可以),实现IDEA和VS Code的git commit自动生成,其中模型位置:/usr/share/ollama/.ollama/models

在docker挂载中改为了/home/d/.ollama/models,点击从服务器同步即可