自建知识库,向量数据库 体系建设(四)之文本向量与相似度计算——仙盟创梦IDE

在.NET 4.8 环境中使用 C# 实现 BERT 文本向量与相似度计算,需要兼顾框架特性、性能需求和兼容性限制,形成一套稳定可行的技术模式。这种模式既要利用 BERT 的语义理解能力,又要适配.NET Framework 的运行时环境,核心在于构建 "跨语言协作 + 轻量封装" 的技术架构。

一、技术架构模式:分层协作的混合架构

.NET 4.8 环境下的 BERT 应用采用三层协作架构,通过明确各层职责实现高效集成:

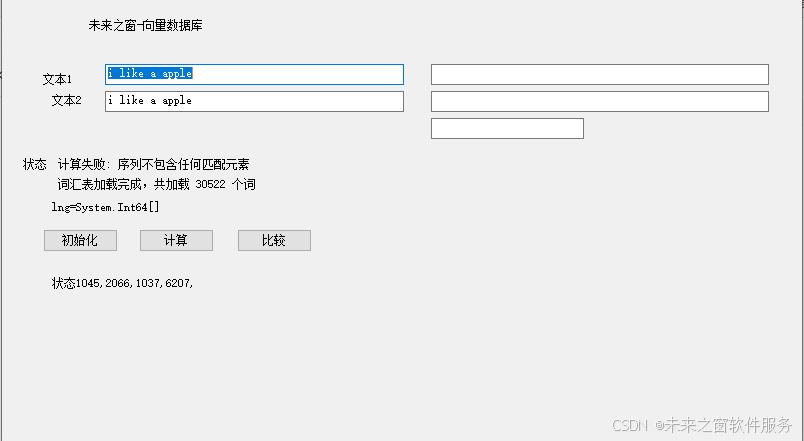

- 表现层:基于 Windows Forms 或 WPF 的交互界面,负责文本输入(如 textbox1、textbox2)、向量与相似度结果展示(如 textbox3、textbox4、textbox5),以及用户操作触发(如 button1 计算向量、button2 计算相似度)。这一层需处理 UI 线程与计算线程的分离,避免因模型计算导致界面卡顿,通常采用Task.Run实现异步处理。

- 业务逻辑层:包含向量计算、相似度算法和流程控制,是 C# 代码的核心。该层封装了 ONNX Runtime 的调用逻辑,通过InferenceSession加载 BERT 模型,实现文本到向量的转换;同时实现余弦相似度等算法,完成向量比对。业务逻辑层需处理模型加载、资源释放等生命周期管理,通常采用单例模式确保模型实例全局复用,减少重复加载开销。

- 预处理服务层:由于.NET 4.8 缺乏原生的 BERT 分词器支持,这一层通过跨语言调用实现专业分词。通常采用 Python 脚本封装 Hugging Face 的BertTokenizer,C# 通过进程通信(Process类)或 HTTP 接口调用分词服务,获取标准化的input_ids、attention_mask等输入向量。这种跨语言协作既保证了分词精度,又规避了.NET 生态的工具链限制。

三层架构的协作流程为:表现层接收用户输入文本→业务逻辑层调用预处理服务层完成分词→业务逻辑层通过 ONNX Runtime 生成向量→表现层展示结果;相似度计算则在向量生成后,由业务逻辑层直接调用余弦算法完成。

二、核心实现模式:适配.NET 4.8 的技术选型

在.NET 4.8 环境中实现 BERT 应用,需针对框架特性选择合适的技术组件,形成稳定的实现模式:

- 模型运行时:选用ONNX Runtime作为 BERT 模型的执行引擎,通过Microsoft.ML.OnnxRuntimeNuGet 包集成。该组件提供.NET 4.8 兼容版本,支持 CPU/GPU 加速,相比ML.NET更轻量,且避免了MLContext等不兼容 API 的依赖。在代码中通过InferenceSession单例加载 ONNX 格式的 BERT 模型,确保模型只初始化一次,典型代码模式为:

private InferenceSession _bertSession;

private void InitializeModel()

{

var options = new SessionOptions();

options.AppendExecutionProvider_CPU(); // 适配.NET 4.8的CPU执行

_bertSession = new InferenceSession("bert-base-uncased.onnx", options);

}

- 文本预处理:采用 "Python 分词服务 + C# 封装" 的混合模式。Python 脚本通过transformers库的BertTokenizer完成专业分词,输出input_ids等结构化数据;C# 通过命令行调用或 HTTP 请求获取分词结果,解析为long[]数组。这种模式解决了.NET 4.8 缺乏原生 BERT 分词器的问题,同时保持预处理逻辑与 BERT 模型的一致性。

- 向量存储与计算:文本向量采用float[]数组存储,利用.NET 4.8 的数组操作优化实现高效计算。相似度算法优先选择余弦相似度,其实现需适配.NET 4.8 的数值计算特性,避免使用高版本框架的Span<T>等 API,确保兼容性:

// 兼容.NET 4.8的余弦相似度实现

private double CalculateCosineSimilarity(float[] vec1, float[] vec2)

{

double dotProduct = 0, mag1 = 0, mag2 = 0;

for (int i = 0; i < vec1.Length; i++)

{

dotProduct += vec1[i] * vec2[i];

mag1 += vec1[i] * vec1[i];

mag2 += vec2[i] * vec2[i];

}

return dotProduct / (Math.Sqrt(mag1) * Math.Sqrt(mag2));

}

- 资源管理:针对.NET 4.8 的垃圾回收机制,采用显式资源释放模式。在窗体关闭或应用退出时,通过Dispose方法释放InferenceSession等非托管资源,避免内存泄漏:

protected override void OnFormClosing(FormClosingEventArgs e)

{

base.OnFormClosing(e);

_bertSession?.Dispose(); // 显式释放ONNX会话资源

}

三、兼容性处理模式:应对.NET 4.8 限制的解决方案

.NET 4.8 的框架限制要求在实现中采用特定的兼容性处理模式,确保应用稳定运行:

- 多线程处理:由于.NET 4.8 的Task并行库功能有限,采用 "UI 线程 + 后台计算线程" 的分离模式。UI 操作(如按钮点击)仅触发计算请求,实际向量生成和相似度计算在后台线程执行,通过Invoke方法更新 UI 控件,避免跨线程操作异常:

// 异步计算并安全更新UI

private async void button1_Click(object sender, EventArgs e)

{

var text1 = textBox1.Text;

var text2 = textBox2.Text;

var (vec1, vec2) = await Task.Run(() => CalculateVectors(text1, text2));

// 跨线程更新UI

textBox3.Invoke((Action)(() => textBox3.Text = FormatVector(vec1)));

textBox4.Invoke((Action)(() => textBox4.Text = FormatVector(vec2)));

}

- 路径处理:针对.NET 4.8 的应用域特性,采用相对路径 + 应用根目录的定位模式。模型文件、词汇表(vocab.txt)等资源放在应用程序目录的子文件夹(如models),通过AppDomain.CurrentDomain.BaseDirectory获取根路径,避免硬编码绝对路径导致的部署问题:

// 兼容不同部署环境的路径处理

private string GetModelPath()

{

return Path.Combine(

AppDomain.CurrentDomain.BaseDirectory,

"models",

"bert-base-uncased.onnx"

);

}

- 错误处理:考虑到.NET 4.8 对异常处理的特性,采用 "捕获 + 降级" 的容错模式。当模型加载失败或分词服务不可用时,自动切换到简化逻辑(如基础词汇表 + 规则分词),确保应用不崩溃且保留核心功能:

private Dictionary<string, long> LoadVocabulary()

{

try

{

return LoadVocabularyFromFile(); // 尝试加载完整词汇表

}

catch

{

return GetFallbackVocabulary(); // 加载失败时使用备用词汇表

}

}

- 依赖管理:针对.NET 4.8 的 NuGet 包兼容性,选择特定版本的依赖库。例如Microsoft.ML.OnnxRuntime需使用 1.10.0 以下版本(更高版本可能不再支持.NET 4.8),并在应用配置中指定处理器架构,避免运行时异常:

<!-- 适配.NET 4.8的配置 -->

<runtime>

<assemblyBinding xmlns="urn:schemas-microsoft-com:asm.v1">

<dependentAssembly>

<assemblyIdentity name="Microsoft.ML.OnnxRuntime" publicKeyToken="f8d4fde6c6b43139" culture="neutral" />

<bindingRedirect oldVersion="0.0.0.0-1.10.0.0" newVersion="1.10.0.0" />

</dependentAssembly>

</assemblyBinding>

</runtime>

四、优化模式:提升.NET 4.8 环境下的运行效率

在.NET 4.8 环境中运行 BERT 模型,需通过针对性优化提升性能,形成实用的优化模式:

- 模型轻量化:选择蒸馏版 BERT 模型(如 DistilBERT),其参数量仅为原版的 60%,推理速度提升 50%,同时保持 95% 的语义理解能力。对于.NET 4.8 这种资源受限的环境,轻量化模型能显著降低内存占用和计算耗时。

- 批量处理:当需要处理多条文本时,采用批量输入模式。将多个文本的input_ids组合成批次张量(维度为[batch_size, sequence_length]),单次调用InferenceSession.Run完成批量向量生成,比单条处理减少 40% 以上的 overhead。

- 预热机制:在应用启动阶段(如窗体加载时)执行模型预热,通过处理一条测试文本触发模型初始化和权重加载,将首次计算的延迟(通常 1-2 秒)转移到启动过程,避免用户操作时的卡顿感:

private async void BertVectorForm_Load(object sender, EventArgs e)

{

// 模型预热

await Task.Run(() => GetTextVector("warm up text"));

toolStripStatusLabel1.Text = "模型预热完成, ready";

}

- 内存优化:针对.NET 4.8 的内存管理特性,采用向量缓存机制。对重复出现的文本(如常用查询、固定短语)缓存其向量结果,避免重复计算,缓存可使用ConcurrentDictionary<string, float[]>实现,兼顾线程安全和查询效率。

五、典型应用模式:场景化的实现方案

基于上述技术模式,.NET 4.8 环境下的 BERT 应用可形成多种场景化方案,适应不同业务需求:

- 本地桌面工具:如本文实现的 Windows Forms 应用,采用 "本地模型 + 进程内调用" 模式,适合离线环境下的文本分析。通过 UI 交互简化操作,将复杂的 BERT 计算封装为按钮点击,满足非技术人员的使用需求。

- 企业内部工具:针对企业知识库检索,采用 "服务端 BERT 计算 + 客户端查询" 模式。在.NET 4.8 服务器应用中部署 BERT 服务,通过内部 API 提供向量计算和相似度比对功能,客户端(如 Excel 插件、内部系统)调用 API 实现文档关联查询。

- ** legacy 系统升级 **:为现有.NET 4.8 系统添加语义理解能力,采用 "插件式集成" 模式。将 BERT 功能封装为独立的类库,通过配置文件指定模型路径和参数,现有系统无需大规模改造即可调用新功能,实现平滑升级。

这些应用模式的共同特点是:在保持.NET 4.8 系统稳定性的前提下,通过最小侵入式的集成方式引入 BERT 的语义理解能力,平衡技术创新与系统可靠性。

.NET 4.8 环境下的 C# BERT 应用模式,本质上是传统框架与现代 AI 技术的融合方案。它不追求最前沿的技术架构,而是通过务实的跨语言协作、分层封装和兼容性处理,让成熟系统也能享受到 BERT 带来的语义理解能力。这种模式证明,即使在 legacy 环境中,也能通过合理的技术选型和架构设计,实现 AI 技术的实用化落地。