论文Review 激光动态物体剔除 Dynablox | RAL2023 ETH MIT出品!

基本信息

题目:Dynablox: Real-time Detection of Diverse Dynamic Objects in Complex Environments

来源:RAL2023

学校:ETH、MIT

是否开源:https://github.com/ethz-asl/dynablox

摘要:激光动态物体剔除

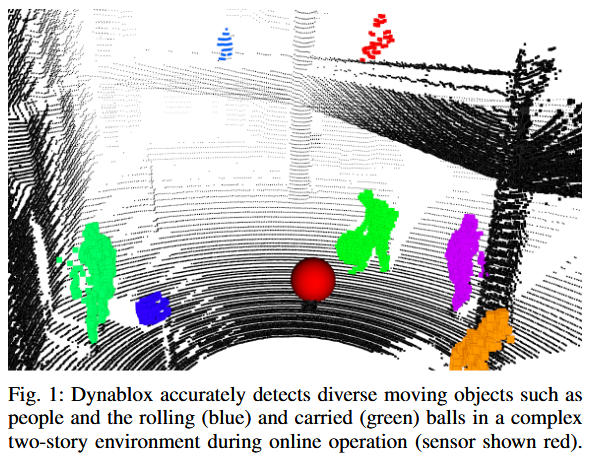

运动目标的实时检测是机器人在动态环境中自主作业的必备能力。因此,我们提出了一种新的基于在线映射的方法机器砖块,用于在复杂的非结构化环境中进行鲁棒的运动目标检测。该方法的中心思想是通过对在线机器人运行过程中的传感、状态估计和映射限制进行建模和核算,增量估计高置信度的自由空间区域。时空保守的自由空间估计可以在不对物体或环境的外观做出任何假设的情况下实现对移动物体的鲁棒检测。这允许部署在复杂的场景中,如多层建筑或楼梯,以及对于多样化的移动对象,如携带各种物品的人,门的摇摆甚至滚球。我们在真实数据集上对我们的方法进行了全面的评估,在典型的机器人设置中,在17 FPS下达到了86%的IoU。该方法优于最近的基于外观的分类器,并接近离线方法的性能。

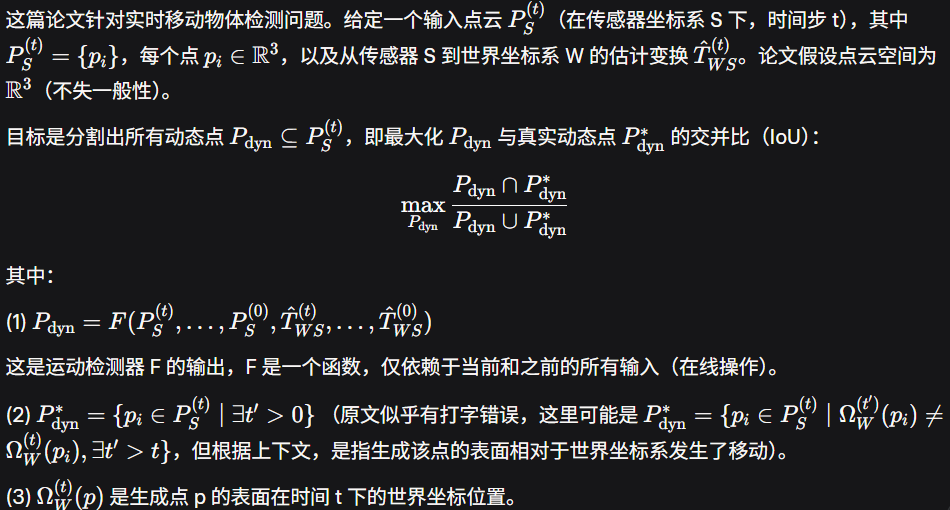

文章提出一种在线、实时移动物体检测方法,基于点云数据和体积映射框架(扩展Voxblox)。核心是增量估计高信心自由空间,通过建模传感器稀疏、噪声、漂移和地图不准等限制。方法流程:

- 地图表示:使用TSDF体素地图,添加时序属性(最后占用帧、持续帧、高信心自由标签)。

- 整合点云:构建点到体素映射,更新地图。

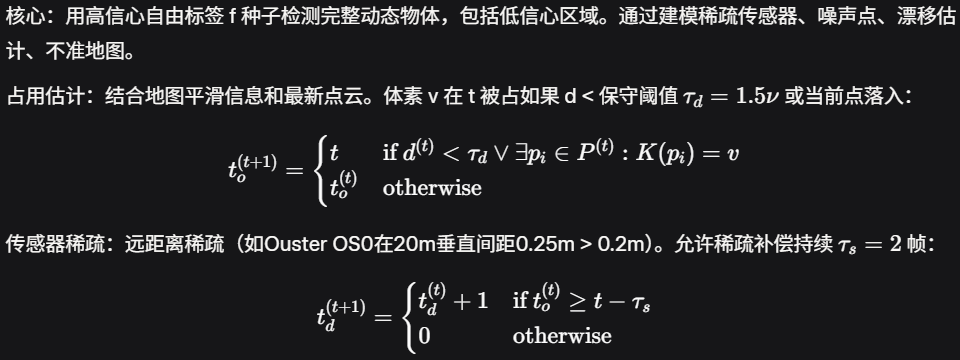

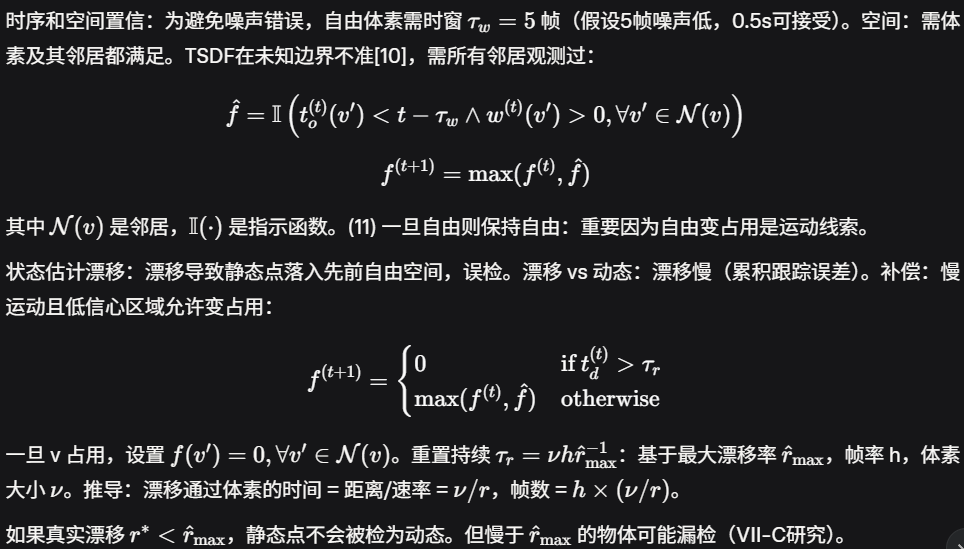

- 高信心自由空间估计:保守占用估计,补偿稀疏、时空置信、漂移(重置阈值τ_r)。

- 动态点检测:用高信心自由体素种子检测占用体素,聚类扩展到低信心区域,滤除小簇。 方法无学习,纯几何,确保实时(界定计算)和鲁棒。

Introduction

移动机器人的能力正在超越受控环境向复杂动态环境中的检查、安全或物流等多样化任务发展,可靠地检测人、车辆和其他机器人等各种移动对象的需求对于机器人的安全运行至关重要。这是一个具有挑战性的问题,原因是多方面的。在许多情况下,自主机器人必须在新的或快速变化的环境中行动。因此,他们必须在线和在车载平台检测移动物体,而不是依靠现有的地图。此外,现实世界的工作场所和公共空间也面临着多重挑战,因为它们没有表现出强烈的结构,例如平坦的街道或有标记的行人路口。相反,环境结构有很大的变化,例如矿井中的隧道到商场,具有多层次的开放式平面,楼梯,或坡道,以及在运动中遇到的物体类型,如儿童打球,宠物,或人携带的物体。然而,大多数关于在线运动目标检测的工作都大量使用了基于外观的线索,要么是针对特定类型的环境设计的,要么是使用带标签的样本进行离线训练的。这使得它们在不常见的物体或非平面环境中容易失效,如图1所示。

为了在异构的非结构化环境和物体上实现鲁棒的运动目标检测,我们在这里提出了一种基于在线映射的方法,该方法通过从最先进的体积映射解决方案中提取运动线索来对外观不敏感。我们的方法是基于这样的见解:为了使用地图鲁棒地检测移动对象,我们需要一个鲁棒的自由空间的概念。然而,当在线构建地图时,这一点尤其具有挑战性,因为误差不仅来自传感器噪声,还来自状态漂移、未探测空间边界处的地图不确定性以及距离向的稀疏回报。我们依次详细说明如何克服这些问题来估计高置信度的自由体素集合。然后这些被用来恢复所有的移动点,并相应地更新地图。因此,我们的方法不需要预先知道机器人将遇到的环境或运动物体的类型。其次,与在这种环境中进行自主导航所需的传统映射栈相比,它增加了很少的计算开销,使其能够在笔记本电脑级CPU上在线实时运行。

虽然该方法是通用的,但在这项工作中,我们专注于配备激光雷达传感器的机器人。激光雷达已经出现。作为在具有挑战性的条件下映射复杂未知环境的可靠选择,在最近的DARPA Subterannean挑战赛中的团队严重依赖它[ 1 ] [ 4 ]。由于在非结构化环境中仍然缺乏3D运动目标检测的开源解决方案,我们将我们的实现作为一个层运行在流行的映射框架Voxblox [ 5 ]之上,该框架也被DARPA SubT获奖团队使用[ 1 ]。

我们做出了以下贡献:

- 我们提出了一种从点云数据中增量式高置信度自由空间估计的方法,建模了传感器噪声、测量稀疏性、动态环境和状态估计漂移。

- 我们提出了Dynablox,我们的系统利用高置信度自由空间在复杂的非结构化环境中对各种动态物体进行鲁棒的实时检测。

- 我们对所提出的方法进行了全面的评估,在移动CPU上达到了17FPS的86% IoU,并证明了其对根本不同的物体类型、不同的环境和漂移状态估计的鲁棒性。

[1] M. Tranzatto, M. Dharmadhikari, L. Bernreiter, M. Camurri, S. Khattak, F. Mascarich, P. Pfreundschuh, D. Wisth, S. Zimmermann, M. Kulkarni, et al., “Team cerberus wins the darpa subterranean challenge: Technical overview and lessons learned,” arXiv preprint arXiv:2207.04914, 2022.

[4] S. Zhao, H. Zhang, P. Wang, L. Nogueira, and S. Scherer, “Super odometry: Imu-centric lidar-visual-inertial estimator for challenging environments,” in IEEE/RSJ Int. Conf. on Intelligent Robots and Systems, 2021, pp. 8729–8736.

[5] H. Oleynikova, Z. Taylor, M. Fehr, R. Siegwart, and J. Nieto, “Voxblox: Incremental 3d euclidean signed distance fields for on-board mav planning,” in IEEE/RSJ Int. Conf. on Intelligent Robots and Systems. IEEE, 2017, pp. 1366–1373.

Related Works

我们根据分割点云中运动物体的主要方法对相关工作进行分类:基于appearance-based外观的每个点云的分割,对以前的点进行scan-to-scan检测,或者通过比较点云与地图进行map-based的变化检测。有几个工作使用了不止一种方法。与我们在非结构化杂乱环境中对自主机器人的关注相反,最近的工作主要集中在自动驾驶设置上。

动态物体的空间外观可以仅从一个点云中进行检测。这要么是通过模型,要么是通过事先对有标签的示例进行训练,是针对对象或环境的。一个微妙但常见的基于外观的假设是过滤掉地面。然而,虽然街道和楼层大多是平坦的,但这在许多机器人应用中并不成立。最近的许多工作集中于学习点云的语义分割,其中大部分工作集中于自动驾驶和使用Semantic KITTI [ 11 ]。然而,基于外观的方法的一个主要限制是,机器人经常需要在open-set环境中操作,在open-set环境中可能会遇到先前未知的物体。 相反,我们开发了一种方法来检测复杂场景中的各种移动对象。

在点云配准或场景流中,也可以从残差中分割出运动物体。这些方法对物体类型不敏感,但它们通常计算昂贵,并且与缓慢移动的物体或具有单独移动部件的铰接物体(如行人)斗争。有的方法在点云配准上使用RANSAC依次估计多个刚性运动假设。这一点在Deep semantic classification中也已经与学习外观相结合。先进的基于学习的自动驾驶方法还包括scan to scan的深度残差,以改进基于外观的方法[ 8、9 ]。然而,基于外观的学习失去了纯scan to scan方法的对象不可知性。相比之下,4DMOS [ 14 ]最近提出完全在一系列点云上进行训练,使其对物体外观的依赖性降低。

[8] X. Chen, S. Li, B. Mersch, L. Wiesmann, J. Gall, J. Behley, and C. Stachniss, “Moving object segmentation in 3d lidar data: A learningbased approach exploiting sequential data,” IEEE Robotics and Automation Letters, vol. 6, no. 4, pp. 6529–6536, 2021.

[9] J. Sun, Y. Dai, X. Zhang, J. Xu, R. Ai, W. Gu, and X. Chen, “Efficient spatial-temporal information fusion for lidar-based 3d moving object segmentation,” in IEEE/RSJ Int. Conf. on Intelligent Robots and Systems, 2022, pp. 11 456–11 463.

[14] B. Mersch, X. Chen, I. Vizzo, L. Nunes, J. Behley, and C. Stachniss, “Receding moving object segmentation in 3d lidar data using sparse 4d convolutions,” IEEE Robotics and Automation Letters, vol. 7, no. 3, pp. 7503–7510, 2022.

基于地图的方法通常需要一个现有的地图来进行检测。如果一个环境已经被建好图,背景减除可以用来帮助运动物体的恢复。最近的基于地图的方法[ 10、16]侧重于离线生成基于外观分类器的标签。然而,这些运行速度太慢,无法在线运行,并且利用它们在场景中既有过去又有未来的数据。

[10] P. Pfreundschuh, H. F. Hendrikx, V. Reijgwart, R. Dub ́e, R. Siegwart, and A. Cramariuc, “Dynamic object aware lidar slam based on automatic generation of training data,” in IEEE Int. Conf. on Robotics and Automation, 2021, pp. 11 641–11 647.

[16] X. Chen, B. Mersch, L. Nunes, R. Marcuzzi, I. Vizzo, J. Behley, and C. Stachniss, “Automatic labeling to generate training data for online lidar-based moving object segmentation,” IEEE Robotics and Automation Letters, vol. 7, no. 3, pp. 6107–6114, 2022.

类似地,地图清洗方法试图离线去除动态对象,以计算环境[ Erasor、peopleremover ]的精确静态地图。虽然相关,地图通常足够稠密,即使有相当大的伪去除,这意味着它们的度量集中于静态点,并且方法没有直接可比性。这可以利用非常近似的自由空间计算[ 19、20 ],最近,子地图的在线清理已经出现[ 21 ],但它只需要在集成多个点云的子地图时进行清理,而不需要在传感器速率下进行清理。

[19] D. Yoon, T. Tang, and T. Barfoot, “Mapless online detection of dynamic objects in 3d lidar,” in Conf. Comp. & Rob. Vision, 2019, pp. 113–120.

[20] F. Pomerleau, P. Kr ̈usi, F. Colas, P. Furgale, and R. Siegwart, “Long-term 3d map maintenance in dynamic environments,” in IEEE Int. Conf. on Robotics and Automation, 2014, pp. 3712–3719.

[21] T. Fan, B. Shen, H. Chen, W. Zhang, and J. Pan, “Dynamicfilter: an online dynamic objects removal framework for highly dynamic environments,” in IEEE Int. Conf. on Robotics and Automation, 2022, pp. 7988–7994.

与我们最接近的是方法是在线建立一个占用网格,在自由空间中检测移动中的点,并将它们聚集成通过时间跟踪的对象。但它只使用了2D的测距仪扫描,在3D中可能无法很好地工作。在之后的工作中,这样的八叉树结构被用于在线检测街道上的运动物体,但他们注意到他们的方法对行人效果不佳,并且没有提供量化的结果。

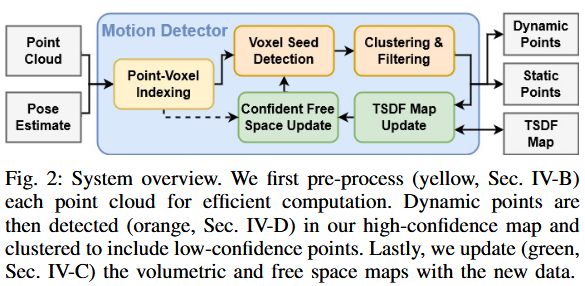

III. PROBLEM STATEMENT

直观上,这是最大化检测到的动态点与真实动态点的IoU。机器人在线操作时,F 仅使用过去输入。点被视为动态,如果生成它的表面相对于世界坐标系移动了。

IV. APPROACH

为了实现目标,论文利用运动线索:如果一个点落入已知自由空间,则它必须移动到那里,因此是动态的。但在线操作中,确定真正自由空间很困难:传感器读数稀疏、点噪声、状态估计漂移、地图重建不准(观测有限)。

如果空间错误分类为自由,会将静态部分检测为移动;如果太保守,可能延迟检测动态物体,危及安全。

核心想法:逐步估计一个缩小但高信心的自由空间区域,通过建模每个限制因素。然后用这些高信心区域种子动态物体簇,并消除低信心区域的歧义。

机器人通常需要构建导航地图,论文利用此事实,在Voxblox [5](广泛使用的映射框架)上实现轻量级方法,计算开销最小。

系统概述(图2):预处理(黄色,IV-B)点云;检测动态点(橙色,IV-D)在高信心地图中,并聚类包括低信心点;更新(绿色,IV-C)体积和自由空间地图。

[5] H. Oleynikova, Z. Taylor, M. Fehr, R. Siegwart, and J. Nieto, “Voxblox: Incremental 3d euclidean signed distance fields for on-board mav planning,” in IEEE/RSJ Int. Conf. on Intelligent Robots and Systems. IEEE, 2017, pp. 1366–1373.

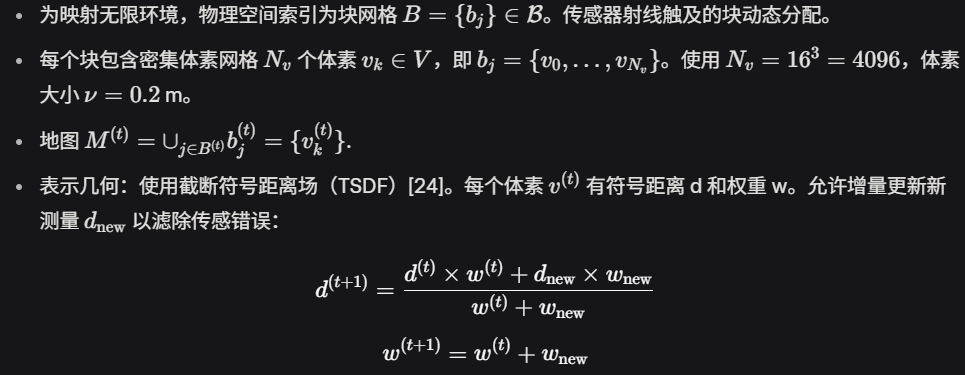

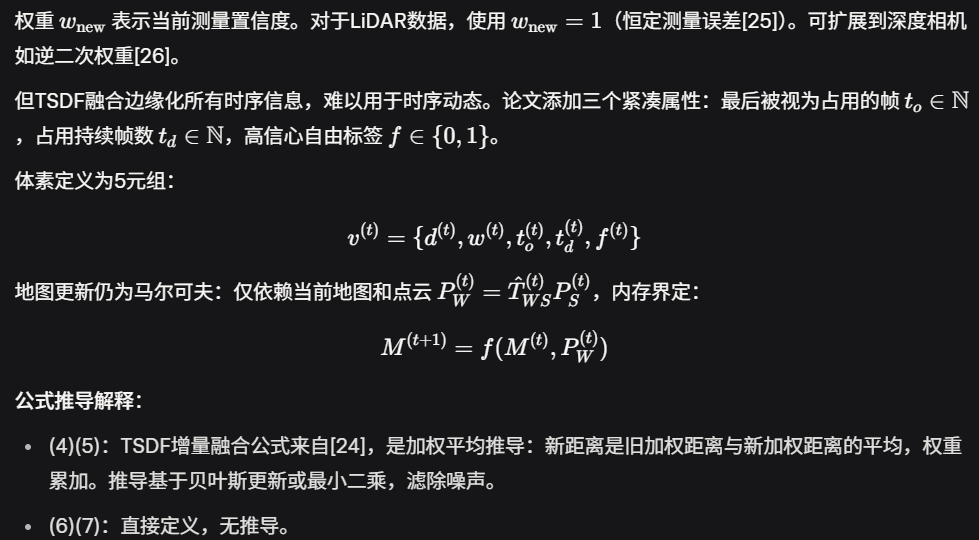

A. Map Representation

地图表示是基于映射的运动检测的核心。论文适应并扩展Voxblox [5]:优点1,直接用于导航,无额外计算;优点2,利用分层空间哈希块结构高效实时计算。但方法适用于其他表示。

简要总结Voxblox并扩展:

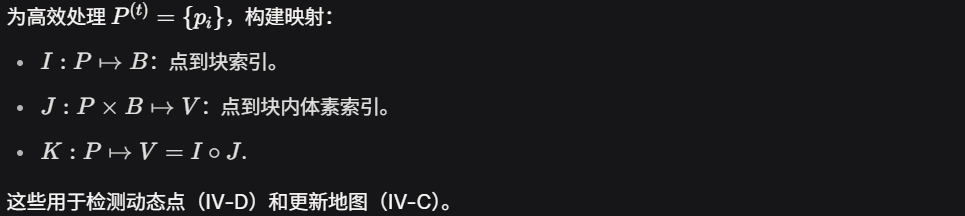

B. Integrating New Point Clouds

C. High-confidence Free-space Estimation

公式推导解释:

D. Detecting Dynamic Points

实验

硬件平台

NUC(配备笔记本级AMD-4800U CPU)上运行

数据集

- 定量评估:使用DOALS [10]数据集,该数据集包含8个序列,覆盖4种环境,使用高范围、高分辨率的OS1 64 LiDAR以10 Hz频率采集。主要探索开放、平坦环境,以行人为主要移动物体。

- 定性评估:由于DOALS数据集局限性(主要行人和平坦环境),作者额外录制了新序列,使用OS0 128高范围、高分辨率LiDAR(10 Hz )。数据使用Fast-lio2 处理,以模拟真实机器人操作中的状态估计。这些新序列公开发布,包含挑战性环境和多样移动物体(如球、门等)。

[10] P. Pfreundschuh, H. F. Hendrikx, V. Reijgwart, R. Dub ́e, R. Siegwart, and A. Cramariuc, “Dynamic object aware lidar slam based on automatic generation of training data,” in IEEE Int. Conf. on Robotics and Automation, 2021, pp. 11 641–11 647.

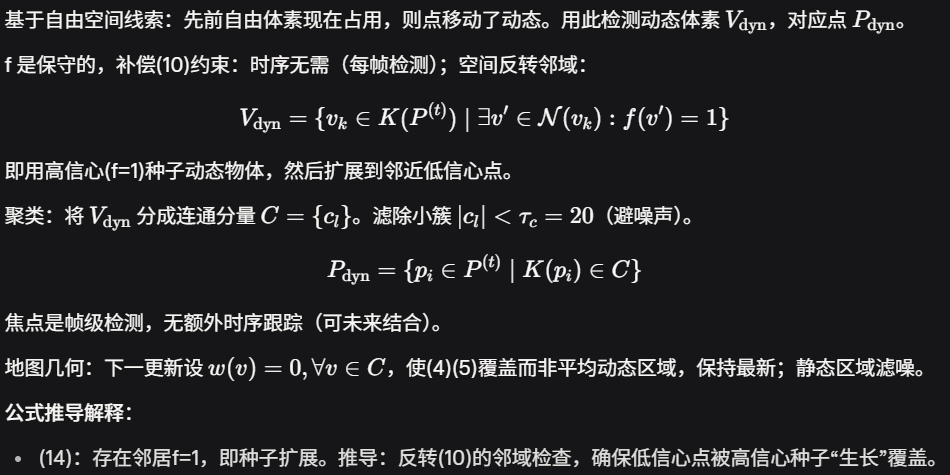

Benchmark

A. Dynamic Point Detection Performance

- 结果表格(Tab. I):在DOALS数据集上比较方法性能。全范围(最大172.7 m)和有限范围(d_max = 20 m)下评估。

- 基线:

- Occupancy [10]:离线方法,使用所有过去和未来扫描,作为性能上限(IoU较高)。

- 学习-based:DOALS-3DMiniNet (在DOALS其他环境训练,最好性能,因针对行人)、4DMOS [14](强调空间运动线索,转移较好)、LMNet 、MotionSeg3D (预训于KITTI ,原始性能低;refit后改善,但仍低于作者方法)。

- 映射-based:Low-confidence (LC) Free Space (直接查询低信心自由空间,性能显著低于作者方法)。

- 作者方法性能:全范围下IoU高于学习方法,接近离线上限;有限范围下略有提升(附近物体更相关)。方差低,表明跨序列稳定性。

- 基线:

- 分析:

- 挑战:远距离密度低、领域差距(学习方法需重训)、物体类依赖(学习方法针对行人)。

- 作者方法无先验、物体类无关,泛化好。IoU高,适用于长范围检测。

- LC Free Space性能低,强调高信心地图的重要性。

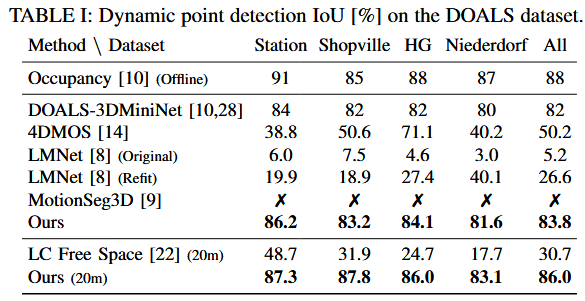

B. Robustness to Object Class and Environment

- 定性结果(Fig. 3):在新录序列上展示检测。

- 成功检测:多样行人(携带箱子、行李箱、冲浪板)、不同物体(滚动的球、摆动的门)。

- 环境:挑战性、非结构化场景(无地面平面假设),静态几何正确分类(保守估计)。

- 分析:方法纯几何,无物体类依赖,优于学习方法(后者常针对特定类,如行人)。泛化到开放世界。

C. Robustness to Drift

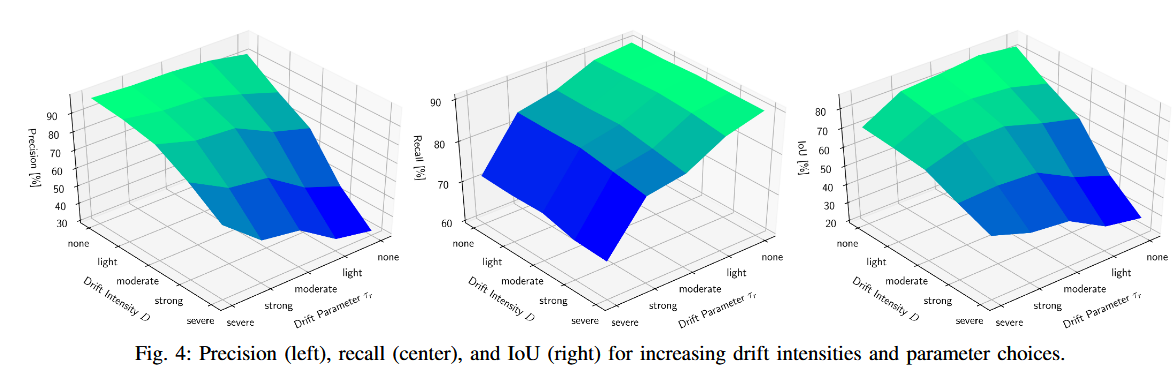

- 实验:使用[29]漂移模拟器,在DOALS上生成随机漂移(强度D:none, light, moderate, strong, severe;真实最大漂移率 r^*_max = {1.26, 3.65, 4.54, 10.38} cm/s)。每个D和序列3次 rollout。τ_r = {∞, 150, 50, 40, 15}(基于(13))。

- 结果(Fig. 4):精确率(precision)、召回率(recall)、IoU。

- 精确率:保守τ_r提高精确率;高漂移降低,但τ_r缓解(最多2.9×)。

- 召回率:独立于漂移强度(真动态点仍检测);高τ_r略降(慢物体漏检),最差72%。

- IoU:当τ_r匹配D时最佳(验证模型假设)。

- 分析:方法对轻漂移(如[27]的LiDAR里程计)强健;严重漂移下位移达3.5m仍鲁棒。正确设置τ_r提升88%;过估τ_r降15%,建议稍高设置。

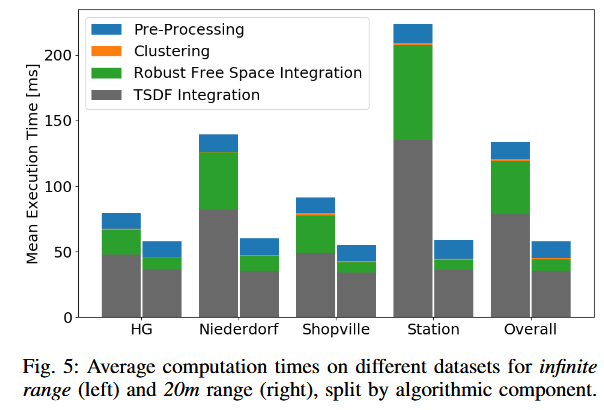

D. Computation Cost Analysis

总结优势和不足

优势

- 高性能和鲁棒性:IoU接近离线上限,优于学习方法;无先验、物体类无关,泛化强(多样物体、环境、漂移)。

- 实时性:低计算成本(<60 ms/帧),适合机器人硬件;若有导航地图,额外开销小。

- 保守高信心设计:减少假阳性,适用于安全关键场景;漂移补偿有效(精确率提升2.9×)。

- 泛化:纯几何,无需训练/重训,适用于新数据集/长范围。

- 实际影响:公开新数据集,促进研究。

不足

- 局限物体/环境:薄/反射物体难处理;依赖密集映射和高数据率,可能在快速运动或遮挡下部分失败。

- 慢物体检测:漂移补偿可能漏检慢于 \hat{r}_{\max} 的物体(召回降至72%)。

- 保守性权衡:高信心导致延迟检测新区域物体(τ_w=5帧,0.5s)。

- 无时序跟踪:帧级检测,可能未来结合跟踪提升。

- 计算依赖:大开放空间下无限整合距高成本(需限d_int)。

初体验

TODO