MM DEMO-2025 | 北航新融合LLM与多模态交互的无人机导航系统!AirStar,智能空中助手等你来体验

作者:Ziqin Wang, Jinyu Chen, Xiangyi Zheng, Qinan Liao, Linjiang Huang, Si Liu

单位:北京航空航天大学

论文标题:Hi AirStar, Guide Me to the Badminton Court

论文链接:https://www.arxiv.org/pdf/2507.04430

项目主页:https://buaa-colalab.github.io/airstar.github.io/

主要贡献

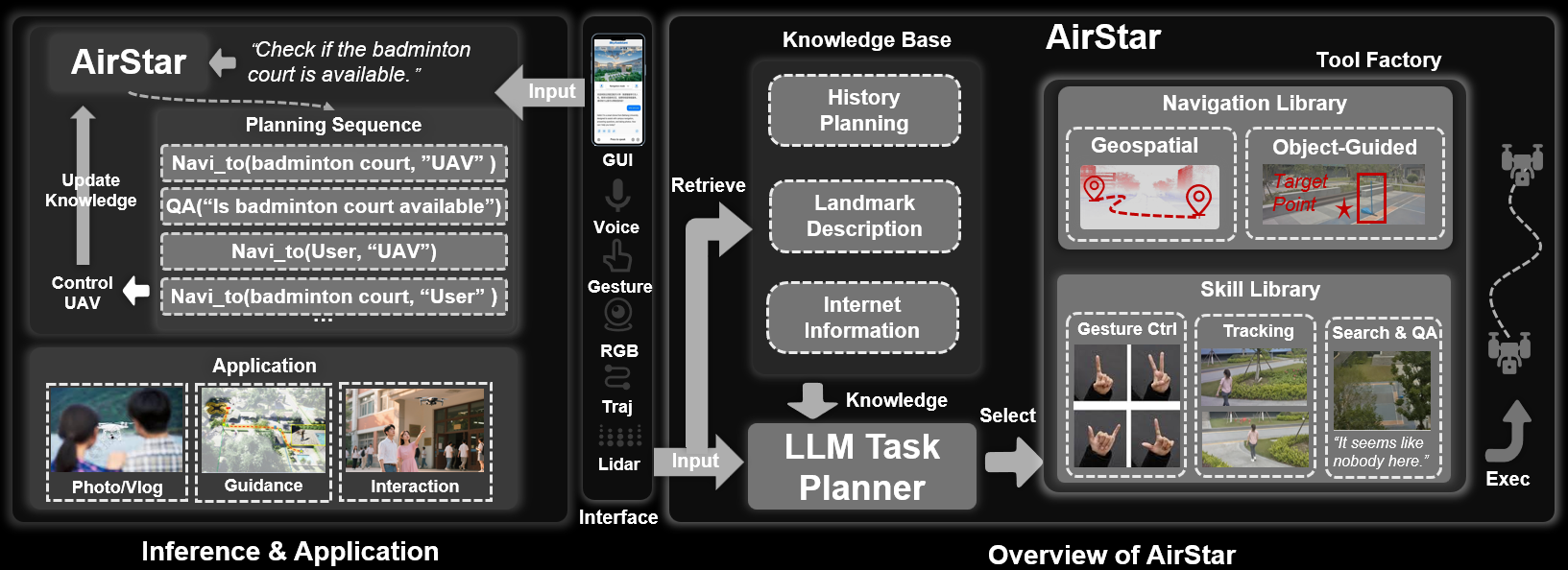

提出了无人机系统AirStar,将无人机的高机动性与大型语言模型(LLM)的认知能力相结合,使无人机能够理解自然语言指令并执行复杂任务。

通过LLM任务规划器,AirStar能够将复杂任务分解为可执行的技能序列,并动态调整任务执行过程中的失败情况。

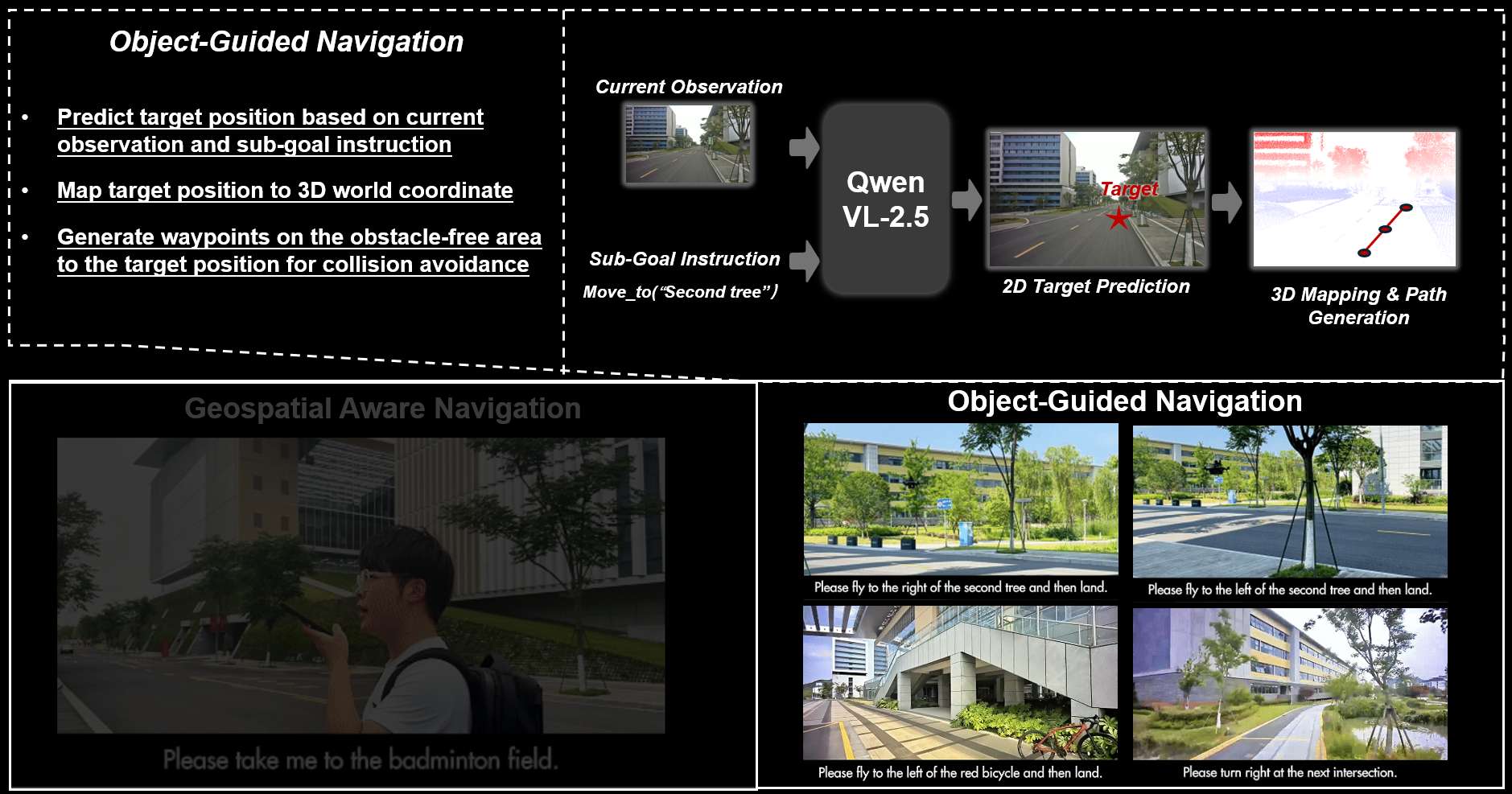

AirStar支持基于地理信息的长距离导航和基于视觉语义的短距离导航,提高了导航的准确性和灵活性。

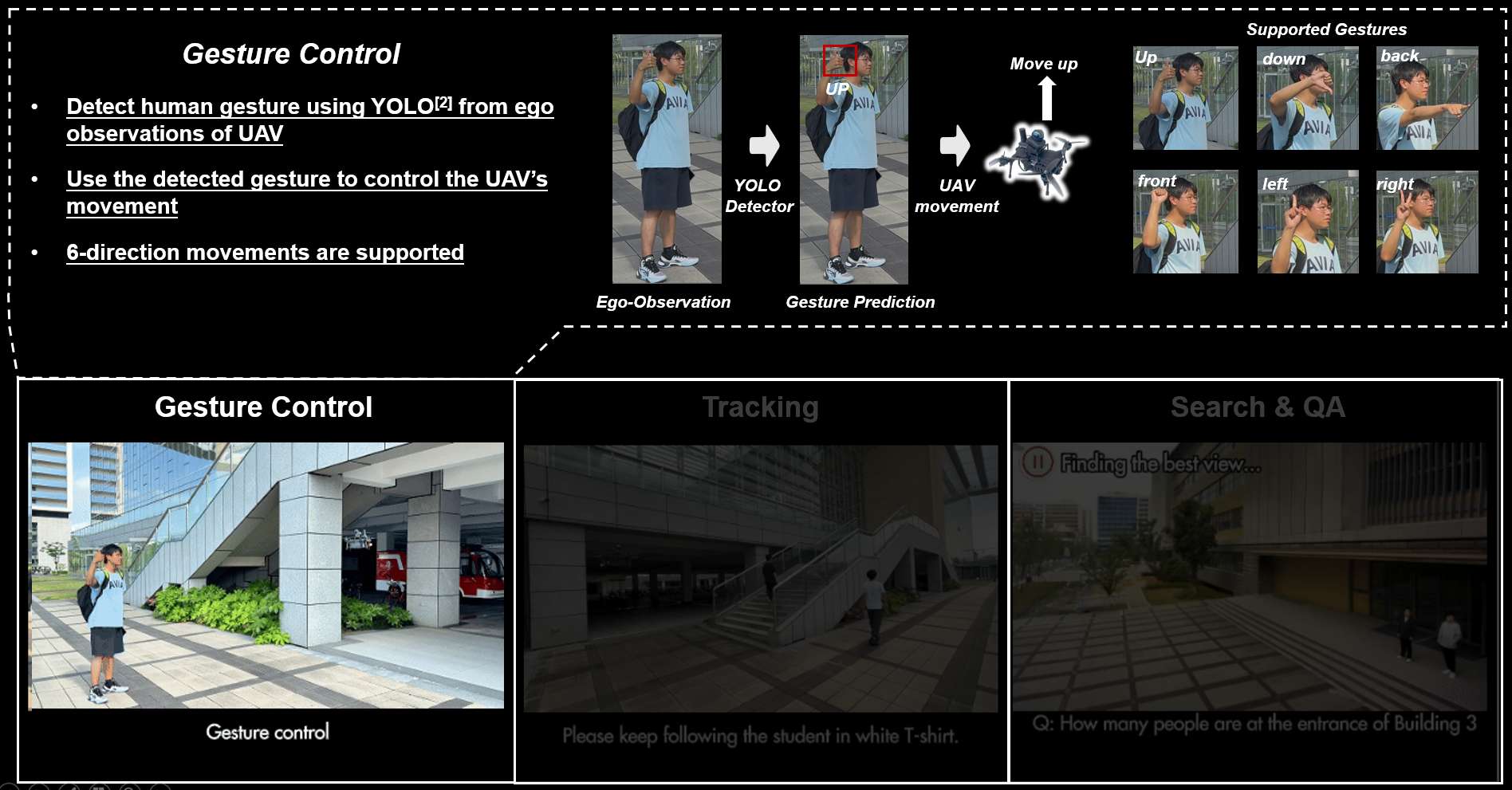

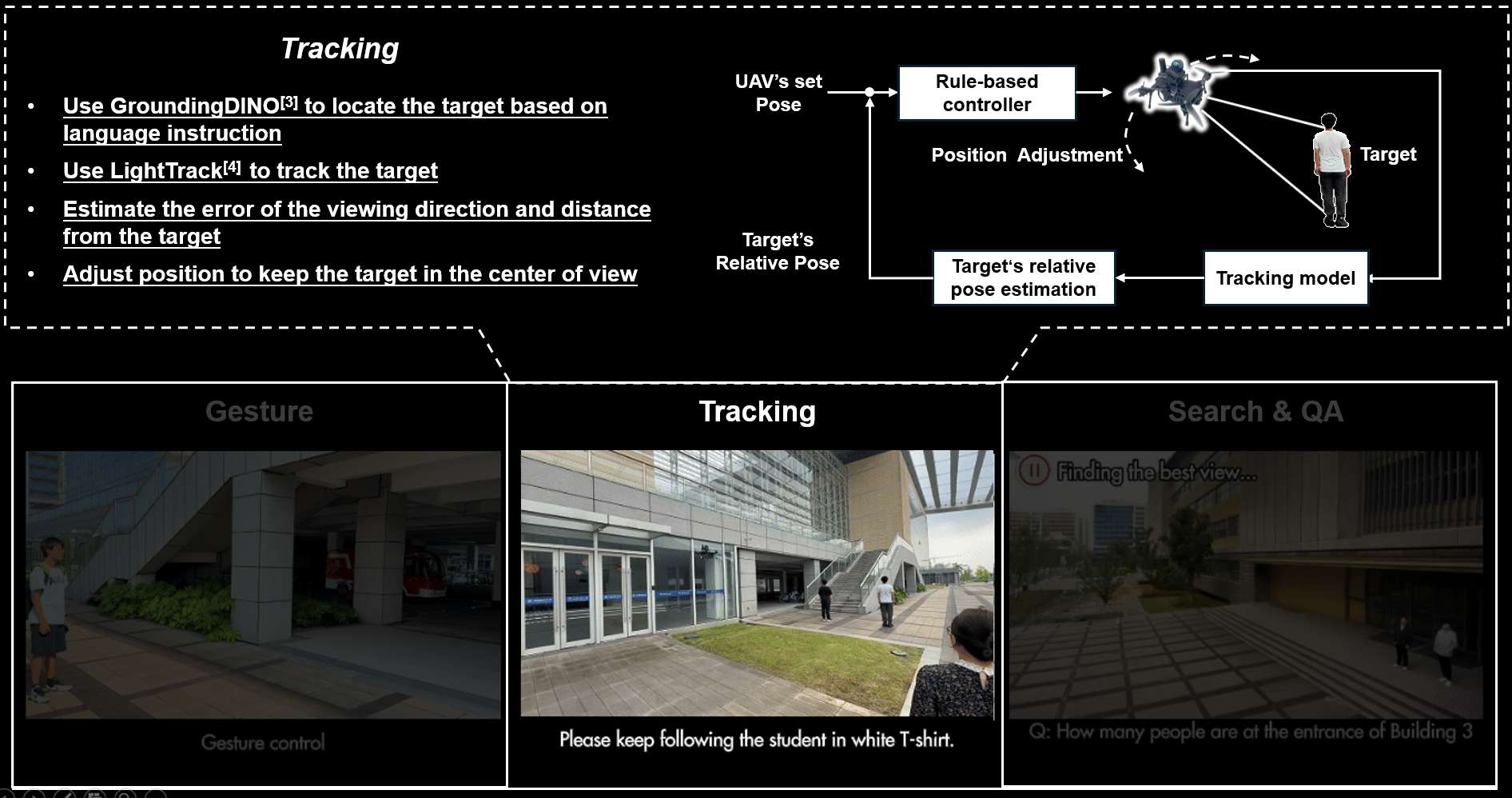

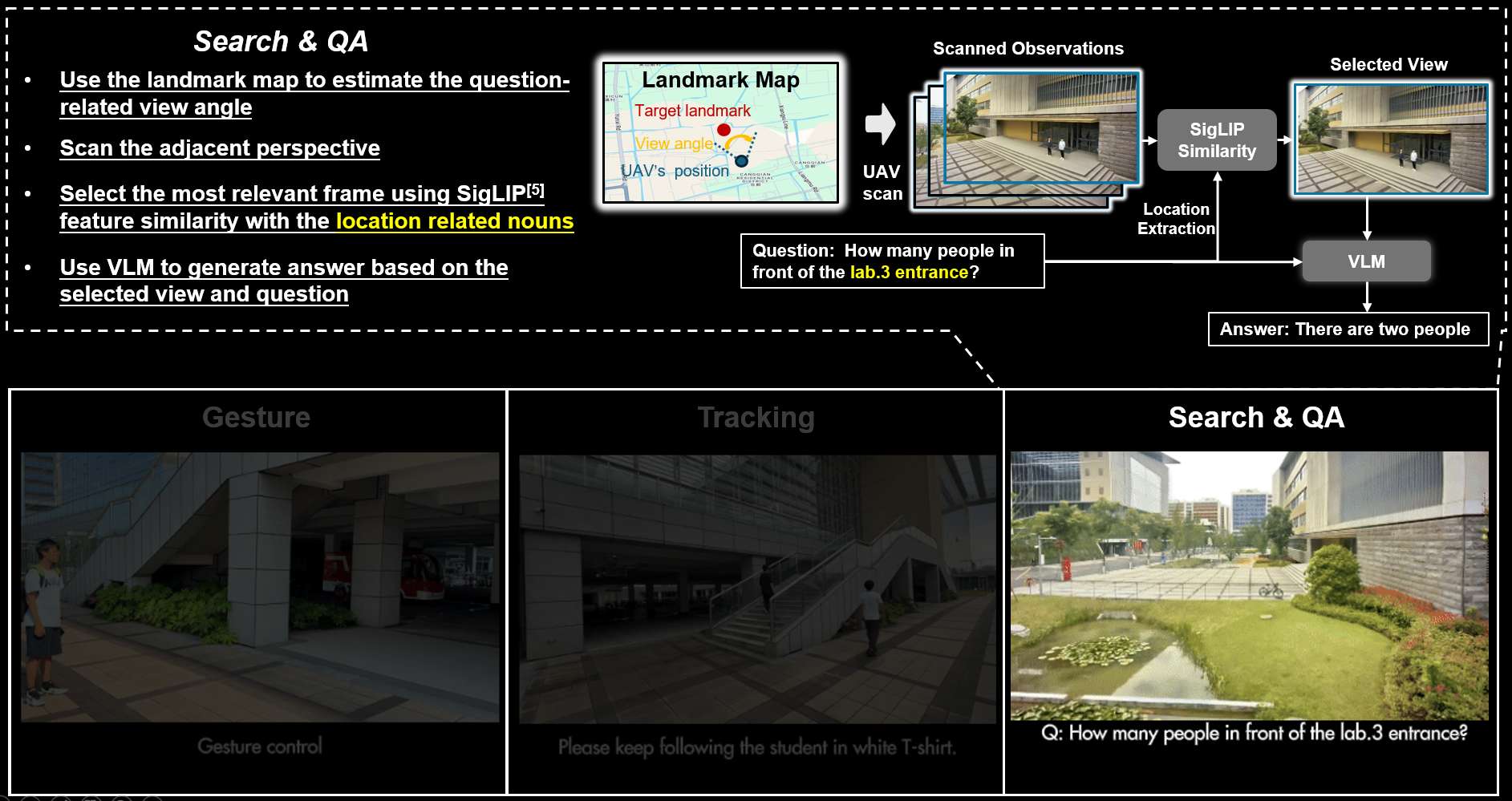

提供了多种交互功能,包括手势控制、目标跟踪、智能问答等,使用户能够通过语音和手势与无人机进行自然交互。

提出了高度可扩展的框架,支持无缝集成新功能,为开发通用的、指令驱动的智能无人机代理奠定了基础。

研究背景

无人机的优势:无人机具有高机动性、三维移动能力,能够在复杂环境中快速接近目标并执行多种任务,如探索、检查、空中成像和日常协助。然而,大多数现有的无人机仍然依赖于手动操作,智能化程度有限。

现有无人机的局限性:尽管一些无人机具备自主功能,但通常仅限于单一任务,如检测或导航,无法实现全面的场景感知、理解和决策。

AirStar的创新点:AirStar通过将无人机的机动性与LLM驱动的决策能力相结合,克服了现有无人机的局限性,实现了全面的场景感知和智能决策。

系统框架

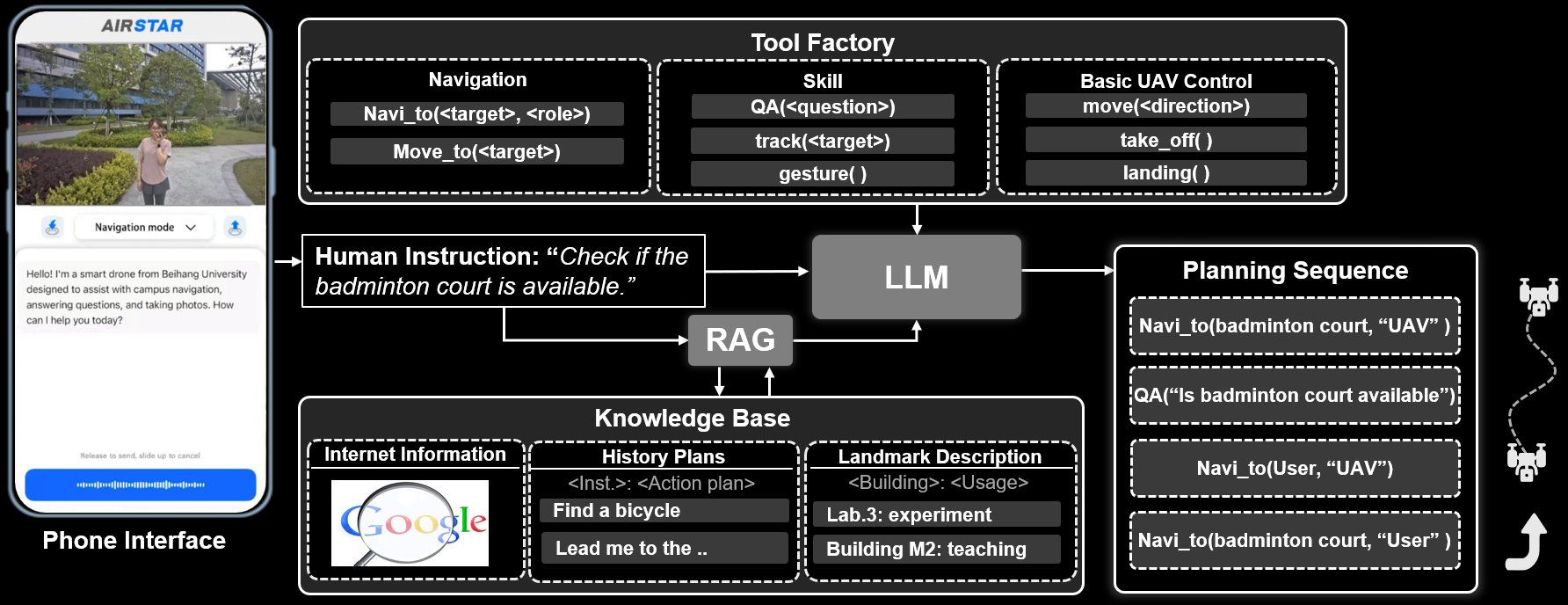

LLM任务规划器

知识库查询:在处理用户指令之前,系统会查询一个包含历史计划、导航记录、地标描述和最新互联网信息的知识库,以获取与任务相关的知识。

任务分解:LLM任务规划器通过链式推理将复杂任务分解为可执行的技能序列,并为每个技能分配相应的参数。

任务执行与重规划:无人机执行技能序列以完成用户指令。如果执行失败,任务规划器会根据执行历史和失败原因重新规划任务。

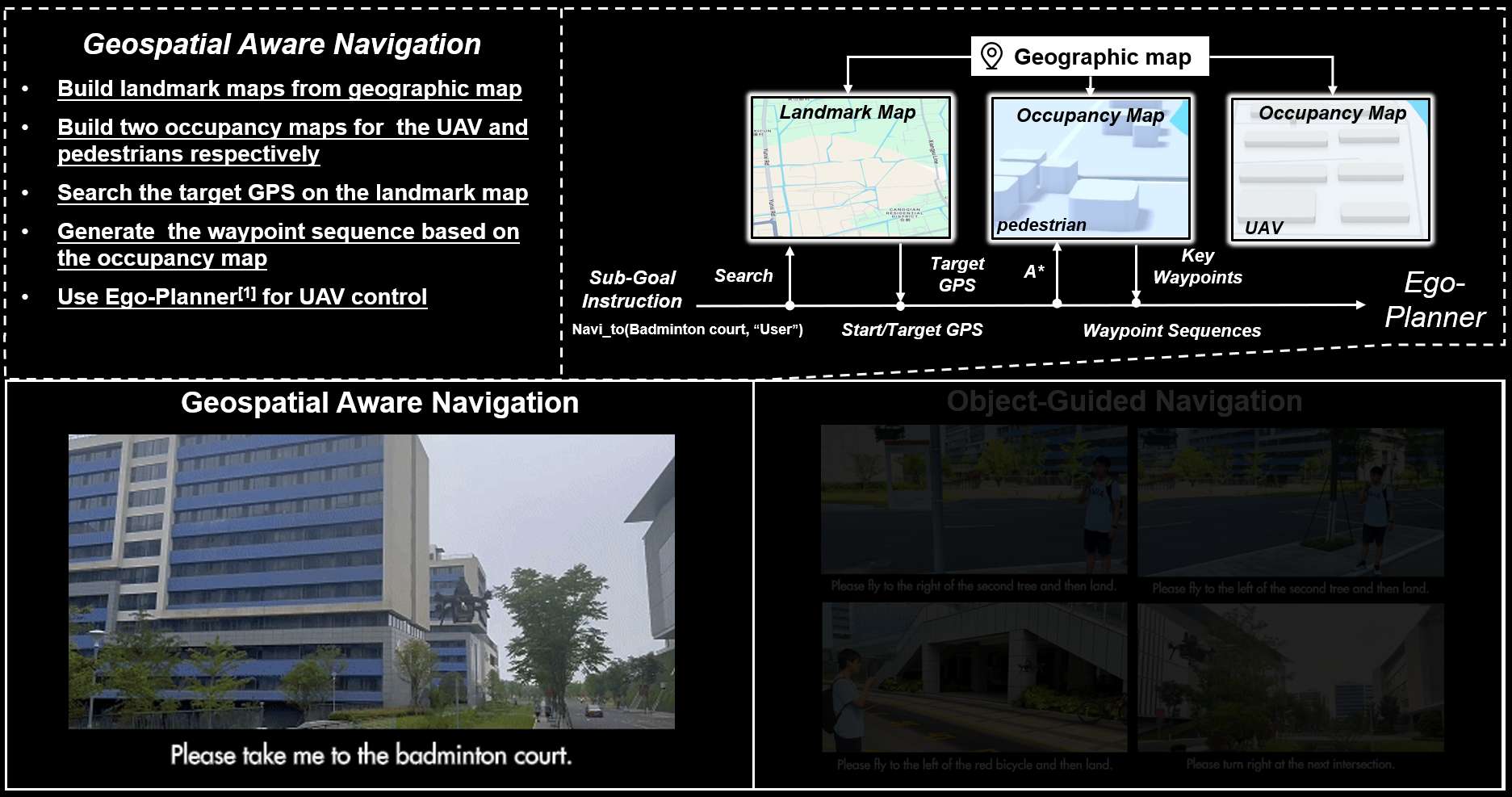

导航库

地理空间感知导航:用于长距离导航任务,基于离线地图建模和地标信息。系统通过A*算法计算关键航点,并使用Ego-Planner生成平滑可行的轨迹。

目标引导导航:用于短距离导航任务,基于视觉语言理解。系统使用Qwen2.5-VL预测目标点,并将其转换为3D世界坐标,然后通过Ego-Planner进行精确导航。

技能库

手势控制:用户可以通过手势命令(如上下左右前后)调整无人机的视角。

目标跟踪:支持通过指令或交互式点击初始化目标,并通过LightTrack进行实时目标跟踪。

搜索与问答:无人机导航到与问题相关的区域后,通过计算候选视角并评估其与地标相关名词的相似性,生成最佳视角。

系统工作流程与基础设施

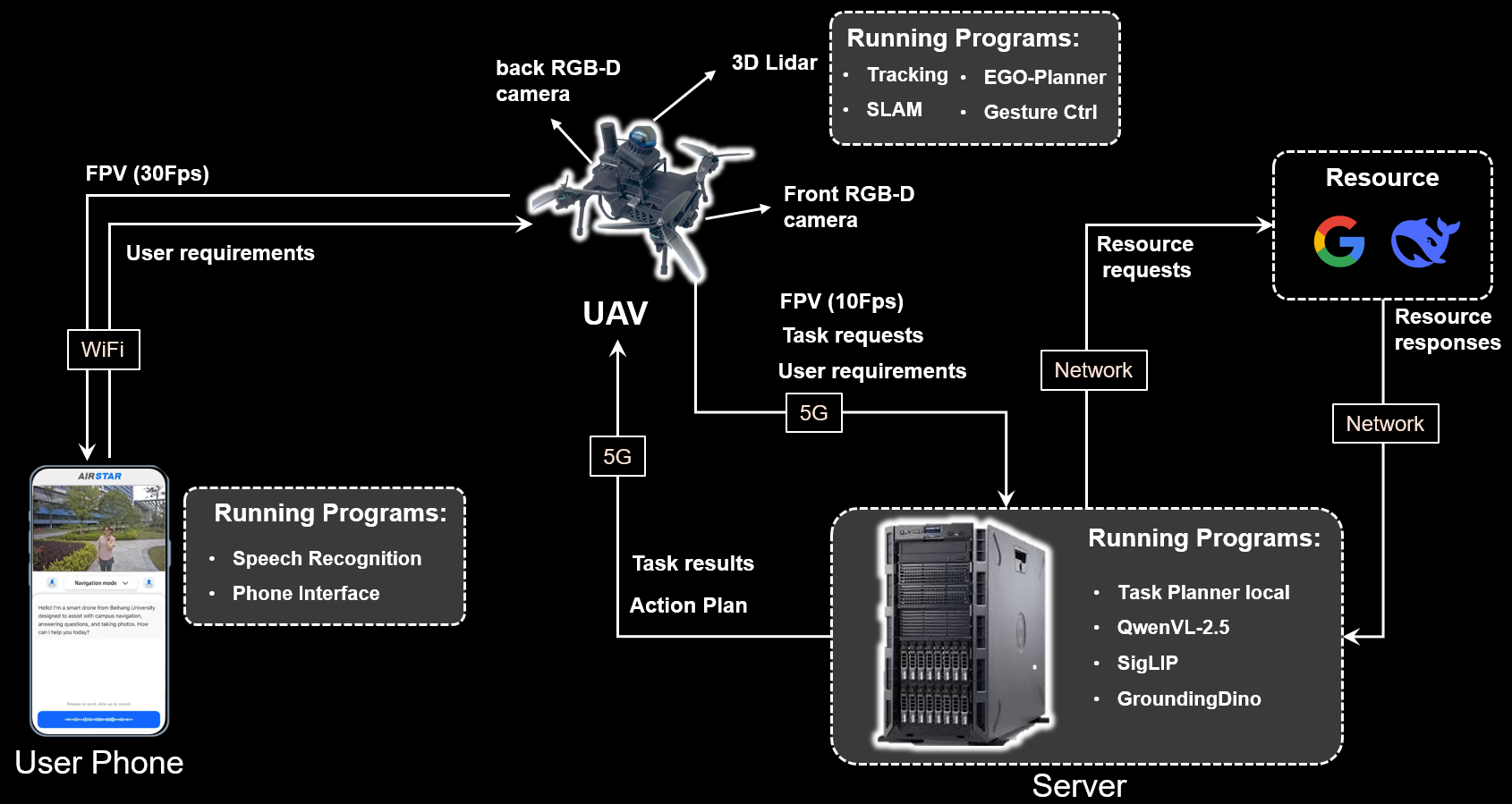

用户交互:用户可以通过智能手机应用程序与系统交互,支持文本和语音命令。

任务执行:接收到导航指令后,无人机执行由AirStar协调的一系列API调用,以完成指定任务。

通信与计算:无人机通过Wi-Fi与智能手机通信,并通过5G与基站连接。由于无人机的计算能力有限,轻量级算法(如避障、目标跟踪和手势识别)在无人机上运行,而计算密集型的LLM相关算法则托管在基站上。

总结

AirStar通过将无人机的机动性与LLM的认知能力相结合,提供了一个高度智能的空中助手平台。

它不仅支持复杂的任务规划和执行,还具备多种交互功能,能够满足用户在不同场景下的需求。

此外,其高度可扩展的框架为未来无人机系统的进一步发展提供了广阔的空间。