occworld(1):论文解读

https://arxiv.org/pdf/2311.16038v1

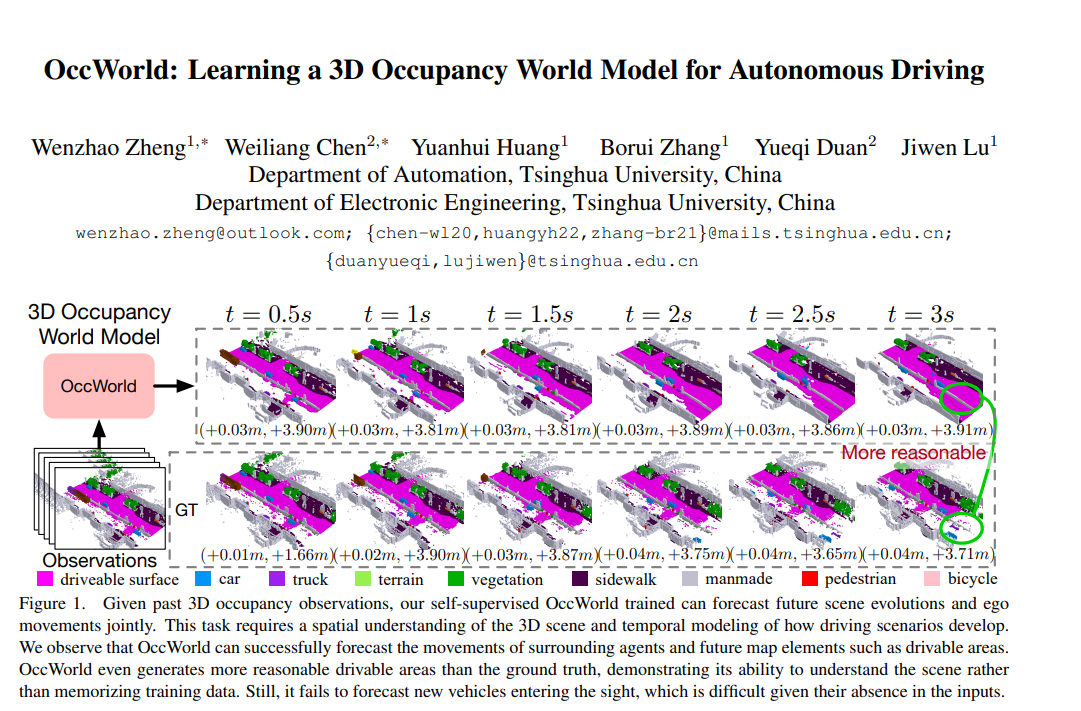

理解3D场景的演化对于自动驾驶中的决策至关重要。大多数现有方法通过预测物体包围框的运动来实现这一点,但这些方法无法捕捉更细粒度的场景信息。在本文中,我们探索了一种新的框架,即在3D Occupancy空间中学习一个世界模型OccWorld,以同时预测自车运动和周围场景的演化。我们提出基于3D occupancy而不是3D包围框和分割图来学习世界模型,原因有三点:>- 表达能力:3D occupancy可以描述更细粒度的场景3D结构;>- 效率:3D occupancy的获取成本更低(例如从稀疏LiDAR点云生成);>- 通用性:3D occupancy可以同时适配视觉和LiDAR。>为了便于建模世界演化,我们在3D occupancy上学习了一个基于重建的scene tokenizer,以获得离散的scene token来描述周围场景。随后,我们采用了一个类似GPT的时空生成式transformer,生成后续的scene token和ego token,以解码未来的occupancy和自车轨迹。在广泛使用的nuScenes基准数据集上的大量实验证明了OccWorld能够有效建模驾驶场景的演化。OccWorld还在不使用实例和地图监督的情况下,生成了具有竞争力的规划结果。代码:https://github.