梯度下降的基本原理

序言:最近再整理之前的一些笔记,感觉梯度下降之前整理的很详细也很杂乱,删了也不是,留着看着也烦,就发到这里来当个备用吧。

随机梯度下降(SGD)

求极小值:①有条件的极小值(有条件的用拉格朗日),②无条件的极小值(无条件的用梯度下降)。

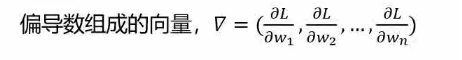

梯度是什么:

梯度有什么用:

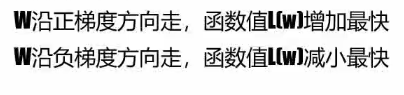

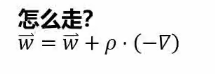

怎么走:

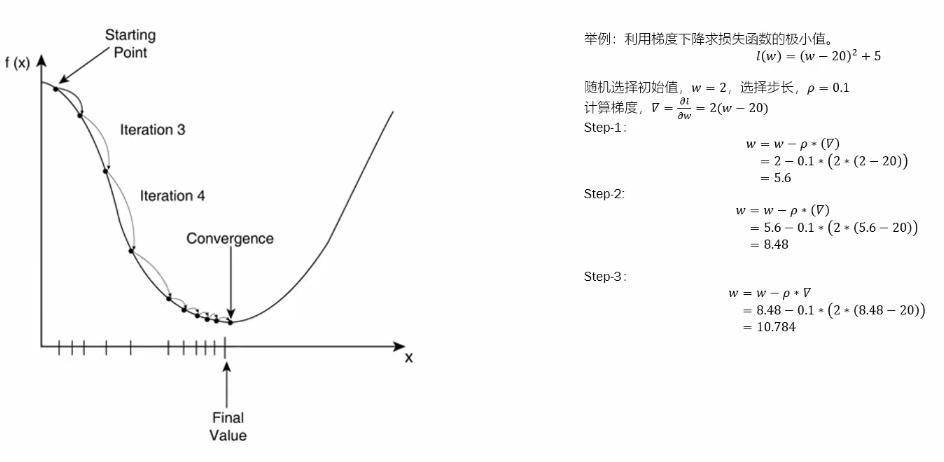

梯度下降的迭代举例:

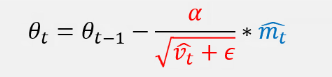

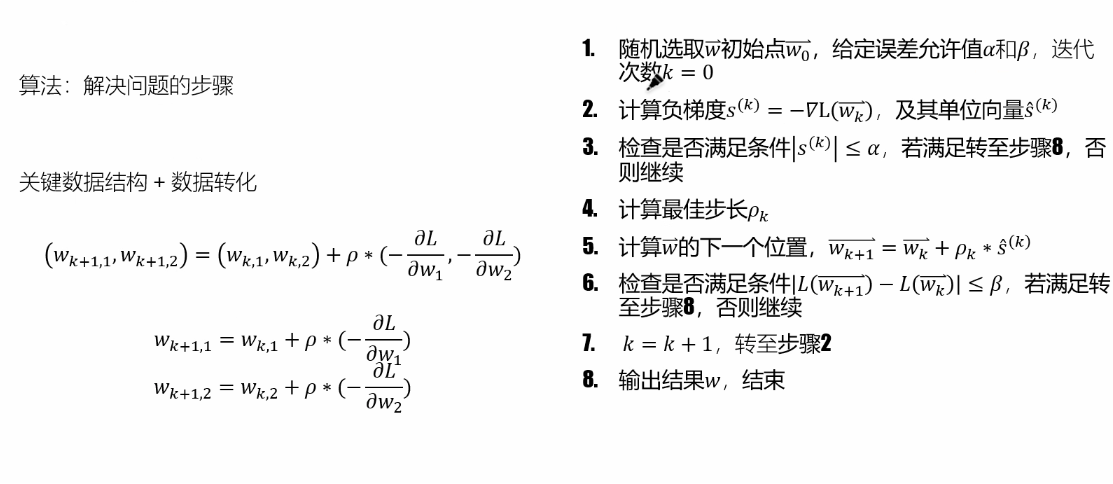

关键算法:

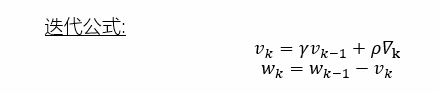

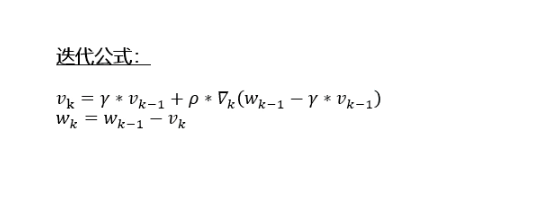

Momentum算法

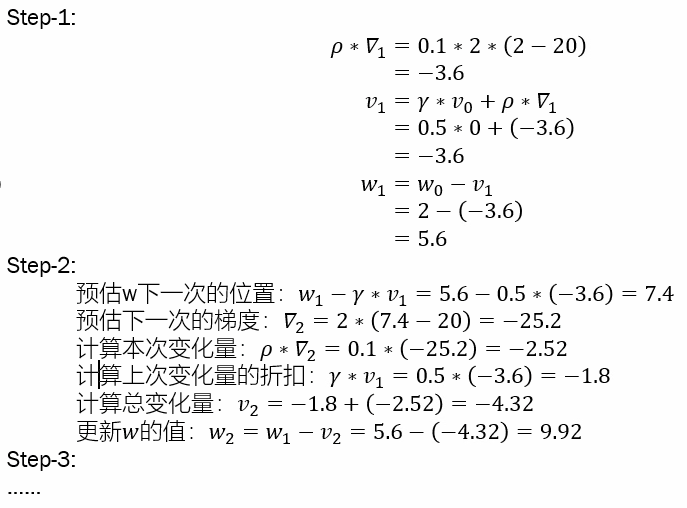

NAG算法

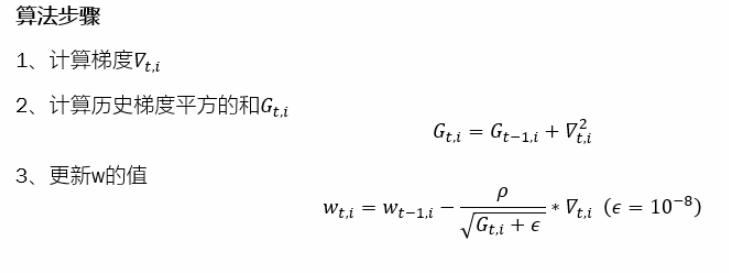

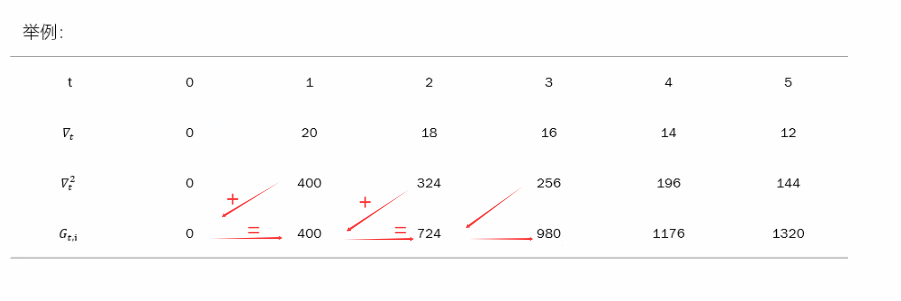

Adagrad算法

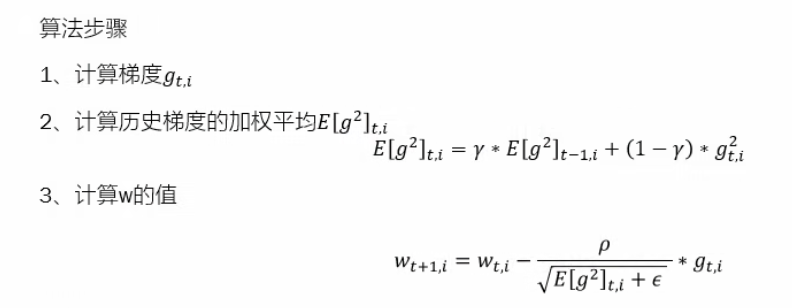

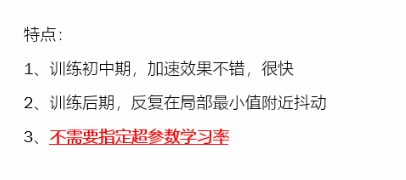

RMSprop算法

解决了Adagrad算法中学习率衰减过快的问题。

改进点:1.时间窗口机制

2.均值代替平方和

3.历史梯度均值和当前梯度加权平均

AdaDelta算法

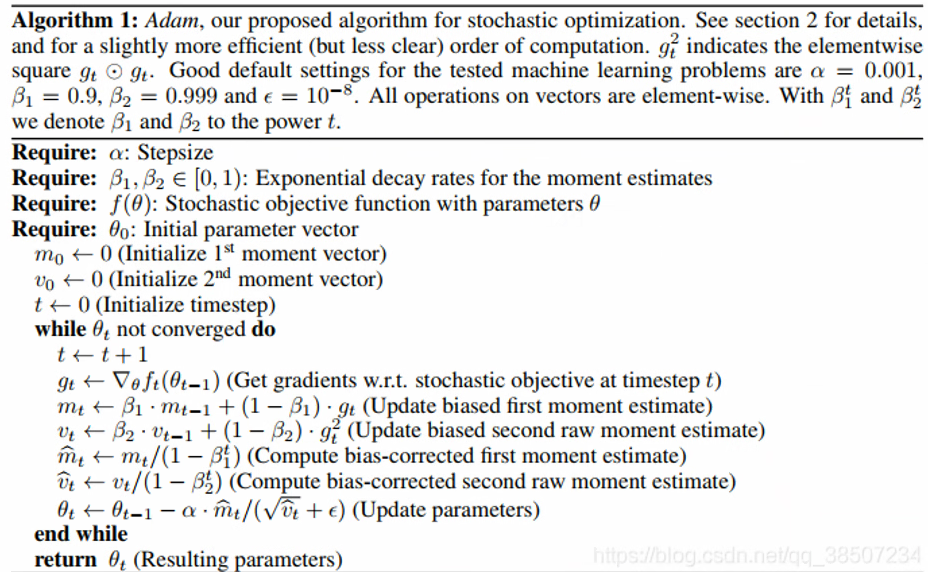

Adam算法

Adam吸收了Adagrad(自适应学习率的梯度下降算法)和动量梯度下降算法的优点既能适应稀疏梯度(即自然语言和计算机视觉问题),又能缓解梯度震荡的问题.