KU Leuven TU Berlin 推出“RobBERT”,一款荷兰索塔 BERT

荷兰语是大约24万人的第一语言,也是近5万人的第二语言,是继英语和德语之后第三大日耳曼语言。来自比利时鲁汶大学和柏林工业大学的一组研究人员最近推出了基于荷兰RoBERTa的语言模型RobBERT。

谷歌的BERT(来自Transformers的B idirectional Encoder R表示)于2019年首次推出,是一种强大而流行的语言表示模型,旨在预训练来自未标记文本的深度双向表示。研究表明,在单一语言上训练的BERT模型明显优于多语言版本。

与以前使用早期的BERT实现来训练荷兰语BERT的方法不同,新研究使用了RoBERTa,这是去年夏天由Facebook AI和华盛顿大学西雅图分校的研究人员推出的BERT的改进版本。RobBERT 经过了来自 OSCAR 语料库荷兰部分的 6 亿字总计 6 GB 文本的预训练。

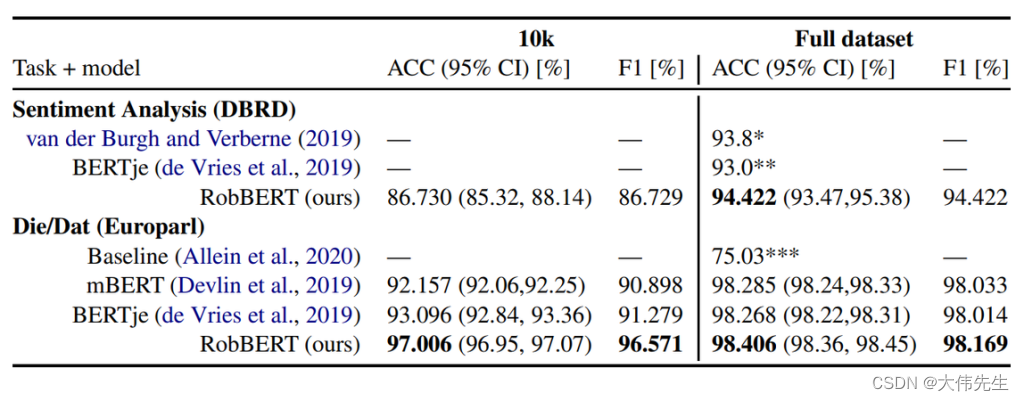

与SOTA相比,RobBERT在几个下游任务上进行了微调的结果

研究人员在不同环境中评估了RobBERT在多个下游任务上的表现,比较了其在荷兰书评数据集(DBRD)的情感分析中的表现,以及荷兰语特有的任务,将Europarl话语语料库中的“die”与“dat(that)”区分开来。结果表明,RobBERT在情感分析方面优于现有的基于荷兰BERT的模型,如BERTje,并在“Die/Dat”消歧任务上取得了最先进的结果。

本文确定了这项研究的可能改进和未来方向,例如训练类似的模型,改变训练数据格式和预训练任务,如句子顺序预测,以及将RobBERT应用于其他荷兰语任务。

预训练的RobBERT模型可以与Hugging Face的变压器和Facebook的Fairseq工具包一起使用。顺便说一下,RobBERT标志源于这样一个事实,即“rob”这个词在荷兰语中也是“印章”的意思。

论文RobBERT:基于荷兰RoBERTa的语言模型在arXiv上发表。模型和代码可在 GitHub 上找到。