Storage.AI解读:构建AI数据基础设施的开放标准

“Storage.AI的核心使命:构建跨厂商的“数据流动层”标准,实现从存储介质到GPU内存的端到端优化。”

一、AI数据瓶颈:当前生态的致命痛点

随着AI大模型训练和推理任务的爆发式增长,数据已成为整个AI系统的核心瓶颈。AI工作负载面临着前所未有的挑战:

-

极端性能需求:TB级甚至PB级训练数据集需要毫秒级的访问延迟和百万级IOPS吞吐量,但传统存储系统难以满足高频次、小文件随机读写需求(如Checkpoint保存与加载),导致GPU/TPU资源闲置率高达30%-50%。

-

资源约束:数据中心空间、电力与冷却系统的压力剧增,而内存容量与带宽的不足加剧了“内存墙”问题,迫使大量数据在DRAM、SSD、HDD之间频繁迁移,能耗与成本激增。

-

架构碎片化:不同厂商的AI存储方案(如专用文件系统、定制网络协议)缺乏统一标准,导致数据孤岛、互操作性差,难以实现跨集群、跨云的高效协作。

-

管理复杂性:AI数据管道涵盖训练、推理、持续学习等多阶段生命周期管理,涉及数据治理、版本控制、灾备等复杂流程,传统工具链效率低下。

这些挑战严重制约了AI的实际性能和普及速度,单一厂商或封闭生态无法系统性解决——行业亟需一个中立、开放的协作框架。

二、SNIA Storage.AI:应运而生的开放协作平台

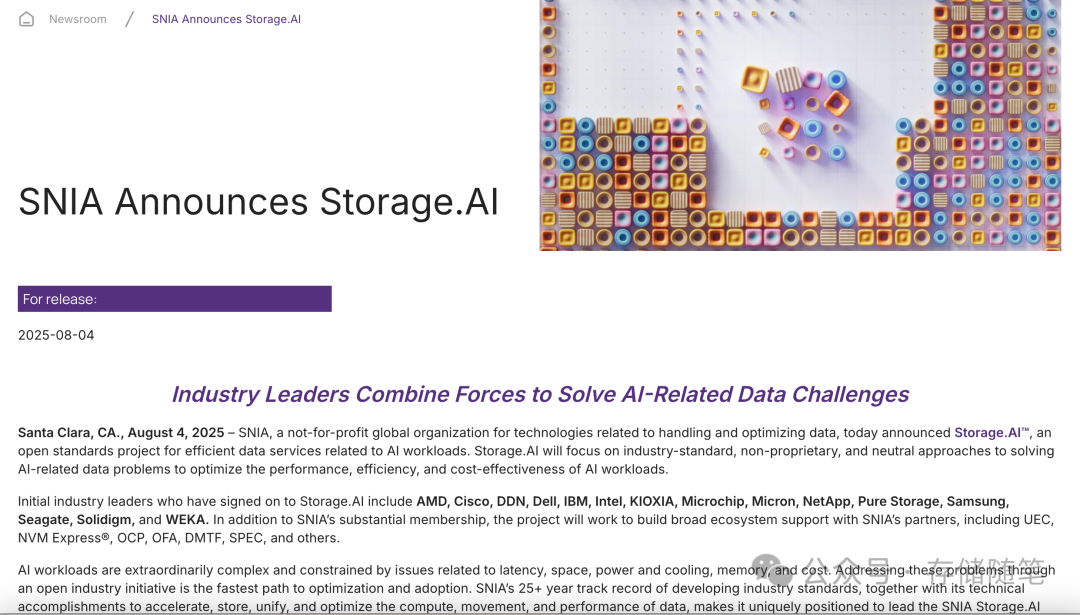

2025年8月,存储网络行业协会(SNIA)宣布启动Storage.AI开放标准项目,旨在通过中立、非专有、行业驱动的方法解决AI数据难题,优化性能、效率与成本效益。

这一举措标志着SNIA将其25年的存储标准制定经验(如NVMe、SCSI、Ceph等)延伸至AI数据领域,核心目标是:

-

统一架构语言:定义跨硬件(存储设备、控制器、网络)、软件(文件系统、编排工具)和云环境的通用接口与规范,消除碎片化壁垒。

-

优化数据全栈:从内存层次(如CXL技术整合)、SSD/HDD介质特性到网络传输协议(NVMe-oF、RDMA优化),建立端到端的性能模型与能效基准。

-

推动生态协同:联合芯片厂商(AMD、Intel)、存储供应商(Dell、Pure Storage、Samsung)、网络服务商(Cisco)、云基础设施商(DDN、WEKA)及开源社区(OCP、OFA),形成开放创新联盟。

-

解决真实痛点:聚焦AI特有的数据管理挑战(如小文件元数据瓶颈、Checkpoint快速持久化、数据主权保障),制定场景化的标准与最佳实践。

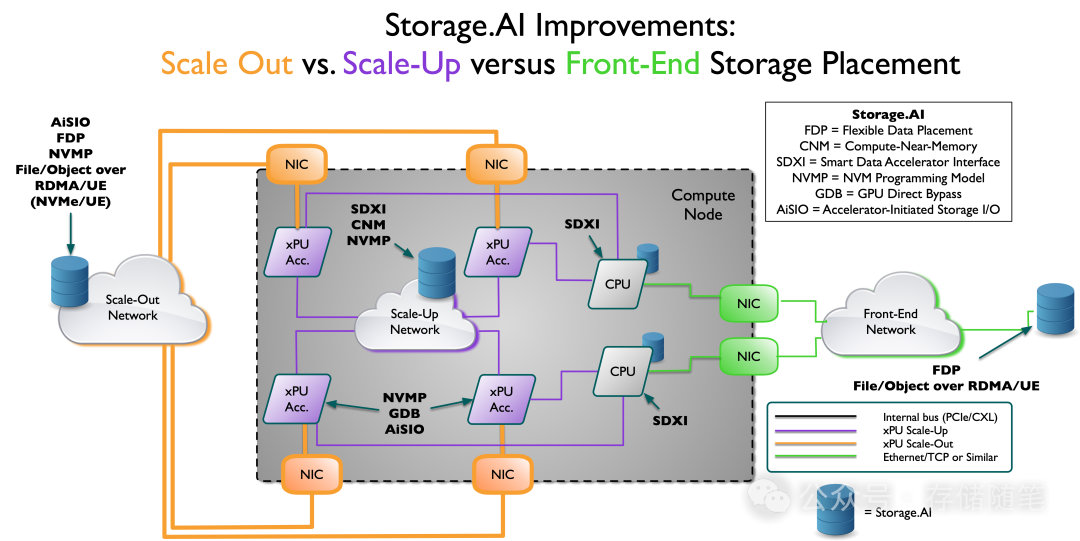

Storage.AI的本质是通过标准化接口,让存储与计算“无缝对话”,释放AI硬件的协同潜力。Storage.AI的工作围绕“优化数据流动、降低协同成本”展开,当前及未来计划聚焦四大领域:

1. 打破数据移动壁垒:从“CPU中转”到“直接协同”

-

SDXI(智能数据加速接口):构建跨CPU、GPU、DPU的中立DMA加速通道,支持内存-内存直接拷贝与数据转换(如格式压缩、加密),无需CPU介入。例如,GPU可通过SDXI直接从SSD读取数据并完成格式转换,将数据准备时间缩短40%以上。 (万字长文|下一代系统内存数据加速接口SDXI解读)