AI 大模型分类全解析:从文本到多模态的技术图谱

在当今科技飞速发展的时代,人工智能(AI)技术正以前所未有的速度重塑着各个领域的格局。为了更好地理解和应用这些复杂多样的AI大模型,对其进行系统的分类显得尤为重要。根据其能力边界、处理模态及任务类型,大模型可划分为多个细分领域,其中既有专注于单一模态的垂直型模型,也有具备跨模态交互能力的通用型模型。这些不同类型的模型在各自的领域发挥着独特的作用,相互协作,共同推动着人工智能技术的发展和应用。

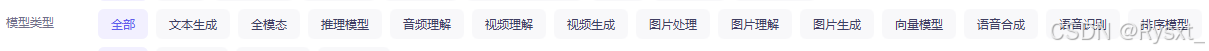

一、AI大模型分类概览表

| 分类 | 开源模型示例 | 闭源服务示例 |

|---|---|---|

| 文本生成 | LLaMA、Bloom、GPT-Neo | GPT-4、Claude |

| 全模态 | BLIP-2、Flamingo | GPT-4V、Gemini |

| 推理模型 | LLaMA(微调)、MiniGPT-4 | DeepSeek-R1 |

| 音频理解 | Whisper(OpenAI) | DeepSpeech(Mozilla) |

| 视频理解 | SlowFast、I3D | Gemini Video |

| 视频生成 | VideoGPT、CogVideo | Sora(OpenAI) |

| 图片处理 | Stable Diffusion、ControlNet | DALL·E 3 |

| 图片理解 | ResNet、YOLO | CLIP |

| 图片生成 | Stable Diffusion、DALL·E Mini | Midjourney |

| 向量模型 | FAISS、Annoy | Pinecone |

| 语音合成 | VITS、Coqui TTS | OpenAI TTS |

| 语音识别 | Whisper(OpenAI) | DeepSpeech(Mozilla) |

| 排序模型 | BERT-Rank | RankNet |

二、各分类模型详细介绍(完整保留原始内容 + OpenAI补充)

(一)文本生成模型

-

原始描述:

文本生成模型专注于根据输入信息生成自然流畅的文本内容。以 GPT 系列为代表的大语言模型(LLM)是其中的典型代表,它们能够进行创意写作、文章生成、对话回复等多种任务。例如,ChatGPT 可以根据用户的提问生成详细的回答,在内容创作领域,还能生成小说、诗歌、广告文案等。这些模型通过对大量文本数据的学习,掌握了语言的语法、语义和逻辑,从而能够生成符合人类语言习惯的内容。 -

开源模型:LLaMA(Meta)、Bloom(BigScience)、GPT-Neo(EleutherAI)

-

OpenAI:

注:文本生成需通过OpenAI API调用GPT系列(付费),开源模型需自行部署。

(二)全模态模型

-

原始描述:

全模态模型能够处理多种模态的数据,如文本、图像、音频、视频等,并在这些模态之间进行交互和融合。例如,一些模型可以将图像中的信息转化为文字描述,或者根据文字描述生成相应的图像。这类模型的发展使得人工智能能够更全面地理解和处理现实世界中的复杂信息,为智能交互、虚拟现实等领域带来了新的可能性。 -

开源模型:BLIP-2(Salesforce)、Flamingo(Meta)

-

注:可通过Hugging Face加载模型,示例:

from transformers import AutoModel, AutoTokenizer model = AutoModel.from_pretrained("Salesforce/blip-2-opt-2.7b") tokenizer = AutoTokenizer.from_pretrained("Salesforce/blip-2-opt-2.7b")

(三)推理模型

-

原始描述:

推理模型主要用于解决逻辑推理、数学计算、知识问答等任务。它们能够对输入的信息进行分析、推理和判断,得出合理的结论。在科学研究、金融分析、教育等领域,推理模型可以帮助人们快速解决复杂的问题。例如,在数学领域,一些推理模型能够求解复杂的数学方程;在法律领域,能够对法律条文进行分析和解读,辅助律师进行案件推理。 -

开源模型:LLaMA(Meta,微调版)、MiniGPT-4

-

注:LLaMA需通过Meta授权获取,MiniGPT-4需本地部署。

(四)音频理解模型

-

原始描述:

音频理解模型致力于将音频信号转化为可理解的语义信息。语音识别(ASR)技术是音频理解的重要组成部分,它能够将人类语音转换为文字。此外,音频理解模型还可以对音频中的情感、语调等信息进行分析,用于语音助手、情感分析、音频内容检索等应用场景。例如,智能音箱通过音频理解技术能够识别用户的语音指令并执行相应的操作。 -

开源模型:Whisper(OpenAI)

-

OpenAI支持:是

集成示例(Python):import openai openai.api_key = "your_api_key"# 使用Whisper API进行语音识别 response = openai.Audio.create(file=open("audio.wav", "rb"),model="whisper-1" ) print(response["text"])

(五)视频理解模型

-

原始描述:

视频理解模型可以对视频内容进行分析和理解,包括目标检测、行为识别、场景分类等任务。在安防监控领域,视频理解模型可以实时监测异常行为并及时报警;在智能交通领域,能够对交通流量、车辆行驶状态等进行分析,为交通管理提供支持。通过对视频内容的理解,人工智能能够更好地适应动态的现实环境。 -

开源模型:SlowFast(Facebook AI)、I3D(University of Michigan)

-

注:需通过PyTorch加载模型,示例:

import torch model = torch.hub.load('facebookresearch/pytorchvideo', 'slowfast_r50', pretrained=True)

(六)视频生成模型

-

原始描述:

视频生成模型能够根据输入的信息生成视频内容。它可以结合文本描述、图像序列等生成具有特定主题和风格的视频。在影视制作、广告宣传、游戏开发等领域,视频生成模型具有广泛的应用前景。例如,一些模型可以根据剧本自动生成简单的动画视频,为创作者节省时间和成本。 -

开源模型:VideoGPT(KAIST)、CogVideo(智谱AI)

-

注:CogVideo部分开源,需申请访问权限。

(七)图片处理模型

-

原始描述:

图片处理模型主要用于对图像进行各种处理操作,如图像增强、修复、裁剪、色彩调整等。在数字图像处理领域,这些模型可以提高图像的质量和视觉效果。例如,在老照片修复中,图片处理模型能够去除照片中的噪声、划痕,恢复照片的清晰度和色彩。此外,图片处理模型还可以用于图像的风格转换,将普通照片转换为艺术风格的图像。 -

开源模型:Stable Diffusion(Stability AI)、ControlNet

-

注:Stable Diffusion需本地部署,示例:

python scripts/txt2img.py --prompt "A cat" --plms

(八)图片理解模型

-

原始描述:

图片理解模型能够对图像中的内容进行分析和理解,识别图像中的物体、场景、人物等信息。在图像检索、智能安防、医学影像分析等领域,图片理解模型发挥着重要作用。例如,在医学领域,通过对X光、CT等医学影像的理解,辅助医生进行疾病诊断;在智能安防领域,能够识别监控图像中的人员和物体,实现目标追踪和异常报警。 -

开源模型:ResNet(Microsoft Research)、YOLO(Joseph Redmon)

-

注:YOLO需通过Ultralytics库调用:

from ultralytics import YOLO model = YOLO("yolov8n.pt") results = model.predict("image.jpg")

(九)图片生成模型

-

原始描述:

图片生成模型可以根据输入的条件生成各种风格和主题的图像。生成对抗网络(GAN)和变分自编码器(VAE)等技术在图片生成领域取得了显著的成果。例如,DALL·E 系列模型可以根据文本描述生成极具创意的图像,为艺术创作、设计等领域提供了新的工具和灵感。 -

开源模型:Stable Diffusion(Stability AI)、DALL·E Mini(Boris Dayma)

-

注:DALL·E Mini为社区项目,非官方产品。

(十)向量模型

-

原始描述:

向量模型主要用于将数据转化为向量表示,以便于进行相似性搜索、聚类分析等操作。在信息检索、推荐系统等领域,向量模型能够提高搜索和推荐的准确性。例如,在推荐系统中,通过对用户的行为数据和物品的特征数据进行向量化处理,能够更精准地为用户推荐感兴趣的内容。 -

开源模型:FAISS(Facebook AI)、Annoy(Spotify)

-

注:需自行构建向量数据库,示例:

import faiss index = faiss.IndexFlatL2(128)

(十一)语音合成(TTS)模型

-

原始描述:

语音合成模型(TTS)能够将文字转化为自然流畅的语音。与音频理解模型相对应,TTS技术使得计算机能够“说话”。在智能客服、有声读物、导航等领域,语音合成模型为用户提供了更加便捷和自然的交互方式。目前,一些先进的语音合成模型能够模拟不同人的语音特征,生成具有个性化的语音。 -

开源模型:VITS(NVIDIA)、Coqui TTS(Coqui AI)

-

OpenAI支持:是(闭源API)

集成示例(Python):import openai openai.api_key = "your_api_key"# 使用OpenAI TTS生成语音 response = openai.Audio.create(input="Hello, this is a text-to-speech demo.",model="tts-1",voice="alloy" ) with open("output.mp3", "wb") as f:f.write(response["audio"])

(十二)语音识别(ASR)模型

-

原始描述:

语音识别模型(ASR)是将人类语音转换为文本的技术。它在很多领域都有广泛应用,如智能语音助手、会议记录、语音输入法等。随着深度学习技术的发展,语音识别模型的准确率不断提高,能够适应不同的口音、语速和环境噪音。例如,在智能车载系统中,驾驶员可以通过语音指令操作导航、播放音乐等功能,大大提高了驾驶的安全性和便利性。 -

开源模型:Whisper(OpenAI)

-

OpenAI支持:是

集成示例(Python):import openai openai.api_key = "your_api_key"# 使用Whisper API进行语音识别 response = openai.Audio.create(file=open("audio.wav", "rb"),model="whisper-1" ) print(response["text"])

(十三)排序模型

-

原始描述:

排序模型主要用于对信息进行排序,以提高信息检索和推荐的效率。在搜索引擎、电子商务等领域,排序模型能够根据用户的需求和相关性对搜索结果或商品列表进行排序。例如,在搜索引擎中,通过对网页内容、用户行为等多方面因素的分析,排序模型能够将最相关、最有价值的网页排在搜索结果的前列。 -

开源模型:BERT-Rank

-

注:需通过Hugging Face加载模型:

from transformers import BertForSequenceClassification model = BertForSequenceClassification.from_pretrained("bert-base-uncased")

三、OpenAI服务调用通用模板(Python)

import openai# 初始化客户端

openai.api_key = "your_api_key"

client = openai.OpenAI(api_key=client.api_key)# 通用API调用函数

def call_openai(model, prompt, temperature=0.7):try:response = client.chat.completions.create(model=model,messages=[{"role": "user", "content": prompt}],temperature=temperature)return response.choices[0].message.contentexcept Exception as e:print(f"API Error: {str(e)}")return None# 示例:调用GPT-4生成文本

text = call_openai("gpt-4", "请解释量子力学的基本原理。")

print(text)四、总结

-

OpenAI生态定位:

- 核心优势:文本生成(GPT系列)、语音交互(Whisper/TTS)、多模态(GPT-4V)等场景。

- 限制:开源模型(如LLaMA、Whisper)需区分本地部署与闭源API调用,全模态/视频生成等前沿领域仍依赖闭源服务。

-

实践建议:

- 快速验证:优先使用OpenAI API(如文本生成、语音任务)。

- 成本控制:对敏感数据或高频调用场景,选择开源模型(如Whisper本地版、Stable Diffusion)。

- 技术整合:通过Hugging Face、LangChain等框架实现多模型协同。

附:模型调用资源链接

- OpenAI官方网页: