Ollama安装及使用Ollama部署大模型

目录

前言

一、安装

1. 官方安装

2. Docker安装

2.1 检查 Docker 状态

2.2 ollama 镜像拉取

2.3 启动容器

2.3.1 仅 CPU

2.3.2 英伟达 GPU

2.4 验证

二、模型部署

1. 模型查找

2. 进入容器

3. 下载安装模型

4. 移除大模型

三、模型路径

四、API调用

前言

Ollama 是一个开源的本地大语言模型(LLM)运行平台,目标是让你在本地像运行 ChatGPT 一样调用 LLM,而不需要依赖云服务。

一、安装

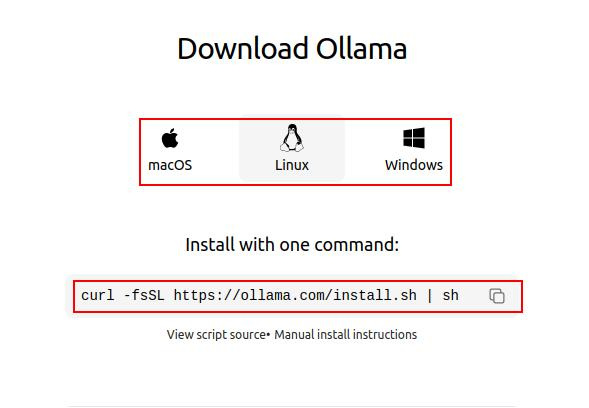

1. 官方安装

官方推荐了一种简单的安装方式,Linux系统可直接通过下述命令进行安装。

curl -fsSL https://ollama.com/install.sh | sh在下述界面中可以选择自己对应平台的命令进行安装:

2. Docker安装

Ollama 作为一款流行的本地大语言模型运行框架,其官方安装方式简洁高效。然而,对于追求更高灵活性、跨平台一致性以及希望简化管理流程的用户而言,采用 Docker 来部署 Ollama 提供了一种颇具吸引力的替代方案。

2.1 检查 Docker 状态

安装之前查看docker 是否启动

systemctl status docker# 如果没启动,执行启动命令

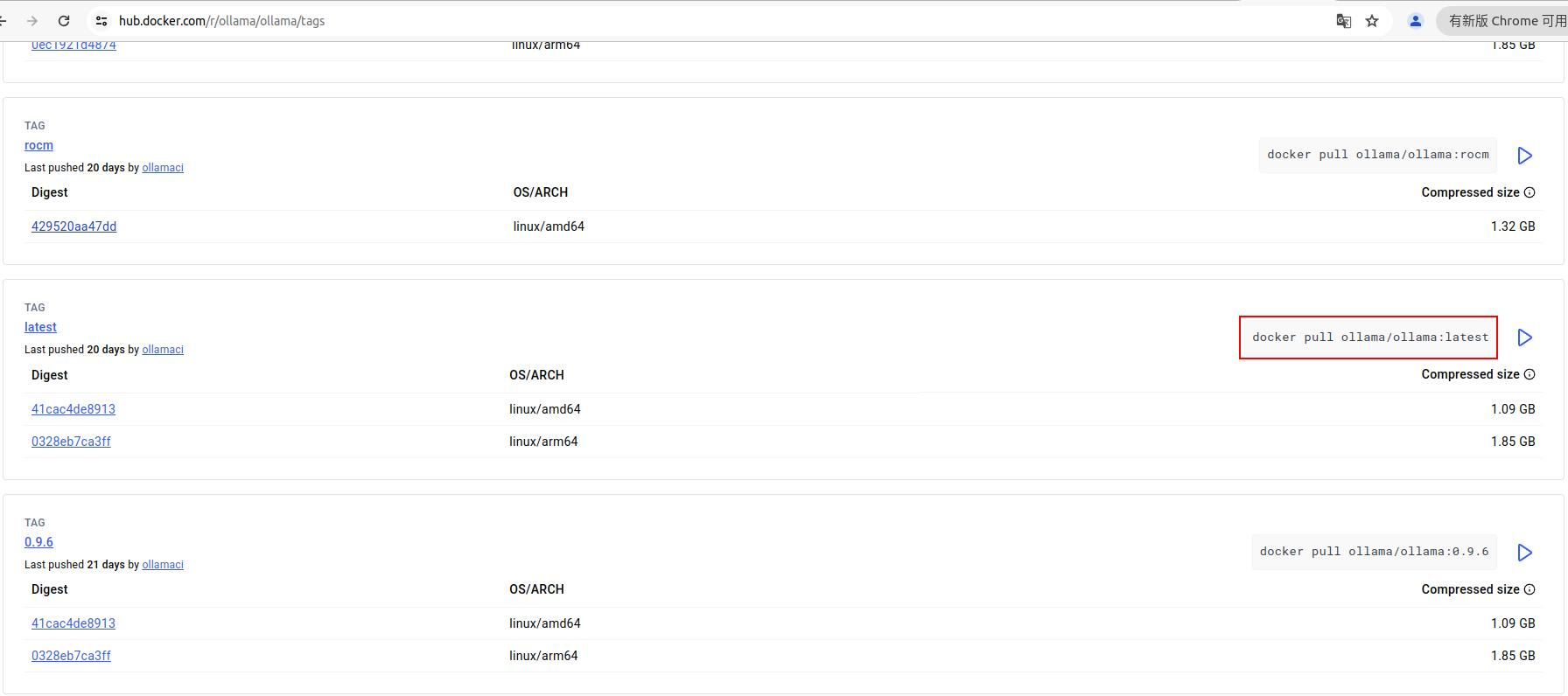

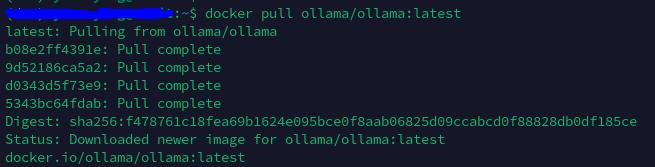

systemctl start docker2.2 ollama 镜像拉取

首先进入官方链接拉取想要的镜像到本地,一般拉取 ollama/ollama:latest 镜像。

https://hub.docker.com/r/ollama/ollama/tags

拉取完成,可以使用 docker images 命令查看我们拉取好的镜像。

2.3 启动容器

2.3.1 仅 CPU

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:latest

参数说明:

1.

docker run

- 作用:启动一个新的容器实例。

- 说明:Docker 的核心命令,用于从镜像创建并启动容器。

2.

-d(--detach)

- 作用:以 后台模式 运行容器。

- 说明:容器启动后会与当前终端分离,终端不会被阻塞,可以继续执行其他命令。

- 典型场景:适用于需要长期运行的服务(如 Web 服务器、数据库等)。

3.

-v /qjp/software/ollama:/root/.ollama(--volume)

- 作用:挂载 数据卷,实现宿主机与容器之间的目录映射。

- 参数结构:

宿主机目录:容器内目录- 说明:

- 将宿主机的

/qjp/software/ollama目录挂载到容器内的/root/.ollama目录。- 容器内的

/root/.ollama通常是 Ollama 的配置和数据存储目录,挂载后数据会持久化到宿主机,避免容器删除后数据丢失。- 典型场景:用于保存模型文件、配置文件或日志等持久化数据。

4.

-p 11434:11434(--publish)

- 作用:映射 容器端口 到 宿主机端口。

- 参数结构:

宿主机端口:容器内端口- 说明:

- 将宿主机的

11434端口映射到容器的11434端口。- 外部通过宿主机的

11434端口访问容器内的服务。- 典型场景:Ollama 的 API 或 Web 服务可能默认监听

11434端口,通过此映射允许外部访问。5.

--name ollama

- 作用:为容器指定一个 自定义名称(这里是

ollama)。- 说明:

- 如果不指定名称,Docker 会自动生成一个随机名称(如

angry_curie)。- 自定义名称便于后续通过

docker start/stop/rm等命令管理容器。- 典型场景:简化容器管理,避免依赖容器 ID。

6.

ollama/ollama:latest

- 作用:指定要使用的 Docker 镜像。

- 说明:

- 如果本地不存在该镜像,Docker 会从 Docker Hub 自动拉取。

- 未指定标签时,默认使用

latest标签。- 镜像的完整格式为

镜像名:标签(如ollama/ollama:latest)。- 典型场景:使用官方或自定义镜像启动服务。

2.3.2 英伟达 GPU

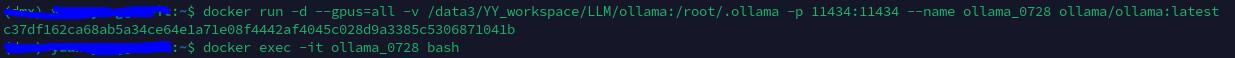

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:latest容器创建成功,id为:c37df162ca68ab5a34ce64e1a71e08f4442af4045c028d9a3385c5306871041b,同时还可以通过 docker exec -it ollama_0728 bash 命令进入容器内部。

2.4 验证

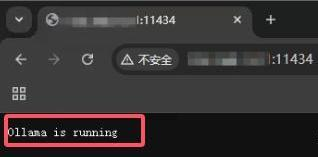

页面访问:http://xxx.xxx.xx.xx:11434/

显示 如下图,则 Ollama 安装成功,并正在运行

二、模型部署

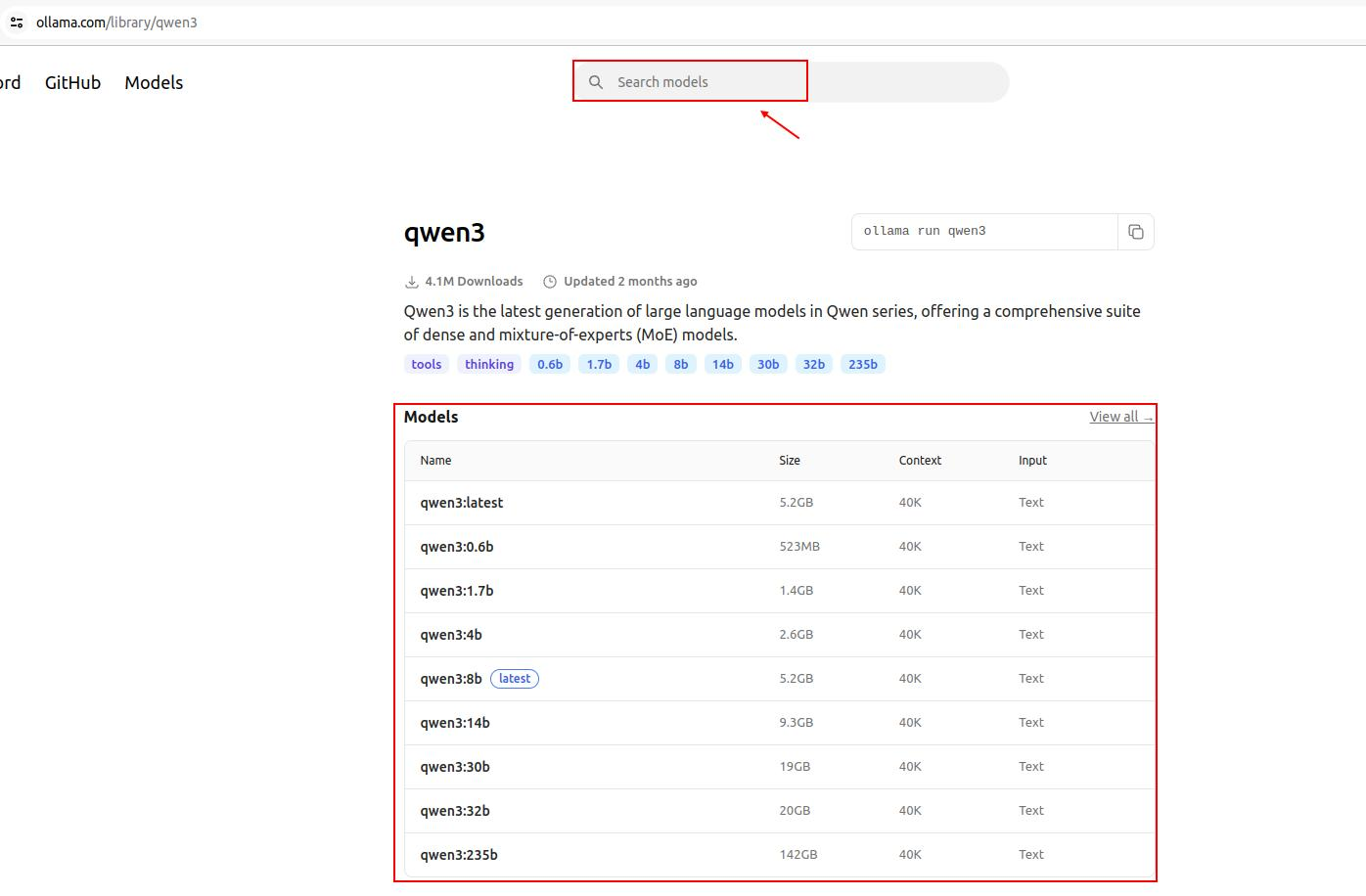

1. 模型查找

Ollama可部署的模型可以去官网查看

Ollama

点击需要安装的模型,获取对应的指令下载安装。

2. 进入容器

docker exec -it ollama bash3. 下载安装模型

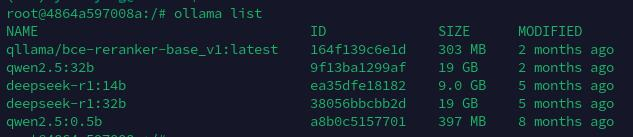

查看已安装的模型列表:

ollama list

会列出我们所有安装的模型

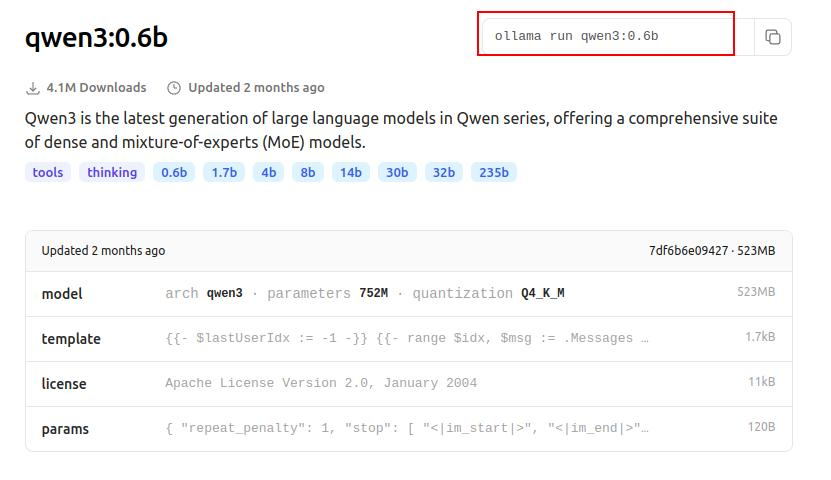

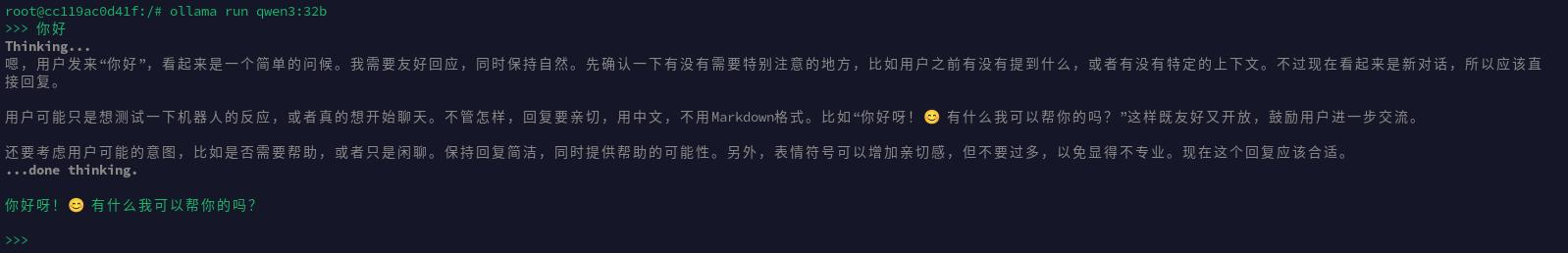

通过下述命令安装指定模型,如安装Qwen3-0.6B的模型

ollama run qwen3:0.6b

和大模型进行对话

4. 移除大模型

ollama rm qwen3:0.6b三、模型路径

在容器内,Linux中 ollama 安装的模型存放的默认路径一般为 /root/.ollama 路径下面,具体路径一般为:/root/.ollama/models/manifests/registry.ollama.ai/library

同时在启动容器的时候我们会将容器内部模型存放路径映射到我们本地,如果忘记本地的映射路径了,可以通过下述命令查看:

# 查看ollama容器的挂载信息

docker inspect ollama在输出结果中,查找 "Mounts" 字段,例如:

"Mounts": [{"Type": "volume","Name": "ollama-data","Source": "/var/lib/docker/volumes/ollama-data/_data","Destination": "/root/.ollama",...}

]

可以看到:

-

容器内的

/root/.ollama挂载到了宿主机的路径/var/lib/docker/volumes/ollama-data/_data

四、API调用

参考文档

API 参考文档 -- Ollama 中文文档|Ollama官方文档

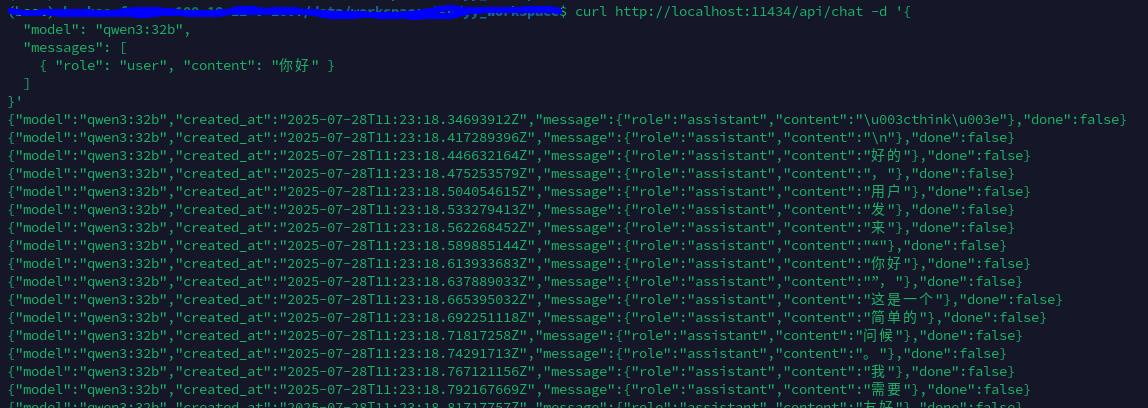

如与模型聊天

curl http://localhost:11434/api/chat -d '{"model": "qwen3:32b","messages": [{ "role": "user", "content": "你好" }]

}'