嵌入式学习-(李宏毅)机器学习(2)-day29

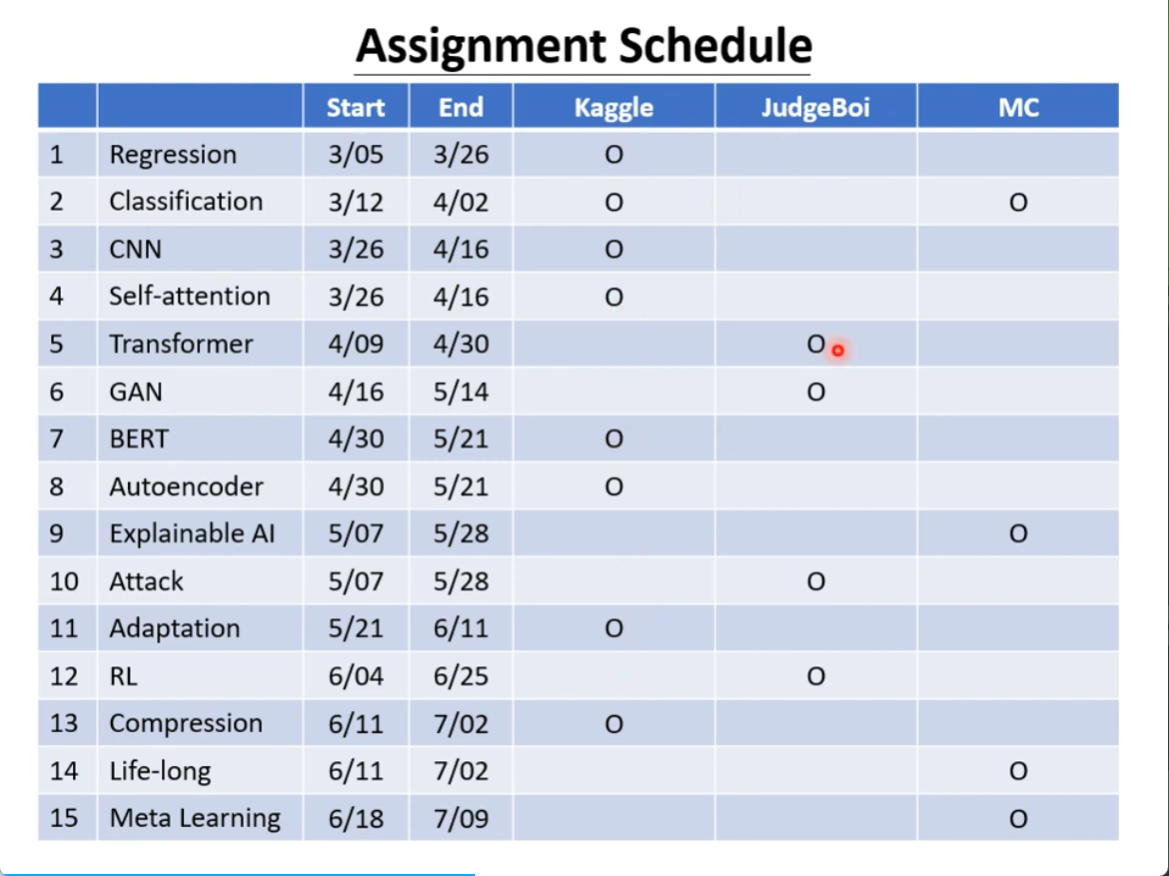

十五个作业

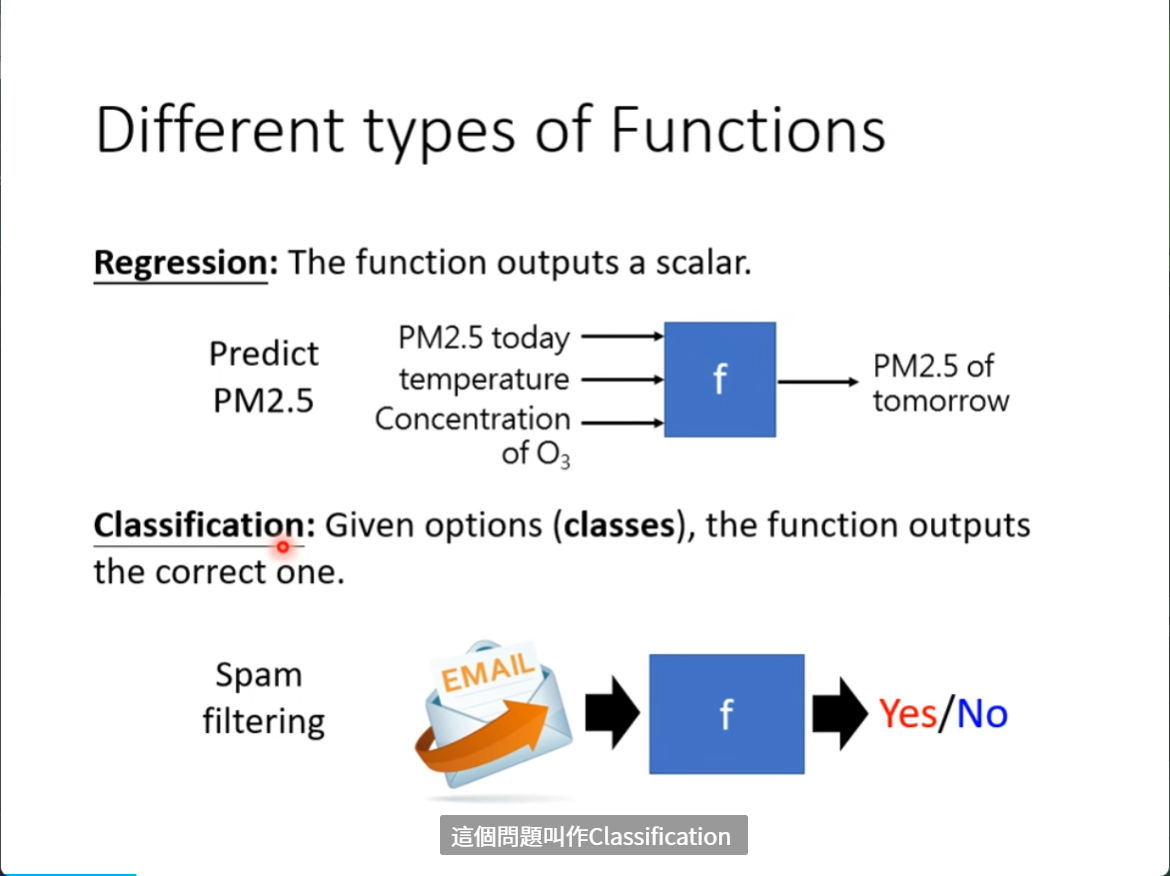

不同类型的Functions

两大类任务

一个是Regression(回归) 一个是 Classification(分类)

一个是给出一个数值,一个是从类别中选择一个

还有一类任务 Structured Learning 机器要学会创造文件

机器学习预测频道第二天的观看人数的三个步骤

1,我们要写出一个带有未知参数的函数

猜测 y = b + wX1

w 是 weight

b 是 bias

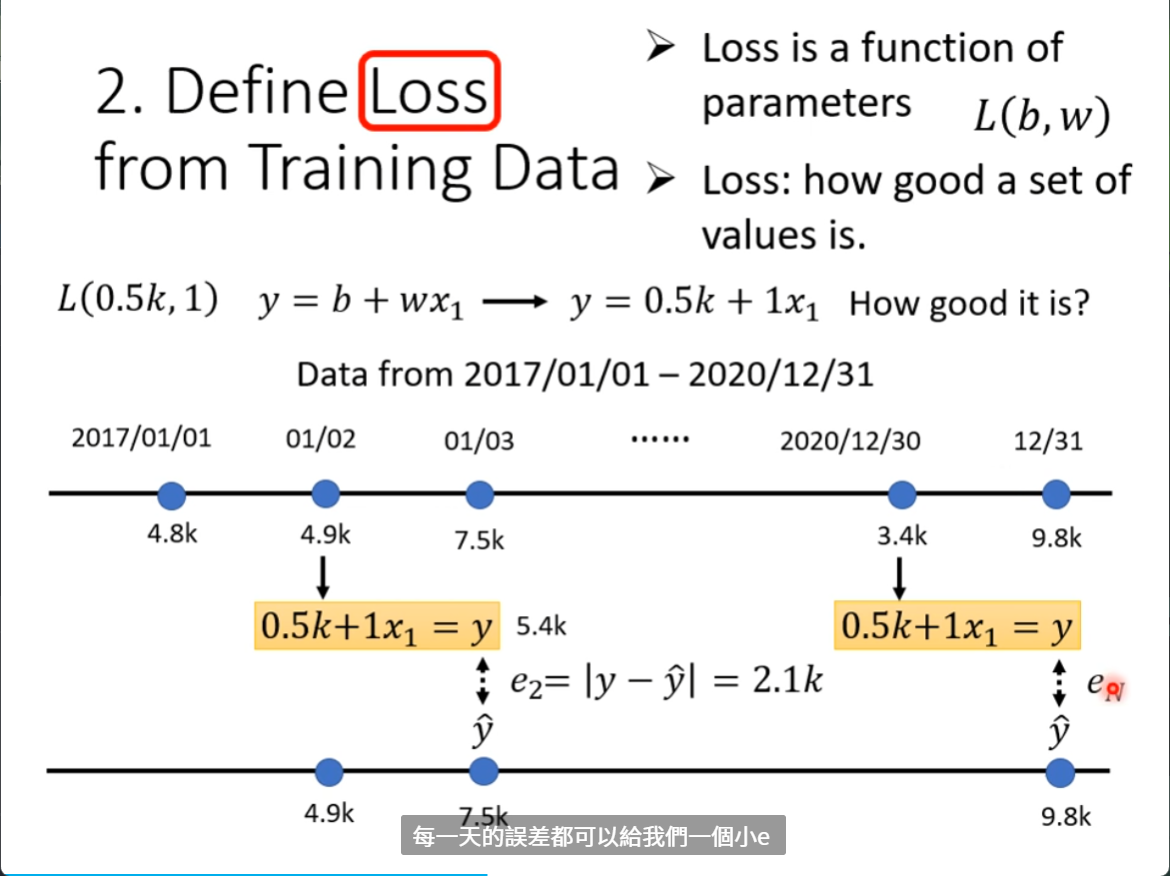

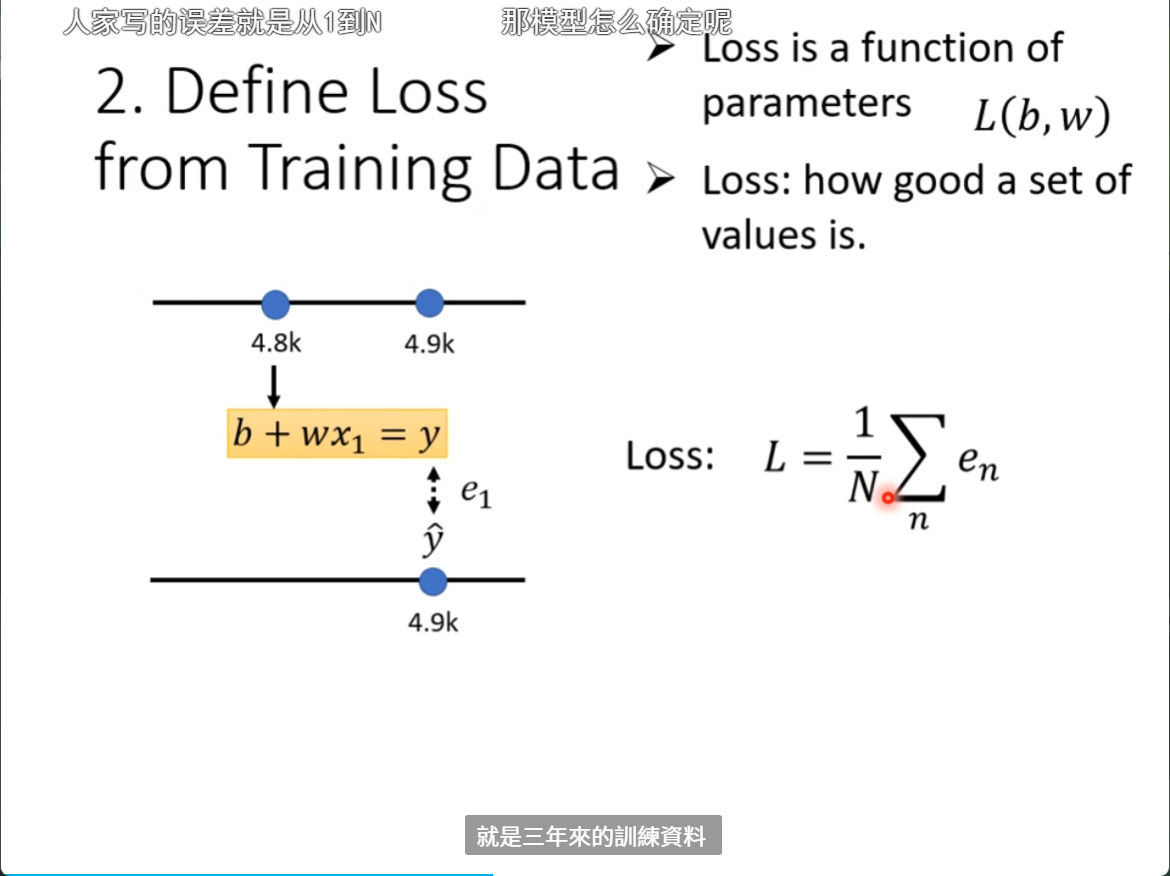

2,Define Loss from Training Data 定义一个损失函数

Loss :how good a set of values is.

预估的结果和真实的结果的差距

计算差距

真实的值叫做label

把三年每一天的误差都加起来

然后求一个均值 : L

L越大, 这一组参数越不好

L越小,这一组参数越好

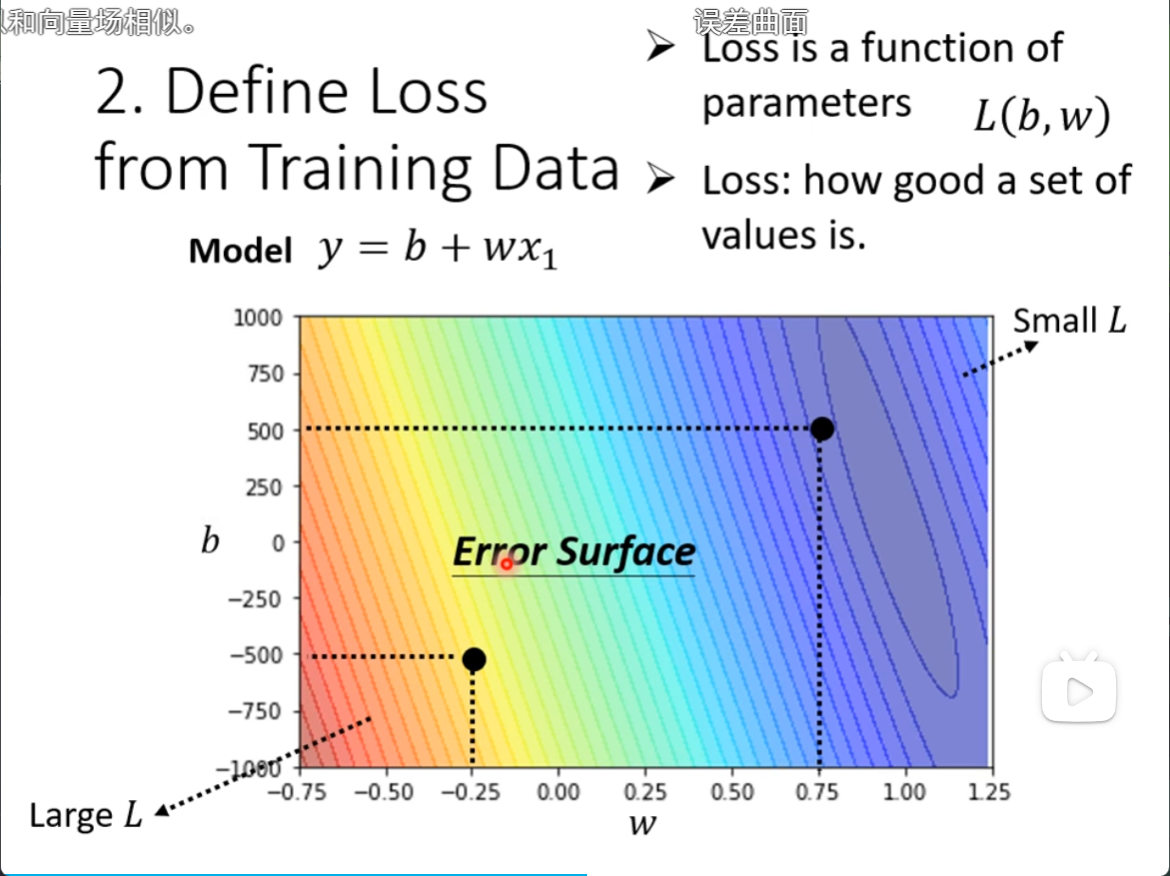

计算误差的公式有很多

MAE,MSE,交叉熵

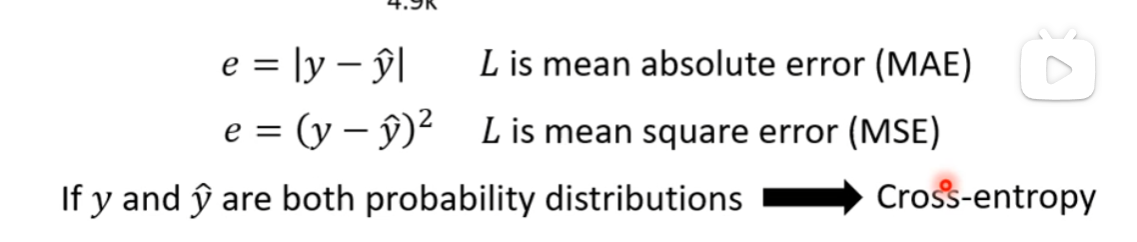

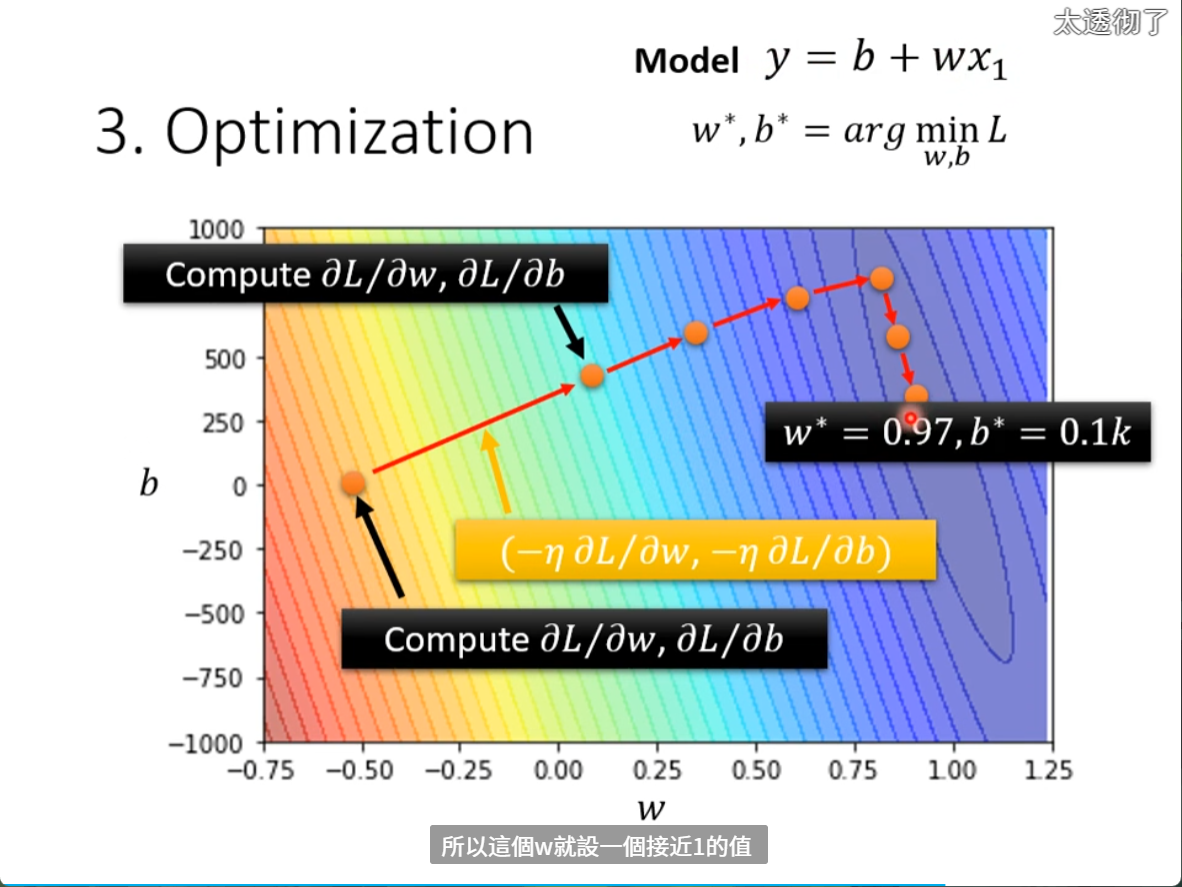

将计算的Loss画一个等高线图,越靠近蓝色就代表参数设置的越好,Loss越小

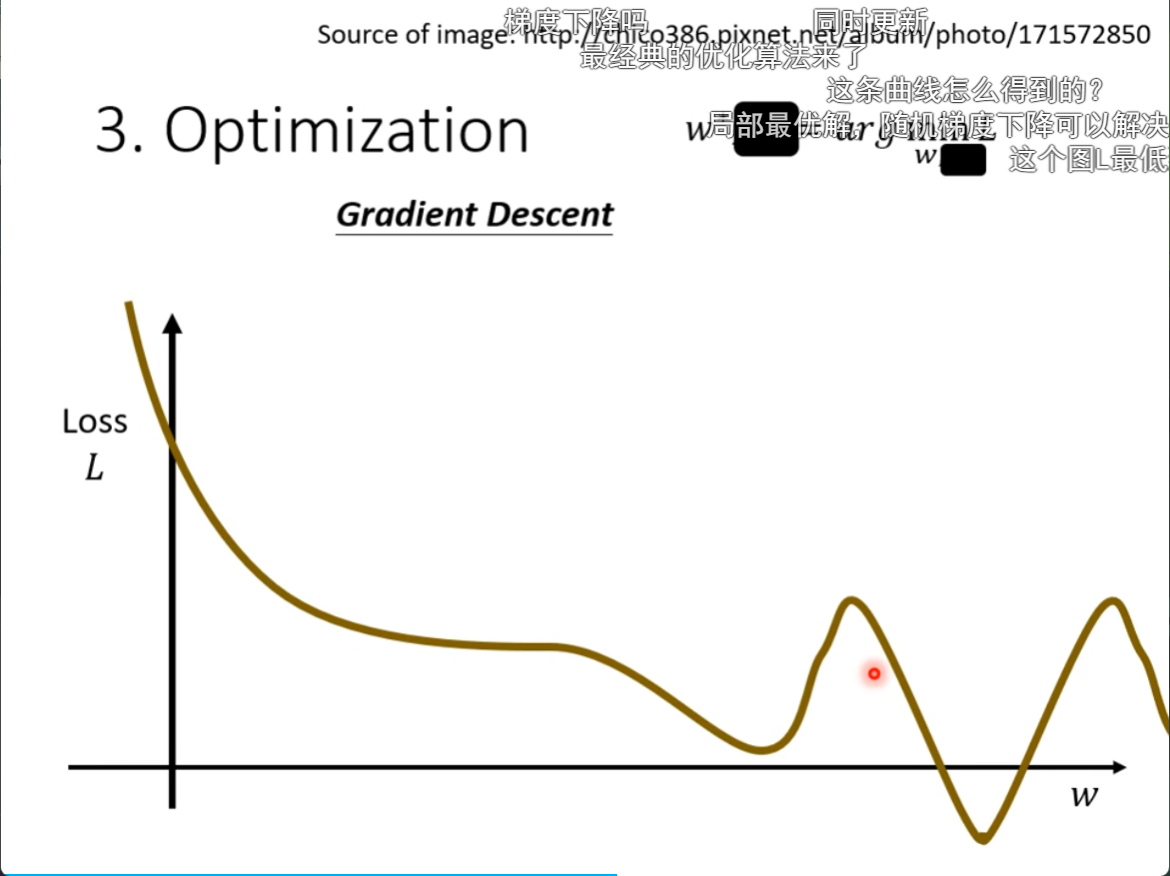

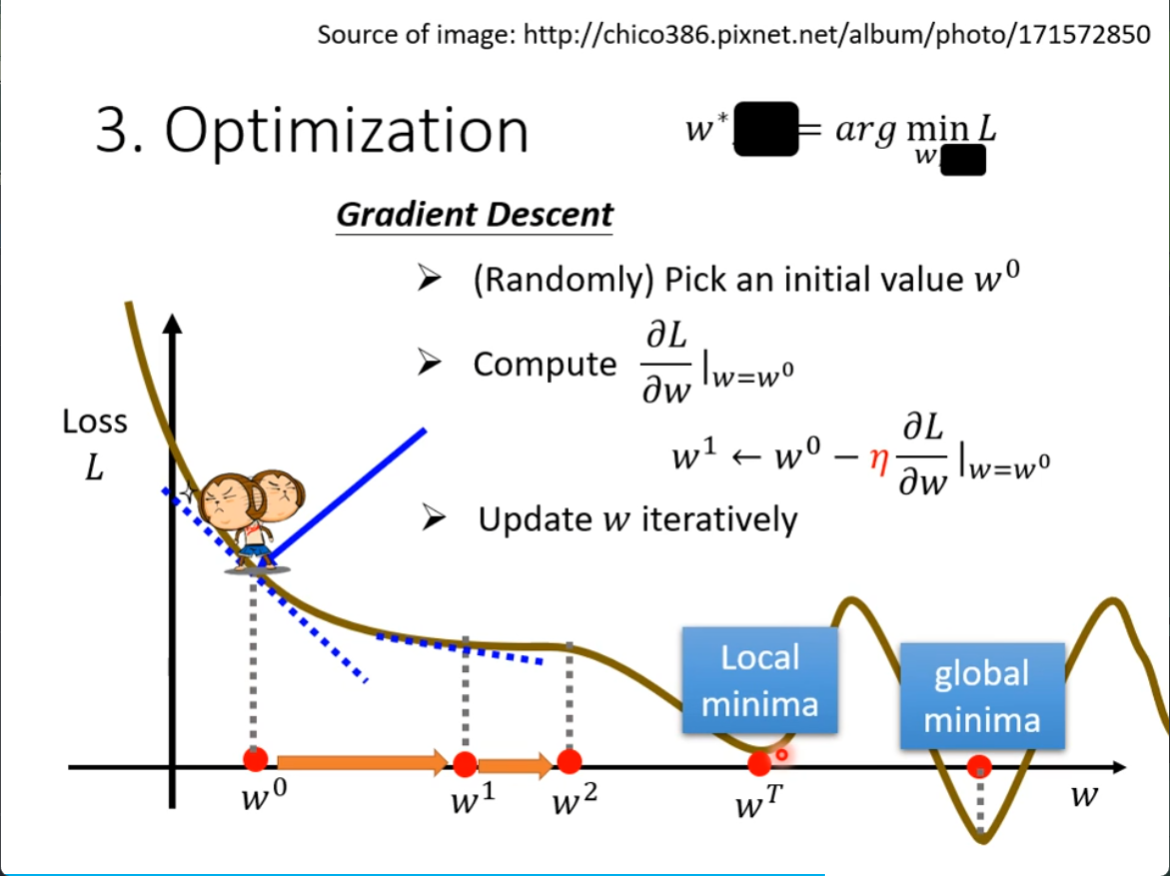

3,一个未知数 Gradient Descent 梯度下降

只有一个w的时候的图像

选择一个初始的点W0,随机的选择

计算W对Loss的微分,计算切线斜率,

自己需要自己设置的东西是 超参数 hyperparameters

向左或者向右走的步伐就是 learning rate 自己决定

什么时候停下来,算出微分是0,或者更新次数达到已设置的值

容易出现Local minnima的问题

还有梯度消失和梯度爆炸

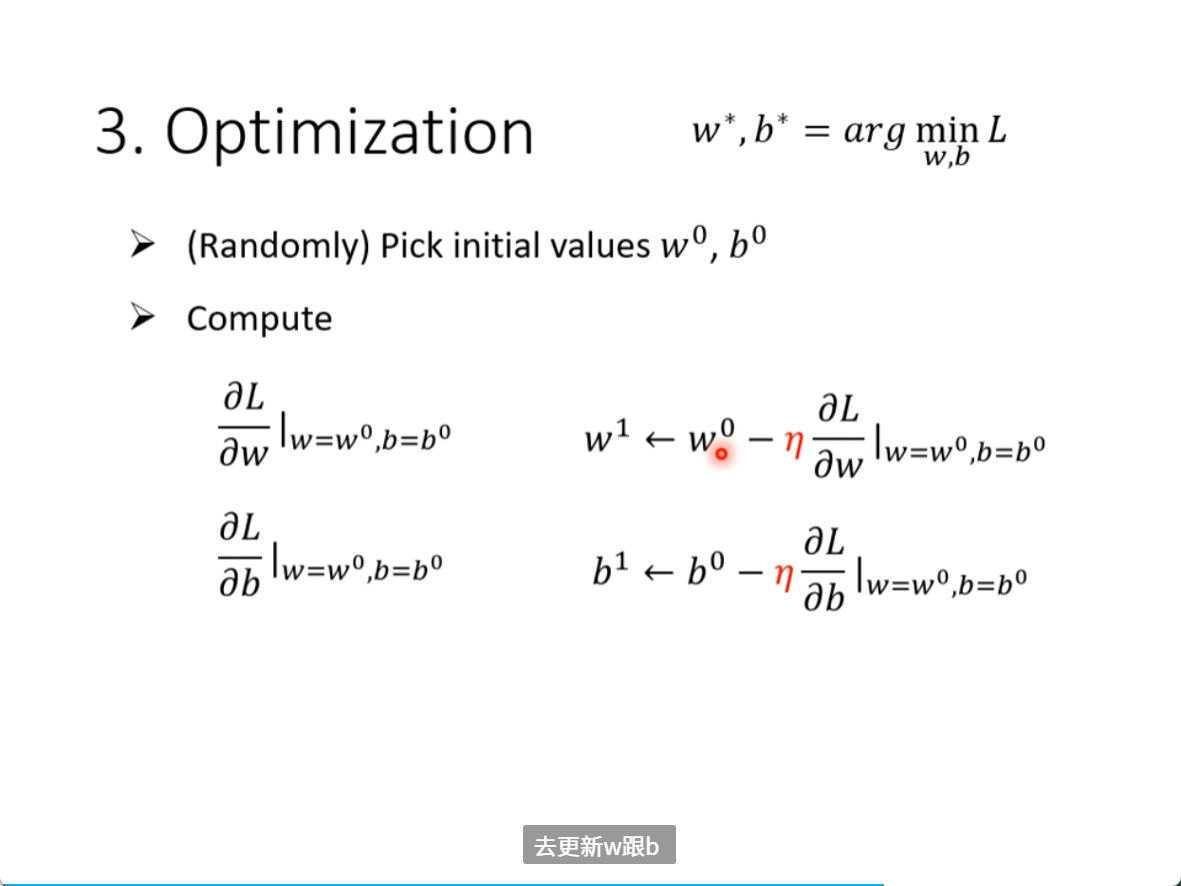

3,两个未知数 Gradient Descent 梯度下降

机器学习的三个步骤

1,写一个函数

2,定义一个loss函数,损失函数

3,optimization

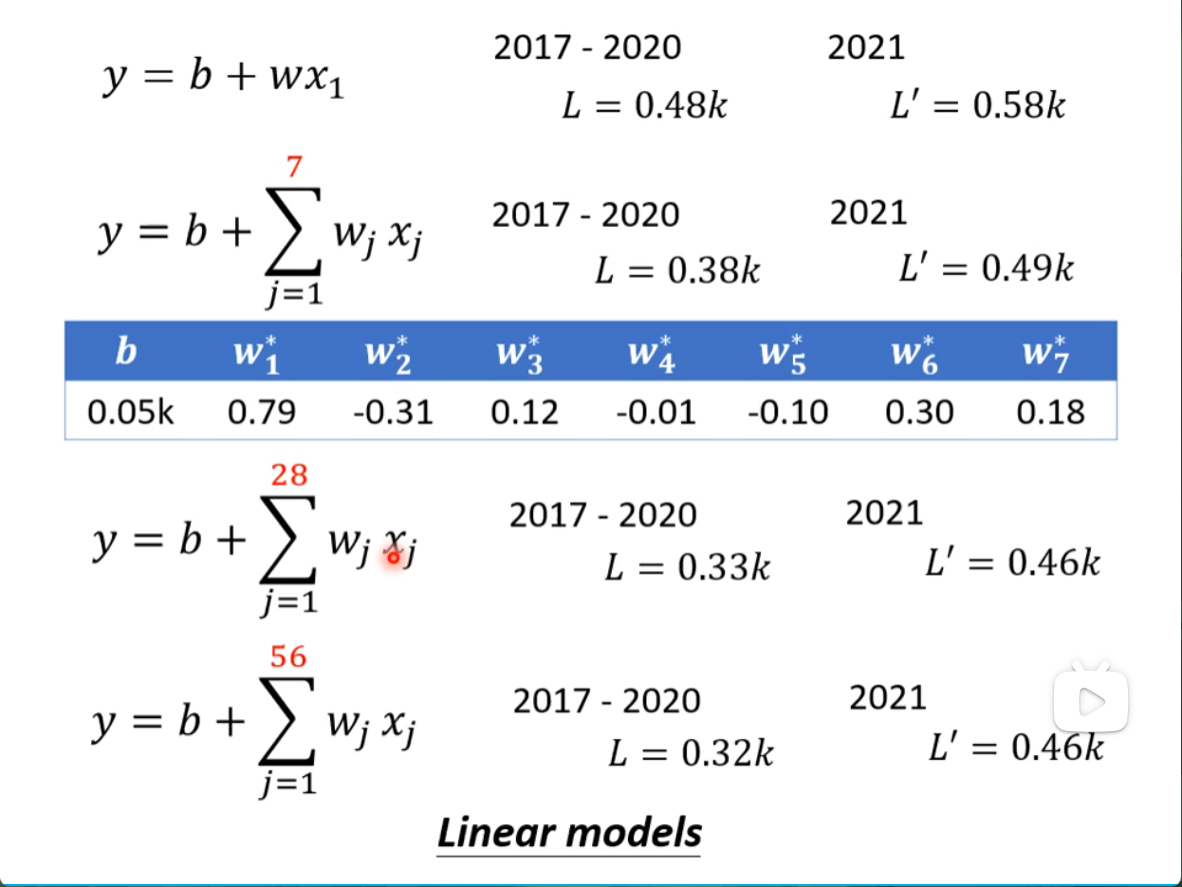

Linear models

Linear model也许太过简单了

由于model的限制叫做 Model Bias

我们需要写一个更复杂的,有位置参数的function

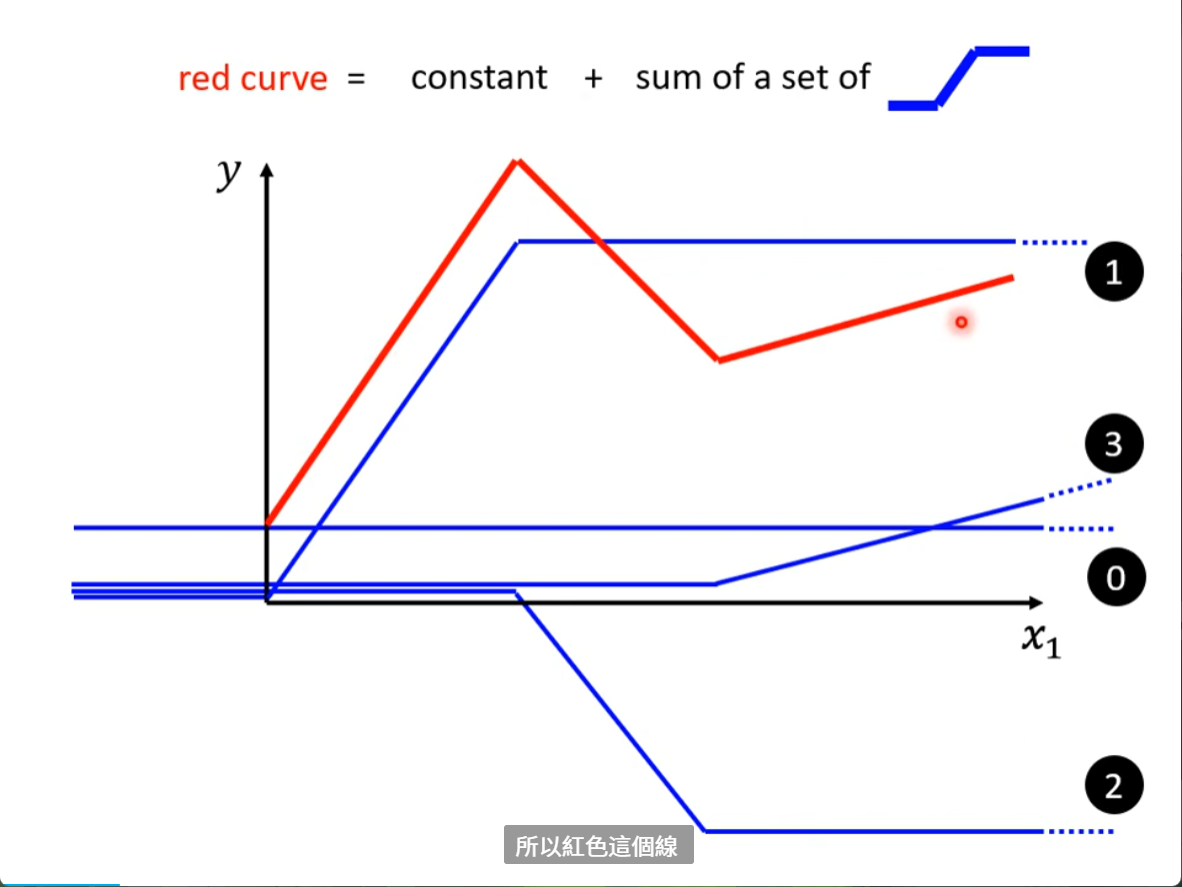

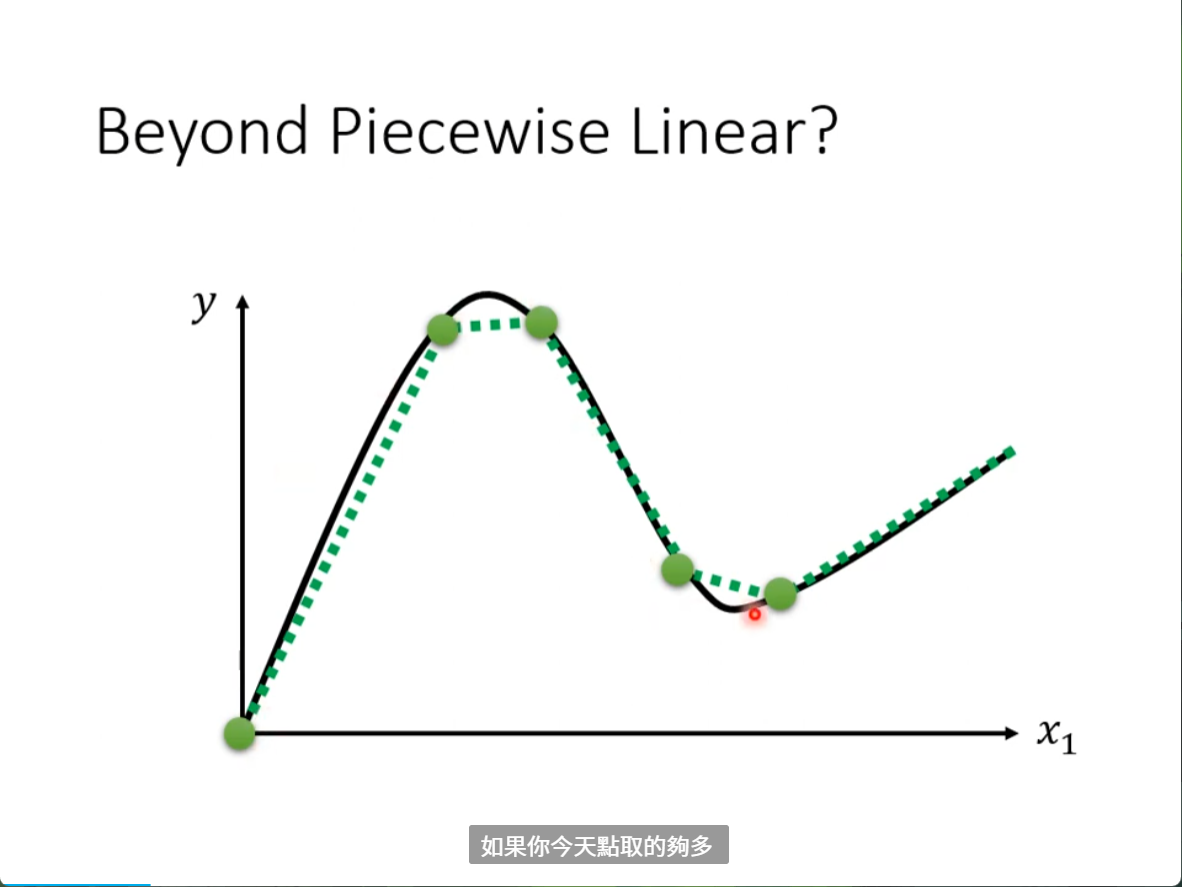

就算是曲线,也可以用piecewise linear

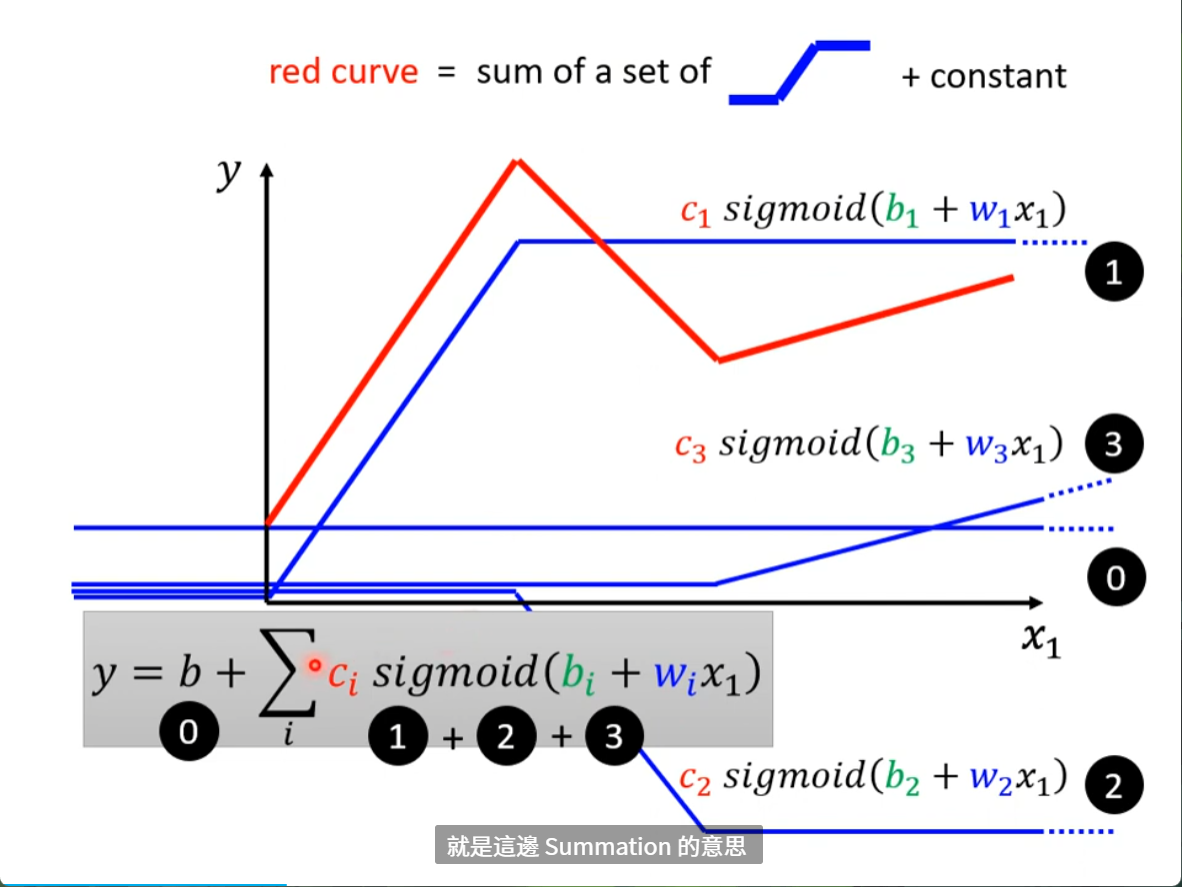

怎么把蓝色function写出来呢

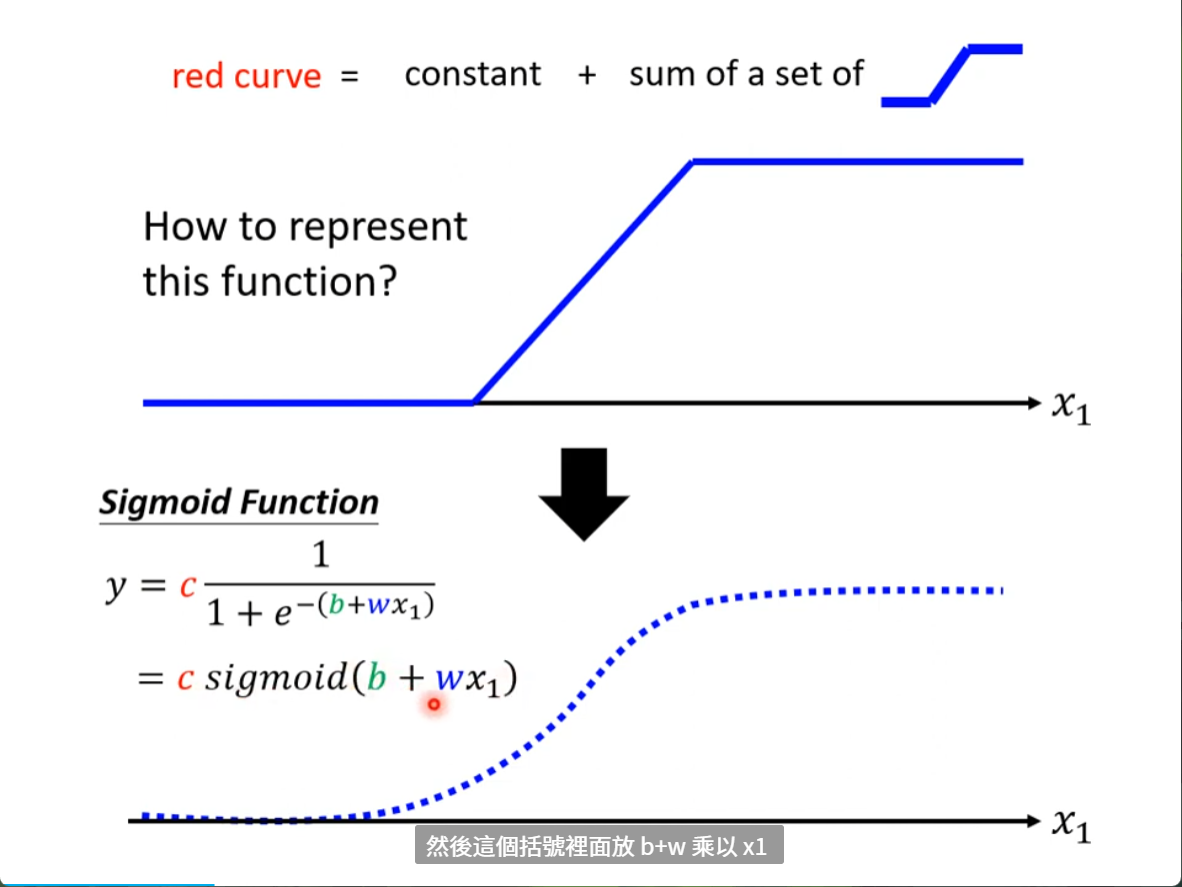

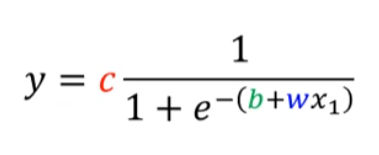

有一个就是sigmod function

有一个就是sigmod function

x -> max y -> c

x -> -max y -> 0

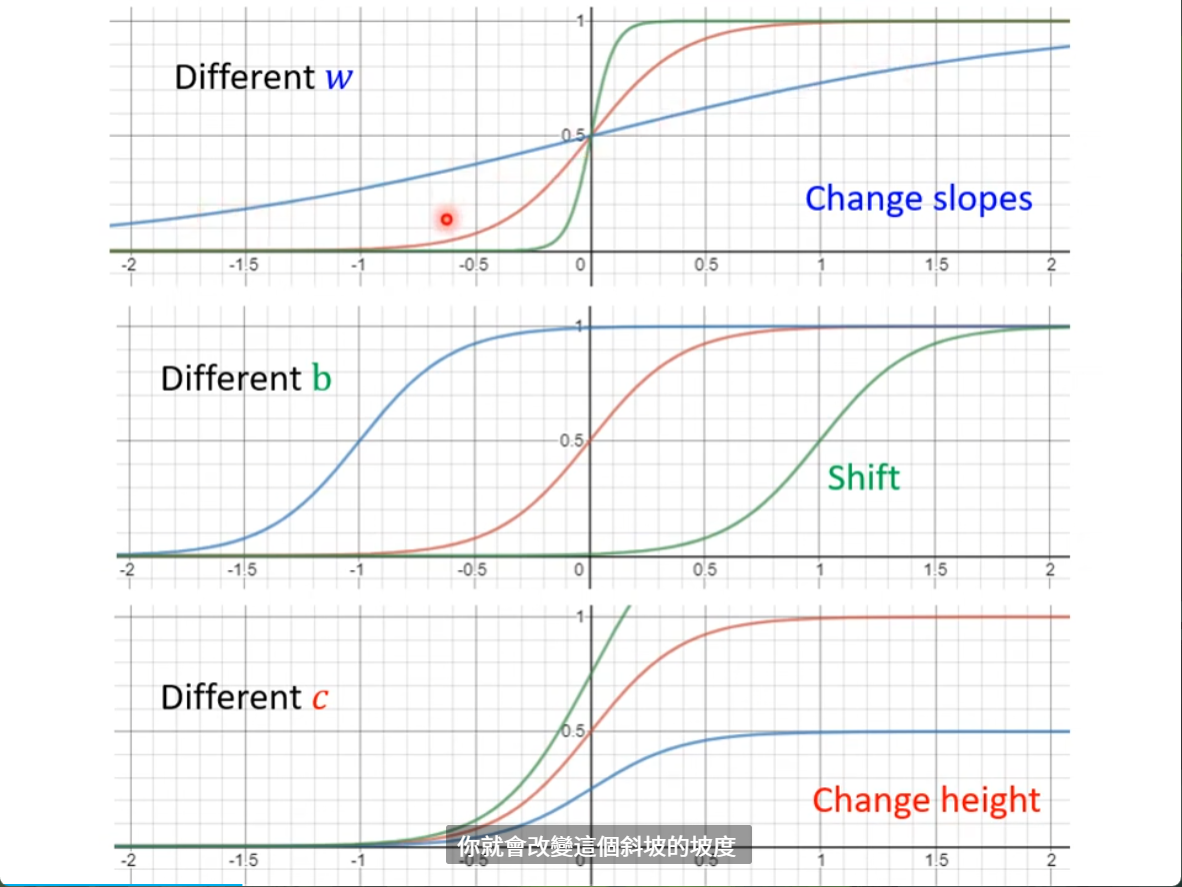

改变 w b c 的区别如图

所以红的得线可以用每个蓝色sigmod 函数加起来,再别忘了一个常数constant b,就是橙色函数