佳文赏读 || (CVPR 2025新突破) Robobrain:机器人操作从抽象到具体的统一大脑模型(A Unified Brain Model)

💡 简介:在人类眼中,一句“把杯子放到盘子上”是再自然不过的动作指令;但对机器人而言,这却是从抽象语言到精确执行的“天堑”。如何让机器人真正具备“大脑”般的理解力?CVPR 2025 的这篇重磅工作——RoboBrain,给出了一个统一且可落地的多模态大模型范式。

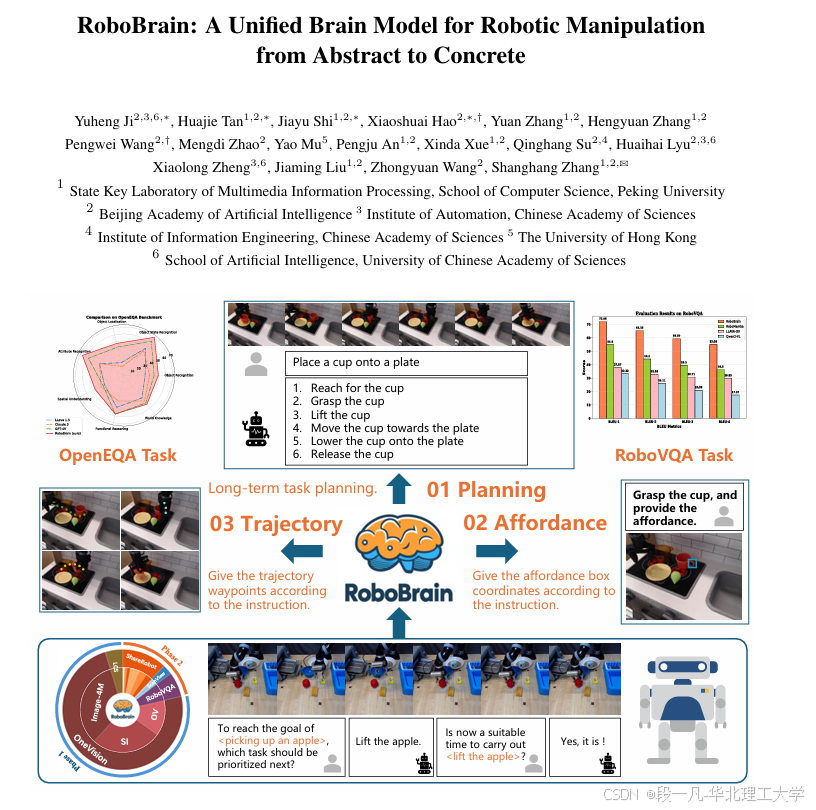

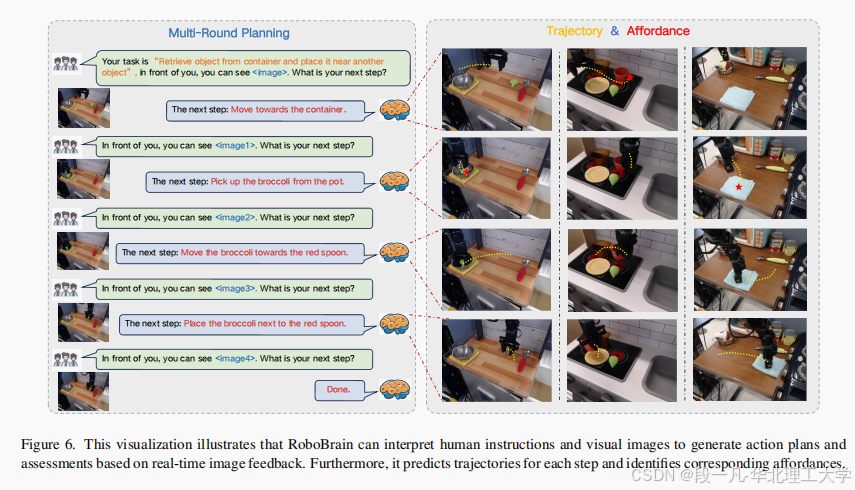

它首次将任务规划、可抓取区域感知(Affordance)与轨迹预测三大核心能力整合进一个端到端模型,并通过超百万级的 ShareRobot 数据集完成训练,在 OpenEQA、RoboVQA 等多个基准上刷新 SOTA,成为迈向通用机器人操作(Generalist Robotic Manipulation)的里程碑。

论文题目:RoboBrain: A Unified Brain Model for Robotic Manipulation from Abstract to Concrete

第一作者:Yuheng Ji

通讯作者:Xiaoshuai Hao

通讯单位:北京大学、北京智源人工智能研究院

发表时间:2025年3月25日

引用参考:Y. Ji et al., “RoboBrain: A Unified Brain Model for Robotic Manipulation from Abstract to Concrete,” 2025 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, TN, USA, 2025, pp. 1724-1734, doi: 10.1109/CVPR52734.2025.00168.

论文地址:https://ieeexplore.ieee.org/document/11094342.

目录:

一、研究动机

二、方法框架与实现

2.1 网络拓扑与参数策略

2.2 数据工程与标注体系

三、实验验证与性能评估

3.1 基准结果

3.2 消融与比例实验

四、结束语

🚀 读完本文,你将获得以下超实用技能和知识储备:

- 🧠 模型设计思维:如何用 LLaVA 结构 + LoRA 插件,低成本扩展机器人专属能力

- 📊 数据集方法论:如何构建“高分辨率+长视频+多维度”的 ShareRobot 数据管线

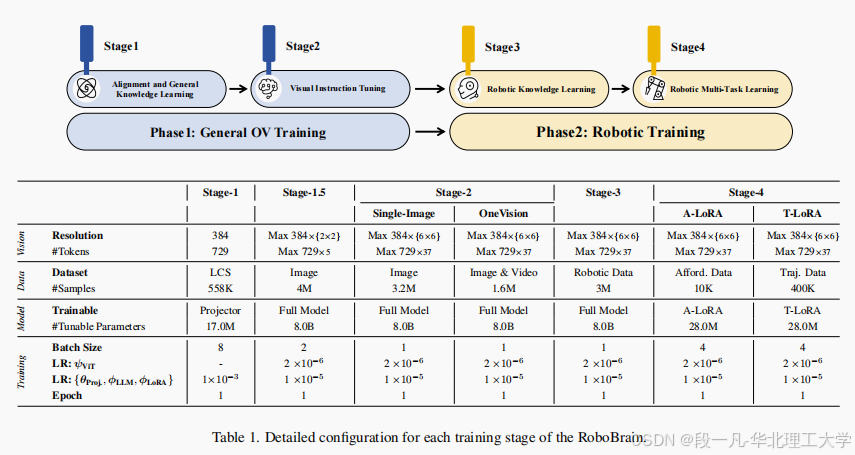

- 🛠️ 训练技巧:四阶段策略(General OV → Robotic Training → Affordance → Trajectory)让模型“先通识、再专精”

- 🔍 评估黑科技:GPT-4o 作为“打分器”统一主观评价,BLEU/DFD/RMSE 量化客观指标

一、研究动机

长期以来,多模态大语言模型(MLLM)在视觉问答、图像描述等任务上已呈现卓越性能,但在真实机器人操作场景中仍显孱弱。根本瓶颈集中于三点:

- 高层抽象指令难以分解为可执行的细粒度子任务;

- 场景中对“可抓取区域(affordance)”的感知缺乏像素级精准度;

- 端到端轨迹的完整预测尚未与语言-视觉语义深度融合。

RoboBrain 的出现,正是针对上述三项缺陷提出的一体化解决方案。它以统一网络架构将规划、感知与轨迹生成整合至单一计算图,并通过大规模高质量数据集 ShareRobot 实现从抽象语义到具体动作的映射。

二、方法框架与实现

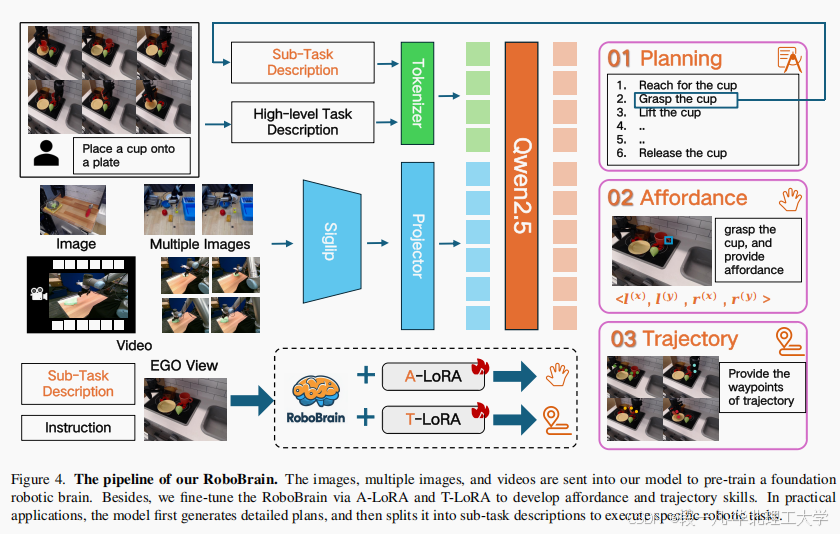

2.1 网络拓扑与参数策略

RoboBrain 基于 LLaVA-OneVision-7B 基线,保留 SigLIP-384×384 视觉编码器与 Qwen2.5-7B 语言模型,核心创新在于引入双 LoRA 插件。

Affordance-LoRA(A-LoRA)与 Trajectory-LoRA(T-LoRA)分别承担 28M 参数的低秩适配,既避免灾难性遗忘,又显著降低显存占用。

训练中采用 Zero3 分布式策略,16×A800 GPU 集群下,单 epoch 仅需 12 小时完成 200k 混合样本迭代。

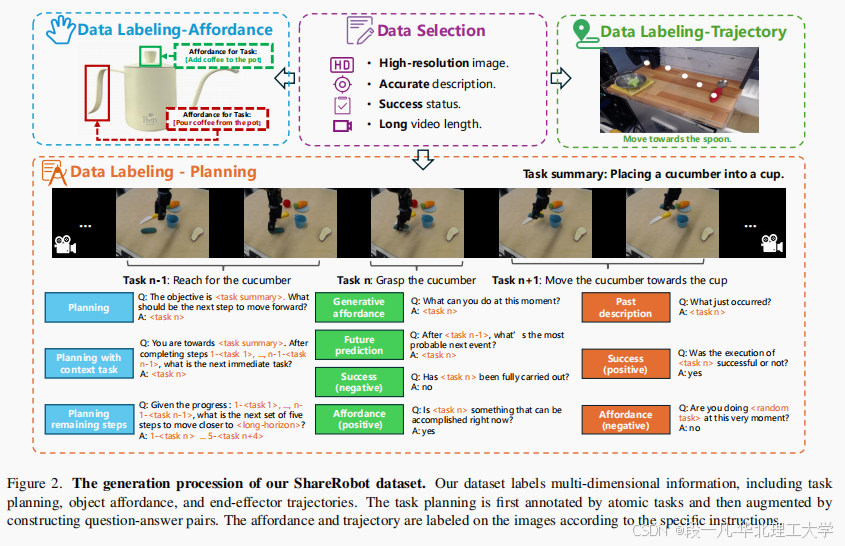

2.2 数据工程与标注体系

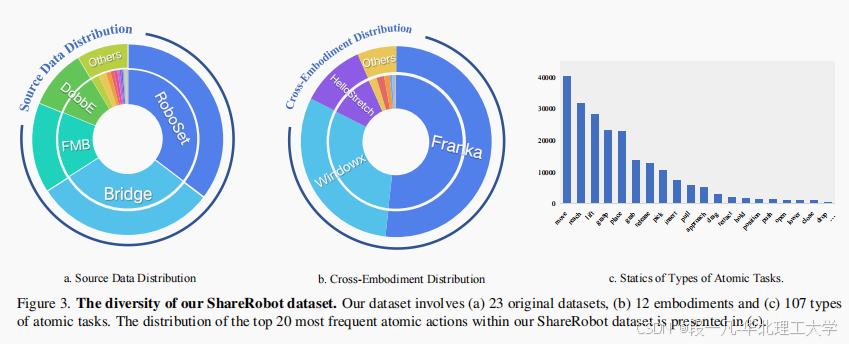

ShareRobot 从 Open X-Embodiment 的 23 个源数据集、102 个场景、12 类机械本体中精炼出 51,403 条高保真视频。

每条视频经 Gemini 初标后由 3 名人类标注员交叉复核,生成 1,027,990 组 QA 对,涵盖规划、affordance、轨迹三类标签。affordance 采用边界框 {l^(x), l^(y), r^(x), r^(y)} 形式;轨迹则以 2D 关键点序列 P_t:N 表示,采样间隔统一至 1000×1000 归一化坐标。

三、实验验证与性能评估

3.1 基准结果

在 OpenEQA、RoboVQA、ShareRobot 三大基准上,

- RoboBrain 的规划任务 BLEU-4 分别超越 GPT-4V 18.75%、LLaVA-OV-7B 24.08%;

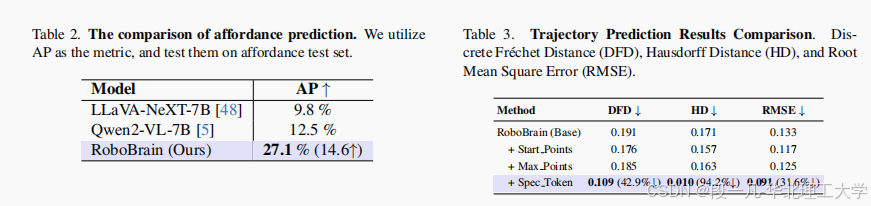

- affordance 预测 AP 提升至 27.1%,相较 Qwen2-VL-7B 提升 14.6 个百分点;

- 轨迹预测的离散 Fréchet 距离、Hausdorff 距离与 RMSE 同步下降 42.9%、94.2%、31.6%。

3.2 消融与比例实验

维持 4:6 的机器人-通用数据比例可在通用视觉基准与机器人基准间取得最佳平衡;引入 ShareRobot 数据后,RoboVQA 指标由 36.29 升至 55.05,增幅达 51.7%。逐阶段训练分析表明,Stage 3 的规划能力显著跃升,Stage 4 的 LoRA 微调则专门强化 affordance 与轨迹分支,二者互补而非冲突。

四、结束语

RoboBrain 以统一的 LLM-LoRA 范式,首次在单模型内完成“语言理解—视觉感知—动作生成”的闭环,为通用机器人操作提供了可扩展、可解释、可迁移的新基线。

未来工作将聚焦于空间推理、工具使用效率与安全约束机制,以期在真实工业与家用场景中实现稳健部署。

最后,感谢你的阅读!如果你觉得本文对你有帮助,不妨点赞和关注,我会继续分享更多关于工业大数据与人工智能工业应用领域的佳文鉴赏系列。🚀

我的邮箱:yifanduan@stu.ncst.edu.cn

关注专栏,每周更新,带你持续了解更多前沿性科研报道。

版权归文章作者所有,本文为对原文的翻译性总结介绍与解读,或有不当之处,敬请指正!