CART算法:Gini指数

目录

1、CART算法的核心特点

2、Gini指数的数学本质

3、Gini增益计算流程

第一步:计算根节点Gini指数

第二步:计算各特征Gini增益

1. 特征"天气"(3个取值:晴/阴/雨)

方案1计算({晴} vs {阴,雨})

方案2/3计算(计算过程略)

2. 特征"风速"(2个取值:弱/强)

第三步:特征选择对比

第四步:构建子树

1:处理纯分支(晴分支)

2:处理混合分支(阴/雨分支)

1. 计算当前节点Gini指数

2. 候选特征选择(应用C4.5改进)

3. 分裂决策

3:后剪枝处理

5、CART的二叉树分裂机制

6、回归树中的方差最小化

8、CART的局限性及解决方案

9、Gini指数计算过程

10、实战:Python sklearn

11、优化策略

"Gini指数像一把快刀,用最简单的计算实现最有效的分割"

1、CART算法的核心特点

Classification and Regression Trees (CART) 是决策树家族的里程碑算法,其独特之处在于:

- 二叉树结构:每个节点只做二元分裂(即使特征有多个取值)

- 万能性:唯一能同时处理分类(Gini指数)和回归(方差最小化)的树算法

- 高效率:Gini指数计算比信息熵节省约40%的计算量(无对数运算)

2、Gini指数的数学本质

定义:从数据集中随机抽取两个样本,其类别标记不一致的概率

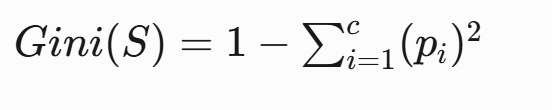

计算公式:

- c:类别总数

- pi:第i类样本的占比

计算示例:某节点有10个样本:

- 7个类别A → pA=0.7

- 3个类别B → pB=0.3

Gini = 1 - (0.7² + 0.3²) = 1 - (0.49 + 0.09) = 0.423、Gini增益计算流程

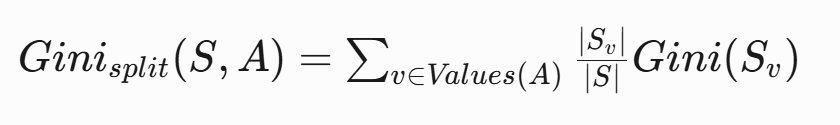

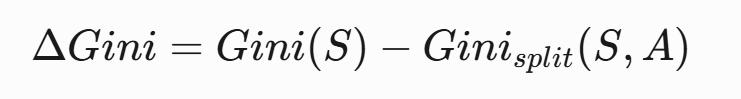

- 计算父节点Gini指数

- 计算特征分裂后的加权Gini指数:

- 计算Gini增益:

实例演算(天气数据集):

| 天气 | 风速 | 打球 |

|---|---|---|

| 晴 | 弱 | 否 |

| 晴 | 强 | 否 |

| 阴 | 弱 | 是 |

| 雨 | 强 | 是 |

| 雨 | 弱 | 是 |

| 雨 | 强 | 否 |

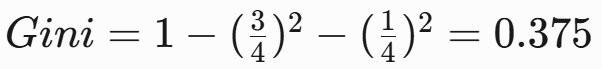

第一步:计算根节点Gini指数

父节点数据(共6个样本):

- •打球=是:3个(阴-是, 雨-是, 雨-是)

- •打球=否:3个(晴-否, 晴-否, 雨-否)

总样本6个:3"是",3"否"——![]()

第二步:计算各特征Gini增益

1. 特征"天气"(3个取值:晴/阴/雨)

候选二分方案(CART必须做二元分裂):

- {晴} vs {阴,雨}

- {阴} vs {晴,雨}

- {雨} vs {晴,阴}

方案1计算({晴} vs {阴,雨})

- 左节点(晴):2否 → Gini=0

- 右节点(阴+雨):1阴是 + 2雨是 + 1雨否

- 加权Gini:

- Gini增益:

方案2/3计算(计算过程略)

- 方案2({阴} vs {晴,雨}):ΔGini=0.1

- 方案3({雨} vs {晴,阴}):ΔGini=0.056

详细计算过程放在:9、Gini指数计算过程

最佳分裂:选择方案1({晴} vs {阴,雨}),ΔGini=0.25

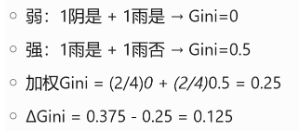

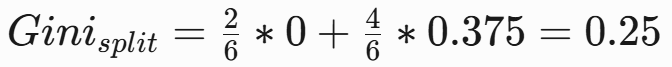

2. 特征"风速"(2个取值:弱/强)

二元分裂方案:{弱} vs {强}

计算过程:

第三步:特征选择对比

| 特征 | 最佳分裂方案 | Gini增益 |

|---|---|---|

| 天气 | {晴} vs {阴,雨} | 0.25 |

| 风速 | {弱} vs {强} | 0.056 |

决策:选择"天气"的{晴} vs {阴,雨}分裂方案

第四步:构建子树

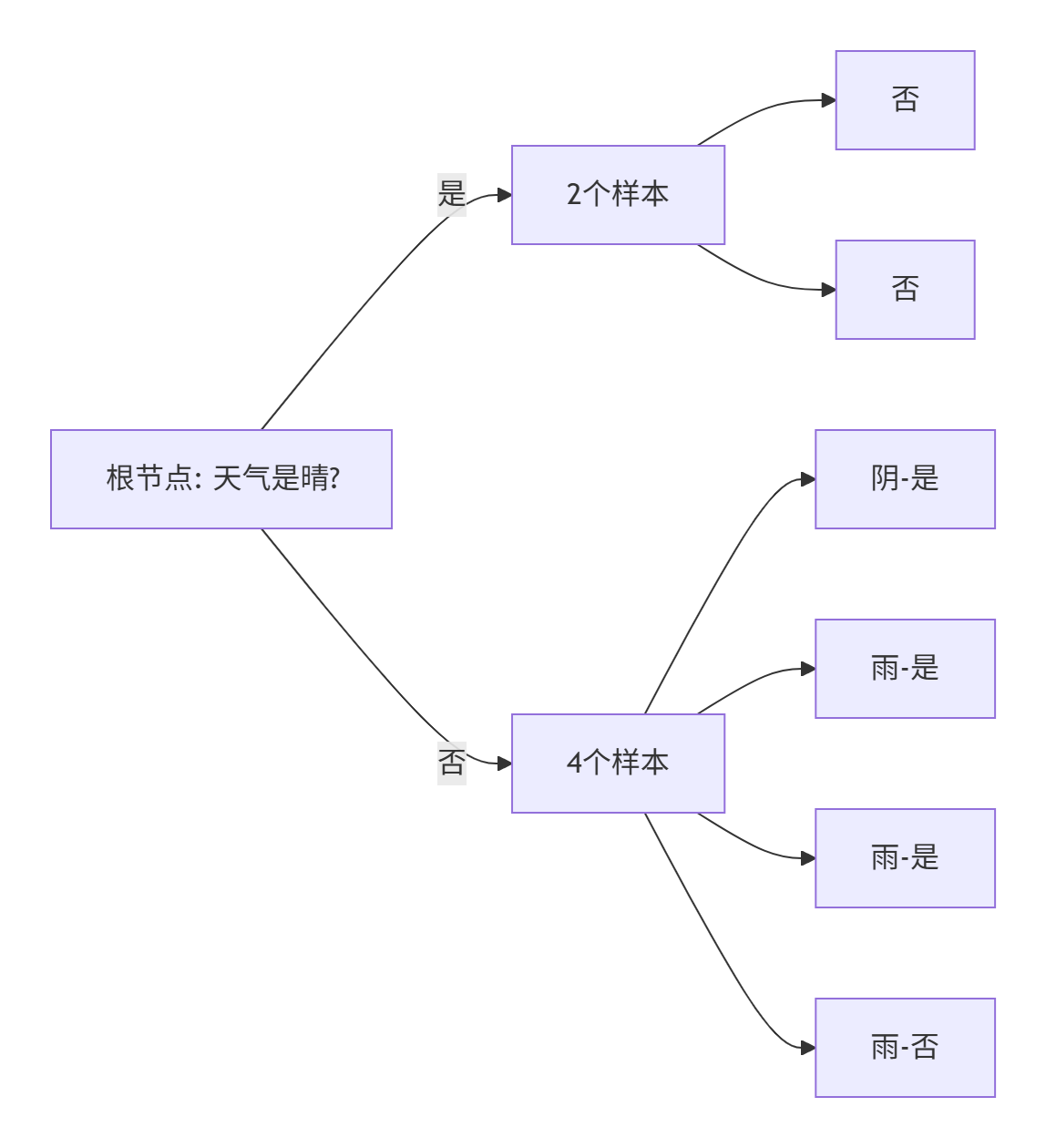

当前分裂状态

1:处理纯分支(晴分支)

左分支(天气=晴):样本完全纯净(全部为"否"),直接作为叶节点:不打球。无需剪枝(已达最大纯度)。

2:处理混合分支(阴/雨分支)

右分支(天气≠晴):

4个样本:

| 天气 | 风速 | 打球 |

|---|---|---|

| 阴 | 弱 | 是 |

| 雨 | 强 | 是 |

| 雨 | 弱 | 是 |

| 雨 | 强 | 否 |

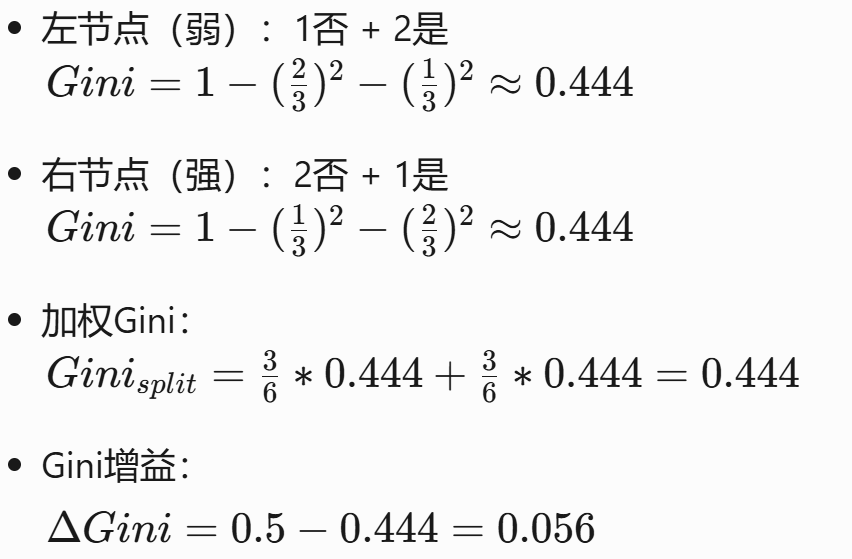

1. 计算当前节点Gini指数

![]()

2. 候选特征选择(应用C4.5改进)

(1) 连续特征处理(无)。本例无连续特征

(2) 缺失值处理(无)。当前分支无缺失值

(3) 计算各特征的Gini指数

a. 天气特征(已用父特征,不再考虑)

b. 风速特征:

-

分裂方案:{弱} vs {强}

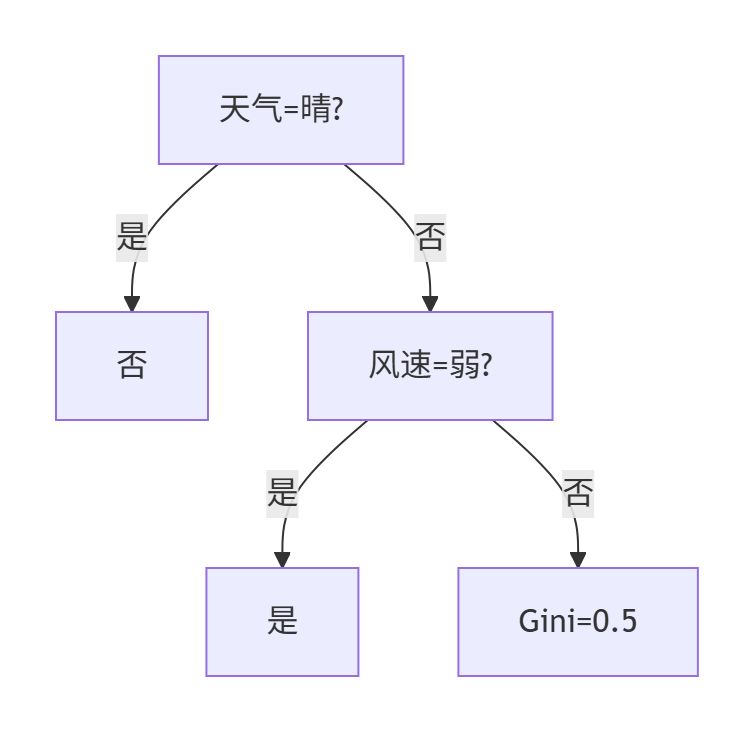

3. 分裂决策

- 唯一可用特征:风速(ΔGini=0.125)

- 执行分裂(虽然增益率不高,但能提升纯度)

节点说明:

- 风速=弱:阴-是 + 雨-是 → 纯净叶节点(打球)

- 风速=强:样本:雨-是 + 雨-否 → 仍需分裂但无更多特征

3:后剪枝处理

-

评估风速=强分支:

- 不分裂时:直接预测多数类(是:1, 否:1 → 无法确定)

- 替代方案:合并为叶节点并计算验证集误差

- 若验证集支持"多数表决"(如选"是"),则剪枝

-

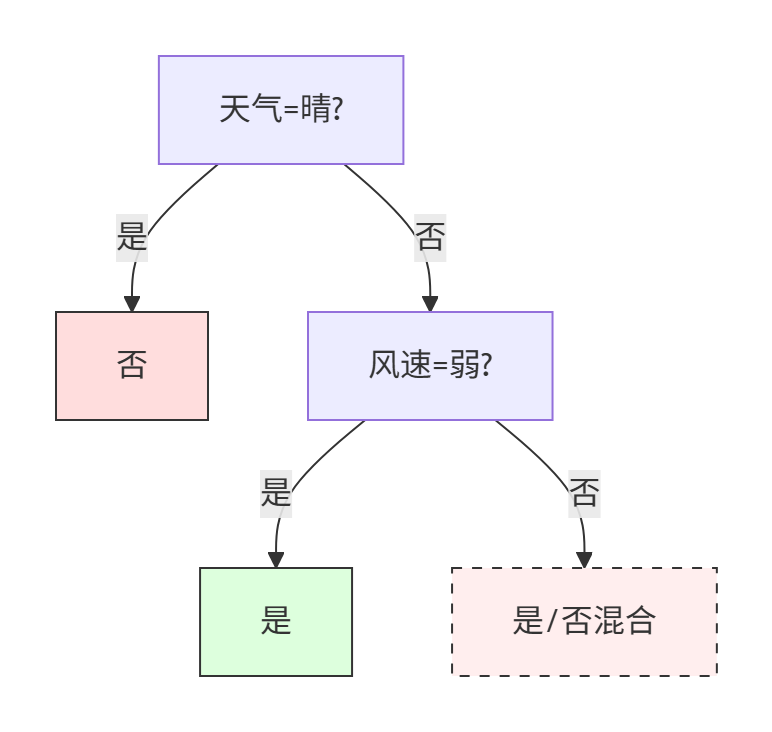

最终优化树:

当特征信息不足时,允许存在未完全纯化的节点。

完整决策规则

- 晴天 → 不打球

- 非晴天且弱风 → 打球

- 非晴天且强风 → 打球(剪枝后保守决策)

业务解释:

雨天强风时实际存在不打球样本,但C4.5通过剪枝牺牲局部精度换取泛化能力,这与ID3追求100%训练集准确率形成鲜明对比。

关键结论

-

CART特性:

- 强制二叉树结构(即使天气有3个取值也转为二元问题)

- 对阴/雨节点的风速分裂产生混合结果,说明需要更多特征

-

与ID3/C4.5对比:

# ID3会直接选择天气三路分裂: # 晴→否, 阴→是, 雨→混合 # CART通过二元分裂更适应集成学习 -

业务解释:

- 晴天绝对不打球

- 非晴天时,弱风天打球,强风天需结合温度等其他因素判断

5、CART的二叉树分裂机制

连续特征处理:

- 将特征值排序(如年龄[22,25,30])

- 计算相邻值中点(23.5, 27.5)

- 选择使Gini增益最大的分割点

类别特征处理:

- 对k个取值生成2k−1−1种可能划分

- 选择最优二分方案(计算复杂度优化关键)

Python实现示例:

# 最佳分割点查找函数

def find_best_split(X, y):best_gain = -1for feature in range(X.shape[1]):thresholds = np.unique(X[:, feature])for thresh in thresholds:left_idx = X[:, feature] <= threshp_left = np.mean(y[left_idx])p_right = np.mean(y[~left_idx])gini_left = 1 - (p_left**2 + (1-p_left)**2)gini_right = 1 - (p_right**2 + (1-p_right)**2)gain = gini_parent - (len(left_idx)/len(y))*gini_left - (len(~left_idx)/len(y))*gini_rightif gain > best_gain:best_gain = gainreturn best_gain6、回归树中的方差最小化

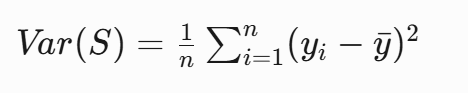

当用于回归任务时,CART改用方差作为分裂标准:

选择使加权方差最小的分割:

房价预测示例:

- 分割前方差:100

- 按"房间数≤3"分割:

- 左节点方差:60(样本占比0.6)

- 右节点方差:30(样本占比0.4)

ΔVar = 100 - (0.6 * 60 + 0.4 * 30) = 648、CART的局限性及解决方案

| 局限性 | 解释 | 解决方案 |

|---|---|---|

| 过拟合 | CART 会不断分裂直到纯度最大化,可能导致模型过于复杂,泛化能力差。 | 后剪枝(Post-Pruning): 使用 预剪枝(Pre-Pruning): 设置 |

| 数据不平衡 | 如果某一类样本占主导,CART 可能会偏向该类,忽略少数类。 | 类别权重: 使用 采样方法: 过采样少数类(SMOTE)或欠采样多数类。 |

| 不稳定性 | 训练数据的微小变化可能导致完全不同的树结构。 | 随机森林(Random Forest): 通过多棵树的投票降低方差。 梯度提升树(GBDT/XGBoost/LightGBM): 使用 Boosting 方式逐步修正错误。 |

| 只能生成二叉树 | 相比 ID3/C4.5 的多叉树,CART 的二叉树结构可能在某些数据集上效率较低。 | 需要多叉树 → 使用 ID3/C4.5(如 Weka 的 需要更鲁棒的树 → 使用 条件推断树(CIT, |

| 类别特征处理低效 | 直接处理类别特征时,CART 可能不如信息增益(ID3/C4.5)高效。 | 分箱(Binning): 对连续特征离散化,提高稳定性。 避免高基数类别特征: 对类别特征进行编码(如 Target Encoding)。 |

| 贪心分裂 (局部最优) | 每次分裂只考虑当前最优,而非全局最优,可能导致次优树结构。 | 动态规划优化树结构(如 OSDT 算法,但计算成本高)。 |

CART算法因其简洁高效,成为现代集成学习(如随机森林、GBDT)的基础组件。Gini指数的设计体现了机器学习中一个重要原则:在保证效果的前提下,最简单的计算方法往往是最优选择。这种思想在XGBoost等现代算法中得到了进一步发扬光大。

9、Gini指数计算过程

方案2:{阴} vs {晴,雨} 二元分裂

1. 计算子集Gini指数

左节点(阴):

-

样本:1是

-

Gini = 1 - (1/1)² - (0/1)² = 0

右节点(晴+雨):

-

样本:2晴否 + 3雨(2是,1否)

-

是占比 = 2/5,否占比 = 3/5

-

Gini = 1 - (2/5)² - (3/5)² = 0.48

2. 计算加权Gini

3. 计算Gini增益

ΔGini=0.5−0.4=0.1

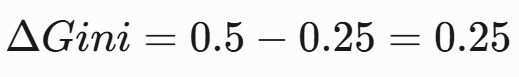

方案3:{雨} vs {晴,阴} 二元分裂

1. 计算子集Gini指数

左节点(雨):

-

样本:2是,1否

-

Gini = 1 - (2/3)² - (1/3)² ≈ 0.444

右节点(晴+阴):

-

样本:2晴否 + 1阴是

-

是占比 = 1/3

-

否占比 = 2/3

-

Gini = 1 - (1/3)² - (2/3)² ≈ 0.444

2. 计算加权Gini

3. 计算Gini增益

ΔGini=0.5−0.444=0.056

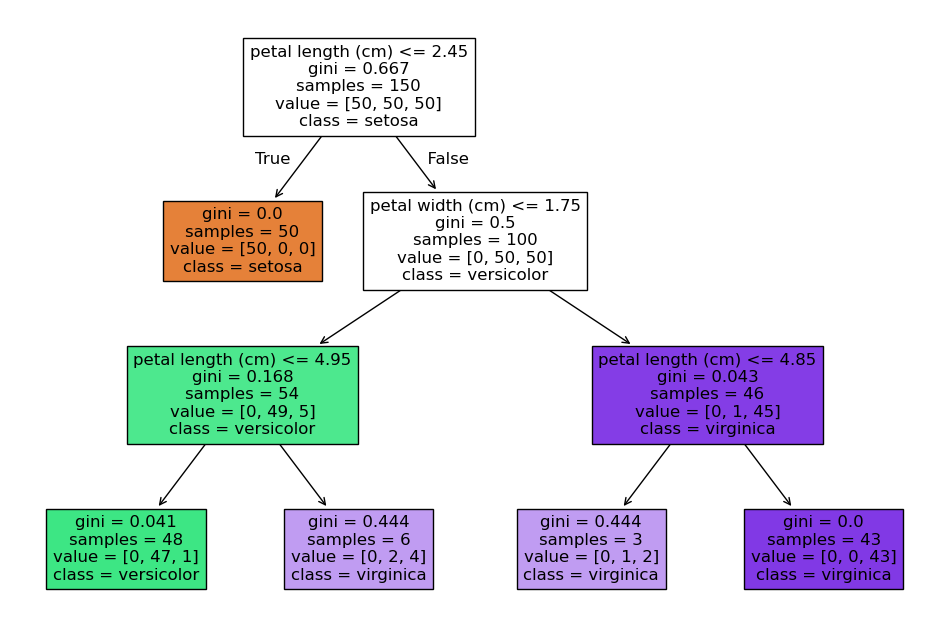

10、实战:Python sklearn

from sklearn.tree import DecisionTreeClassifier, plot_tree

from sklearn.datasets import load_iris

import matplotlib.pyplot as plt# 加载数据

iris = load_iris()

X, y = iris.data, iris.target# 创建决策树(使用Gini指数)

model = DecisionTreeClassifier(max_depth=3, random_state=42)

model.fit(X, y)# 可视化决策树

plt.figure(figsize=(12,8))

plot_tree(model, feature_names=iris.feature_names,class_names=iris.target_names,filled=True)

plt.show()关键参数说明:

max_depth:树的最大深度(控制复杂度)min_samples_split:节点最小分裂样本数criterion:分裂标准(gini/entropy)

11、优化策略

- 剪枝实战(预防过拟合):

# 后剪枝示例(代价复杂度剪枝)

pruned_model = DecisionTreeClassifier(ccp_alpha=0.02)

pruned_model.fit(X, y)-

处理连续特征:寻找最佳分割点(如排序后取中位数)

-

处理缺失值:替代分裂(surrogate splits)