深入解析LLM层归一化:稳定训练的关键

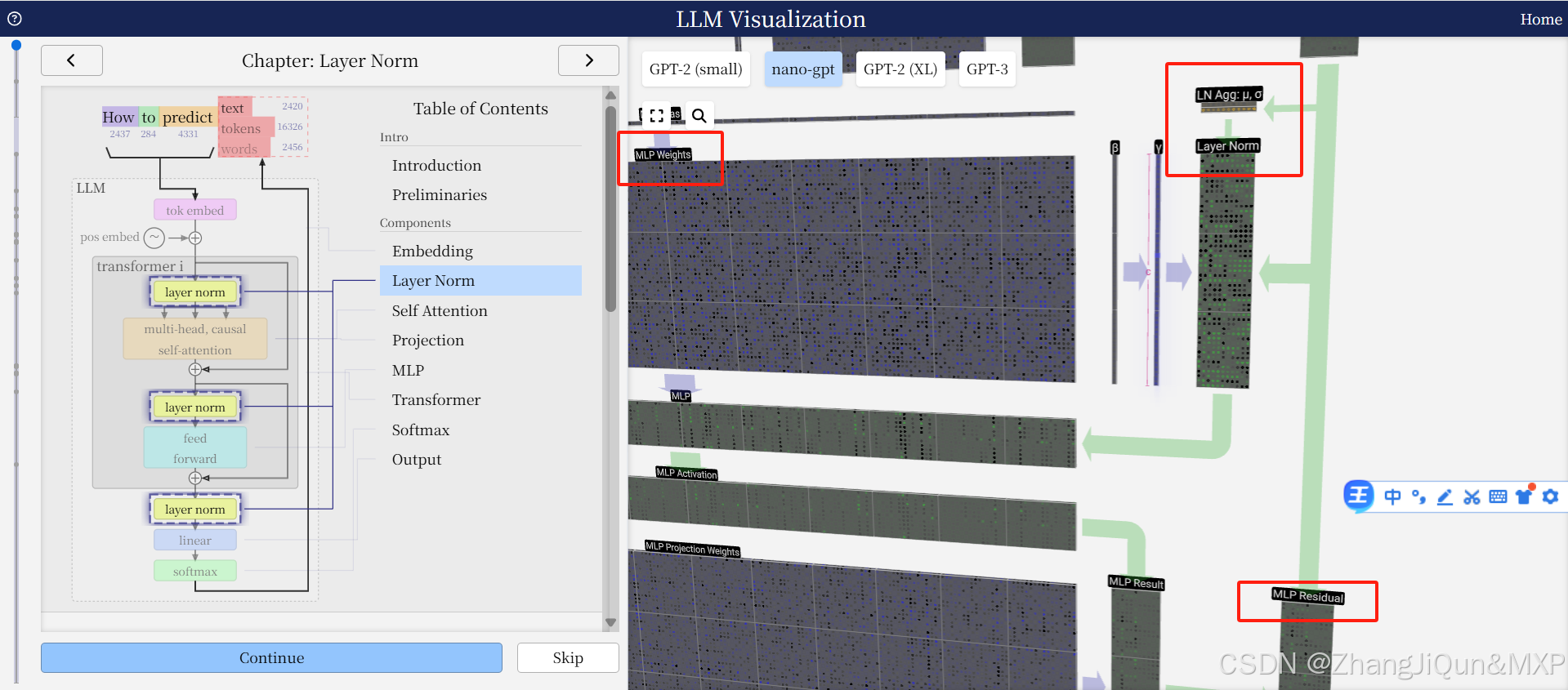

LLM 中的 层归一化(Layer Normalization)

残差流灭有归一化,但是他的输入参数是经过归一化计算的,因此残差流数字不会很大

1. Layer Norm

即 层归一化(Layer Normalization),是深度学习中用于稳定训练、加速收敛的归一化技术。

- 作用:对神经网络某一层的输出特征进行标准化(均值为0,方差为1),避免因特征分布波动导致训练不稳定。

2. LN Agg: μ, σ

LN是Layer Norm的缩写;Agg可理解为 Aggregation(聚合)。μ(mu):该层特征的均值(mean);σ(sigma):该层特征的标准差(standard deviation)。- 含义:在层归一化中,首先对当前层的特征进行统计,计算出所有特征的均值