第2章 AB实验的关键问题

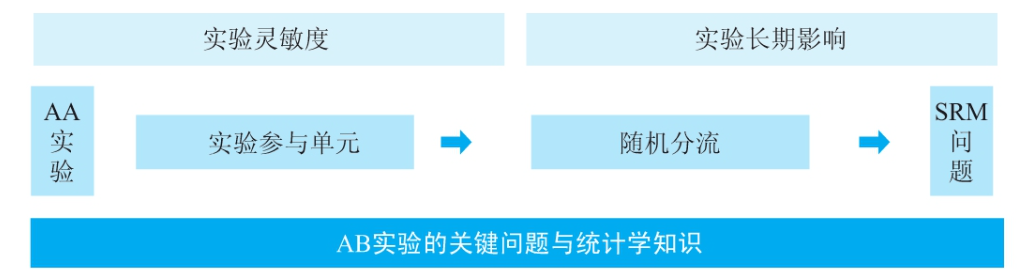

在第二部分,我们将深入讨论AB实验的关键问题和统计学知识,只有掌握这些理论基础才能更好地进行后续实践。

- 在理论基础之上会介绍实验参与单元和随机分流,这两个部分与业务紧密相连,不同的业务和场景有不同的选型和方案,关系到实验效果的评估的可靠性和准确性。

- RM问题和AA实验作为保证AB实验可靠性的手段,也将重点介绍。

- 实验评估分析中实验灵敏度和实验的长期影响问题是两个较难解决的常见问题,在本部分也会进行讨论。

引言:AB实验的“简单陷阱”

某电商平台曾对搜索算法进行优化,实验显示新策略让点击率提升8.2%,全量上线后大盘数据却纹丝不动。复盘发现——实验期间对照组流量被其他团队占用,导致用户群体不匹配。这个真实案例揭示了AB实验的核心矛盾:原理简单如“随机分组对比”,落地却暗藏系统性风险。本章将结合案例拆解四大关键问题。

一、实验参与对象的3大陷阱与案例

问题1:伪随机分组

- 理论:哈希函数分组可能发生碰撞,极值用户(如VIP)会扭曲结果

- 案例:某社交App测试红包弹窗效果,由于采用低性能哈希算法,实验组意外集中了大量新注册用户(占比达35% vs 对照组的12%),导致误判“弹窗显著提升留存”

问题2:违反SUTVA假设

- 理论:用户行为需独立,避免组间互相影响

- 案例:外卖平台实验配送费补贴时,实验组用户将优惠信息分享到社区,吸引对照组用户主动索要补贴,最终补贴效果被高估200%

问题3:样本量不足

- 理论:小样本易受随机波动干扰

- 案例:工具类App测试付费转化,因仅分配5%流量(约500人/组),导致统计功效(Power)仅35%,错失真实提升2%的优质方案

二、随机分流的3类致命错误

问题1:颗粒度错配

- 理论:用户级分流适合长期行为,页面级适合短期交互

- 案例:视频平台测试推荐算法时,采用页面级分流导致同一用户在不同页面看到完全相反的策略,用户体验割裂造成跳出率上升15%

问题2:流量复用失控

- 理论:正交分层需保证流量独立性

- 案例:电商大促期间,3个团队同时使用“满199减30”活动标签做实验,流量交叉污染使转化率提升归因完全失效

问题3:SRM(样本比例不匹配)

- 理论:组间用户结构需同质

- 案例:旅游平台实验发现“新界面提升机票预订率12%”,实则因实验组意外涌入更多iOS用户(占比68% vs 对照组的52%),真实效果仅3%

三、实验指标的2大设计雷区

问题1:指标体系缺失

- 理论:需区分核心指标/护栏指标/探索指标

- 案例:某资讯App仅关注点击率提升,未监控阅读完成率,上线“标题党”策略后虽然CTR+15%,但用户停留时长暴跌20%

问题2:OEC(综合评估标准)失效

- 理论:多目标需量化加权

- 案例:游戏公司测试新活动时,将「付费率×30% + ARPU×70%」作为OEC,忽略活跃度指标,导致出现高付费但玩家流失的“杀鸡取卵”效应

四、实验分析和评估的3个问题

错误1:统计结果误读

- 经典陷阱:将P=0.06解读为“边缘显著”

- 案例:在线教育平台因忽略统计功效(实际仅60%),误将偶然波动当作课程改版效果,损失百万改造成本

- 解法:AA测试验证系统稳定性 + 预估样本量工具

P值误读(P=0.06 ≠ "边缘显著")

- P值本质:当策略实际无效时,实验观测到差异纯属偶然的概率

- 行业标准:P≤0.05 才认为统计显著(即只有≤5%概率是随机波动)

- 致命错误:将P=0.06解读为“接近显著” → 相当于把59分说成“勉强及格”

统计功效(Power)不足(60%的灾难)

- 定义:当策略真实有效时,实验能成功检测到显著差异的概率

- 最低要求:通常需≥80%(案例中仅60% = 40%概率漏检真效果)

- 后果:

✅ 如果策略无效 → 实验大概率正确判断(P>0.05)

❌ 如果策略有效 → 实验有40%概率误判为无效(漏报)

错误2:分析流程漏洞

- 隐蔽风险:偷窥实验(Peeking Problem)

- 案例:金融App在实验第3天看到转化率提升就提前终止,实则后续数据回归正常水平(如下图时序波动)

实验组转化率:第1天 +5% → 第3天 +12% → 第7天 +1.3% - 解法:预注册实验方案 + 固定样本分析

错误3:外推谬误

- 群体外推:本地生活App在大学生群体实验成功的“周末套餐”,推广到全年龄段时订单量下降18%

- 时间外推:社交游戏“签到奖励”实验期DAU+25%,1个月后因奖励疲劳效应归零

- 解法:长期观测队列 + 因果森林模型评估异质效应

结语:AB实验的“反脆弱”设计原则

某头部电商通过标准化以下流程,将实验失败率从35%降至12%:

1️⃣ 分流阶段:强制SRM检测 + 用户属性平衡算法

2️⃣ 执行阶段:自动AA测试看板 + 偷窥防护锁

3️⃣ 决策阶段:OEC决策矩阵 + 长期效果追踪器

关键认知:当实验全量后效果消失的概率超过15%(而非理论上的5%),往往意味着系统性偏差已渗透实验全链路。这不仅是统计问题,更是组织协作与数据基建的试金石。

延伸思考:你们团队是否遇到过“实验成功但业务受损”的案例?

来源书籍:——刘玉凤《AB实验:科学归因于增长的利器》