在一台没联网的机器上,用ollama加载qwen3,14b

文章目录

- 背景

- 去另一台机器下载模型

-

- 使用docker部署ollama

- 后续

背景

项目甲方终于搞定了一台T4,咱们的项目又可以正常推进了。

但是,高高兴兴地上去之后,发现,此机器竟不可以联网~

不过好在,前辈已经把docker装好了。

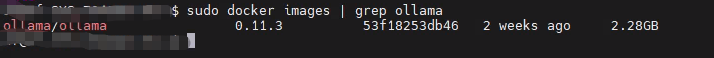

竟然还有ollama的镜像。

可以的,至少可以节省一步。

去另一台机器下载模型

使用docker部署ollama

使用docker部署ollama之前,先要拉取ollama的镜像。当然这个时候会遇到镜像仓库源不可用的问题。

这个时候,可以试试:docker.1ms.run作为镜像(此镜像非彼镜像)

有了ollama的镜像之后,就可以用docker run运行一个ollama的容器了:

docker run -d --gpus=all -v ./ollama:/root/.ollama -p 13434:11434 --name ollama_3 ollama/ollama

这里,--gpus=all表示使用所有的GPU,如果你只想用某一个GPU呢?

要使用:

–gpus “device=1”