【完整源码+数据集+部署教程】织物缺陷检测系统源码和数据集:改进yolo11-RevCol

背景意义

研究背景与意义

随着纺织工业的快速发展,织物质量的控制与检测变得愈发重要。织物缺陷不仅影响产品的外观和使用性能,还可能导致经济损失和品牌形象的受损。因此,开发高效、准确的织物缺陷检测系统成为了行业亟待解决的问题。传统的人工检测方法不仅耗时耗力,而且容易受到人为因素的影响,导致检测结果的不稳定性。为此,基于计算机视觉的自动化检测技术应运而生,尤其是深度学习技术的迅猛发展,为织物缺陷检测提供了新的解决方案。

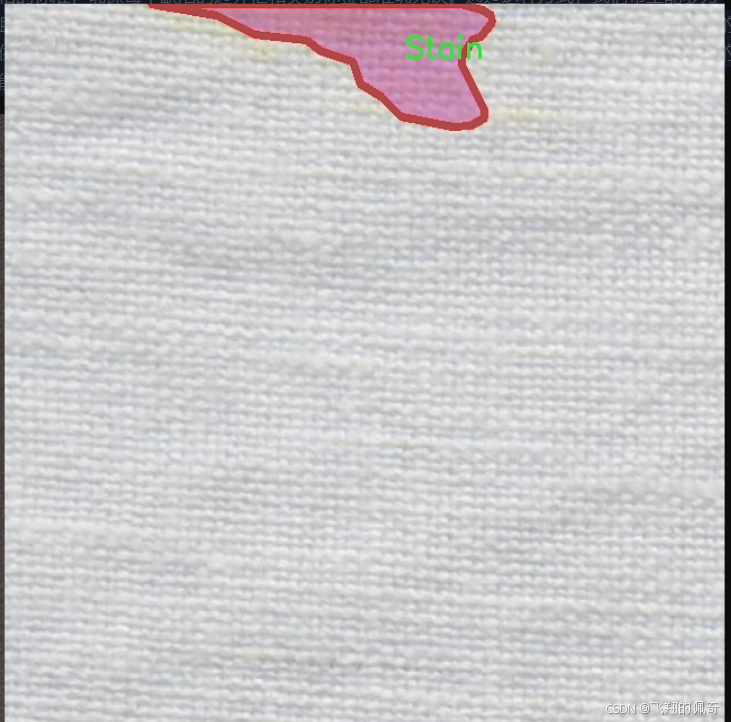

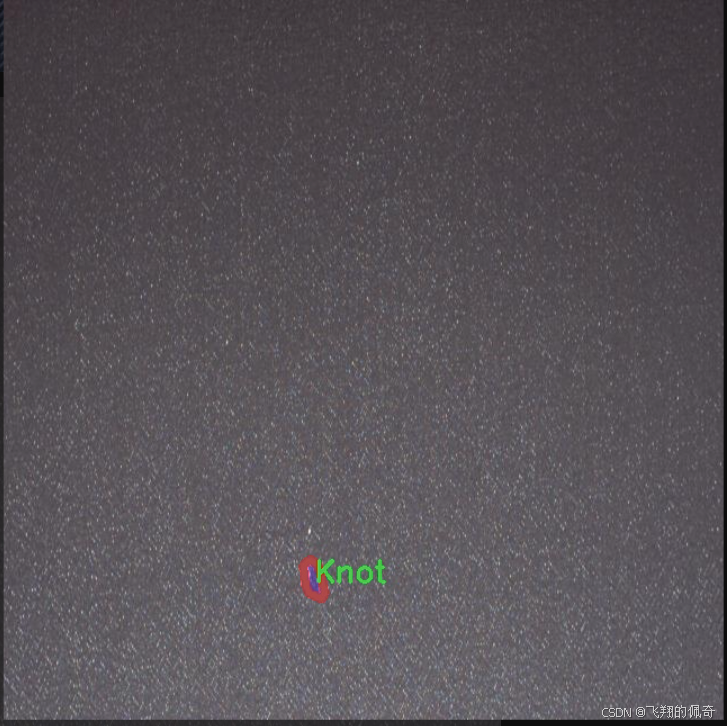

在众多深度学习模型中,YOLO(You Only Look Once)系列因其高效的实时检测能力而受到广泛关注。YOLOv11作为该系列的最新版本,具备更强的特征提取能力和更快的推理速度,适合于处理复杂的视觉任务。通过对YOLOv11进行改进,可以进一步提升其在织物缺陷检测中的性能。具体而言,本研究将聚焦于四种主要的织物缺陷类型:孔洞、结疤、线头和污渍,这些缺陷在实际生产中较为常见且对产品质量影响显著。

本项目将使用包含2500张图像的织物缺陷数据集进行训练和测试,数据集涵盖了多种缺陷类型,具有较高的代表性和实用性。通过对该数据集的深入分析和模型的优化,期望能够实现高精度的缺陷检测,并为后续的织物质量控制提供科学依据。此外,本研究还将探讨改进YOLOv11在不同缺陷类型检测中的表现差异,以期为纺织行业的智能化发展提供有力支持。通过这一研究,期望不仅能够提升织物缺陷检测的效率和准确性,还能推动计算机视觉技术在纺织领域的应用与发展。

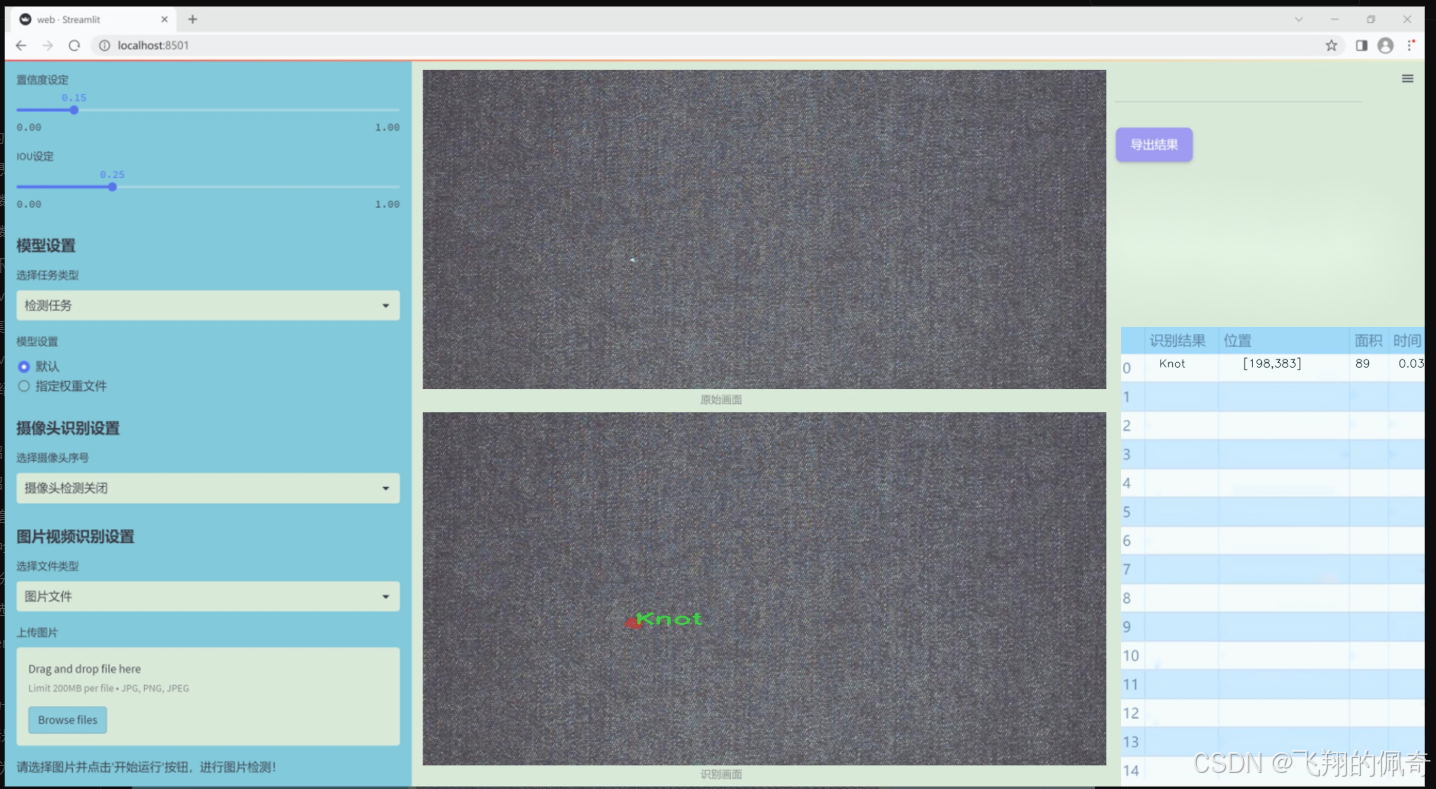

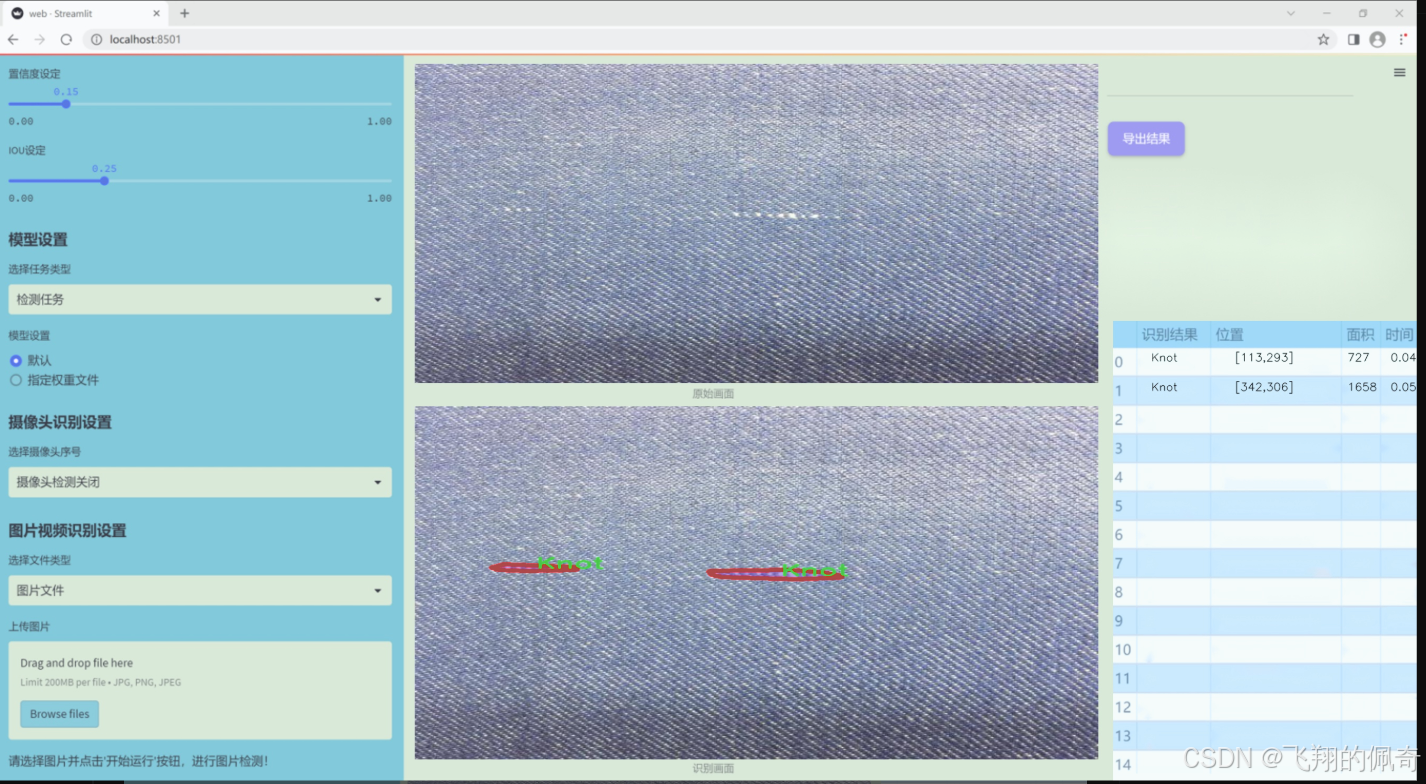

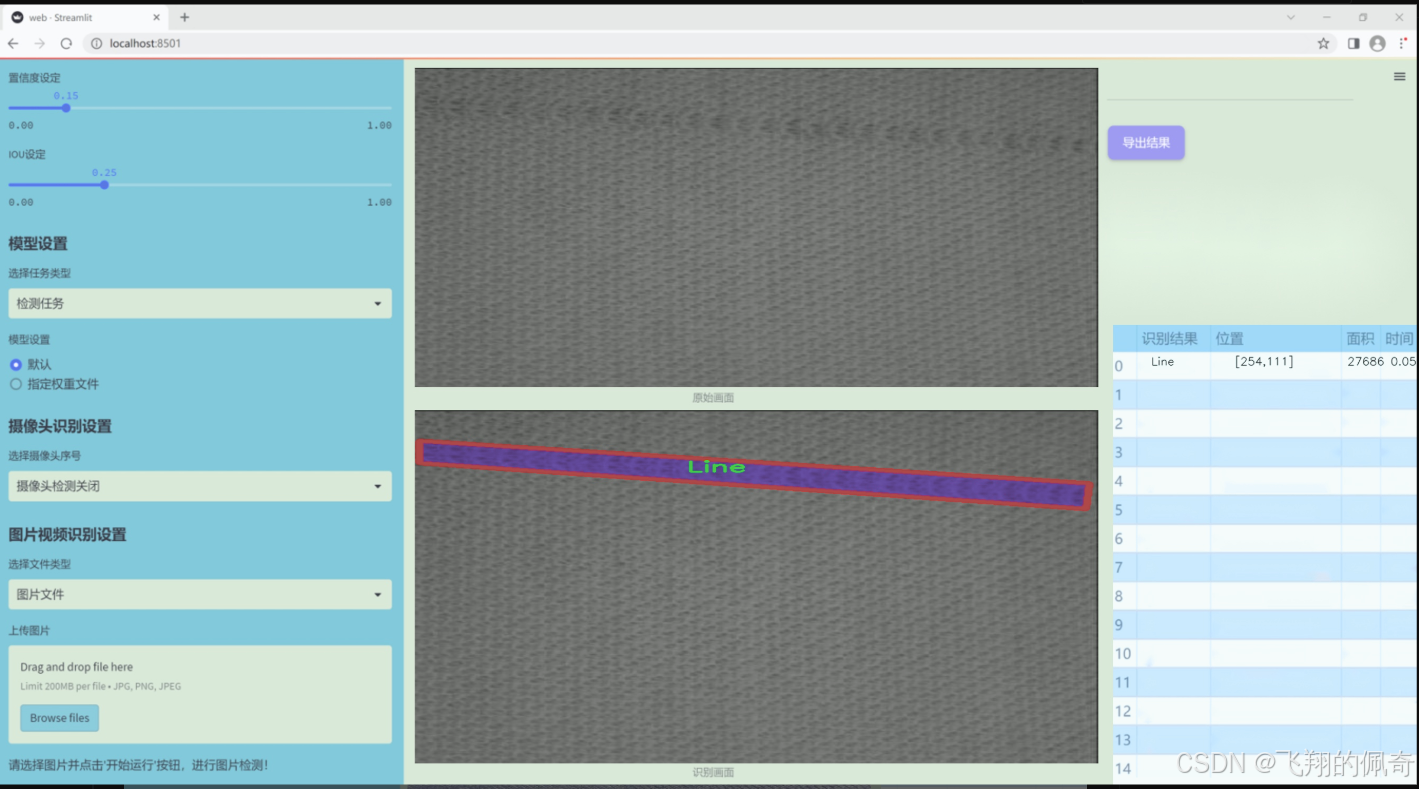

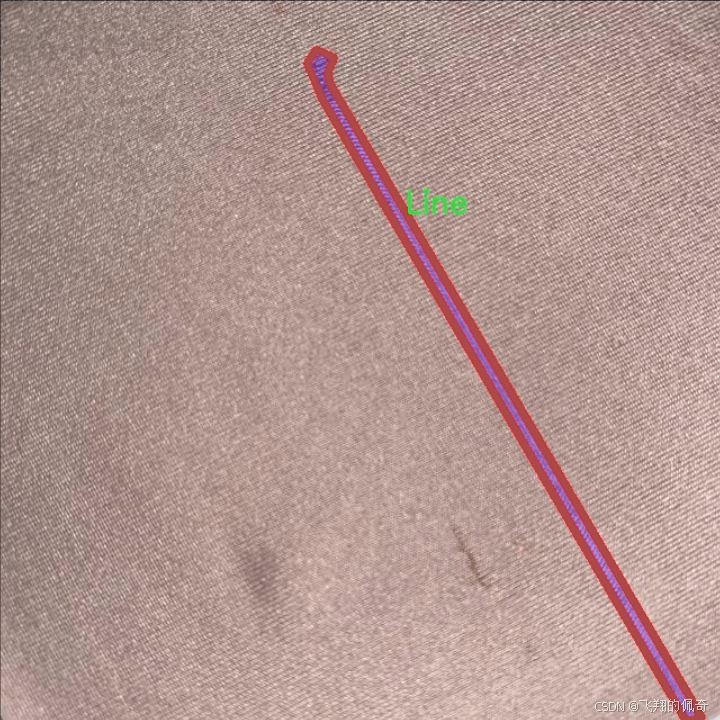

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于织物缺陷检测,旨在为改进YOLOv11模型提供高质量的训练样本。数据集包含四个主要类别,分别是“Hole”(孔洞)、“Knot”(结)、“Line”(线条)和“Stain”(污渍),这些类别涵盖了织物在生产和使用过程中可能出现的常见缺陷。每个类别的样本均经过精心挑选和标注,以确保数据的准确性和多样性,从而提升模型的检测能力。

在数据集的构建过程中,我们考虑了织物的多样性,包括不同材质、颜色和纹理的织物样本。这种多样性不仅有助于模型学习到不同类型缺陷的特征,还能增强其在实际应用中的泛化能力。此外,数据集中每个类别的样本数量经过合理分配,以确保模型在训练过程中能够获得均衡的学习机会,避免因某一类别样本过少而导致的偏差。

数据集的标注过程采用了严格的标准,确保每个缺陷的边界框和类别标签都准确无误。通过这种方式,我们希望能够为YOLOv11模型提供一个全面且具有挑战性的训练环境,使其能够在实际应用中有效识别和分类织物缺陷。总之,本项目的数据集不仅为模型的训练提供了坚实的基础,也为织物缺陷检测技术的进一步发展奠定了重要的基础。通过对该数据集的深入分析和应用,我们期待能够显著提升织物缺陷检测的准确性和效率,为相关行业带来更高的质量保障。

核心代码

以下是经过简化和注释的核心代码部分:

import torch

import torch.nn as nn

from functools import lru_cache

class KAGNConvNDLayer(nn.Module):

def init(self, conv_class, norm_class, conv_w_fun, input_dim, output_dim, degree, kernel_size,

groups=1, padding=0, stride=1, dilation=1, dropout: float = 0.0, ndim: int = 2):

super(KAGNConvNDLayer, self).init()

# 初始化参数self.inputdim = input_dimself.outdim = output_dimself.degree = degreeself.kernel_size = kernel_sizeself.padding = paddingself.stride = strideself.dilation = dilationself.groups = groupsself.base_activation = nn.SiLU() # 使用SiLU激活函数self.conv_w_fun = conv_w_fun # 卷积权重函数self.ndim = ndim # 维度self.dropout = nn.Dropout3d(p=dropout) if ndim == 3 else nn.Dropout2d(p=dropout) if ndim == 2 else nn.Dropout1d(p=dropout) if ndim == 1 else None# 参数检查if groups <= 0:raise ValueError('groups must be a positive integer')if input_dim % groups != 0:raise ValueError('input_dim must be divisible by groups')if output_dim % groups != 0:raise ValueError('output_dim must be divisible by groups')# 创建卷积层和归一化层self.base_conv = nn.ModuleList([conv_class(input_dim // groups,output_dim // groups,kernel_size,stride,padding,dilation,groups=1,bias=False) for _ in range(groups)])self.layer_norm = nn.ModuleList([norm_class(output_dim // groups) for _ in range(groups)])# 多项式权重初始化poly_shape = (groups, output_dim // groups, (input_dim // groups) * (degree + 1)) + tuple(kernel_size for _ in range(ndim))self.poly_weights = nn.Parameter(torch.randn(*poly_shape))self.beta_weights = nn.Parameter(torch.zeros(degree + 1, dtype=torch.float32))# 权重初始化for conv_layer in self.base_conv:nn.init.kaiming_uniform_(conv_layer.weight, nonlinearity='linear')nn.init.kaiming_uniform_(self.poly_weights, nonlinearity='linear')nn.init.normal_(self.beta_weights, mean=0.0, std=1.0 / ((kernel_size ** ndim) * self.inputdim * (self.degree + 1.0)))def beta(self, n, m):# 计算beta值return (((m + n) * (m - n) * n ** 2) / (m ** 2 / (4.0 * n ** 2 - 1.0))) * self.beta_weights[n]@lru_cache(maxsize=128) # 缓存以避免重复计算Legendre多项式

def gram_poly(self, x, degree):p0 = x.new_ones(x.size()) # 初始化p0为全1if degree == 0:return p0.unsqueeze(-1)p1 = xgrams_basis = [p0, p1]for i in range(2, degree + 1):p2 = x * p1 - self.beta(i - 1, i) * p0 # 计算Legendre多项式grams_basis.append(p2)p0, p1 = p1, p2return torch.cat(grams_basis, dim=1) # 连接多项式基def forward_kag(self, x, group_index):# 对输入应用基础激活函数和卷积层basis = self.base_conv[group_index](self.base_activation(x))# 将x归一化到[-1, 1]范围x = torch.tanh(x).contiguous()if self.dropout is not None:x = self.dropout(x) # 应用dropoutgrams_basis = self.base_activation(self.gram_poly(x, self.degree)) # 计算Gram多项式基y = self.conv_w_fun(grams_basis, self.poly_weights[group_index],stride=self.stride, dilation=self.dilation,padding=self.padding, groups=1)y = self.base_activation(self.layer_norm[group_index](y + basis)) # 归一化和激活return ydef forward(self, x):# 将输入分组并进行前向传播split_x = torch.split(x, self.inputdim // self.groups, dim=1)output = []for group_ind, _x in enumerate(split_x):y = self.forward_kag(_x.clone(), group_ind)output.append(y.clone())y = torch.cat(output, dim=1) # 连接输出return y

代码说明:

KAGNConvNDLayer类:这是一个自定义的神经网络层,支持多维卷积(1D、2D、3D),并使用了Legendre多项式的特性。

初始化方法:设置输入和输出维度、卷积参数、激活函数、归一化层等,并初始化卷积和多项式权重。

beta方法:计算用于Legendre多项式的beta值。

gram_poly方法:计算给定度数的Legendre多项式,并缓存结果以提高效率。

forward_kag方法:执行前向传播,应用卷积和激活函数,并返回输出。

forward方法:将输入数据分组,调用forward_kag进行处理,并将结果合并。

这个程序文件 kagn_conv.py 实现了一个基于卷积神经网络的自定义层,主要用于处理多维数据(如1D、2D和3D数据)。该层的设计灵感来源于一个名为 GRAMKAN 的项目,具体实现了一个名为 KAGNConvNDLayer 的类,作为其他特定维度卷积层的基类。

在 KAGNConvNDLayer 类的构造函数中,初始化了一些重要的参数,包括输入和输出维度、卷积核大小、步幅、填充、扩张、组数、丢弃率等。根据输入的维度,选择相应的丢弃层(Dropout),并对输入和输出维度进行了一些验证,以确保它们能够被组数整除。

该类还定义了基础卷积层和归一化层的模块列表,这些模块会根据组数进行初始化。接着,定义了多项式权重和β权重,并使用 Kaiming 均匀分布初始化这些权重,以便在训练开始时能够更好地收敛。

beta 方法用于计算β值,gram_poly 方法用于计算Legendre多项式,利用缓存机制避免重复计算。forward_kag 方法实现了前向传播过程,其中包括对输入进行激活、归一化和卷积操作。最后,forward 方法将输入分成多个组,分别通过 forward_kag 进行处理,并将结果拼接成最终输出。

此外,文件中还定义了三个特定的卷积层类:KAGNConv3DLayer、KAGNConv2DLayer 和 KAGNConv1DLayer,分别用于处理3D、2D和1D数据。这些类通过调用基类 KAGNConvNDLayer 的构造函数,传入相应的卷积和归一化类,简化了多维卷积层的实现。

整体来看,这个文件实现了一个灵活且可扩展的卷积层设计,能够适应不同维度的数据处理需求,同时通过多项式的引入增强了模型的表达能力。

10.4 efficientViT.py

以下是简化后的代码,保留了核心部分,并添加了详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

from timm.models.layers import SqueezeExcite

定义一个用于卷积和批归一化的模块

class Conv2d_BN(torch.nn.Sequential):

def init(self, in_channels, out_channels, kernel_size=1, stride=1, padding=0):

super().init()

# 添加卷积层

self.add_module(‘conv’, torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding, bias=False))

# 添加批归一化层

self.add_module(‘bn’, torch.nn.BatchNorm2d(out_channels))

@torch.no_grad()

def switch_to_deploy(self):# 将训练模式下的BN层转换为推理模式c, bn = self._modules.values()w = bn.weight / (bn.running_var + bn.eps)**0.5w = c.weight * w[:, None, None, None]b = bn.bias - bn.running_mean * bn.weight / (bn.running_var + bn.eps)**0.5m = torch.nn.Conv2d(w.size(1) * self.c.groups, w.size(0), w.shape[2:], stride=self.c.stride, padding=self.c.padding, dilation=self.c.dilation, groups=self.c.groups)m.weight.data.copy_(w)m.bias.data.copy_(b)return m

定义Patch合并模块

class PatchMerging(torch.nn.Module):

def init(self, dim, out_dim):

super().init()

self.conv1 = Conv2d_BN(dim, dim * 4, kernel_size=1)

self.act = nn.ReLU()

self.conv2 = Conv2d_BN(dim * 4, dim * 4, kernel_size=3, stride=2, padding=1, groups=dim * 4)

self.se = SqueezeExcite(dim * 4, .25) # Squeeze-and-Excitation模块

self.conv3 = Conv2d_BN(dim * 4, out_dim, kernel_size=1)

def forward(self, x):# 前向传播x = self.conv3(self.se(self.act(self.conv2(self.act(self.conv1(x))))))return x

定义EfficientViT的基本模块

class EfficientViTBlock(torch.nn.Module):

def init(self, embed_dim, key_dim, num_heads=8):

super().init()

self.dw0 = Conv2d_BN(embed_dim, embed_dim, kernel_size=3, stride=1, padding=1, groups=embed_dim)

self.ffn0 = Conv2d_BN(embed_dim, embed_dim * 2)

self.mixer = Conv2d_BN(embed_dim, embed_dim) # 这里可以替换为注意力机制

self.dw1 = Conv2d_BN(embed_dim, embed_dim, kernel_size=3, stride=1, padding=1, groups=embed_dim)

self.ffn1 = Conv2d_BN(embed_dim, embed_dim * 2)

def forward(self, x):# 前向传播x = self.ffn1(self.dw1(self.mixer(self.ffn0(self.dw0(x)))))return x

定义EfficientViT模型

class EfficientViT(torch.nn.Module):

def init(self, img_size=224, embed_dim=[64, 128, 192], depth=[1, 2, 3]):

super().init()

self.patch_embed = Conv2d_BN(3, embed_dim[0] // 8, kernel_size=3, stride=2, padding=1)

self.blocks = nn.ModuleList()

for ed, d in zip(embed_dim, depth):

for _ in range(d):

self.blocks.append(EfficientViTBlock(ed, key_dim=16, num_heads=4))

def forward(self, x):x = self.patch_embed(x)for block in self.blocks:x = block(x)return x

实例化EfficientViT模型

if name == ‘main’:

model = EfficientViT()

inputs = torch.randn((1, 3, 640, 640)) # 输入的图像张量

res = model(inputs) # 模型前向传播

print(res.size()) # 输出结果的尺寸

代码说明:

Conv2d_BN: 这个类定义了一个卷积层和批归一化层的组合,方便后续使用。

PatchMerging: 该模块用于将输入特征图进行合并,通常用于图像的下采样。

EfficientViTBlock: 这是EfficientViT的基本构建块,包含了卷积层和前馈网络。

EfficientViT: 这是整个模型的定义,包含了多个EfficientViTBlock和一个初始的卷积层用于嵌入输入图像。

主程序: 在主程序中实例化了模型并进行了前向传播,输出了结果的尺寸。

这个程序文件 efficientViT.py 实现了一个高效的视觉变换器(Efficient Vision Transformer,EfficientViT)模型架构,主要用于图像分类等下游任务。文件的结构包括多个类和函数,下面是对其主要部分的讲解。

首先,文件导入了必要的库,包括 PyTorch 和一些用于构建模型的层。EfficientViT 模型是通过多个模块构建的,每个模块负责不同的功能,比如卷积、注意力机制和前馈网络等。

Conv2d_BN 类是一个自定义的卷积层,结合了卷积和批归一化(Batch Normalization)。它在初始化时创建一个卷积层和一个批归一化层,并对批归一化的权重进行初始化。switch_to_deploy 方法用于在推理阶段将卷积和批归一化层融合,以提高推理效率。

replace_batchnorm 函数用于替换模型中的批归一化层为恒等映射,以便在推理时提高效率。

PatchMerging 类实现了将特征图进行合并的操作,通常用于在不同的分辨率之间进行转换。它使用了多个卷积层和激活函数,结合了 squeeze-and-excitation(SE)模块来增强特征表示。

Residual 类实现了残差连接,允许输入直接加到经过处理的输出上,以缓解深层网络中的梯度消失问题。

FFN 类实现了前馈神经网络,包含两个卷积层和一个激活函数,通常用于特征的非线性变换。

CascadedGroupAttention 和 LocalWindowAttention 类实现了不同类型的注意力机制。前者是级联的组注意力,后者是局部窗口注意力。它们都使用了自定义的卷积层来计算查询、键和值,并通过注意力机制来加权特征。

EfficientViTBlock 类是 EfficientViT 的基本构建块,结合了卷积、前馈网络和注意力机制。它根据指定的类型选择不同的注意力机制。

EfficientViT 类是整个模型的核心,负责将输入图像通过多个阶段进行处理。每个阶段由多个 EfficientViTBlock 组成,并通过 PatchMerging 进行特征图的合并。模型的输入分辨率和嵌入维度等参数在初始化时被设定。

在文件的最后部分,定义了一些模型配置,如 EfficientViT_m0 到 EfficientViT_m5,这些配置包含了不同的模型参数设置。

EfficientViT_M0 到 EfficientViT_M5 函数用于创建不同配置的 EfficientViT 模型,并支持加载预训练权重和批归一化层的替换。

update_weight 函数用于更新模型的权重字典,确保加载的权重与模型的结构相匹配。

最后,在 main 块中,创建了一个 EfficientViT_M0 模型实例,并对一个随机生成的输入进行前向传播,输出每个阶段的特征图的尺寸。

总体来说,这个文件实现了一个灵活且高效的视觉变换器模型,适用于各种计算机视觉任务。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻