中国电信清华:大模型驱动的具身智能发展与挑战综述

- 作者:白辰甲1,2^{1,2}1,2,许华哲3^{3}3,李学龙2,1^{2,1}2,1

- 单位:1^{1}1中国电信人工智能研究院上海,2^{2}2中国电信人工智能研究院北京,3^{3}3清华大学交叉信息学院

- 论文标题:大模型驱动的具身智能:发展与挑战

- 出版信息:中国科学:信息科学 2024年第54卷第9期:2035–2082

- 论文链接:https://www.sciengine.com/SSI/doi/10.1360/SSI-2024-0076

主要贡献

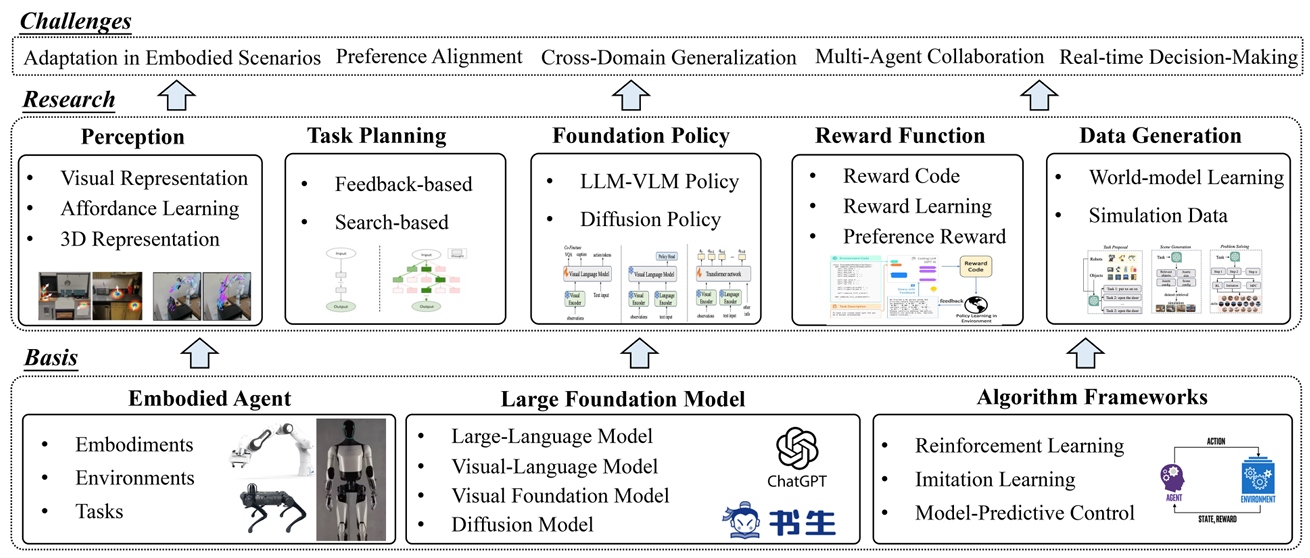

- 文章全面回顾了大模型和具身智能的相关技术背景,包括具身智能的基本概念、学习框架以及大模型技术。

- 将大模型驱动的具身智能研究分为五大范式:环境感知、任务规划、基础策略、奖励函数和数据生成,并对每类研究进行了详细分析。

- 总结了大模型驱动的具身智能面临的五大挑战,并对未来的研究方向提出了展望,为相关研究人员提供了参考。

引言

具身智能的背景

- 定义:具身智能(embodied AI)是人工智能、机器人学和认知科学的交叉领域,主要研究如何使机器人具备类似人类的感知、规划、决策和行为能力。

- 历史:具身智能可以追溯到20世纪50年代,艾伦·图灵首次提出具身智能的概念,探索如何使机器感知和理解世界,并作出相应的决策和行动。80年代,罗德尼·布鲁克斯等研究者认识到智能应通过与环境的主动交互获取,强调机器人应主动适应环境。

- 特点:具身智能强调感知 - 运动回路(perception-action loop),使用物理实体感知和建模环境,根据任务目标和实体能力进行规划和决策,最后通过实体的运动能力完成任务。具身智能在研究中更多体现智能的理念,融合了视觉、语言、决策等多方面的技术来提升智能体的通用型和泛化性。

大模型技术的发展

- 大语言模型:近年来,以ChatGPT为代表的大语言模型(LLM)取得了突破性进展,通过在大规模网络对话数据中学习,能够实现自动问答、文本分类、自动文摘、机器翻译等任务,并具有较强的泛化能力。

- 视觉基础模型:视觉基础模型(VFM)通过自监督学习目标获得强大的视觉编码器,能够解决图像分类、语义分割、场景理解等视觉感知任务。

- 视觉 - 语言模型:视觉 - 语言模型(VLM)通过引入预训练视觉编码器和视觉 - 语言模态融合模块,使大语言模型能够获取视觉输入,并根据语言提示进行视觉问答。

- 多模态大模型:多模态大模型(LMM)通过引入更多模态(如视频、音频、肢体语言等),分析更丰富的传感器输入并进行信息融合,帮助解决更复杂的具身智能任务。

大模型对具身智能的推动

- 提升数据效率和泛化能力:大模型通过充分利用大规模数据集中学习到的知识,结合特定的具身智能场景和任务描述,为智能体提供环境感知和任务规划的能力,从而提升现有具身智能框架(如模仿学习、强化学习、模型预测控制等)的数据效率和泛化能力。

- 结合经典框架:大模型能够与具身智能的经典框架结合,克服现有框架面临的问题。例如,在模仿学习中,大模型能够作为基础策略,利用其对环境的理解和泛化能力;在强化学习中,大模型能够生成合适的奖励函数;在模型预测控制中,大模型能够构建环境模型。

本文的研究重点和目标

- 研究领域:本文围绕大模型驱动的具身智能这一研究领域,从环境感知、任务规划、基础策略、奖励函数和数据生成等五个方面进行了系统的调研、分析和展望。

- 技术背景:回顾了大模型和具身智能的相关技术背景,包括具身智能的基本概念、学习框架以及大模型技术。

- 挑战与展望:总结了大模型驱动的具身智能面临的挑战,并对未来的研究方向提出了展望,为相关研究人员提供参考,进一步推动国家人工智能发展战略。

背景

具身系统基本概念

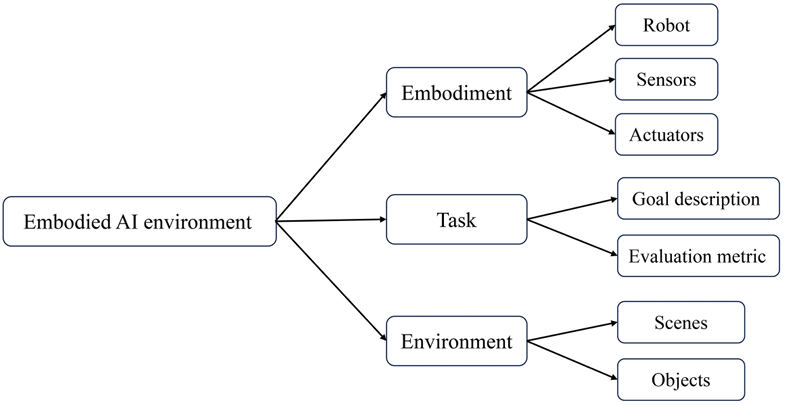

具身智能系统的基本结构如图所示,主要包括实体、任务和环境三个部分。具身实体是系统的核心,主要包括机器人、传感器和执行器。机器人通过传感器获取环境的感知信息,随后由具身智能算法产生当前合适的动作,将动作传输给执行器,执行器产生底层机器人指令与环境进行交互,获得环境的反馈和更新后的场景感知信息,循环进行上述过程。

具身实体

具身实体是具身智能系统的核心,主要包括机器人、传感器和执行器。不同的机器人类型决定了具体可以使用的传感器和执行器类型。常见的具身实体包括机械臂、四足机器人、移动机器人、灵巧手和人形机器人。

-

机械臂:

- 用途:用于执行物体操作和抓取任务。

- 常见类型:Franka、xArm、Sawyer、Kuka、UR5等。

- 仿真平台:MuJoCo、Deepmind Control Suite、Franka Kitchen、RoboSuite、ManiSkill等。

- 特点:通过传感器获取环境信息,由算法生成动作,执行器执行动作与环境交互。

-

四足机器人:

- 用途:在复杂地形条件下进行稳定行走、奔跑、跳跃和避障等任务。

- 常见类型:宇树科技开发的Aliengo、Go1、A1等,麻省理工学院研发的MiniCheetah,波士顿动力研发的SpotMini,苏黎世联邦理工学院的Anymal等。

- 特点:需要对不同地形使用不同的运动策略,采集涵盖所有不同地形的数据集较为困难。依赖高度并行化的仿真环境进行算法调优。

-

移动机器人:

- 用途:拓展了固定机械臂的使用场景,通过可移动的底座在自主选择的场景下执行抓取和物体操作任务。

- 示例:Google开发的EveryDay Robot能够完成倒垃圾、清洁桌子、整理房间等任务。

- 特点:使用视觉定位和导航技术,移动机械臂的操作使用大模型驱动的具身智能框架进行训练,有效扩展了机械臂的能力。

-

灵巧手:

- 用途:用于执行复杂的灵巧操作任务。

- 常见类型:Adroit hand、Allegro、Shandow Hand、Realman Hand等。

- 特点:硬件设计要求高,包括电机、丝杠、减速器、驱动控制系统、位置传感器、力传感器、触觉控制等新型部件。仿真平台如Isaac Gym和MuJoCo用于模拟真实世界中的灵巧操作场景。

-

人形机器人:

- 用途:模仿人类外观和行为的机器人,具有全地形行为能力,可以覆盖人类活动的方方面面。

- 发展节点:2000年ASIMO(本田)、2013年Atlas(波士顿动力)、2022年Optimus(特斯拉)等。

- 特点:当前人形机器人硬件本体系统已满足基本需求,但全身运动控制算法的稳定性和泛化性仍需提升。未来有望在医疗保健、军事、娱乐、教育等领域产生应用。

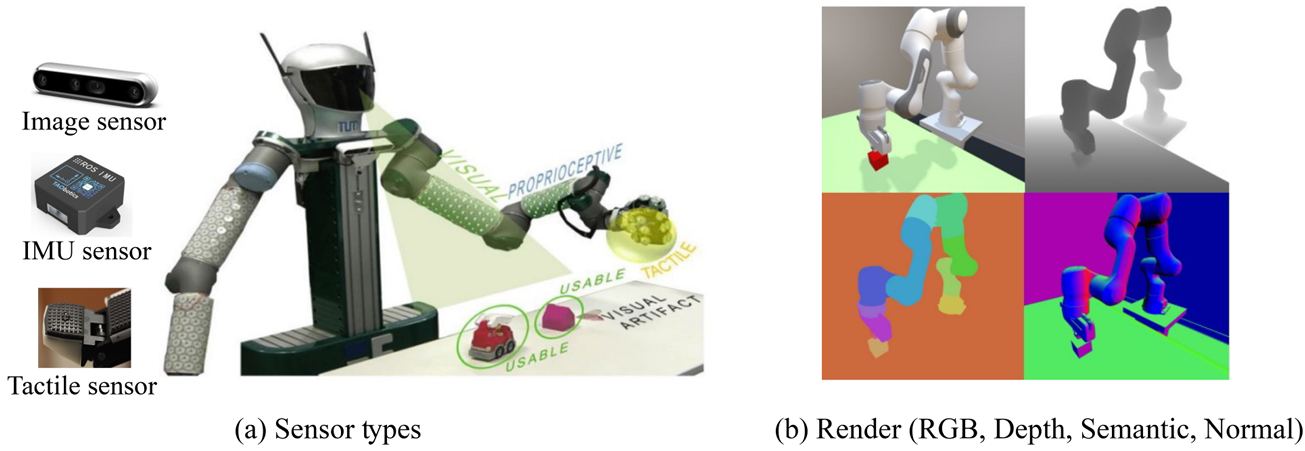

传感器

具身机器人使用的传感器主要包括视觉传感器、机器人本体感知(proprioception)传感器、触觉/力学(haptic/tactile perception)传感器、GPS和IMU传感器等。大模型驱动的具身智能中由于大模型主要用于处理视觉和语言,因此对视觉传感器较为关注。

- 视觉传感器:通过视觉传感器或仿真环境中的视觉渲染功能,可以获得RGB、深度图、语义分割图、点云等视觉输入信息。

- 本体感知传感器:根据机器人类型而有所不同,例如机械臂的本体感知包括各个关节的位置、速度、扭矩和机械臂末端位置等;四足机器人的本体感知信息包括自身线速度、角速度,身体关节位置、力传感器等各种传感器信息。

- 触觉/力学传感器:主要用于灵巧手和人形机器人手部关节中,用于灵巧手感受抓握物体的力度,估计物体的形状等。

- GPS/IMU传感器:在机器人运动中进行定位,多用于移动机器人、人形机器人等。

执行器

根据机器人类型的不同,机器人底层分别采用不同的控制器进行执行。大模型更关注于高层的任务执行和动作选择,底层由传统的执行器进行执行。

- 机械臂:动作输出有关节位置、δ关节位置、末端执行器姿态和δ末端执行器姿态等。通过控制器驱动相应电机来进行关节位置、速度、扭矩的调整,从而执行相应的动作。

- 四足机器人:动作一般为足部关节的位置,通过PD控制器来产生相应的电机扭矩。

- 灵巧手:动作一般为手指关节的力矩、手腕的位置、方向等,随后转换为关节扭矩进行执行。

- 人形机器人:拥有更多的关节和更高的自由度,一般采用多个控制器分别控制手部关节、双臂系统、腿部关节、躯干等。

具身智能学习框架

具身智能的策略学习问题可以描述为马尔科夫决策过程(MDP),表示为 M=(S,O,A,P,r,L)M = (S, O, A, P, r, L)M=(S,O,A,P,r,L),其中:

- OOO 表示观测空间,包含机器人传感器的输入,如视觉观测、本体感知、触/力传感、定位信息等。

- SSS 表示状态空间,由历史观测和当前观测通过感知学习方法获取。

- AAA 表示动作空间,不同机器人的动作空间定义不同,如机械臂末端姿态或关节位置等。

- P(s′∣s,a)P(s′|s, a)P(s′∣s,a) 表示状态转移函数,由机器人动力学和环境决定。

- r(s,a)r(s, a)r(s,a) 表示奖励函数,用于衡量动作执行后下一个状态的好坏。

- LLL 表示任务描述空间,通常使用自然语言描述任务,方便大模型进行理解和规划。

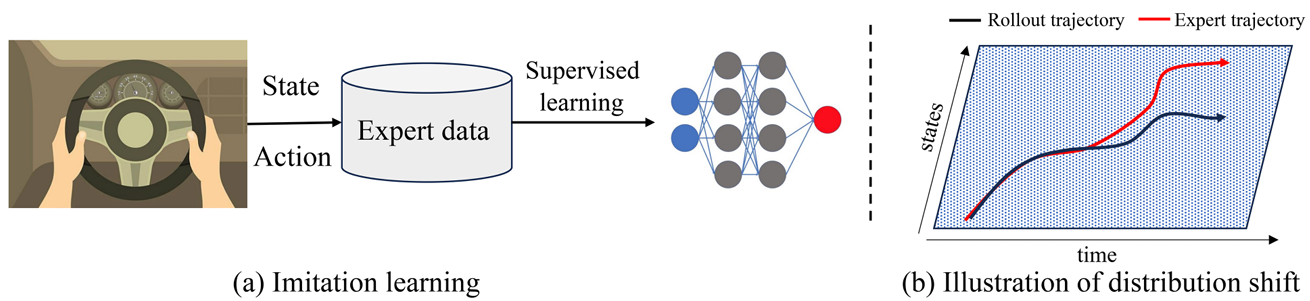

模仿学习

模仿学习(Imitation Learning, IL)是具身智能学习框架中最直接的方法之一,其核心思想是通过模仿专家(通常是人类)的行为来学习策略。模仿学习的主要方法包括行为克隆(Behavior Cloning, BC)和逆强化学习(Inverse Reinforcement Learning, IRL)。

-

行为克隆(BC):

- 定义:行为克隆是最简单的模仿学习方法,通过直接从专家轨迹数据中学习策略。专家轨迹数据集表示为 D={τi,li}i∈[N]D = \{\tau_i, l_i\}_{i \in [N]}D={τi,li}i∈[N],其中 τi=[s0,a0,s1,a1,…,sT]\tau_i = [s_0, a_0, s_1, a_1, \ldots, s_T]τi=[s0,a0,s1,a1,…,sT] 代表专家轨迹,lil_ili 代表任务描述。

- 损失函数:行为克隆的损失函数为:

L(θ)=−E(τ,l)∼D[∑t=0T−1logπθ(at∣st,l)] L(\theta) = -\mathbb{E}_{(\tau, l) \sim D} \left[ \sum_{t=0}^{T-1} \log \pi_\theta(a_t | s_t, l) \right] L(θ)=−E(τ,l)∼D[t=0∑T−1logπθ(at∣st,l)] - 优点:不需要建模环境的状态转移,直接从专家数据中学习策略。

- 缺点:存在分布偏移问题,即在任务执行中遇到的新状态与专家数据集中的状态差距较大时,策略会产生不可预估的动作。

-

逆强化学习(IRL):

- 定义:逆强化学习旨在从观察到的智能体行为中推断出其背后的潜在目标或奖励函数。早期的逆强化学习方法为边际类算法,旨在从专家演示中学习奖励函数,获得与专家策略相近的策略。

- 方法:包括最大熵逆强化学习、相对熵逆强化学习、贝叶斯逆强化学习等。在深度学习背景下,结合神经网络的感知力和强化学习的决策力提出了基于神经网络的逆强化学习方法。

- 优点:能够从专家行为中学习到奖励函数,从而在没有明确奖励信号的情况下做出智能决策。

- 缺点:需要大量的专家数据,且学习过程较为复杂。

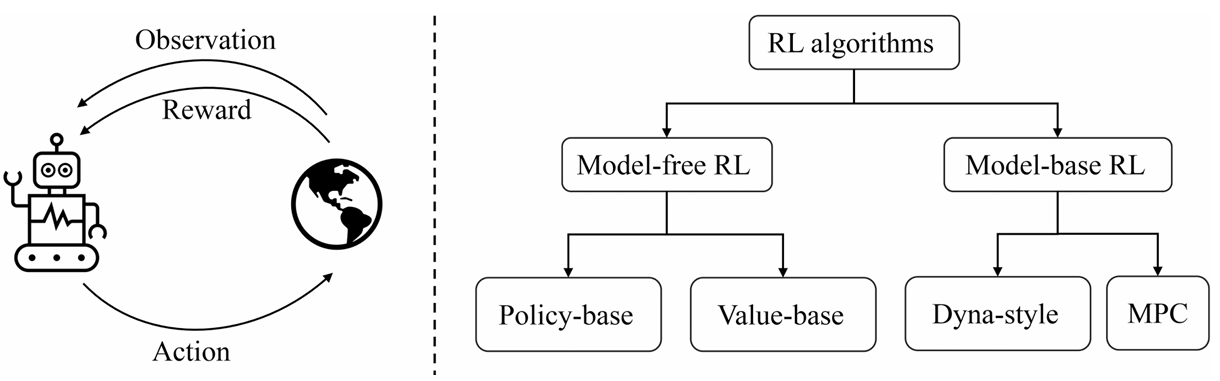

强化学习

强化学习(Reinforcement Learning, RL)的目标是通过智能体与环境的交互来最大化奖励。在时间步 ttt,智能体根据当前环境的状态 sts_tst 来选择动作 ata_tat,环境通过执行该动作得到下一个状态 st+1s_{t+1}st+1,并反馈给智能体一个奖励信号 rt+1r_{t+1}rt+1。

-

回报定义:

Rt=rt+γrt+1+γ2rt+2+…+γT−t−1rT R_t = r_t + \gamma r_{t+1} + \gamma^2 r_{t+2} + \ldots + \gamma^{T-t-1} r_T Rt=rt+γrt+1+γ2rt+2+…+γT−t−1rT

其中,奖励权重随着时间步以 γ\gammaγ 的速度衰减。 -

值函数:

Qπ(s,a)=Eπ[Rt∣st=s,at=a] Q^\pi(s, a) = \mathbb{E}_\pi [R_t | s_t = s, a_t = a] Qπ(s,a)=Eπ[Rt∣st=s,at=a]

表示从状态 sss 和动作 aaa 出发,按照策略 π\piπ 选择动作,在整个周期结束时获得的回报的期望。 -

算法分类:

- 值函数学习:如Q-learning,通过时序差分(TD)估计法更新值函数。

- 策略学习:如策略梯度法,通过求解策略的梯度来优化策略。

- 基于模型的方法:如Dyna-Q,通过建立环境模型进行规划。

- 离线强化学习:利用已有的数据集进行学习,解决在线交互代价较高的问题。

模型预测控制

模型预测控制(Model Predictive Control, MPC)通过使用环境模型产生对未来策略执行情况的预测,结合策略搜索方法获得当前最优的动作。

-

基本原理:

(at,…,at+H−1)=argmaxat,…,at+H−1∑t′=tt+H−1γt′−tr(st′,at′) (a_t, \ldots, a_{t+H-1}) = \arg \max_{a_t, \ldots, a_{t+H-1}} \sum_{t'=t}^{t+H-1} \gamma^{t'-t} r(s_{t'}, a_{t'}) (at,…,at+H−1)=argat,…,at+H−1maxt′=t∑t+H−1γt′−tr(st′,at′)

智能体执行第一步的动作 ata_tat,然后再次使用规划方法得到下一步的最优规划动作。 -

方法:

- 随机打靶法:通过随机采样动作序列来帮助智能体决策。

- 交叉熵方法(CEM):通过调整动作采样的分布,提高采样效率。

- 集成概率轨迹采样法(PETS):结合概率环境模型和轨迹采样,实现与无模型强化学习方法接近的效果。

大模型技术

大模型技术是具身智能的重要推动因素,主要包括大语言模型、视觉基础模型、视觉-语言模型和生成式大模型。这些模型通过在大规模数据上进行预训练,能够学习到丰富的知识和特征表示,从而提升具身智能系统的感知、推理和决策能力。

大语言模型

定义与应用:大语言模型(LLM)通过在大规模文本数据上进行预训练,能够实现自然语言理解和生成任务。这些模型在具身智能中可以用于任务描述、规划和决策支持。

-

发展历程:

- 早期模型:如n-gram语言模型、循环神经网络(RNN)、卷积神经网络(CNN)等,这些模型通过条件概率分布进行建模,能够挖掘词之间的长序列依赖关系。

- Transformer架构:2018年提出的BERT模型使用双向Transformer结构,通过掩码预测和未来句子预测等自监督任务进行预训练,在自然语言处理任务中取得了巨大提升。

- GPT系列:OpenAI的GPT-3模型使用更多的参数量进行预训练,能够处理更长的上下文序列,具有零样本的泛化能力。

- ChatGPT:通过基础语言模型预训练、指令微调和人类偏好强化学习优化,能够生成符合人类偏好的回答,避免有害回答的产生。

-

具身智能中的应用:

- 任务规划:大语言模型能够根据任务描述生成逐步的规划指令,帮助机器人完成复杂任务。

- 决策支持:通过理解任务描述和环境信息,大语言模型能够提供决策支持,帮助机器人选择最优动作。

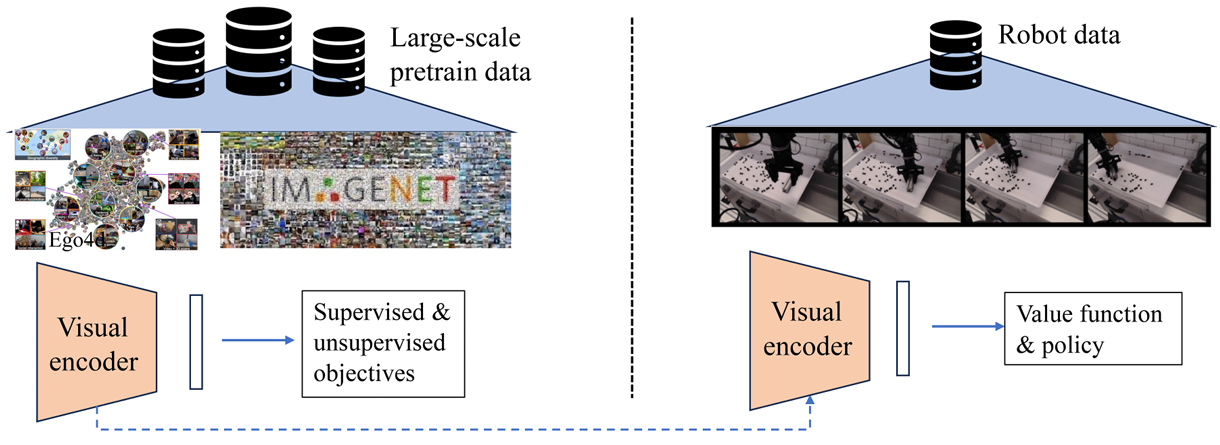

视觉基础模型

定义与应用:视觉基础模型(VFM)通过自监督学习目标提取图像特征,能够解决图像分类、语义分割、场景理解等视觉感知任务。这些模型在具身智能中可以用于环境感知和物体识别。

-

常见模型:

- 卷积神经网络(CNN):如ResNet,通过卷积层提取图像特征。

- 视觉Transformer(ViT):通过Transformer架构提取图像特征,能够处理更复杂的视觉任务。

-

自监督学习:

- MAE(Masked Autoencoders):通过掩码后的视觉输入还原原始图像,从大量无标记图像中进行预训练。

- CLIP:使用大量配对的图像和文本描述进行训练,能够学习图像的语义特征,用于图像和文本的匹配任务。

-

具身智能中的应用:

- 环境感知:视觉基础模型能够对环境进行感知,提取有用的视觉特征,帮助机器人理解环境。

- 物体识别:通过预训练的视觉模型,机器人能够识别和定位环境中的物体,为后续的操作提供支持。

视觉-语言模型

定义与应用:视觉-语言模型(VLM)融合了视觉基础模型和大语言模型,能够同时处理图像和语言输入。这些模型在具身智能中可以用于图像问答、任务描述理解和多模态决策。

-

常见模型:

- SimVLM:提出了一种编码-解码的结构,将图像和文本输入编码器,从解码器中输出后续文本或回复。

- BLIP2:使用预训练的图像编码器提取特征,通过QFormer结构从冻结的编码器中提取视觉特征,将提取的特征经过线性投影后和语言指令作为大语言模型的输入。

- Flamingo:使用少量例子作为输入使模型具备少样本泛化能力,能够根据语言指令和图像信息产生输出。

-

具身智能中的应用:

- 图像问答:视觉-语言模型能够根据图像和语言指令进行问答,帮助机器人理解任务要求。

- 多模态决策:通过融合视觉和语言信息,视觉-语言模型能够生成更准确的决策指令,提升机器人的任务执行能力。

生成式大模型

定义与应用:生成式大模型(如扩散模型)能够生成高质量的图像、视频和文本内容。这些模型在具身智能中可以用于数据增强、环境模拟和策略生成。

-

扩散模型:

- 原理:通过前向的噪声扩散过程将真实图像转化为高斯噪声,再通过逆向的去噪过程恢复出原始图像。

- 应用:在具身智能中,扩散模型可以用于生成机器人交互环境、动作规划和数据增强,缓解真实机器人任务中数据稀缺的问题。

-

多模态生成大模型:

- DALL-E:通过大规模预训练,学习文本和图像之间的复杂关系,能够根据文本描述生成高质量图像。

- Video-LaVIT:通过自回归方式预测下一个图像或文本词元,同时引入音频来对齐视听信号,增强对视频的整体理解。

-

具身智能中的应用:

- 数据增强:生成式大模型可以生成大量的训练数据,提升机器人的学习效率和泛化能力。

- 环境模拟:通过生成虚拟环境,机器人可以在仿真环境中进行训练,减少在真实环境中的试错成本。

- 策略生成:生成式大模型可以生成动作规划和策略,帮助机器人完成复杂任务。

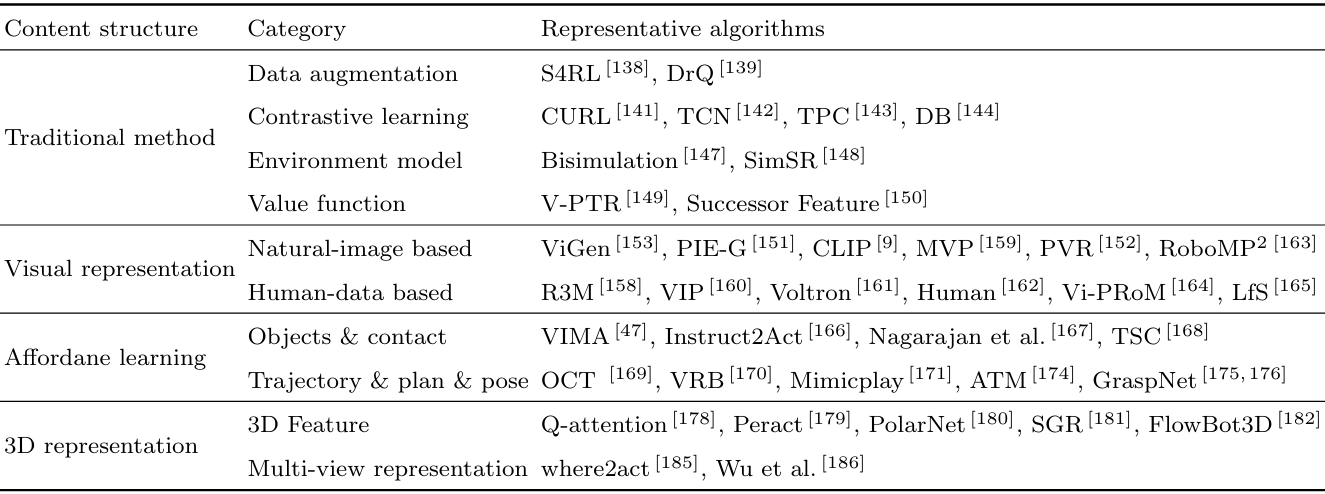

大模型驱动的具身环境感知

图像观测特征学习

在具身智能任务中,智能体对周围环境的观测主要以视觉信息呈现。传统的视觉观测特征提取方法存在一些局限性,例如在新的环境和任务中需要重新训练,且泛化能力较差。为了克服这些局限性,近期的研究引入了预训练的视觉表征模型,以提升表征的泛化性和鲁棒性。

-

预训练表征:

- PIE-G:通过预训练的ResNet编码器对视觉观测进行编码,使用编码后的向量学习值函数和策略,显著提升了策略的视觉泛化能力。

- R3M:专为机械臂操作任务设计的预训练视觉提取器,使用ResNet作为基本结构,通过视频序列的时序关系和语言-视频的相关关系构造对比学习损失,在大规模Ego4D数据集中进行训练,能够提取机械臂操作相关的可迁移知识。

- VIP:在人类数据集上学习表征,将表征学习问题转换为目标导向的强化学习问题,通过对比学习实现了隐式的值函数学习,在下游任务中能同时产生状态表征和值函数估计。

- Voltron:使用MAE学习目标从掩码图像中恢复原始图像,从中学习低层次的语义特征。同时,使用掩码上下文图像信息预测视频对应的文本描述,从而获取高层的人类意图相关特征。

- Huo等:从人类交互数据中进行状态变化分类、时序定位、目标检测、手部检测等任务的构造,通过学习这些辅助任务来获得有意义的表征。

- RoboMP2:通过微调多模态大模型实现基于物体属性、空间关系和知识推理的物体定位,从而根据定位产生规划。

-

人类交互数据:

- Ego4D、Epic-Kitchen、Something-something:这些数据集包含大量人类操作视频,涵盖了人类日常生活中场景的物体类型和交互方式,同时具有语言标注。这些数据集与机械臂操作视频具有很大的相似性,容易学习到可迁移的表征。

-

对比学习:

- CURL:使用状态的图像增强作为正样本,随机采样的状态作为负样本,学习轨迹时序或状态转移相关的特征。

- TCN:使用相邻时间步的状态观测作为正样本,随机采样的状态作为负样本,学习状态转移相关的特征。

- TPC:使用环境状态转移作为正样本,随机采样的状态作为负样本,学习状态转移相关的特征。

- DB:使用随机采样的两个状态作为负样本,学习状态之间的区分能力。

-

环境模型:

- 互模拟(Bisimulation):构造了一个表征空间,希望在表征空间中两个状态的特征距离正比于奖励映射后的距离和环境转移模型映射后的距离,能够提升强化学习的样本效率。

- SimSR:将互模拟表征扩展到离线强化学习中,通过表征学习提升样本效率。

-

值函数学习:

- V-PTR:通过从离线数据集中学习值函数的预测来获取有意义的视觉表征。

- Successor表征:隐式地使用值函数学习估计长期环境转移导致的状态概率密度。

Affordance提取

Affordance是指物体的功能特性,即物体“怎样使用”的性质。在机器人任务中,获取物体的Affordance能够为机器人提供直观的提示,避免完全通过尝试解决任务。

-

Affordance表示:

- VIMA、Instruct2Act:使用预训练的目标检测器对场景中的物体进行检测,随后将分割出的物体区域进行编码作为策略的输入。这些方法仅获取了粗粒度的物体位置信息,而缺乏“怎样使用”物体这些细粒度的信息。

- Nagarajan等:从人类操作视频中挖掘物体的Affordance,通过构建预测模型来预测一系列动作(如可推拉、可拿起、可倾倒等),随后将预测模型用于估计非活动对象是如何进行交互的。

- TSC:通过在人类操作视频中检测人手、交互对象和接触状态来提供监督信号,随后屏蔽手部位置构建预测模型对监督信号进行建模,从而对静止操作物体产生接触点和作用方式的预测。

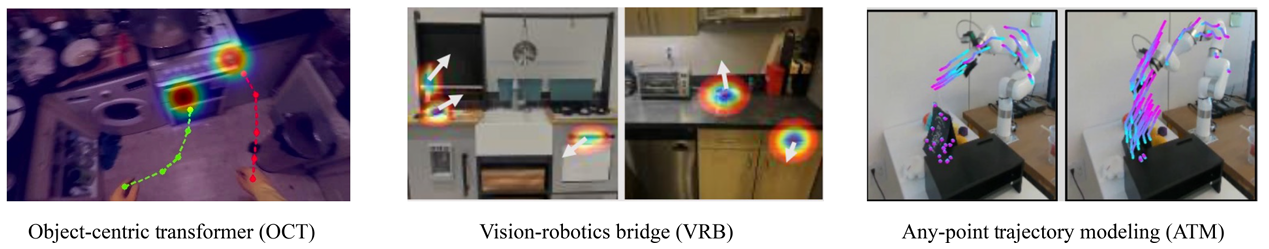

- OCT:从人类交互视频中同时学习人手轨迹和人手与物体未来的接触点,并提出了一种自动化方法来对大量视频数据进行标记,构建了以目标为中心的Transformer结构来对这些信息进行建模。

- VRB:使用类似的思路,从人类第一视角的数据中预测人手和物体的接触点,以及在接触后对物体操作的方向,并将这些知识成功地迁移到实体机器人中。

- Mimicplay:通过人类示教数据来检测人手操作物体的轨迹,并将该轨迹作为隐式的规划结果迁移到机器人策略中,从而引导机器人解决长周期的复杂决策任务。

- ATM:构建了更加精细的轨迹预测模型,不仅检测视频中机械臂/人手和物体接触点的运动轨迹,而且可以直接预测视频帧内任意点的未来轨迹,从而为机械臂操作提供更详细的控制指导。

-

6D抓取位姿:

- GraspNet:提出了一个大规模6D姿态抓取数据集,包含190个杂乱和复杂的场景,对总计97280张图像中的所有对象进行了精确6D姿势和密集抓取姿势的标记,包含88个物体和超过11亿个抓握姿势。在大规模数据集的基础上,可以通过监督学习方法估计6D抓取位姿,从而有效的结合机械臂自身底层规划控制来完成抓取任务。

3D视觉表征提取

在机械臂、移动机器人和人形机器人任务中,仅使用2D图像作为输入往往难以处理复杂场景中的抓取问题。因此,需要提取3D视觉表征来更好地表示复杂场景信息。然而,目前在大模型领域,3D大模型的研究仍处于起步阶段,尚未有在具身智能领域的典型应用。

-

3D输入:

- Q-attention、Peract:使用Perceiver网络对3D体素信息进行特征提取,通过策略的模仿学习损失进行训练,在3D抓取任务中取得了很好的效果。

- PolarNet、SGR、FlowBot3D:使用还原的3D点云作为输入,随后通过PointNet点云特征提取网络进行特征提取,使用策略模仿学习损失进行训练。

-

多视角表征:

- where2act:对机器人抓取中的3D点云输入进行特征提取,为每一个点推断是否是功能部位(如抽屉把手)以及如何对该功能部位进行操作(如垂直把手拉动)。

- Wu等:考虑3D场景的遮挡问题,引入对比学习设计机器人目标条件遮挡场,在学习中忽略不重要的物体,同时保持对重要场景的敏感度,可以推广到具有许多新颖遮挡物组合的场景。

大模型驱动的具身任务规划

开环和闭环反馈

大语言模型(LLM)在大规模语言数据中训练后,对现实世界环境和机器人任务具有丰富的高层次先验知识。例如,在服务机器人中,面对“如何倒一杯牛奶”的任务,大语言模型能够对任务进行分解并给出规划:1. 从冰箱中拿出牛奶;2. 拧开牛奶瓶的盖子;3. 找一个杯子;4. 把牛奶倒进杯子中。随后,机器人可以根据底层技能库对大模型任务规划进行顺序执行,从而完成整体的任务。基于大语言模型的具身任务规划有以下的特性:

- 思维链能力:大语言模型能够利用思维链能力对复杂任务进行逐步分解。

- 自然语言描述的规划:大语言模型生成的规划是自然语言描述的,需要有执行语言指令的机器人底层技能库。

- 上下文信息:大语言模型需要对场景信息有充分的描述并作为提示(prompt),需要充分的上下文信息来指导决策。

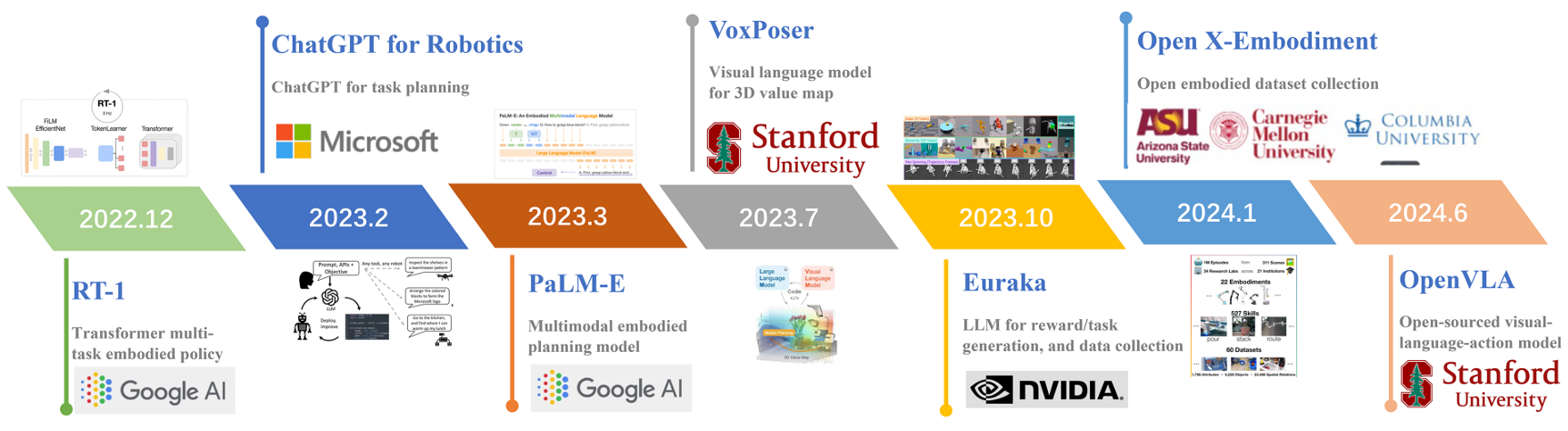

微软推出的 ChatGPT for Robotics 是大模型用于机器人规划的典型应用。该方法在 prompt 中对任务信息和机器人能够执行的操作函数进行详细描述,包括每个机器人底层函数的定义和能够执行的任务。大语言模型根据任务描述和底层技能库依次调用相应的函数来完成任务,能够在机械臂、无人机等实体上应用。

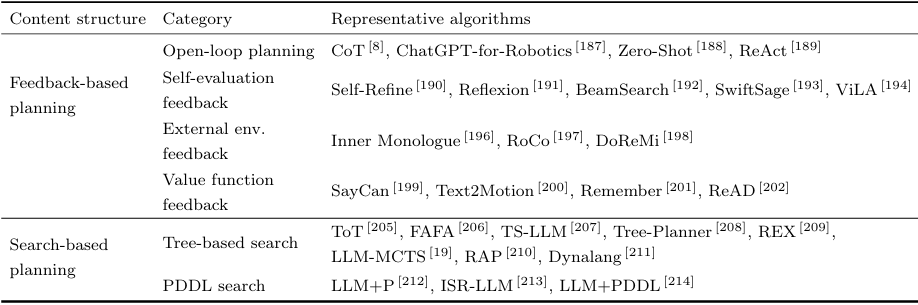

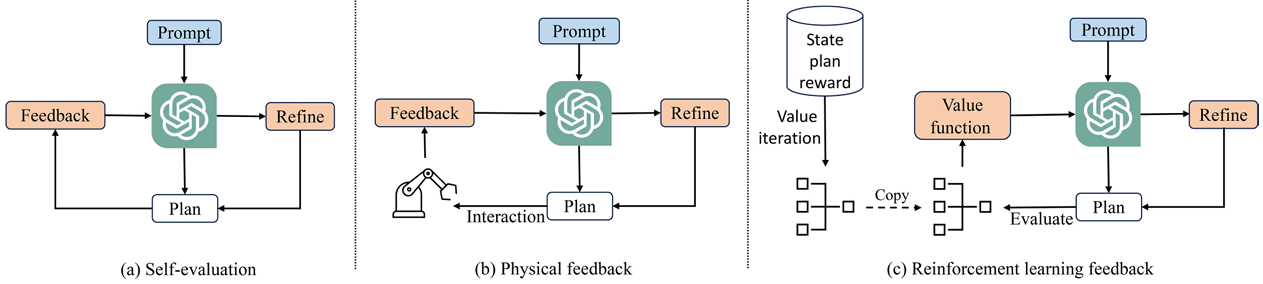

然而,开环任务规划容易出现大模型规划和现实世界不匹配的问题。例如,当询问大模型该如何打扫卫生时,大模型的第一步可能是“去拿吸尘器”,但可能屋子里只有扫帚可以作为清洁工具,导致大语言模型的规划无法执行。为了解决这一问题,可以引入闭环反馈机制,主要分为以下三类:

-

大模型自我反馈:

- Self-Refine:使用大语言模型自身对规划结果进行评价和改进。通过多轮迭代,不断提升规划的合理性。

- Reflexion:设计了多种反馈机制,包括使用大语言模型对自身规划的反思和评价,同时设计了长期记忆模块将评价的结果进行存储。Reflexion 的过程类似于强化学习,大语言模型规划器可以看作 Actor,而评价器作为 Critic。

- BeamSearch:将大语言模型反思引入随机集束搜索中,使用集束搜索解决长序列决策问题。在每个时间步,引入大语言模型进行反馈,从中选择当前最好的搜索结果进行扩展,从而提升集束搜索的效率。

- SwiftSage:同时使用小语言模型和大语言模型,通过离线模仿学习直接模仿得到策略,从而进行快速决策。在最终决策时,设计启发式算法灵活选择小模型或大模型进行决策。

-

外部环境反馈:

- Inner Monologue:在机械臂操作任务中利用不同的感知模型设计多种反馈,包括碰撞检测、场景描述反馈、是否成功的反馈等。例如,机械臂在打开柜子失败后,外部感知模型会检测到失败并告知上次打开柜门失败的原因,随后大模型根据反馈结果进行重新规划。

- RoCo:提出了在基于环境反馈和智能体沟通的多智能体协作框架,使用仿真环境的碰撞检查器对机械臂规划路径进行合理性检测,同时对合作智能体在每个时间步的目标完成情况进行反馈,帮助智能体进行错误纠正和反思。

- DoReMi:引入了一个额外的视觉语言模型作为检查器,在执行大模型规划的每个时间步检查当前的场景是否满足约束。例如,在“如何倒一杯牛奶”的任务中,视觉语言模型会检查桌子上是否有牛奶来判断上一步是否执行成功。如果没有成功则检查器打断执行,对错误规划进行快速纠正。

-

强化学习反馈:

- SayCan:通过引入强化学习中值函数的概念,对智能体的底层调用技能进行策略学习的同时学习动作的值函数。在最终决策中,综合考虑大语言模型输出的动作和动作值函数的大小,从而避免输出不合理的动作。

- Text2Motion:在机械臂任务执行时提出了几何可行性的概念,在堆叠不同的物体时考虑物体的几何关系。对大语言模型产生的多个可能的规划,检查器分别计算几何可行的概率,并与大模型原始的概率结合作出最终的规划。

- Remember:设计了一个记忆模块,用值函数评估方法对大模型预测的结果计算值函数,将状态-动作-值函数的评价结果作为记忆进行存储。在与环境交互中,对于规划产生的新动作,大模型从记忆中检索相似的状态-动作元组并根据这些元组对应的值函数对规划动作是否能够成功进行估计。

- ReAD:在大模型多智能体协同中引入了强化学习反馈机制,通过序列优势函数评价单个智能体行为在总体的贡献,通过最大化优势函数调整智能体的策略。

规划搜索算法

在长序列决策任务中,每个时间步的规划不仅需要考虑当前时间步的最优性,同时需要考虑由该时间步的动作选择而带来的未来长时间决策的最优性。与强化学习类似,在长周期规划过程中,往往需要牺牲某些时间步的最优性而换取长期的最大回报。在大模型规划中,思维链的输出方式往往更多考虑每个时间步规划的最优性。同时,思维链规划过程中对未来存在隐式的推理流程,但随着周期越长,对未来的规划将会更不可靠。例如,大模型很难通过思维链的方式输出决策周期 T=100T = 100T=100 步的超长动作规划,因为很难判断在较长时间步后环境的变化情况。然而,在具身智能中存在许多具有挑战性的长周期决策任务,例如需要组装许多零件的装配任务、具有严密逻辑关系的决策任务、调度多智能体协作的规划任务等。为了解决具身智能中的长周期决策问题,需要引入规划搜索算法来对未来的可行解进行搜索,从而保证长序列决策周期的最优性。

-

基于树搜索的方法:

- 树搜索的基本原理:遵循蒙特卡洛树搜索(MCTS)的思路,通过构建搜索树,并遵循选择节点、扩展节点、蒙特卡洛搜索估计、回溯更新四个步骤不断扩展搜索树,根据搜索树选择当前状态的最优动作。

- 思维树(Tree of Thoughts, ToT):将思维链通过蒙特卡洛树搜索的思路扩展为“思维树”。在树的每一层使用大语言模型采样来扩展不同的分支节点,在叶子节点处使用启发式的值函数评价方法计算值函数,同时结合深度和广度优先搜索算法进行最优路径搜索。

- FAFA:将大语言模型融入树搜索的框架下,使用强化学习值函数的更新的方法对叶子节点的值函数分布进行估计,同时根据树结构进行值函数回溯计算最优路径。

- TS-LLM:针对在树搜索过程中使用启发式方法对值函数估计不准确的问题,提出使用强化学习值函数估计方法显式的对奖励函数和值函数进行估计,对蒙特卡洛树搜索过程中扩展的叶节点价值进行评价。在经过回溯后,TS-LLM 更新路径节点的值函数,结合深度/广度搜索算法和 MCTS 搜索算法选择最优路径。

- TreePlanner:提升了大语言模型进行树搜索规划的询问效率和搜索效率,能够高效的进行错误纠正。

- REX:在基于大语言模型的蒙特卡洛树搜索过程中重点讨论了如何平衡探索和利用的问题,通过扩展非最优动作节点来保持对环境的探索。

- LLM-MCTS:在 VirtualHome 中利用大语言模型对环境自身的理解能力,使大语言模型同时作为环境模型和策略规划器,并将二者统一到蒙特卡洛树搜索的架构中。

- RAP:引入了强化学习中世界模型的概念,使用大语言模型作为世界模型对下一个状态的分布 p(s′∣s,a,c)p(s′|s, a, c)p(s′∣s,a,c) 的分布进行建模,其中 ccc 为引导大语言模型进行状态预测的上下文。随后,将世界模型融入蒙特卡洛树搜索的过程中,设计了启发式的奖励函数对叶节点进行值函数估计,使用置信区间上界(UCB)算法在扩展节时平衡探索与利用。

- Dynalang:显式的构建了参数化的环境模型来预测未来时间步的环境语言描述和图像观测变化,使用类似 Dreamer 结构将语言融入世界模型的构建中,利用语言包含的丰富的世界描述知识来使环境模型的预测更加准确,同时能够融入视频预测、奖励预测等模块。Dynalang 算法在大规模具身数据集上进行预训练,可以和树搜索方法进行结合。

-

基于 PDDL 语言的搜索:

- PDDL(Planning Domain Definition Language):是一种用于描述规划问题的语言,能够通过任务定义和目标定义,结合谓词和动作定义,在可行空间中搜索达到目标状态的可行解决方案。

- LLM+P:将大语言模型和 PDDL 求解器相结合,大语言模型根据任务描述生成 PDDL 语言描述的问题,随后使用 PDDL 求解器进行规划,最后将 PDDL 规划转换为自然语言进行执行。

- ISR-LLM:在将问题转换为 PDDL 语言后,利用大语言模型自身对 PDDL 的理解能力产生任务规划,随后使用 PDDL 合理性检查和大语言模型自身检查作为反馈,帮助大语言模型改进之前的规划结果。

- LLM+PDDL:使用大语言模型对 PDDL 问题进行自然语言归纳,并编写代码程序进行解决。对于解决情况,大语言模型引入自我反馈机制进行纠正并重复上述过程。

大模型驱动的具身基础策略

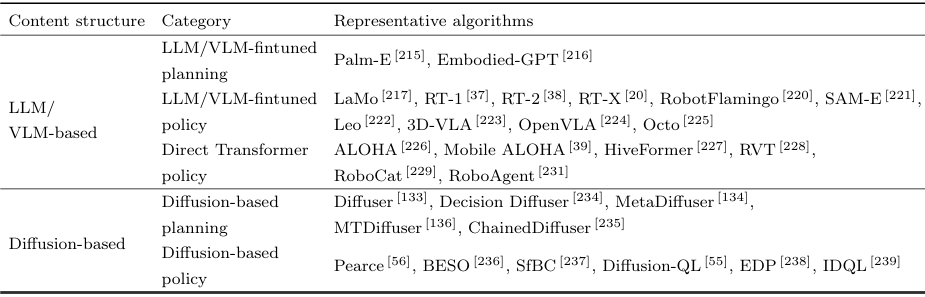

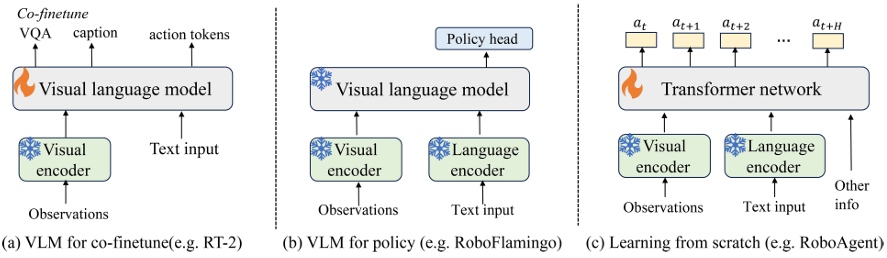

LLM/VLM 驱动的基础策略

大模型(如大语言模型和视觉-语言模型)可以作为基础策略,直接用于具身智能任务的决策和执行。这种方法的核心思想是利用大模型在大规模数据上预训练得到的知识和特征表示,提升具身智能系统在特定任务中的表现。具体方法包括大模型微调的决策规划和大模型微调的策略学习。

-

大模型微调的决策规划:

- Palm-E:Google提出的具身规划大模型,通过将具身智能数据(如状态、图像等)编码到与大语言模型输入相同的潜变量层,然后基于大语言模型的自注意力机制进行处理,最终输出语言描述的任务规划。Palm-E通过端到端的训练,能够处理多模态输入数据,提升策略的视觉泛化能力。

- Embodied-GPT:通过收集基于Ego4D的人类操作问答数据集进行微调,使用轻量级的7B语言模型进行训练。在底层使用模仿学习的方法将单步的规划转换成底层策略进行执行,在Franka Kitchen和Meta-World等测试任务中超过了R3M、BLIP-2等方法。

-

大模型微调的策略学习:

- LaMo:使用小规模GPT-2语言模型作为离线强化学习的基础策略,通过条件模仿学习框架进行训练。使用LoRA(Low-Rank Adaptation)技术对模型参数进行微调,保留大模型自身编码的知识结构,使GPT-2能够适应离线决策任务。

- Robot Transformer (RT) 系列:

- RT-1:使用预训练的EfficientNet-B3网络初始化,以机器人状态和历史图片作为输入,通过EfficientNet特征提取后直接输出动作。RT-1将机器人动作的每个维度均匀离散化,使用监督学习的损失进行训练。

- RT-2:使用更大规模的预训练视觉-语言模型结构,模型参数可以达到55B的规模。RT-2通过预训练的VLM模型中编码的丰富视觉问答知识来帮助具身模型的训练,具有更强的泛化能力。

- RT-X:在RT-2模型的基础上,收集并整理了来自全球60多个实验室的丰富的机械臂数据,覆盖了22个具身实体,527种不同的具身实体类型,共计16万种不同任务。RT-X对场景和任务具备更丰富的理解和泛化能力,同时在动作空间中具有更强的泛化能力。

-

直接策略学习:

- ALOHA:斯坦福大学提出的Transformer编码-解码网络结构,以不同方位的观测图像作为输入,通过解码器直接输出机械臂动作。ALOHA使用动作分块的概念,一次预测多个时间步的动作序列,增强长周期任务中动作预测的整体性。

- Mobile ALOHA:基于ALOHA的移动平台,通过专家示教数据的模仿学习能够完成复杂的菜品制作任务,如滑蛋虾仁、干贝烧鸡、蚝油生菜等。

- HiveFormer:提出了一种3D空间中的机械臂模仿学习架构,以多视角的机器人观测数据作为输入,使用CLIP和Transformer结构进行语言和视觉特征提取和融合,直接预测机器人在6D空间的抓取位姿。

- RoboCat:使用跨实体、跨任务的具身模仿学习框架,在使用VQ-GAN对视觉输入词元化之后,使用标准的DT回归损失根据历史的状态、观测、目标信息对未来的智能体动作和观测进行预测。RoboCat能够生成部分虚拟数据进行训练,提升智能体的能力。

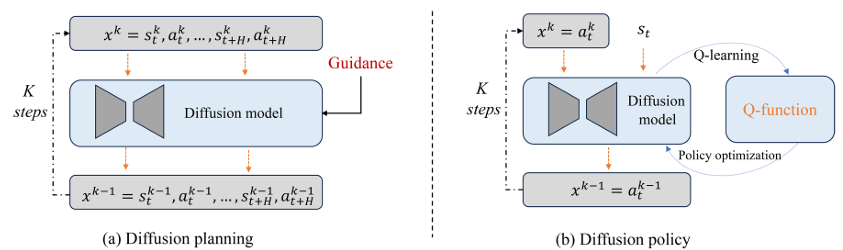

扩散模型驱动的基础策略

扩散模型作为一种生成模型,可以用于建模高维度的决策序列,从而作为基础策略提升具身智能系统的决策能力。

-

基于扩散模型的动作规划:

- Diffuser:一种典型的将扩散模型作为规划器的算法,通过历史轨迹作为条件,使用奖励引导进行轨迹生成,能够根据历史轨迹生成未来的高奖励轨迹规划。

- Decision Diffuser:进一步增强了条件生成的能力,使用无分类器引导的条件生成方法,将回报函数、任务描述、技能描述、约束条件等作为条件进行可控的扩散动作生成,提升了扩散模型在决策任务中的规划能力。

- MetaDiffuser:使用Meta-Learning框架,对任务轨迹使用上下文编码器进行编码,并将编码向量作为条件进行轨迹生成。在测试中,通过将测试任务的示教轨迹进行上下文编码,该模型能够扩展到新任务的轨迹规划中。

- ChainedDiffuser:增强了扩散模型在长序列决策任务规划中的能力,使用层次化的方法首先产生高层任务的规划,随后使用底层扩散过程生成状态到目标规划的动作轨迹。

-

基于扩散模型的策略生成:

- Pearce:在模仿学习框架下使用扩散模型对人类的复杂动作分布进行建模,能够在大规模机器人决策任务中达到更好的效果。

- BESO:在目标导向的模仿学习框架中使用随机微分方程来进行动作建模,同时使用非最优多样化轨迹进行训练。

- SfBC:将策略学习过程分解为基于扩散模型的动作建模和基于强化学习的动作评价,使用值函数加权的重要性采样方法从扩散模型中进行动作选择。

- Diffusion-QL:在强化学习框架下使用扩散模型作为基础策略,使用最大化值函数的学习目标对动作扩散模型进行训练,更好地建模了离线强化学习数据集的动作分布。

- EDP:提出更加高效的动作采样流程,从中间噪声状态可以一步恢复到原始动作,可以和不同的离线强化学习框架结合。

- IDQL:将扩散模型和模仿学习策略进行结合,用于最大化值函数或优势函数,提升离线强化学习的效果。

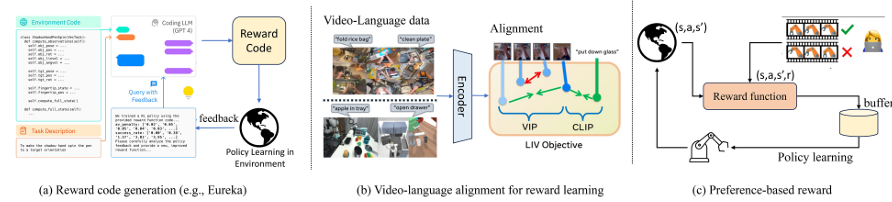

大模型驱动的具身奖励函数

在具身智能中,奖励函数是强化学习算法的核心组成部分,用于衡量智能体在环境中采取动作后的效果。设计一个有效的奖励函数对于智能体的学习至关重要,但通常需要大量的先验知识和调试工作。大模型(如大语言模型和视觉-语言模型)可以通过对环境和任务的理解自动生成或优化奖励函数,从而简化这一过程。

奖励函数代码生成

大模型可以生成奖励函数的代码,直接用于强化学习算法。这种方法的核心思想是利用大模型对环境和任务的理解,自动生成能够反映任务完成度的奖励函数。

- VoxPoser:使用大语言模型生成奖励函数的代码。首先,根据任务的语言描述,使用视觉检测模型对场景中感兴趣的物体进行定位。随后,VoxPoser对可能产生奖励的物体和可能产生危险的物体分别对待,在3D机器人操作空间内生成奖励图和约束图,得到最终价值分布图。在模型预测控制(MPC)中,可以使用现有的运动规划器在价值分布图中规划一条无碰撞的最优路线进行执行。

- Text2Reward:利用大模型对环境的理解能力编写奖励函数定义的代码。通过提供场景描述、环境介绍、奖励函数例子等作为提示,大语言模型能够根据任务要求生成完成该任务的密集奖励函数。强化学习算法根据大模型产生的奖励函数进行策略训练,在环境中进行交互产生轨迹,人类通过观察交互轨迹给出反馈,大模型根据反馈提升现有的奖励函数设计。

- Eureka框架:英伟达提出的奖励生成框架,能够和英伟达的高效并行仿真环境Omniverse进行结合,对自定义的任务进行奖励函数生成。Eureka利用GPT-4中更为强大的任务规划能力、代码编写能力和反馈优化能力,以环境的代码定义和任务描述作为提示直接产生任务的奖励函数。随后,使用强化学习算法对奖励函数进行策略优化,根据策略的执行结果对GPT-4进行反馈,GPT-4分析原因并改进奖励函数中不合理的部分。在多个复杂的机械臂和灵巧手操作任务中的实验结果表明,Eureka具有强大的奖励函数编写能力,能够根据结果反馈不断地改进奖励函数设计,取得了超越人类专家的效果。

- DeepMind的近似工作:将大模型生成奖励函数用于更加复杂的四足机器人运动控制中,为四足机器人的各种技能学习提供奖励函数,能够驱动四足机器人学习奔跑、跳跃、直立行走等复杂的技能。同时,该方法也能基于人类反馈来对奖励函数的规划进行改进。

奖励函数学习和计算

除了直接生成奖励函数的代码,大模型还可以通过学习和计算来估计奖励函数。这种方法的核心思想是利用大模型对环境和任务的理解,通过学习数据中的模式来估计奖励函数。

-

视频预测模型:

- VIPER:通过对专家给出的大量智能体执行视频轨迹进行学习,构建专家轨迹的条件概率生成模型。使用专家轨迹进行评价时能获得较大的概率估计值,相反,如果当前智能体的策略水平较低,则使用概率密度函数对智能体的交互视频进行评价将得到较低的概率密度。VIPER算法使用从专家轨迹中学习的概率分布对当前智能体的轨迹进行评价,将奖励函数定义为 r=logp(st∣s1:t)r = \log p(s_t | s_{1:t})r=logp(st∣s1:t)。

- Diffusion Reward:使用更为先进的VQ-Diffusion扩散模型对智能体交互视频进行建模,并指出专家轨迹在扩散模型的预测中会呈现出更大的确定性,而非最优轨迹可能更加多样,最终使用扩散模型预测的条件熵来作为奖励。

-

语言-视频匹配模型:

- LIV:通过对比学习和值函数优化在隐空间中对任务的文本描述和任务的交互视频的相似性进行最大化,通过大规模训练得到的文本和视频编码器对任务描述和相应的轨迹视频的相关程度进行判别。在新任务执行时,对新任务的文本描述和当前智能体的视频轨迹相关程度进行度量,能够间接地评价当前智能体轨迹和专家轨迹的相似程度,从而作为智能体的奖励。

-

预训练视觉-语言模型:

- VLM-RM:使用CLIP模型的语言和视觉编码器来判断Humanoid中智能体的行为是否和文本描述一致,并将该度量作为奖励函数。

- LAMP:使用奖励函数 r=Gθ(Fϕ(o1),Fϕ(oi),Lα(x))r = G_\theta(F_\phi(o_1), F_\phi(o_i), L_\alpha(x))r=Gθ(Fϕ(o1),Fϕ(oi),Lα(x)) 作为奖励,其中 FϕF_\phiFϕ 是R3M算法从大规模人类操作数据集中训练出的编码器,GθG_\thetaGθ 衡量了从状态 o1o_1o1 到 oio_ioi 的智能体变化情况和任务描述编码 Lα(x)L_\alpha(x)Lα(x) 的匹配程度,对符合人类专家的轨迹产生较高的奖励。LAMP同时使用了强化学习中由不确定性定义内在激励函数,从而引导智能体高效地探索环境。

偏好驱动的奖励函数

大模型在经过预训练的指令微调后,一个重要的步骤是将大模型的输出和人类的偏好进行对齐,进行人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)。在具身智能中,人类专家或预定义的规则对轨迹偏好进行打分,根据打分结果训练奖励函数模型,随后将奖励函数模型用于强化学习算法训练。

- 偏好数据集:从智能体的离线轨迹数据集中采样两个轨迹片段 τ1\tau_1τ1 和 τ2\tau_2τ2,随后人类对两个轨迹进行比较并根据自身偏好给出偏好标签 y∈{0,1,0.5}y \in \{0, 1, 0.5\}y∈{0,1,0.5},其中 y=1y = 1y=1 代表人类更加偏好轨迹 τ1\tau_1τ1(即 τ1≻τ2\tau_1 \succ \tau_2τ1≻τ2),y=0y = 0y=0 代表 τ1≺τ2\tau_1 \prec \tau_2τ1≺τ2,而 y=0.5y = 0.5y=0.5 则代表两条轨迹拥有相似的偏好。

- Bradley-Terry模型:使用Bradley-Terry模型从偏好数据中学习奖励函数。给定特定具身任务中的偏好数据集 Dτ={(τ1,τ2,y)}D_\tau = \{(\tau_1, \tau_2, y)\}Dτ={(τ1,τ2,y)},奖励函数 r^\hat{r}r^ 通过最大化交叉熵损失函数进行学习:

Lr^=EDτ[ylogP[τ1≻τ2]+(1−y)logP[τ2≻τ1]] L_{\hat{r}} = \mathbb{E}_{D_\tau} [y \log P[\tau_1 \succ \tau_2] + (1 - y) \log P[\tau_2 \succ \tau_1]] Lr^=EDτ[ylogP[τ1≻τ2]+(1−y)logP[τ2≻τ1]]

其中 P[τ1≻τ2]=exp∑tr^(s1t,a1t)exp∑tr^(s1t,a1t)+exp∑tr^(s2t,a2t)P[\tau_1 \succ \tau_2] = \frac{\exp \sum_t \hat{r}(s_1^t, a_1^t)}{\exp \sum_t \hat{r}(s_1^t, a_1^t) + \exp \sum_t \hat{r}(s_2^t, a_2^t)}P[τ1≻τ2]=exp∑tr^(s1t,a1t)+exp∑tr^(s2t,a2t)exp∑tr^(s1t,a1t)。 - PEBBLE算法:提出了反馈高效的偏好强化学习框架,将偏好策略学习分为两个阶段。在第一阶段中,利用强化学习的高效探索算法学习探索策略,通过和仿真环境交互来获得多样化的轨迹数据。在第二阶段,使用学习到的奖励函数和强化学习算法进行策略训练,在多个具身任务数据集上达到了和原始外部奖励训练类似的效果。

- SURF算法:提出了额外训练的偏好预测器,对大量未进行偏好标记的数据集进行偏好重标记,随后使用片段随机裁剪的方法进行数据增强,从而在奖励学习中提升人类反馈数据的利用效率。

- RUNE算法:提出了奖励不确定性的概念,通过拟合多个奖励函数并衡量预测的方差来作为不确定性度量,利用不确定性来指导智能体的探索。智能体通过探索能够采集多样化的轨迹,从而有利于偏好奖励的学习。

- Preference Transformer(PT)模型:使用更复杂的Transformer结构来进行偏好奖励的学习,从而建模更加复杂的奖励函数分布。

- 直接策略学习:

- DPPO算法:定义了策略和轨迹的距离度量,通过最小化策略和偏好轨迹之间的距离能够使用Bradley-Terry模型进行直接的策略优化。

- CPL算法:引入优势函数的概念,通过对偏好和非偏好数据的对比学习进行策略优化。

- OPPO算法:将标量的奖励函数学习扩展为偏好表征学习,利用三元组损失在表征空间中将具有类似偏好的轨迹表征进行拉近,而增大了不同偏好表征的距离。在进行数据生成时使用最优轨迹的偏好表征作为条件,使用扩散模型进行条件策略建模。

大模型驱动的具身数据生成

具身智能系统通常需要大量的训练数据来学习有效的策略。然而,真实环境中的数据采集成本高昂且耗时,因此数据生成成为提升具身智能系统性能的关键技术之一。大模型(如大语言模型、视觉-语言模型和生成式大模型)可以通过多种方式生成高质量的训练数据,从而缓解数据稀缺问题。

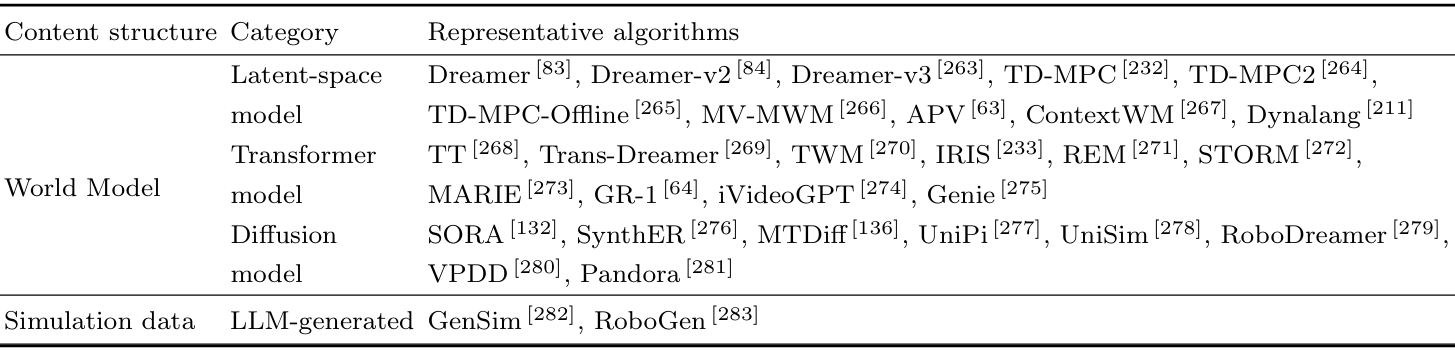

世界模型的数据生成

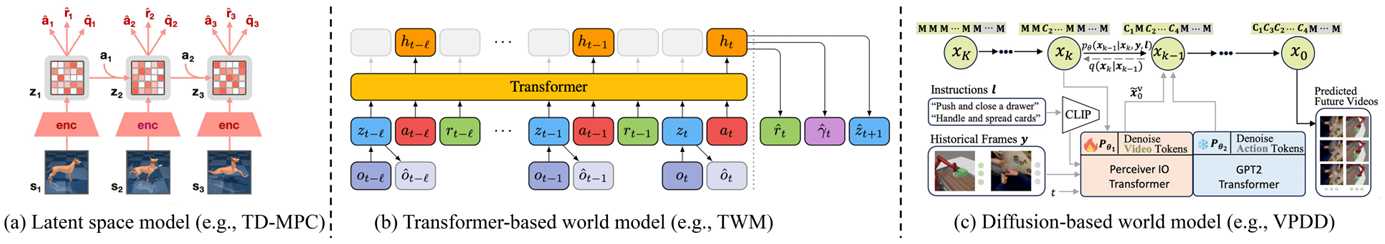

世界模型(World Model)能够帮助智能体对未来的状态和轨迹进行预测,对基于模型的强化学习算法和模型预测控制算法进行帮助。世界模型可以分为隐空间世界模型、Transformer世界模型和扩散世界模型。

-

隐空间世界模型:

- Dreamer系列:Dreamer通过将视觉观测映射到表征空间中,然后在表征空间中构建环境模型,从而降低模型在多步环境模型预测中的误差。Dreamer能够学习如何从隐空间重建原始状态,以及从隐空间预测奖励函数,从而获得更为准确的价值估计。

- TD-MPC:针对连续控制问题,使用非观测重建的方式在隐空间内构建环境状态转移模型,随后使用模型预测控制算法进行策略求解。

- TD-MPC2:通过改进损失函数提升鲁棒性,同时提升模型容量和结构设计,使世界模型能够容纳来自多种具身实体任务的数据。

- MV-MWM:将隐空间环境模型的构建扩展到多视角观测中,利用机器人多个视角的相机输入学习表征,随后在表征空间中构建跨视角的环境模型,学习到的策略能够对视角的变化鲁棒。

- APV:利用大规模人类操作数据集进行联合训练,首先在无动作标记的数据集中训练隐空间预测模型,随后加入动作标记数据进行隐空间环境模型预测和奖励预测进行微调,大大提升了无标签数据的利用率。

- ContextWM:针对机器人数据缺乏的问题,提出利用大规模人类操作数据集进行联合训练,提升无标签数据的利用率。

- Dynalang:将模型扩展到多模态数据,能够同时预测图像和文本表示的状态变化。

- Dreamer系列:Dreamer通过将视觉观测映射到表征空间中,然后在表征空间中构建环境模型,从而降低模型在多步环境模型预测中的误差。Dreamer能够学习如何从隐空间重建原始状态,以及从隐空间预测奖励函数,从而获得更为准确的价值估计。

-

Transformer世界模型:

- Trajectory Transformer (TT):对连续控制任务中的状态和动作以分桶的形式将其转化为词元,再通过每个词元查询获得其对应的嵌入表示,有效地增加了轨迹序列在嵌入空间里的表达长度和语义。随后使用Transformer结构根据当前状态和动作对未来的状态词元进行预测。

- TransDreamer:使用Transformer替换了Dreamer世界模型中使用的循环神经网络,并提出了Transformer状态空间模型。

- TWM:参考了Dreamer系列工作的设计思路,保留使用离散的隐变量空间刻画环境跳转过程的模块,同时加入了均衡采样避免Transformer世界模型在早期采样的轨迹上过度学习。

- IRIS:首次正式提出了基于词元的Transformer世界模型,舍弃了离散的隐变量空间刻画环境跳转过程的模块,使用VQ-VAE对当前视觉观测进行离散化的词元表征,以自回归的方式直接预测未来的视觉观测词元。

- REM:提出了并行观测预测机制,将推理效率提升至IRIS的7∼8倍。

- STORM:在TWM的工作基础上借鉴IRIS优势,并融合观测和动作两种模态形成单一词元,在Atari-100K上取得了最好的结果。

- MARIE:提出了多智能体领域的Transformer世界模型,通过结合分散式共享的世界模型和集中式智能体表征获得了更好的多智能体协同表现。

- iVideoGPT:提出了高效的词元压缩表示,通过人类操作和机器人视频预测进行Transformer模型预训练,随后添加动作条件和奖励预测进行微调。

- Genie:使用大量视频数据训练词元编码器和隐动作模型,随后构建时空Transformer网络进行视频预测的环境模型训练,能够进行以动作为条件的长序列视频生成。

- Trajectory Transformer (TT):对连续控制任务中的状态和动作以分桶的形式将其转化为词元,再通过每个词元查询获得其对应的嵌入表示,有效地增加了轨迹序列在嵌入空间里的表达长度和语义。随后使用Transformer结构根据当前状态和动作对未来的状态词元进行预测。

-

扩散世界模型:

- Sora:OpenAI提出的Sora视频生成模型被认为是世界模拟器。Sora可以根据语言描述在原始的图像空间中生成多步的图像预测,组成长达60秒的内容连贯的视频。Sora在具身智能任务中有着广泛的应用前景,可以根据机器人任务的描述和轨迹先验生成智能体在后续时间步的轨迹视频,将生成的视频序列用于基于模型的强化学习、蒙特卡洛树搜索、MPC算法中。

- SynthER:使用扩散模型学习低维的强化学习离线轨迹数据集,可以生成轨迹数据对原始数据进行增强。

- MTDiff:将扩散模型用于多任务轨迹生成,提出使用任务专家轨迹作为prompt来指导生成符合该任务目标和动力学的智能体轨迹。

- UniPi:直接在图像空间对智能体的轨迹进行建模,使用扩散模型根据语言输入和初始图像对未来的关键视频帧进行生成,随后在时间序列进行超分辨获得一致性增强的密集图像序列。

- UniSim:进一步增强了扩散模型在轨迹预测方面的性能,使用互联网数据和机器人交互视频进行联合训练,得到的模型能够根据高层和低层任务指令对长序列视频轨迹进行预测。

- RoboDreamer:将组合指令分解为单个指令并分别使用扩散模型进行视频轨迹生成,同时可以扩展到多模态的指令集合上,如目标图像、目标草图等。

- VPDD:使用大规模人类操作数据集训练轨迹预测模型,随后加入少量动作标签数据微调动作生成模块,减轻了对大量机器人交互数据的需求。

- Pandora:结合了预训练的大语言模型和扩散模型视频生成器,通过以动作为条件的视频预测训练和指令微调进行可控视频生成。

- Sora:OpenAI提出的Sora视频生成模型被认为是世界模拟器。Sora可以根据语言描述在原始的图像空间中生成多步的图像预测,组成长达60秒的内容连贯的视频。Sora在具身智能任务中有着广泛的应用前景,可以根据机器人任务的描述和轨迹先验生成智能体在后续时间步的轨迹视频,将生成的视频序列用于基于模型的强化学习、蒙特卡洛树搜索、MPC算法中。

仿真环境的数据生成

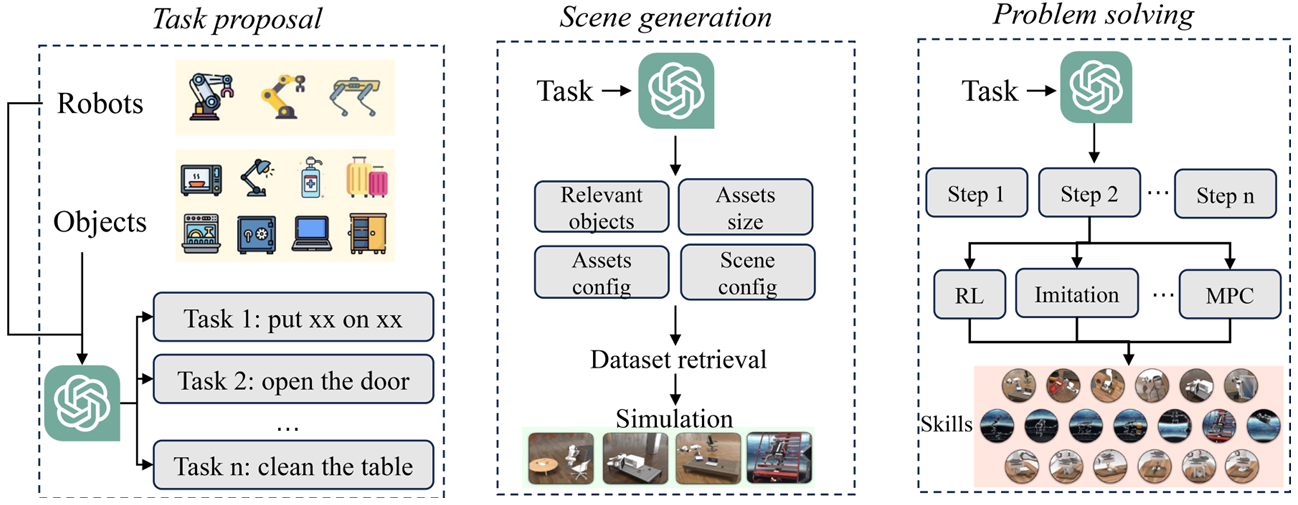

大模型可以借助现有的仿真环境进行自动化的环境生成和数据采集。大语言模型的使用可以大大提升任务的多样性,降低任务仿真环境编写的难度,提升机器人数据的多样性。

- GenSim框架:MIT提出的使用大语言模型进行自动任务提出、自动环境构造、自动任务解决、自动数据采集的全流程框架。首先,大语言模型根据简短的任务描述和任务需求来产生相应任务的仿真场景代码搭建,同时提供了一套自动化的流程来验证仿真环境的可行性和进行迭代的修正。随后,根据不同任务生成的仿真环境构建一个高质量大模型生成的任务库,用于在构建新任务时进行检索和反馈优化。最后,根据任务搭建的流程可以从中采集大量专家数据,在现有模仿学习架构的基础上训练模仿学习策略。

- RoboGen框架:进一步提出更为通用的仿真环境生成器,可以在机械臂、移动机器人、四足机器人、灵巧手等主流的具身实体上生成仿真环境。首先,RoboGen使用现有仿真环境中存在的物体,大语言模型根据对物体功能及如何进行交互的理解来提出有意义的任务;随后,大模型根据任务中需要的场景和目标,通过调用仿真器底层函数来搭建符合该任务描述的仿真环境;大模型对任务进行分解,对子任务选择强化学习、模仿学习、轨迹优化等算法对任务进行求解,最终产生能够解决不同任务的策略和数据。

现有研究的联系

-

环境感知与下游模块的联系:

- 环境感知模块能够为任务规划和策略学习提供场景理解,将视觉信息转化为自然语言描述或词元表示,帮助大模型更好地进行任务分解和策略生成。

- 例如,ManipLLM框架结合环境感知和任务执行,通过大模型问答输出操作向量,指导机械臂操作物体。

-

任务规划模块的中心作用:

- 任务规划是大模型解决复杂任务的核心,依赖环境感知模块将场景信息转化为自然语言描述,从而更好地利用大模型的推理能力。

- 任务规划模块产生的基础任务单元依赖于机器人行为策略进行执行,例如VoxPoser框架中大模型产生的规划依赖底层MPC控制器执行。

-

基础策略模块的隐含功能:

- 基础策略模块通常隐含地进行了环境感知和任务规划。例如,OpenVLA框架使用预训练的视觉编码器进行环境感知,并将环境信息与语言指令混合输入大语言模型,隐含地完成任务规划并输出动作。

-

奖励函数模块的结合:

- 奖励函数模块能够与强化学习算法结合,用于具身策略学习。偏好驱动的奖励函数生成可以用于大模型任务规划和基础策略与人类偏好的对齐,提升策略的安全性和对人类指令的理解能力。

-

数据生成模块的基础作用:

- 数据生成模块为其他模块提供支持,通过生成特定场景的具身数据,帮助大模型进行策略学习和任务规划的微调。

- 例如,GenSim和RoboGen框架使用大语言模型生成仿真环境和数据,为具身智能提供多样化的任务和数据。

存在的挑战

-

大模型在特定具身场景中的适应性:

- 大模型在特定具身任务中需要解决“专才”问题,但目前的闭环反馈方法在特定机器人数据缺乏的情况下难以训练准确的值函数。

- 高保真数字孪生场景的构建和优化面临诸多挑战,包括模型训练、感知与操作的集成、知识库的构建与维护等。

-

大模型策略与人类偏好的对齐:

- 大模型在训练中使用了大量人类对话数据,但具身任务需要简洁、准确、安全的指令。如何将大模型的规划能力与人类偏好对齐是一个重要问题。

- 现有的任务规划和奖励生成中使用人类反馈进行调整,但未来需要更先进的方法来提升大模型策略的安全性和对人类指令的理解能力。

-

具身策略的跨域泛化问题:

- 具身任务涉及多样化的实体类型和动态环境变化,策略在动力学参数改变后难以直接适用。

- 解决方法包括在大模型的提示或训练数据中包含所有可能的变化情况,或使用动力学泛化方法进行数据增强和跨域度量。

-

大模型驱动的多智能体协作问题:

- 多智能体任务中涉及复杂的任务分配和沟通问题,现有研究在对话沟通式框架和中心式评价分布式执行方面仍有提升空间。

- 竞争式多智能体结构在大模型驱动的具身智能中缺乏研究,未来需要引入更多博弈框架来演化复杂的均衡态。

-

具身智能在真实环境中的挑战:

- 数据获取方面,真实环境中的数据是非结构化、动态变化的,对实时采集和处理提出了更高要求。

- 平台安全性方面,具身智能系统依赖网络传输,容易成为网络攻击目标,需要确保通信安全和数据隐私。

- 真实环境反馈方面,各种干扰因素可能影响传感器性能和数据准确性,系统需要具备处理和适应这些干扰的能力。

-

大模型具身策略的决策实时性问题:

- 具身任务需要高频率的决策来适应动态环境变化,但直接调用大模型接口难以满足实时性要求。

- 未来需要对大模型进行轻量化,包括模型剪枝、量化、低秩分解等手段,以提升其在具身推理和决策中的能力。

总结与展望

- 总结:

- 本文围绕大模型驱动的具身智能这一前沿交叉领域,总结了大模型和具身智能的相关技术背景,涵盖了基本概念、学习框架、大模型技术等,并从环境感知、任务规划、基础策略、奖励函数、数据生成等五个方面依次介绍了大模型驱动的具身智能的前沿研究工作,总结了目前研究的成果和挑战。

- 大模型驱动的具身智能是一项有着重大应用前景的研究方向,将日益成熟的大模型技术与机器人进行结合,用于解决机器人在感知、规划、决策中的各种问题。虽然目前关于采取何种路线能够达到通用具身智能仍很难定论,但大模型的成功切实地推动了具身智能的发展。

- 展望:

- 统一具身数据平台:构建涵盖尽可能多的具身实体、任务类型、环境、场景、动力学的多模态快速仿真和真实数据平台,推动数据基础设施建设。

- 通用具身数据表征:机器人状态描述往往涵盖了除了视觉和语言之外的其他信息,包括本体感知、力学/触觉传感器、位置描述等,构建统一机器人多模态观测的具身表征是重要的问题。

- 鲁棒具身控制策略:提升现有大模型进行具身决策时的安全性和鲁棒性,避免环境干扰和外界因素带来的机器人交互危险,提升对机器人系统对环境变化的适应能力。

- 可控具身策略生成:提升大模型具身智能策略的可控性,建立安全保障机制,明确的安全边界和行为规范,确保机器人的行动不会超越这些预设的限制。

- 人机合作具身智能:机器人作为人类的助手需要理解人类意图,进行增强的人类意图识别,帮助机器人提前准备响应,提高合作效率。

- 异构智能体协同:使用大模型控制不同类型的异构智能体进行高效协同,结合多智能体强化学习进行合作策略学习和引导,建立统一的伦理标准和操作准则,确保所有智能体协同工作时遵循相同的伦理约束。

- 轻量化具身策略:推动大模型和小模型结合的方式,以轻量化模型和较少的计算代价解决具身智能任务。

- 人形机器人:推动运动控制、抓取操作、导航、灵巧操作等具身技能集于一身,更好地为人类服务。