支持DeepSeek_Qwen等大模型!字狐Chatbox在线模型+本地部署模型

前言

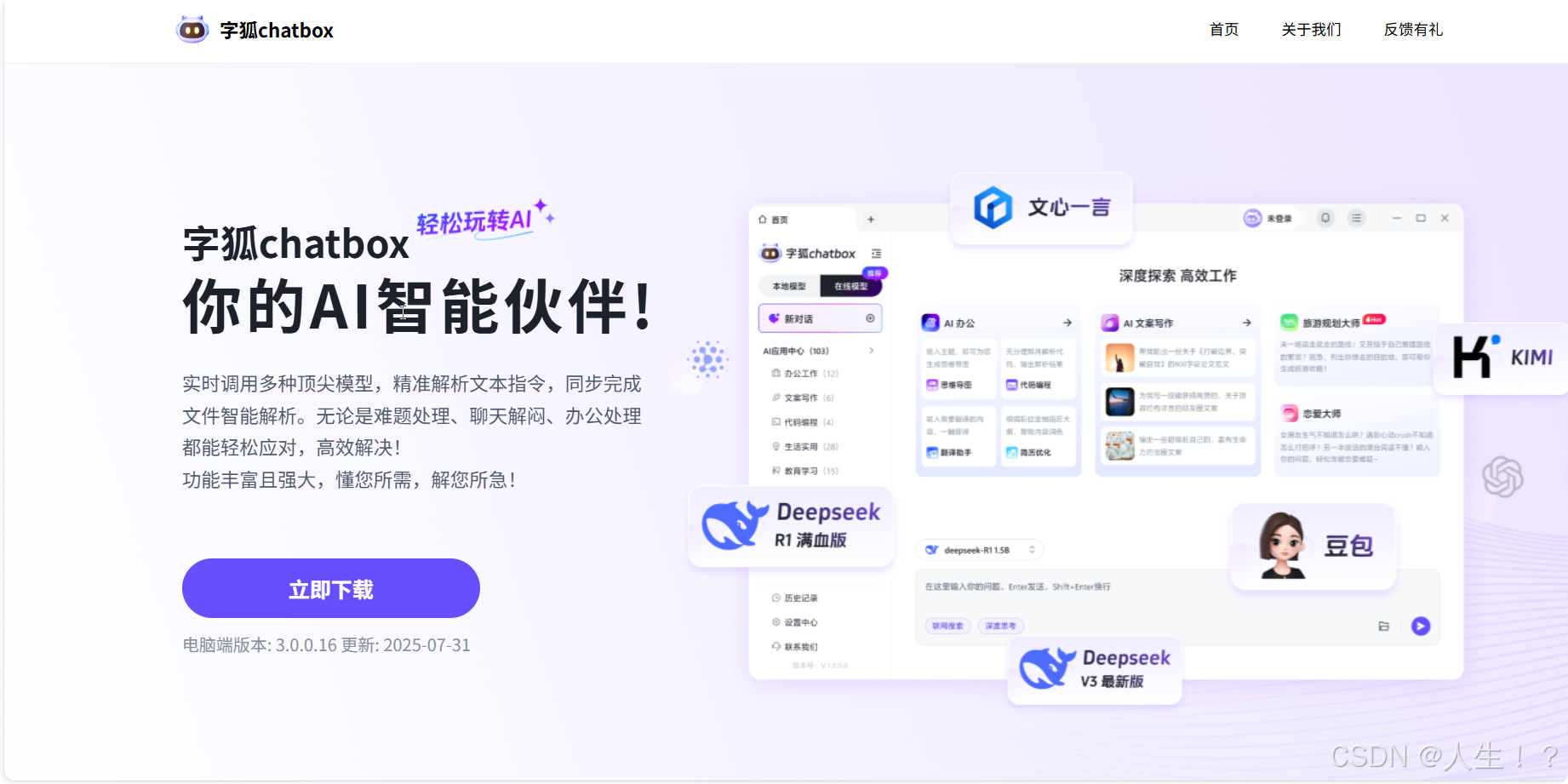

字狐Chatbox是一款功能强大的 AI 聊天客户端,用户可以在一个平台上轻松切换使用各种主流大模型,例如:DeepSeek、Qwen等

不论是联网使用云端模型还是无网络使用离线模型,都能在字狐Chatbox流畅体验

写这篇文章的目的在于体验字狐Chatbox提供的两种使用方式——在线模型与 本地部署模型

平台概览与支持模型

-

字狐Chatbox仅支持运行在Windows端

-

官网页面👇

-

字狐Chatbox支持的模型类型丰富

-

支持在线模型和本地部署模型

-

支持国内众多主流模型例如DeepSeek、Qwen

安装体验

安装

体验链接:https://file-cdn-chatbox.fanqiesoft.cn/chatbox/ZhiHuChatBox_28431_st.exe

下载后安装

安装后进入页面

云端模型体验

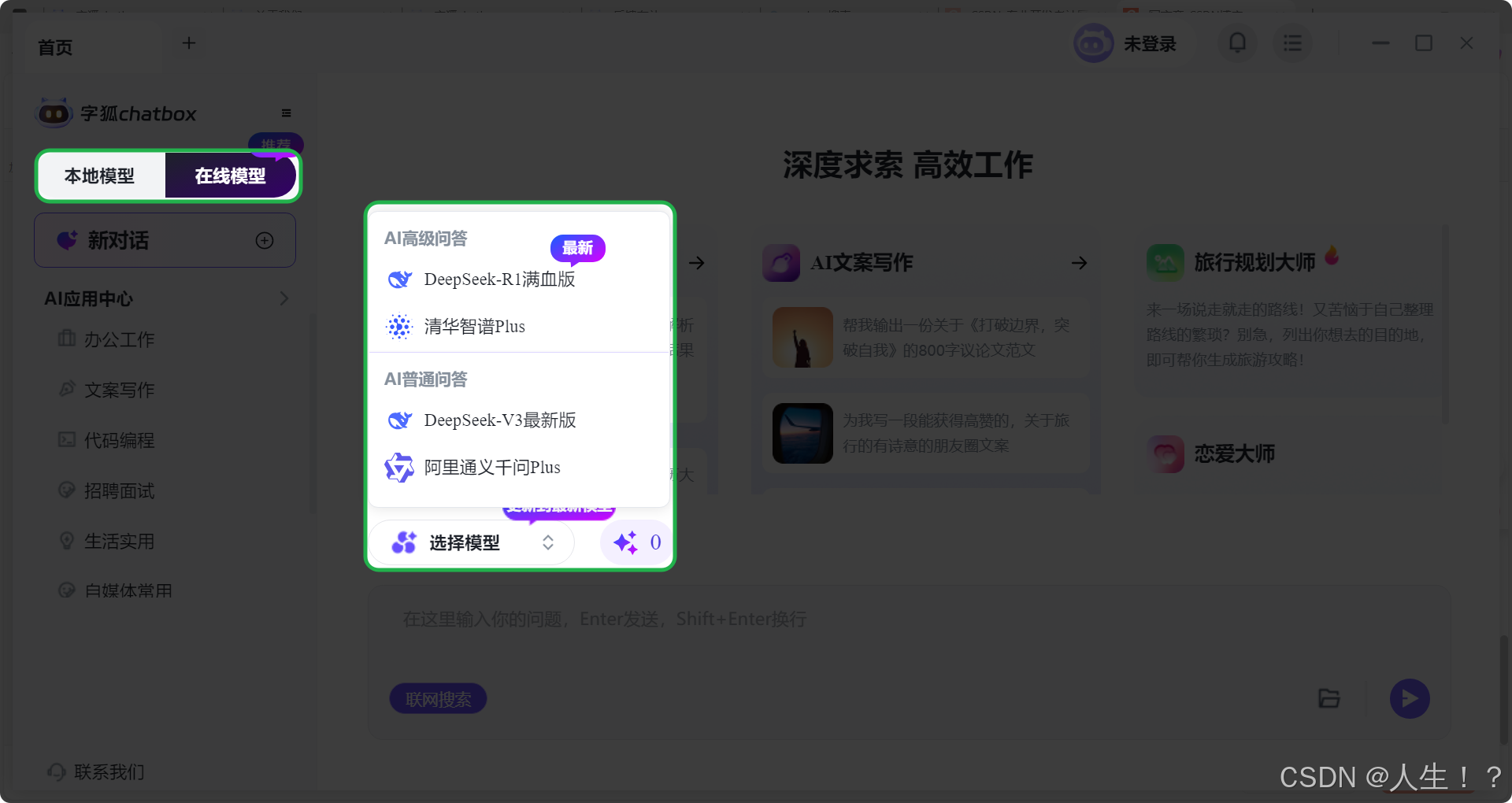

左边有本地模型和在线模型两个模式

右边有各种云端大模型(DeepSeek R1、清华智谱Plus、DeepSeek V3、阿里通义千问Plus)

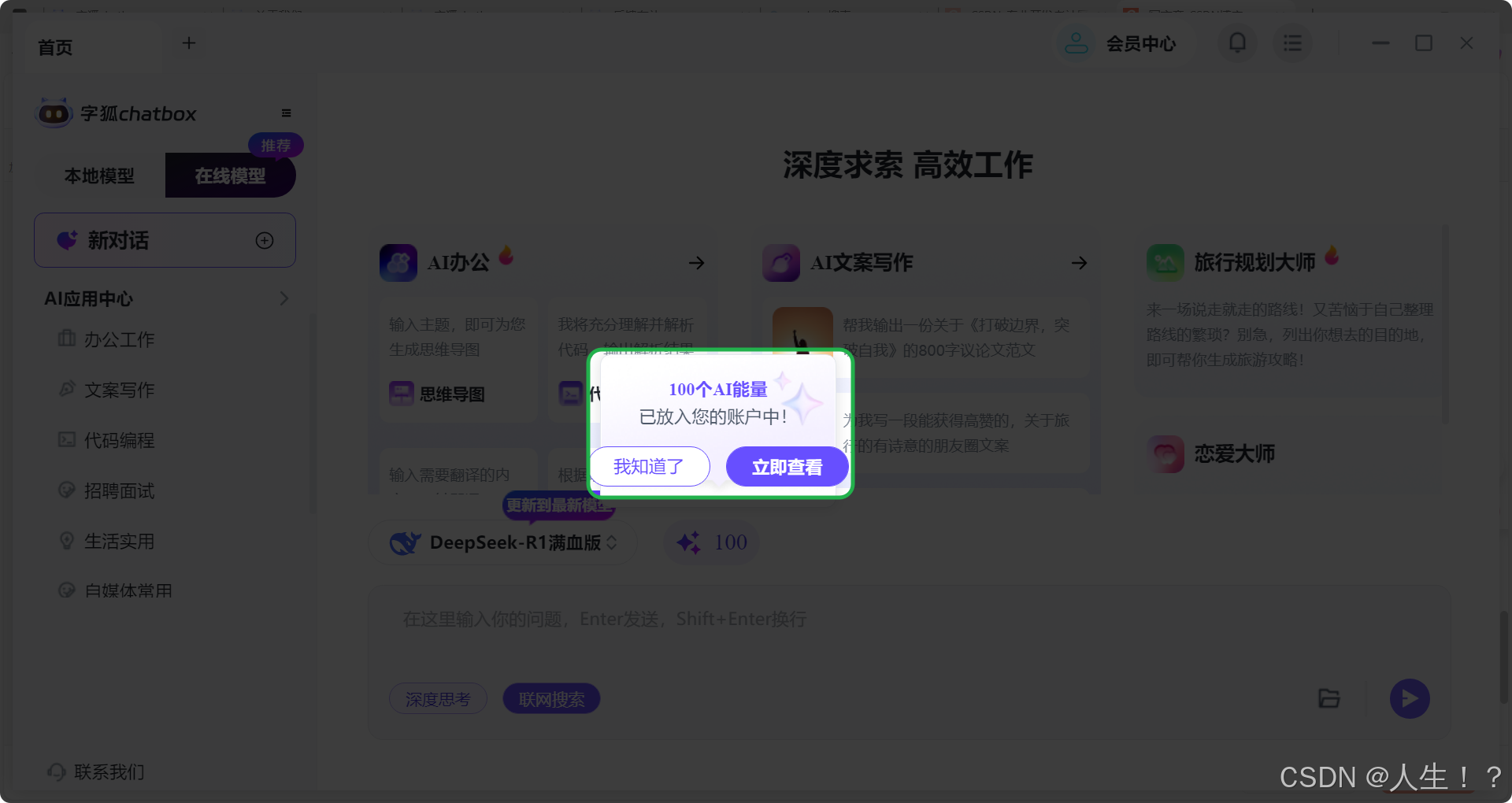

当然以上的所有在线模型需要登陆使用“ai能量”才能使用、新用户登陆后会送【100】个ai能量

本地模型体验

字狐Chatbox支持两种本地部署方式

第一种:使用字狐Chatbox官方工具本地一键部署

模型下载安装好后需要将字狐Chatbox客户端进行重启否则可能无法识别到模型

在①处:选择你所需的本地模型类型

在②出:查看你自己电脑的配置

在③处:结合自己的配置选择一个适合你自己的模型版本

第二种:使用Ollama本地部署连接至字狐Chatbox

步骤一:安装Ollama

Ollama是一个用于本地运行大语言模型的开源工具,支持多种模型,包括DeepSeek - R1等。以下是不同操作系统下的安装方法:

Windows系统:访问Ollama官网(https://ollama.com),下载Windows版本的安装程序(ollama - windows.msi)。双击安装程序,按照提示完成安装。

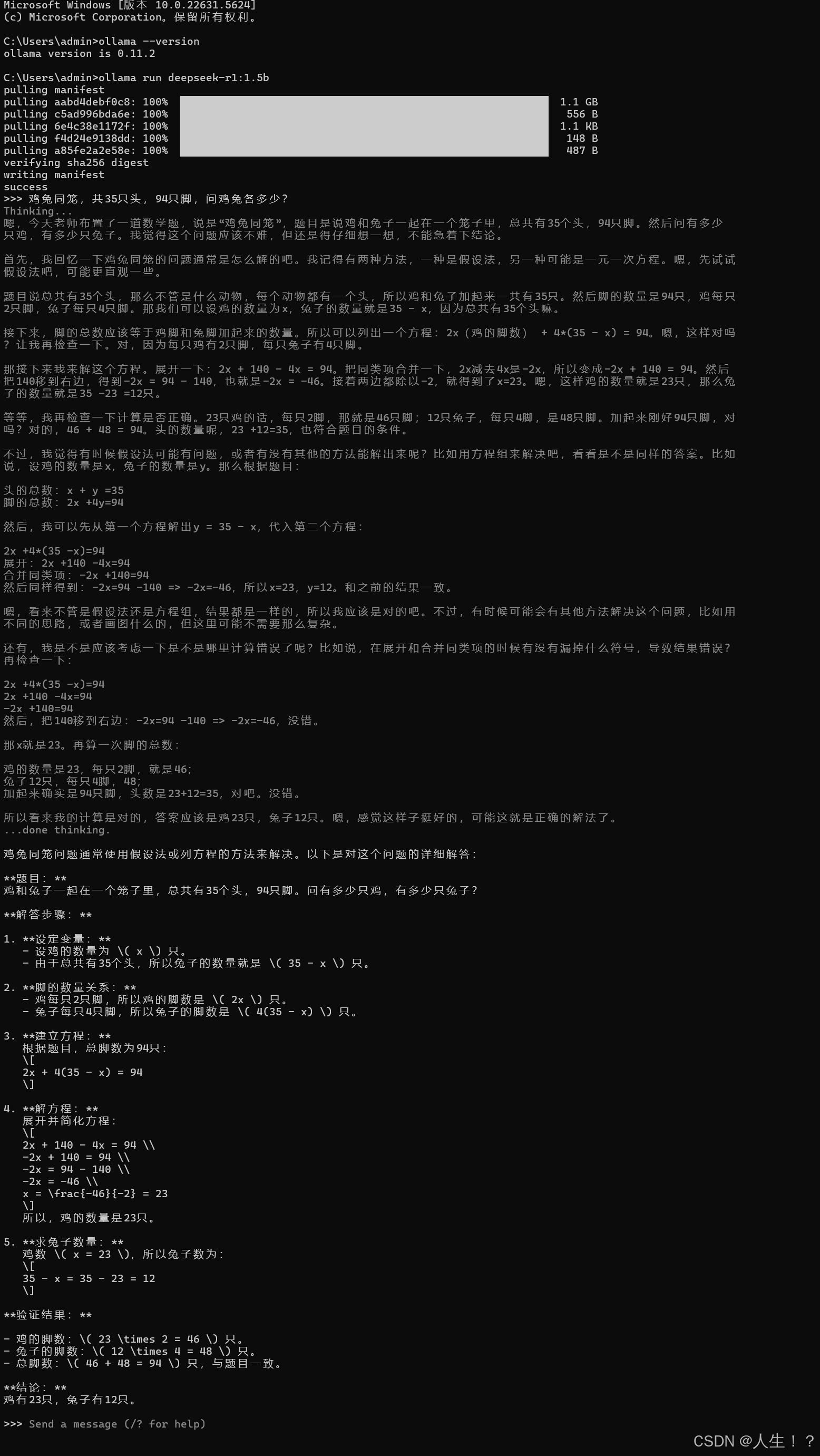

安装完成后,打开命令提示符(cmd)或PowerShell,输入 ollama --version,如果正确显示版本号,则安装成功。

安装完成后可以直接在cmd中向模型提问

步骤二:选择DeepSeek模型

进入Ollama官网,点击【Models】,找到DeepSeek - R1,并选择合适的参数版本。DeepSeek有多种不同参数规模的模型可供选择,你可以根据自己的硬件配置和实际需求进行挑选:

| 模型参数 | 硬件要求 | 适用场景 |

|---|---|---|

| 1.5B | CPU最低4核(推荐Intel/AMD多核处理器),内存8GB + ,硬盘3GB + 存储空间(模型文件约1.5 - 2GB),显卡非必需(纯CPU推理),若GPU加速可选4GB + 显存(如GTX 1650) | 入门级模型,适合个人设备 |

| 7B | CPU 8核以上(推荐现代多核CPU),内存16GB + ,硬盘8GB + (模型文件约4 - 5GB),显卡推荐8GB + 显存(如RTX 3070/4060) | 性能均衡,适合本地开发使用 |

| 8B | 硬件需求与7B相近,略高10 - 20% | 性能优于7B,实现更高精度的轻量级任务 |

| 14B | CPU 12核以上,内存32GB + ,硬盘15GB + ,显卡16GB + 显存(如RTX 4090或A5000) | 强劲性能,可完成企业级复杂任务 |

| 32B | CPU 16核以上(如AMD Ryzen 9或Intel i9),内存64GB + ,硬盘30GB + ,显卡24GB + 显存(如A100 40GB或双卡RTX 3090) | 高精度专业领域任务,建议多卡部署 |

| 70B | CPU 32核以上(服务器级CPU),内存128GB + ,硬盘70GB + ,显卡多卡并行(如2x A100 80GB或4x RTX 4090) | 适合科研机构/大型企业,实现高复杂度生成任务 |

| 671B | CPU 64核以上(服务器集群),内存512GB + ,硬盘300GB + ,显卡多节点分布式训练(如8x A100/H100) | 顶级性能,适合国家级/超大规模AI研究 |

大家最好用匹配的硬件配置进行部署,否则会影响到后续使用过程中DeepSeek的响应速度,再重新部署又得重新操作一遍。

步骤三:安装DeepSeek模型

复制并下载命令:ollama run 模型名 例如:

ollama run deepseek-r1:1.5b

这里和下面的操作,我们选择的是DeepSeek-R1 1.5B模型,大家注意根据自己选择的模型修改命令。

打开CMD(命令行),按 Win + R,输入“cmd”,回车。

粘贴刚刚复制的命令,回车执行。模型开始下载,时间取决于网速和显存。

回到字狐Chatbox

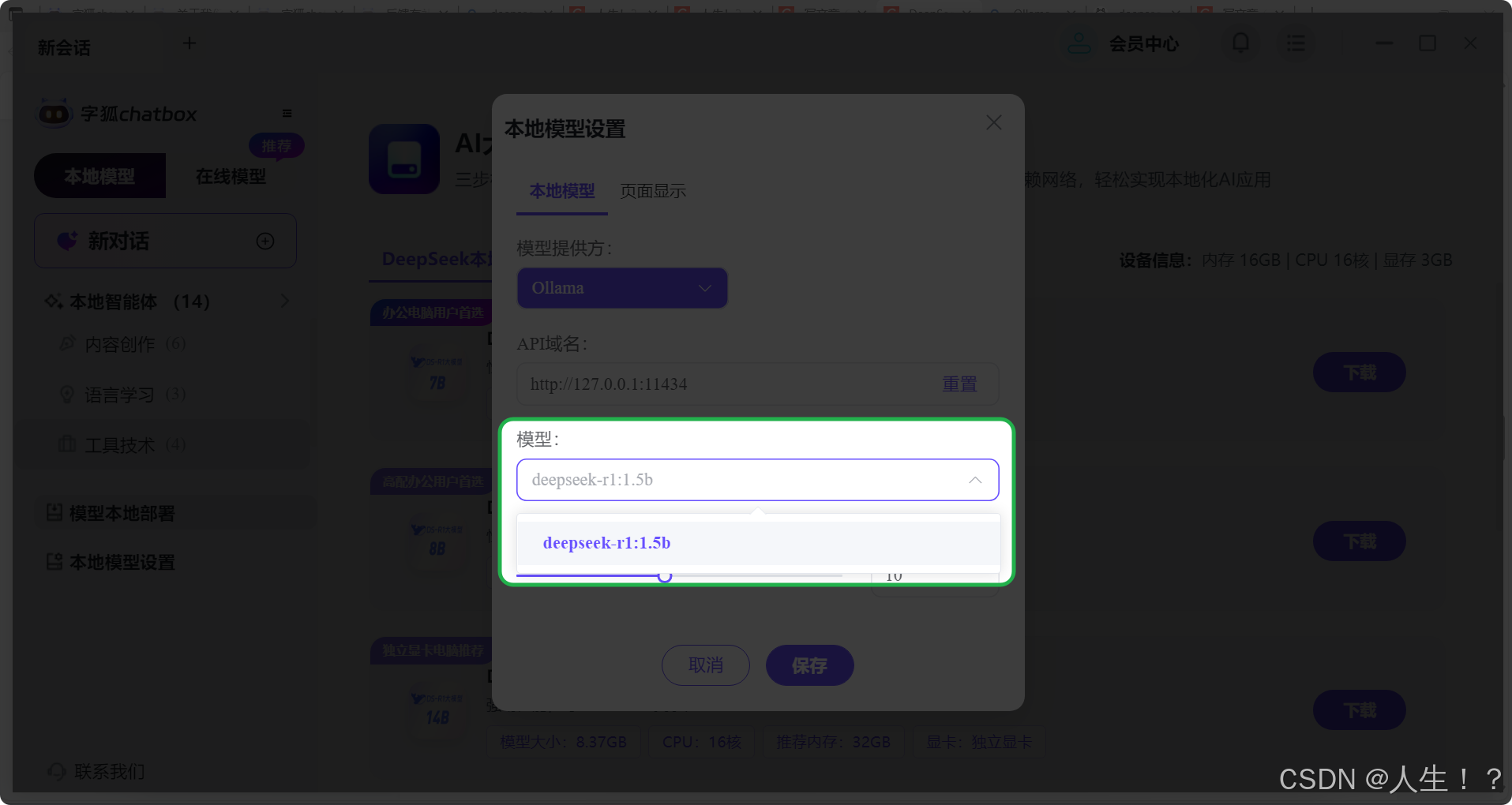

模型下载安装好后需要将字狐Chatbox客户端进行重启否则可能无法识别到模型,在主页中找到本地模型设置

然后在模型中选择刚才下载好的模型后确认

我们回到模型本地部署页面,可以看到右边的模型中有开始对话的字样,点击即可开始使用

测试题

原题:

鸡兔同笼,共35只头,94只脚,问鸡兔各多少?

DeepSeek-R1在线模型回答:

鸡兔同笼问题可以通过以下步骤解决:解法步骤(假设法) 假设全是鸡 35个头 → 35只鸡

鸡脚总数:35 × 2 = 70只脚

实际脚数94只 → 少算了:94 - 70 = 24只脚替换为兔子 每换1只兔(比鸡多2只脚),脚数增加:4 - 2 = 2只

需替换兔子数:24 ÷ 2 = 12只结果 兔:12只

鸡:35 - 12 = 23只验证答案 兔脚:12 × 4 = 48只

鸡脚:23 × 2 = 46只

总脚数:48 + 46 = 94只(符合题目条件)最终答案🐔 鸡23只,🐇 兔12只。鸡兔同笼问题解法:35头94脚求数量DeepSeek-r1:1.5b

根据题目,设鸡的数量为 ( x ) 只,兔子的数量为 ( y ) 只,则:根据头数:( x + y = 35 )

根据脚数:( 2x + 4y = 94 )解方程组:从第一个方程得:( x = 35 - y )

代入第二个方程:( 2(35 - y) + 4y = 94 )( 70 - 2y + 4y = 94 )( 70 + 2y = 94 )( 2y = 24 )( y = 12 )鸡的数量:( x = 35 - 12 = 23 )

答案:鸡有23只,兔子有12只。结语

不管是写文案、编代码还是总结资料,字狐Chatbox都能帮你解决问题。

字狐Chatbox对于我个人来说,它最有趣的地方就是它能够把“本地模型”和”在线模型“两种模式完美融合在一起

总的来说,字狐Chatbox的确是一款很“强”的AI工具:

- 想要快速体验国内主流大模型?——它内置了DeepSeek、通义千问、清华智谱等多个高质量模型,不用折腾API,开箱即用

- 想要自己玩本地部署、享受离线的自由?——无论是一键部署还是Ollama手动链接,它都给你留好了入口

体验入口(单击即可跳转下载):https://file-cdn-chatbox.fanqiesoft.cn/chatbox/ZhiHuChatBox_28431_st.exe