常见的大模型分类

人工智能技术正以前所未有的速度重塑着各个行业的格局,而大模型作为人工智能领域的关键突破,在众多应用场景中崭露头角,悄然改变着我们对技术与智能的认知。从智能客服系统中精准应答用户问题,到医学影像诊断辅助中为医生提供关键洞察,大模型凭借其复杂的架构和强大的数据处理能力,展现出多样化的功能和价值。本文将深入探讨当下常见的大模型类别,帮助更多人了解大模型。

一、按模型架构分类

• Transformer 架构模型

Transformer 架构是当下大模型的主流架构之一。它以自注意力机制(Self - Attention)为核心,摒弃了传统循环神经网络(RNN)的序列处理方式,能够并行处理序列数据,大大提升了训练和推理效率。

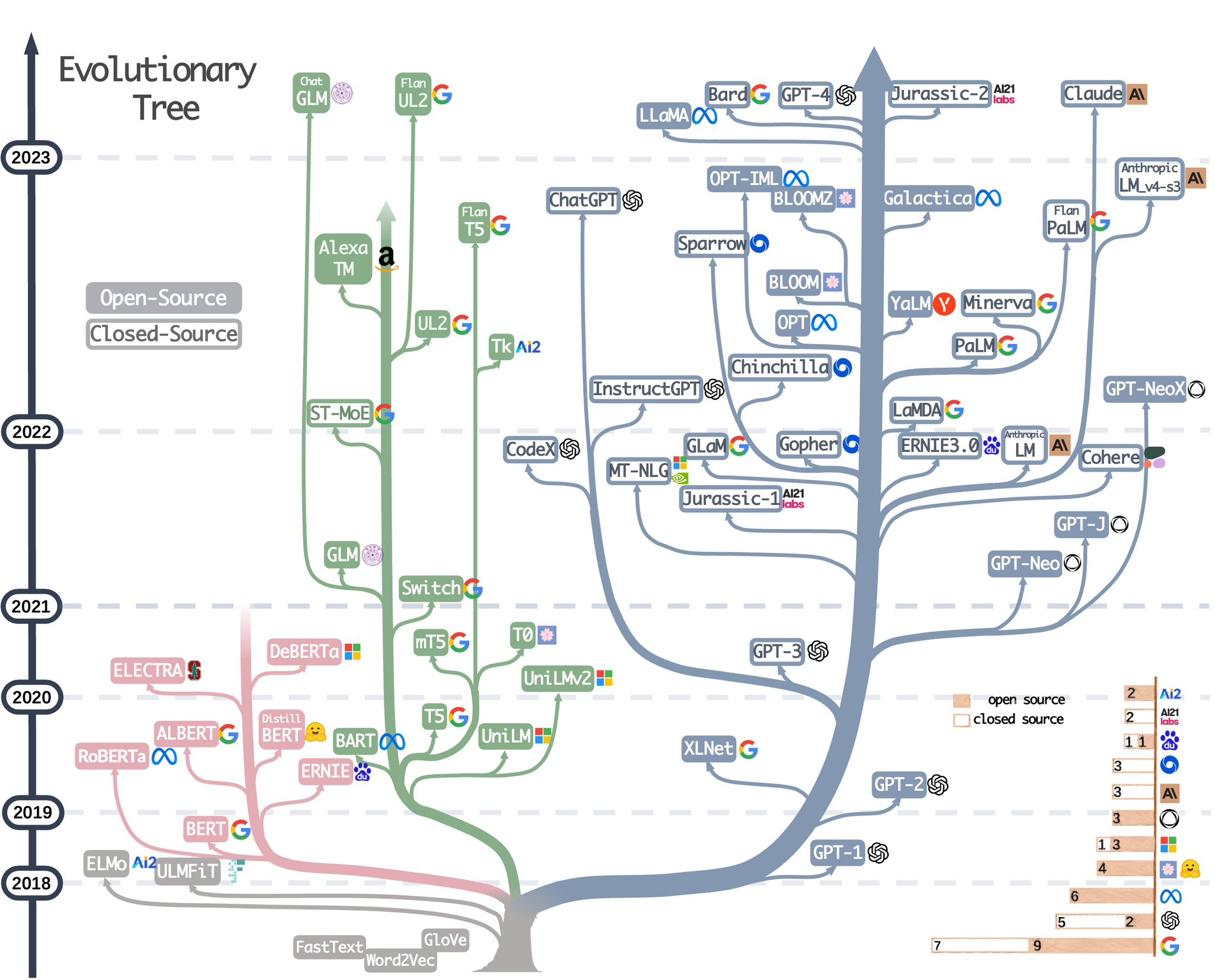

例如,GPT 系列(Generative Pretrained Transformer)就是基于 Transformer 架构的典型代表。GPT - 3 在 2020 年一经推出,就凭借其 1750 亿参数量,展现了强大的语言生成能力。它能够撰写文章、诗歌、故事,甚至代码,生成的文本在语法、逻辑和连贯性方面都达到了较高水平。其后续版本 GPT - 4 更是在多模态处理、推理能力等方面有了显著提升,能够处理图像和文本等多种输入形式,为各种复杂任务提供解决方案。

• 卷积神经网络(CNN)架构模型

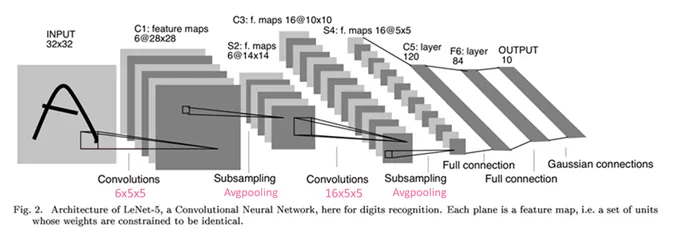

CNN 架构在计算机视觉领域有着举足轻重的地位。它通过卷积层、池化层等结构,能够自动提取图像中的局部特征和层次化特征。虽然 CNN 本身在处理序列数据方面不如 Transformer 架构,但在一些特定的视觉任务上表现卓越。

以 AlexNet 为例,作为早期经典的 CNN 模型,它在 2012 年的 ImageNet 大规模视觉识别挑战赛中取得了突破性成绩,推动了深度学习在计算机视觉领域的快速发展。而如今的一些大型 CNN 模型,如 ResNet 等,通过加深网络层数和引入残差连接等创新结构,进一步提升了模型的性能,广泛应用于图像分类、目标检测、图像分割等任务中。

二、按应用领域分类

• 自然语言处理(NLP)领域模型

这类模型专注于理解和生成人类语言。除了前面提到的 GPT 系列,还有 BERT(Bidirectional Encoder Representations from Transformers)模型。BERT 采用预训练加微调的模式,预训练时通过掩盖部分单词让模型预测,以及预测两个句子之间的关系等任务,学习到丰富的语言知识。在微调阶段,针对不同的自然语言任务(如情感分析、问答系统、文本分类等)进行微调,能够快速适应各种应用场景。

例如,在智能客服系统中,基于 BERT 的模型可以准确理解用户的问题意图,快速提供准确、恰当的回复,大大提高了客户服务的效率和质量。在机器翻译领域,一些大型 NLP 模型也取得了显著成果,能够将一种语言高效、准确地翻译成另一种语言,为跨文化交流提供了有力支持。

• 计算机视觉领域模型

在计算机视觉领域,大模型主要用于图像和视频的分析、理解和生成。除了 CNN 架构的模型,还有基于 Vision Transformer(ViT)的模型。ViT 将图像分割成多个小的图像块,将这些图像块视为序列元素,通过 Transformer 架构进行处理,能够捕捉到图像中的长距离依赖关系。

例如,一些大型目标检测模型可以实时识别和定位图像或视频中的各种物体,广泛应用于安防监控、自动驾驶等领域。在图像生成方面,如 DALL - E 等模型,能够根据给定的文本描述生成高质量、逼真的图像,为创意设计、广告制作等提供了新的思路和工具。

三、按数据类型分类

• 文本大模型

专注于处理文本数据,通过学习大量的文本语料库,掌握语言的规则、语义和知识。这些模型能够进行文本生成、文本摘要、语义理解等任务。

例如,在内容创作领域,文本大模型可以帮助创作者快速生成初稿,激发创作灵感。在信息检索方面,通过对文本语义的理解,能够更准确地为用户找到相关的文档和信息,提高信息检索的效率和准确性。

• 图像大模型

以图像数据为主要处理对象,学习图像的特征、结构和语义信息。它们在图像分类、目标检测、图像分割、图像生成等任务中发挥着关键作用。

在医疗影像诊断领域,图像大模型可以辅助医生快速、准确地分析 X 光、CT、MRI 等影像,发现潜在的病变和疾病迹象,提高诊断的准确性和效率。在工业检测中,能够对生产线上的产品外观进行快速检测,识别缺陷和异常,保障产品质量。

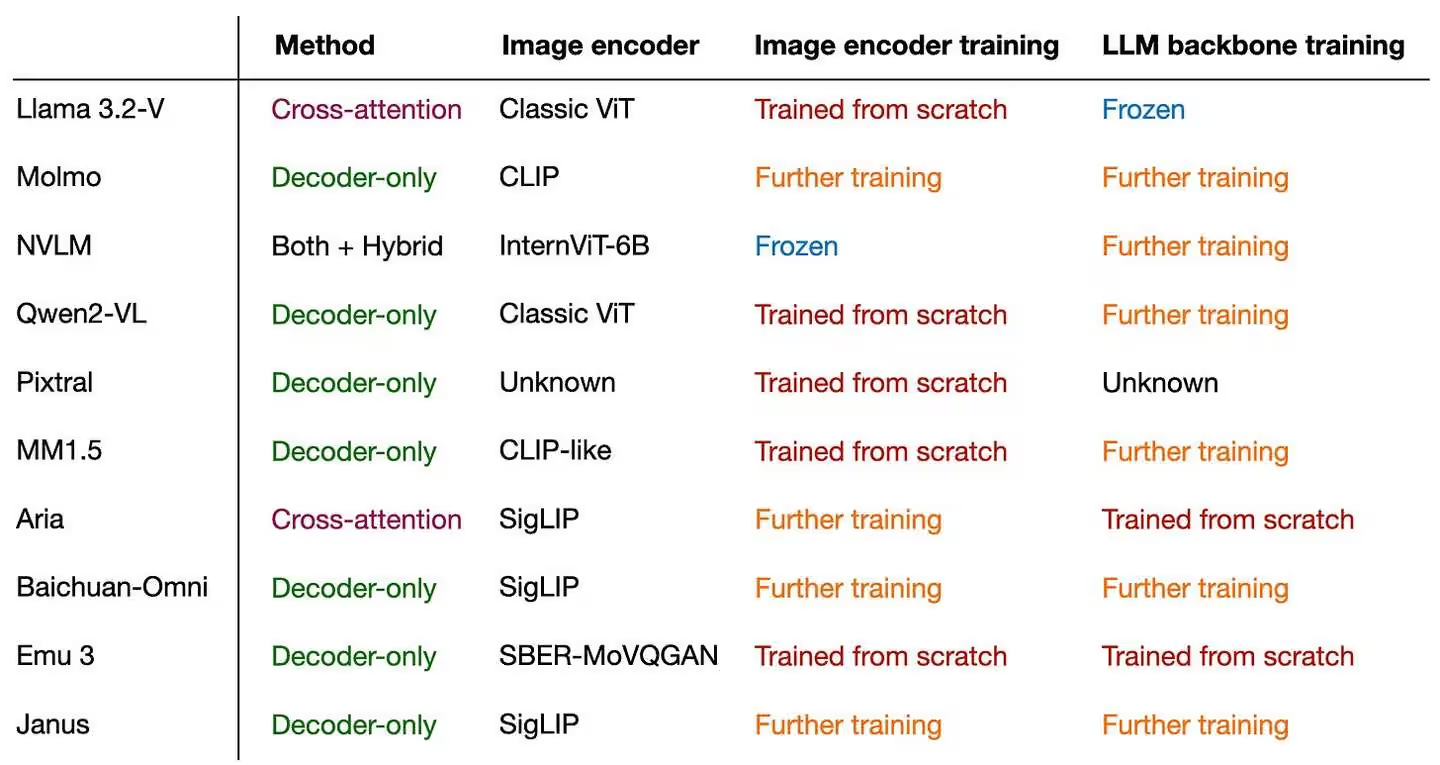

• 多模态大模型

多模态大模型能够同时处理多种类型的数据,如文本、图像、音频等。它们打破了单一模态数据的局限,能够更好地理解和建模现实世界中复杂的信息融合场景。

例如,在智能驾驶领域,多模态大模型可以同时处理车辆摄像头拍摄的图像、激光雷达的点云数据以及车辆传感器的数据等,对路况进行全面、准确的感知和理解,辅助自动驾驶决策。在虚拟现实和增强现实应用中,多模态大模型能够将虚拟元素与现实场景的文本、图像和声音等信息进行自然融合,为用户带来更加沉浸式的体验。

四、按训练方式分类

• 预训练大模型

预训练大模型是在大规模无监督或弱监督的数据集上进行训练,学习到通用的特征表示和知识。这些模型在预训练阶段不针对特定的任务,而是学习数据中的通用规律和模式。预训练完成后,可以通过微调(Finetune)的方式快速适应各种下游任务。

例如,前面提到的 BERT 和 GPT 系列都是预训练大模型的典型代表。预训练模型的优势在于能够充分利用大量的数据资源,学习到广泛的知识,在多个任务上具有良好的泛化能力,降低了针对每个任务单独训练模型的成本和难度。

• 微调大模型

顾名思义,微调大模型是在预训练模型的基础上,针对特定的任务和数据集进行进一步训练。通过微调,模型能够学习到特定任务的独特特征和规律,提高在该任务上的性能。

比如,在医疗领域的文本分类任务中,可以对预训练的 BERT 模型进行微调,使其能够准确区分不同疾病的病历文本,为医疗诊断和研究提供支持。微调过程通常需要相对较少的领域特定数据,就能够使模型在特定任务上取得较好的效果,是将预训练模型应用于实际业务场景的重要手段。

大模型的分类方式多种多样,每种分类都有其独特的特点、优势和应用场景。随着人工智能技术的不断发展,新的大模型架构和训练方法不断涌现,这些模型将继续推动各行业的智能化发展,为人类创造更加美好的未来。