OpenAI重磅推出开源模型!gpt-oss-120b与20b全面解析

OpenAI是在2025年8月5日推出的开源模型,笔者在次日看了下论文,尝试了下Ollama和huggingface下载。

想要下载和推理的朋友直接看“二、模型下载 && 推理”即可。顺便一说,这两个开源模型可以微调训练哦。

参考文献:

- 官方试用地址:https://www.gpt-oss.com/ (笔者进去没有聊天框,因为服务器满载?)

- 官方博客:https://openai.com/zh-Hans-CN/index/introducing-gpt-oss/

- 官方论文:https://cdn.openai.com/pdf/419b6906-9da6-406c-a19d-1bb078ac7637/oai_gpt-oss_model_card.pdf

- GitHub 地址:https://github.com/openai/gpt-oss

- hugging face 地址:https://huggingface.co/openai/gpt-oss-20b

一、基本概念

OpenAI在2025年8月5日推出开源模型:gpt-oss-120b 和 gpt-oss-20b。

这是两款轻量级语言模型,前者能在单个 80GB GPU 上运行,后者能在16GB GPU 上运行。两个模型都支持微调。

Gpt-oss-120b 模型在核心推理基准测试中与 OpenAI o4-mini 模型几乎持平,并且能够能够通过浏览工具快速检索并聚合最新信息。

本次开源的关键点:

- 自由使用,不受版权限制或专利风险。允许实验、定制和商业部署。

- 可微调训练。

- 模型推理可视化(思维链):可以访问模型的推理过程,从而进行更好地调试与微调训练。

- 模型可作为Agent:可以进行网页浏览与信息聚合、调用函数、进行结构化的输出。

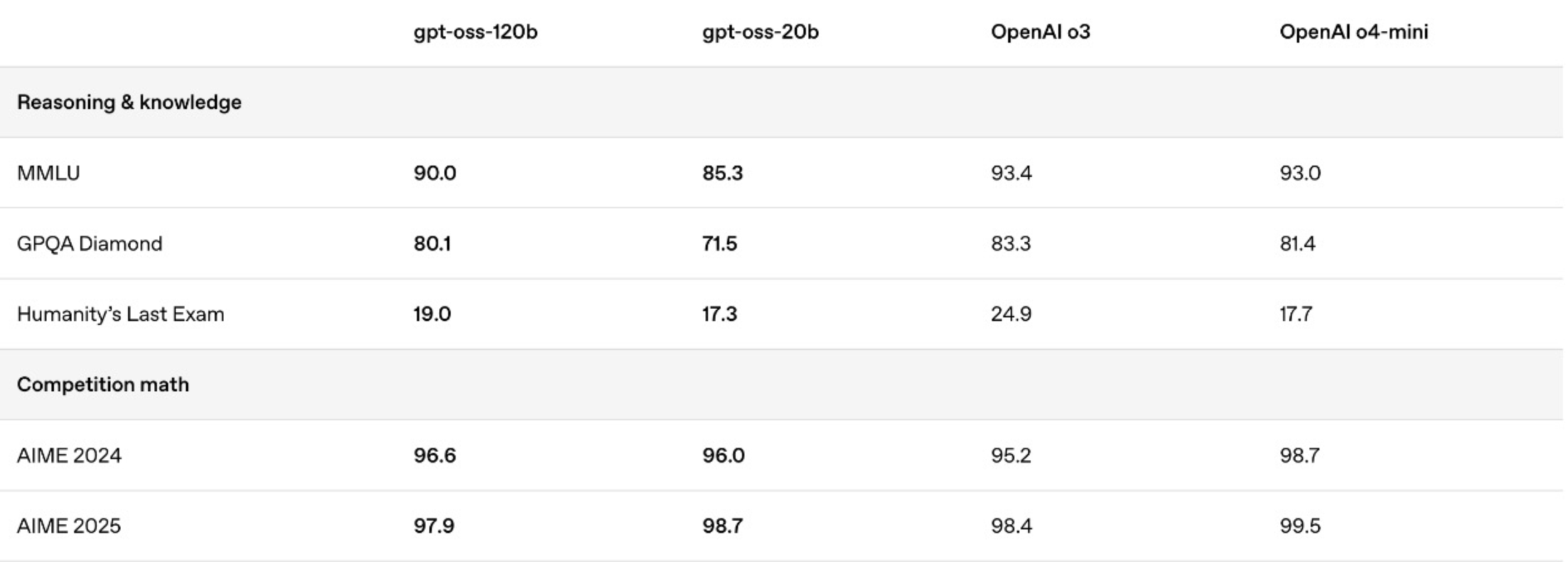

关键的评估指标:(本图转自“机器之心”)

#1. 模型架构

以上两款模型都是 Transformer 结构,它们利用专家混合 (MoE) 来减少推理时的活跃参数数量。其中Gpt-oss-120b 每个令牌激活 51 亿个参数,而 gpt-oss-20b 激活 36 亿个参数。

这两个模型的总参数数分别为 1,170 亿和 210 亿。这些模型采用交替的密集和局部带状稀疏注意力模式,与 GPT‑3 类似。为了提高推理和内存效率,这些模型还使用分组多查询注意力,分组大小为 8。并使用旋转位置嵌入 (RoPE[4]) 进行位置编码,并原生支持长达 128k 的上下文长度。

| 模型 | 总参数 | 模型大小 | 每个令牌的活跃参数 | 总专家数 | 每个令牌的活跃专家数 | 上下文长度 | 层数 |

|---|---|---|---|---|---|---|---|

| gpt-oss-120b | 117b | 60.8GiB | 5.1b | 128 | 4 | 128k | 36 |

| gpt-oss-20b | 21b | 12.8GiB | 3.6b | 32 | 4 | 128k | 24 |

| Component | 120b | 20b |

|---|---|---|

| MLP层 | 114.71B | 19.12B |

| Attention层 | 0.96B | 0.64B |

| Embed + Unembed层 | 1.16B | 1.16B |

| 活跃参数 | 5.13B | 3.61B |

| 总参数 | 116.83B | 20.91B |

#2. 预训练 && 后训练

一个高质量、主要为英文的纯文本数据集对模型进行了训练,重点关注 STEM、编程和通用知识领域。我们使用了 OpenAI o4-mini 和 GPT‑4o 所用tokenizer 的超集进行 token 操作,即 ‘o200k_harmony’,该 tokenizer 也已经开源。

模型采用了与 O4-mini 类似的训练流程进行后训练,包括监督式微调阶段和高计算量强化学习阶段。

二、模型下载 && 推理

#1. 模型下载

想快速尝试效果的话:通过Ollama 下载(以gpt-oss-120b为例):

# Step0. 安装Ollama

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz# Step1. 启动服务

ollama serve# Step2. 下载模型

ollama pull gpt-oss:120b# Step3. 运行推理

ollama run gpt-oss:120b

想自己微调的话:通过huggingface-cli下载**(以gpt-oss-120b为例):

# Step1. 下载模型

huggingface-cli download openai/gpt-oss-120b --include "original/*" --local-dir gpt-oss-120b/# Step2. 安装依赖 && 运行推理

pip install gpt-oss

python -m gpt_oss.chat model/

Tip:笔者在2025.8.6尝试时发现不用huggingface的API Key。

通过网页下载:

- https://huggingface.co/openai/gpt-oss-120b/tree/main

#2. 推理代码(参考用)

安装依赖

pip install -U transformers kernels torch

推理代码

from transformers import pipeline

import torchmodel_id = "openai/gpt-oss-120b"pipe = pipeline("text-generation",model=model_id,torch_dtype="auto",device_map="auto",

)messages = [{"role": "user", "content": "Explain quantum mechanics clearly and concisely."},

]outputs = pipe(messages,max_new_tokens=256,

)

print(outputs[0]["generated_text"][-1])

三、模型的各项评估

gpt-oss-120b 和 gpt-oss-20b 在标准学术基准测试中进行了评估,以衡量在编程、竞赛数学、医疗和智能体工具使用方面的能力,并与其他 OpenAI 推理模型(包括 o3、o3‑mini 和 o4-mini)进行了比较。

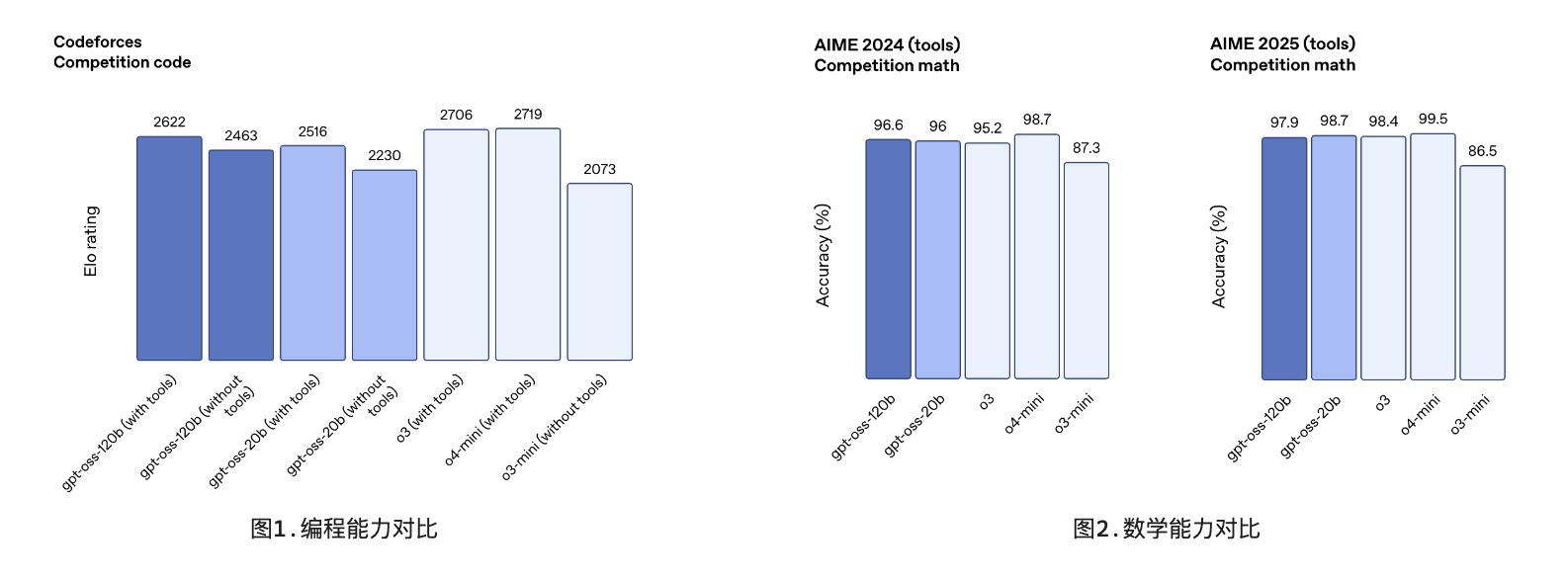

#1. 编程 && 数学

编程与数学能力如下图所示:

可以看到,Gpt-oss-120b 在「编程」方面表现优于 OpenAI o3‑mini,并与 OpenAI o4-mini 持平或超越其性能。

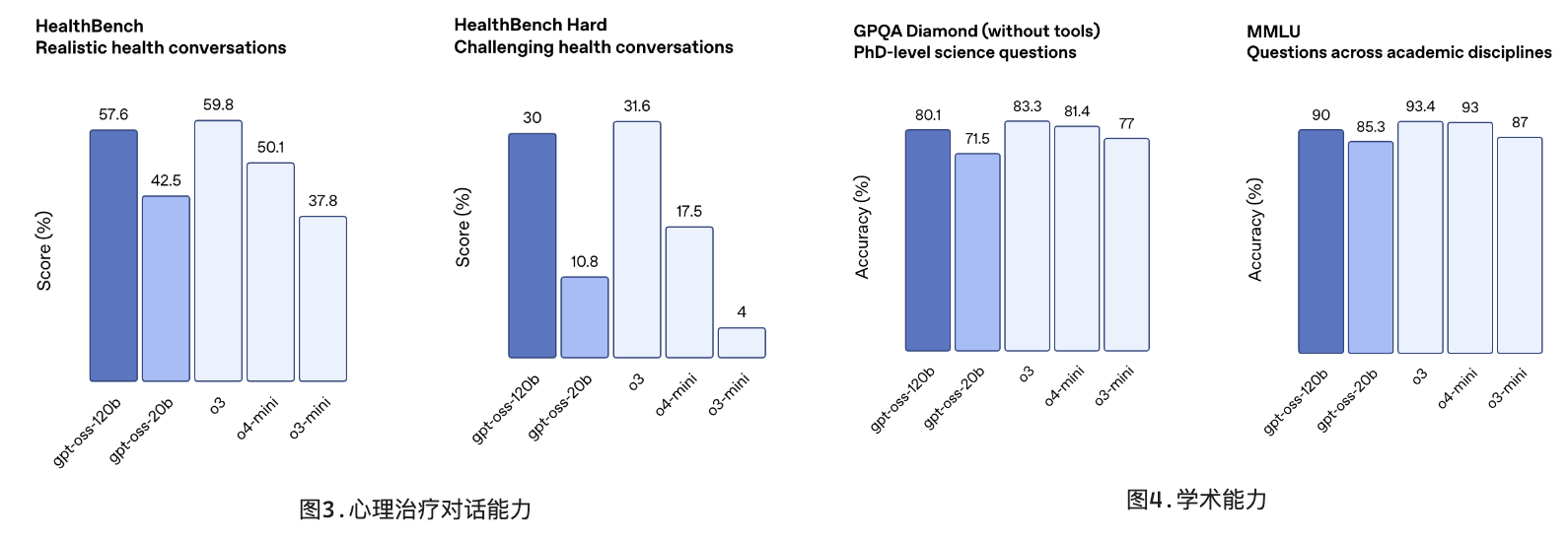

#2. 心理对话 && 学术能力

可以看到,Gpt-oss-120b 在「心理治疗对话」和「竞赛数学」方面表现得比 o4-mini 更好。

尽管 gpt-oss-20b 的规模较小,但在这些相同的评估中,它与 OpenAI o3‑mini 持平或超越后者,甚至在竞赛数学和医疗方面表现得更好。

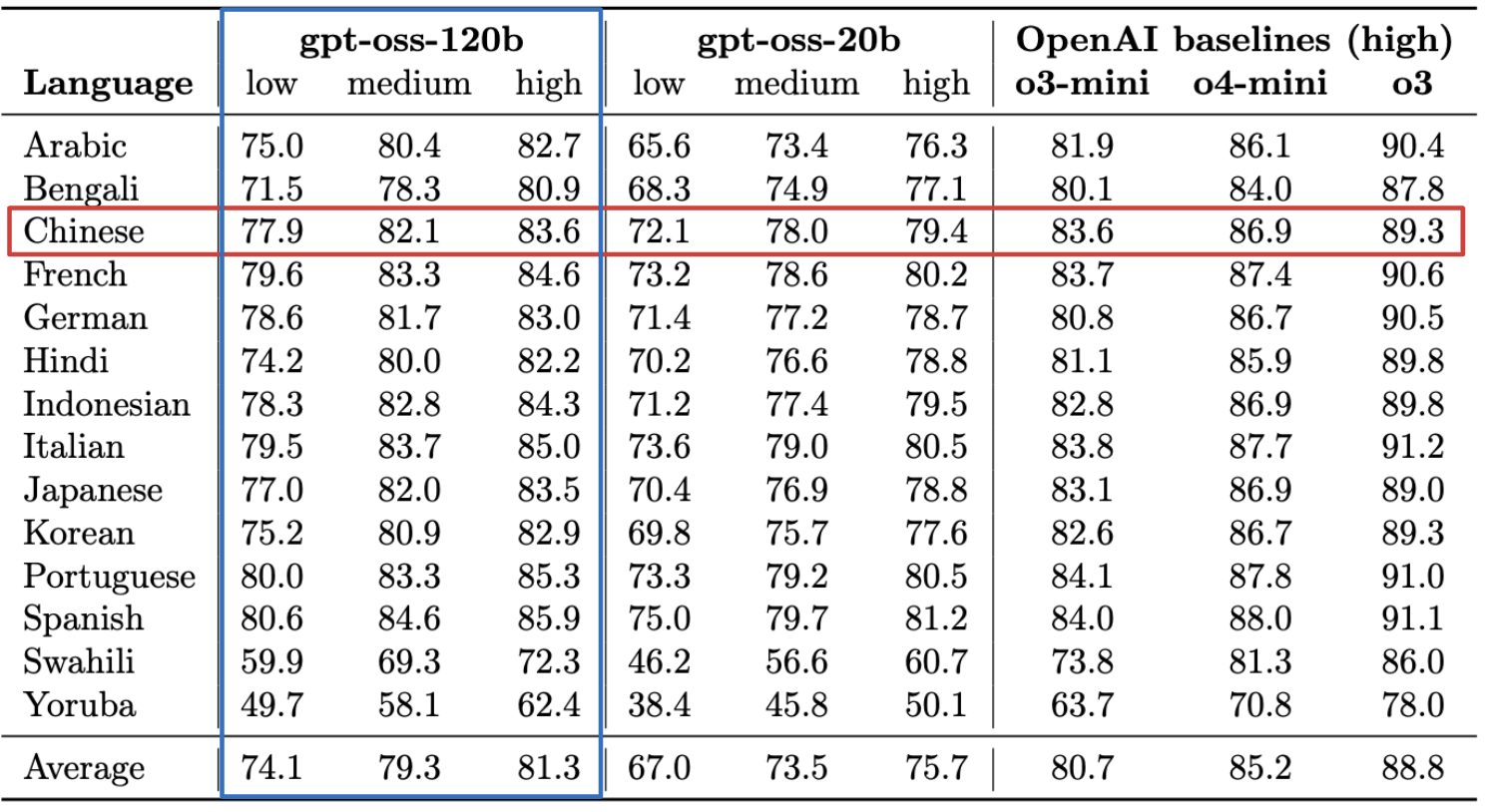

#3. 多语言能力

多语言对话能力如下所示,其中红框为中文能力。

到底咯,如果这篇文章对您有些许帮助,请帮忙点个赞👍或收个藏📃。您的支持是我继续创作的动力💪!

当暴风雨⚡️过去,你不会记得自己是如何度过的,你甚至不确定暴风雨是否真的结束了。但你已经不再是当初走进暴风雨的那个人了,这就是暴风雨的意义💪。