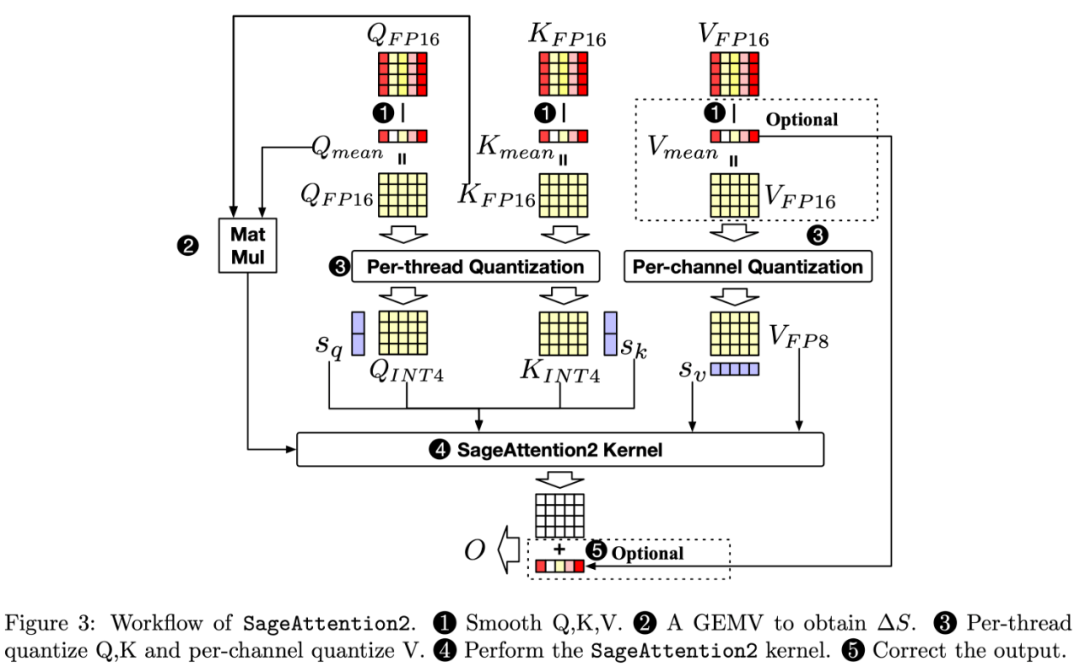

UNet改进(30):SageAttention在UNet中的4-Bit量化实现详解

1. 注意力机制与量化技术概述

1.1 注意力机制的发展

注意力机制源于人类视觉系统的启发,它允许模型在处理信息时"聚焦"于最重要的部分。从早期的SE(Squeeze-and-Excitation)模块到后来的Self-Attention,注意力机制在各种计算机视觉任务中展现出了卓越的性能提升能力。

传统注意力机制通常通过以下步骤实现:

-

特征压缩:通过全局平均池化获取通道级统计信息

-

特征激励:使用全连接层学习通道间关系

-

权重应用:将学习到的注意力权重应用于原始特征图

1.2 量化技术的必要性

量化技术通过降低神经网络中权重和激活值的数值精度来减少模型大小和计算开销。在边缘设备和移动应用中,量化已成为模型部署的标准技术之一。

常见的量化位宽包括:

-

32-bit浮点(FP32):标准训练精度

-

16-bit浮点(FP16):混合精度训练

-

8-bit整数(INT8):常见推理精度

-

4-bit整数(INT4):极限压缩方案

<