疏老师-python训练营-Day33 MLP神经网络的训练

@浙大疏锦行

知识点回顾:

- PyTorch和cuda的安装

- 查看显卡信息的命令行命令(cmd中使用)

- cuda的检查

- 简单神经网络的流程

- 数据预处理(归一化、转换成张量)

- 模型的定义

- 继承nn.Module类

- 定义每一个层

- 定义前向传播流程

- 定义损失函数和优化器

- 定义训练流程

- 可视化loss过程

预处理补充:

注意事项:

1. 分类任务中,若标签是整数(如 0/1/2 类别),需转为long类型(对应 PyTorch 的torch.long),否则交叉熵损失函数会报错。

2.回归任务中,标签需转为float类型(如torch.float32)。

在新建网络的时候,我们选择了2层隐藏层和固定的神经元,这类似于我们在机器学习模型中指定一组超参数,神经网络的调参我们未来再提。

作业:今日的代码,要做到能够手敲。这已经是最简单最基础的版本了。

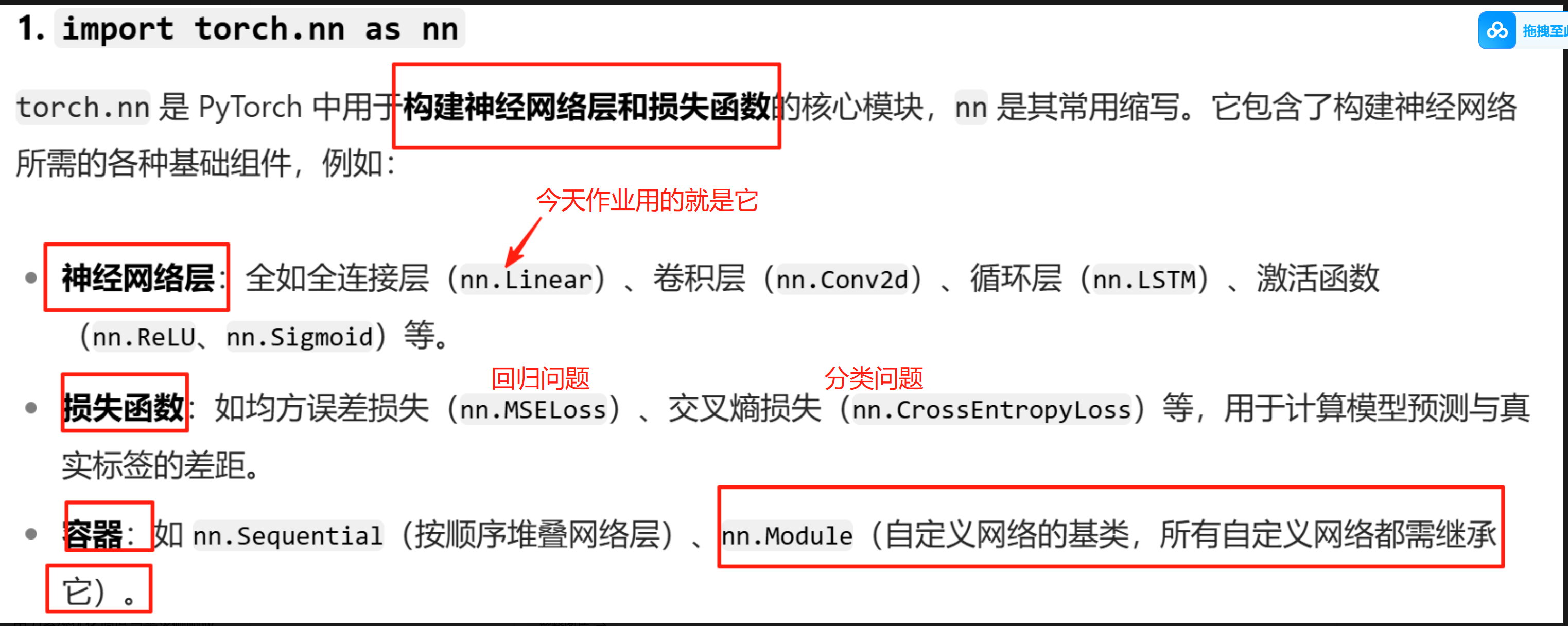

0.知识点学习

DAY33

默认大家已经有一定的神经网络基础,该部分已经在复试班的深度学习部分介绍完毕,如果没有,你需要自行了解下MLP的概念。

你需要知道

- 梯度下降的思想

- 激活函数的作用

- 损失函数的作用

- 优化器

- 神经网络的概念

神经网络由于内部比较灵活,所以封装的比较浅,可以对模型做非常多的改进,而不像机器学习三行代码固定。

PyTorch的安装

我们后续完成深度学习项目中,主要使用的包为pytorch,所以需要安装,你需要去配置一个新的环境。

未来在复现具体项目时候,新环境命名最好是python版本_pytorch版本_cuda版本,例如 py3.10_pytorch2.0_cuda12.2 ,因为复杂项目对运行环境有要求,所以需要安装对应版本的包。

我们目前主要不用这么严格,先创建一个命名为DL的新环境即可,也可以沿用之前的环境

conda create -n DL python=3.8 conda env list conda activate DL conda install jupyter (如果conda无法安装jupyter就参考环境配置文档的pip安装方法) pip insatll scikit-learn 然后对着下列教程安装pytorch

深度学习主要是简单的并行计算,所以gpu优势更大,简单的计算cpu发挥不出来他的价值,我们之前说过显卡和cpu的区别:

- cpu是1个博士生,能够完成复杂的计算,串行能力强。

- gpu是100个小学生,能够完成简单的计算,人多计算的快。

这里的gpu指的是英伟达的显卡,它支持cuda可以提高并行计算的能力。

如果你是amd的显卡、苹果的电脑,那样就不需要安装cuda了,直接安装pytorch-gpu版本即可。cuda只支持nvidia的显卡。

安装教程

或者去b站随便搜个pytorch安装视频。

- 怕麻烦直接安装cpu版本的pytorch,跑通了用云服务器版本的pytorch-gpu

- gpu的pytorch还需要额外安装cuda cudnn组件

准备工作

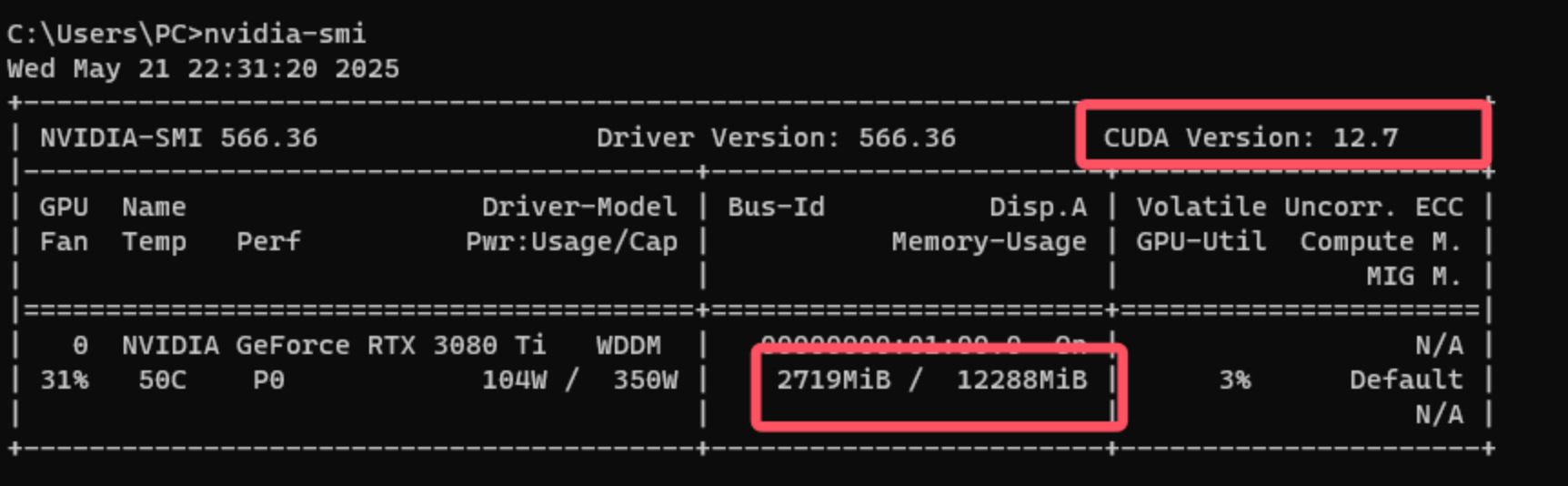

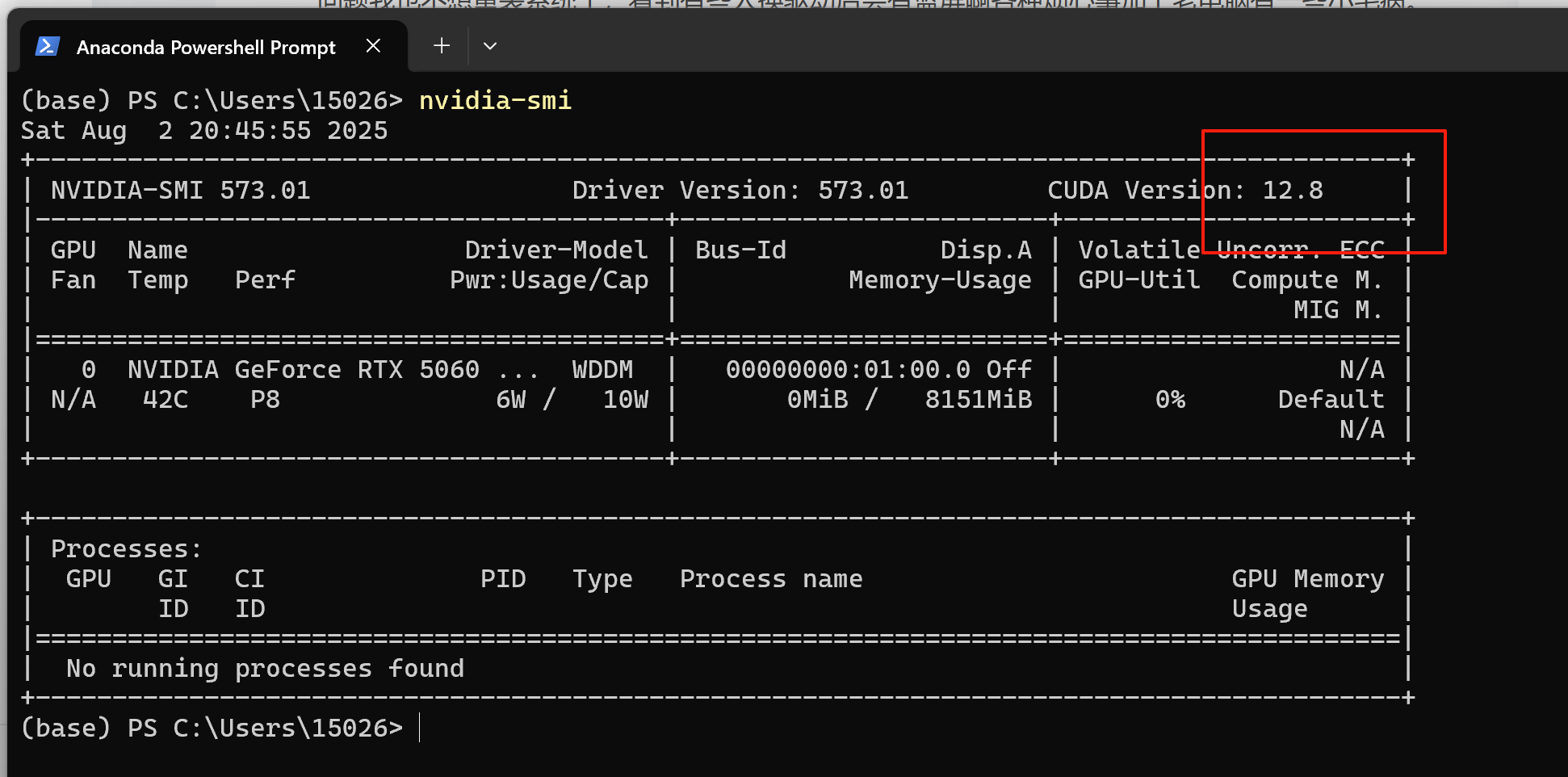

可以在你电脑的cmd中输入nvidia-smi来查看下显卡信息

其中最重要的2个信息,分别是:

- 显卡目前驱动下最高支持的cuda版本,12.7

- 显存大小,12288 MiB ÷ 1024 = 12

PS:之所以输入这个命令,可以弹出这些信息,是因为为系统正确安装了 NVIDIA 显卡驱动程序,并且相关路径被添加到了环境变量中。如果你不是英伟达的显卡,自然无法使用这个命令。

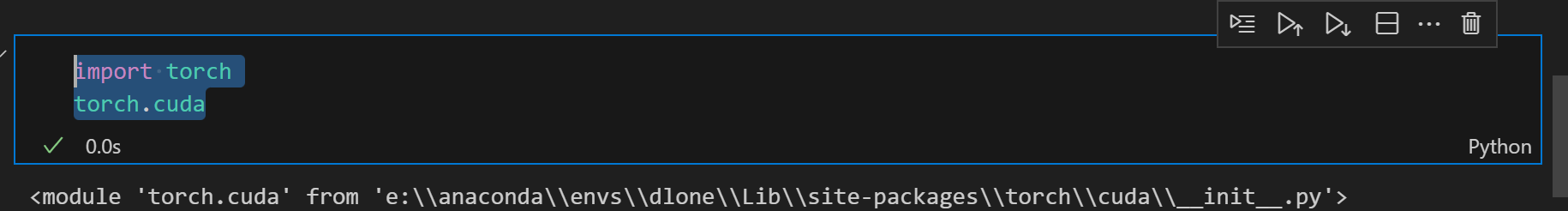

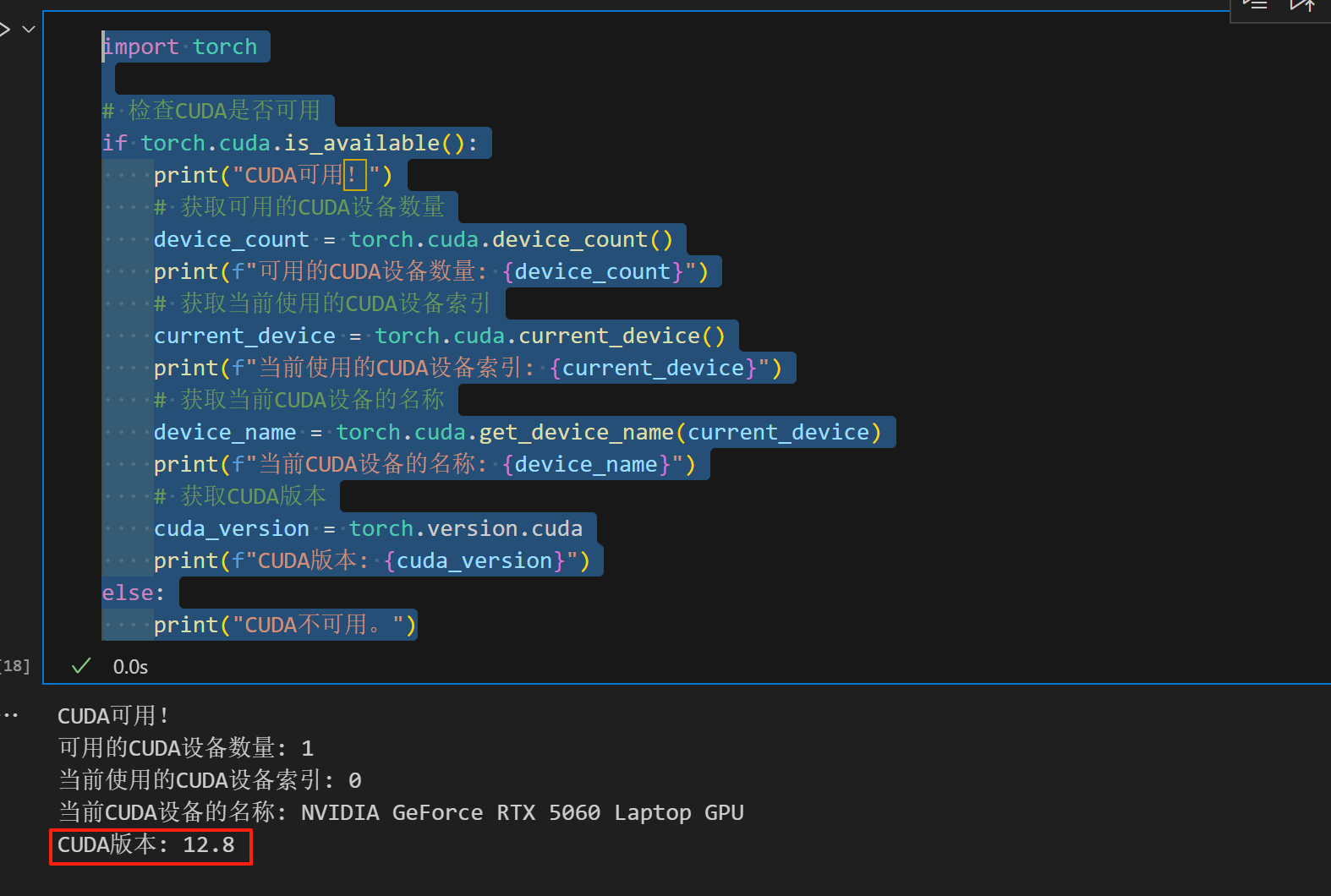

import torch# 检查CUDA是否可用

if torch.cuda.is_available():print("CUDA可用!")# 获取可用的CUDA设备数量device_count = torch.cuda.device_count()print(f"可用的CUDA设备数量: {device_count}")# 获取当前使用的CUDA设备索引current_device = torch.cuda.current_device()print(f"当前使用的CUDA设备索引: {current_device}")# 获取当前CUDA设备的名称device_name = torch.cuda.get_device_name(current_device)print(f"当前CUDA设备的名称: {device_name}")# 获取CUDA版本cuda_version = torch.version.cudaprint(f"CUDA版本: {cuda_version}")

else:print("CUDA不可用。")CUDA可用! 可用的CUDA设备数量: 1 当前使用的CUDA设备索引: 0 当前CUDA设备的名称: NVIDIA GeForce RTX 3080 Ti CUDA版本: 11.1

这里的cuda版本是实际安装的cuda驱动的版本,需要小于显卡所支持的最高版本

上述这段代码,可以以后不断复用,检查是否有pytorch及cuda相关信息,我们今天先用cpu训练,不必在意,有没有cuda不影响。

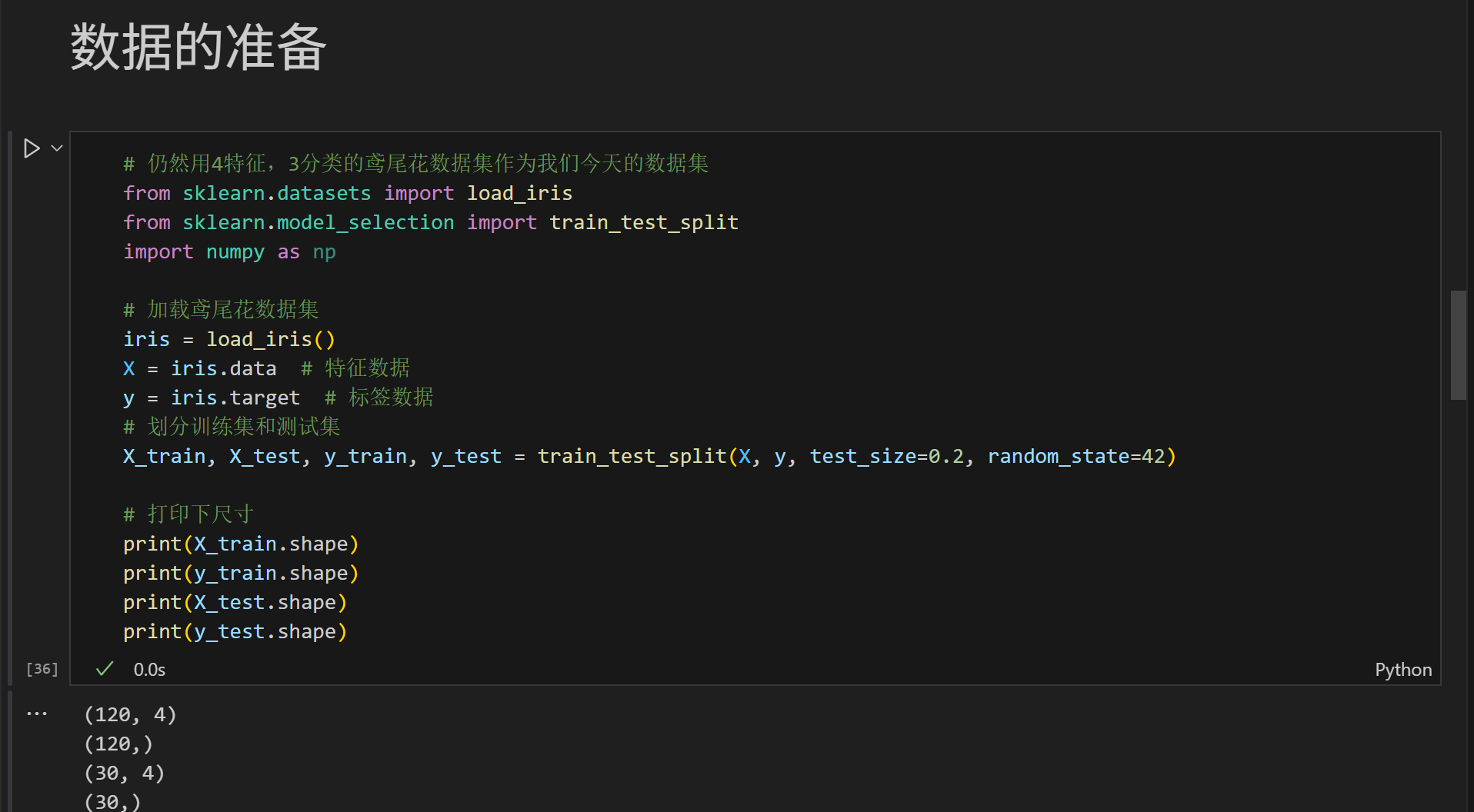

数据的准备

# 仍然用4特征,3分类的鸢尾花数据集作为我们今天的数据集

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

import numpy as np# 加载鸢尾花数据集

iris = load_iris()

X = iris.data # 特征数据

y = iris.target # 标签数据

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 打印下尺寸

print(X_train.shape)

print(y_train.shape)

print(X_test.shape)

print(y_test.shape)(120, 4) (120,) (30, 4) (30,)

# 归一化数据,神经网络对于输入数据的尺寸敏感,归一化是最常见的处理方式

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test) #确保训练集和测试集是相同的缩放# 将数据转换为 PyTorch 张量,因为 PyTorch 使用张量进行训练

# y_train和y_test是整数,所以需要转化为long类型,如果是float32,会输出1.0 0.0

X_train = torch.FloatTensor(X_train)

y_train = torch.LongTensor(y_train)

X_test = torch.FloatTensor(X_test)

y_test = torch.LongTensor(y_test)模型架构定义

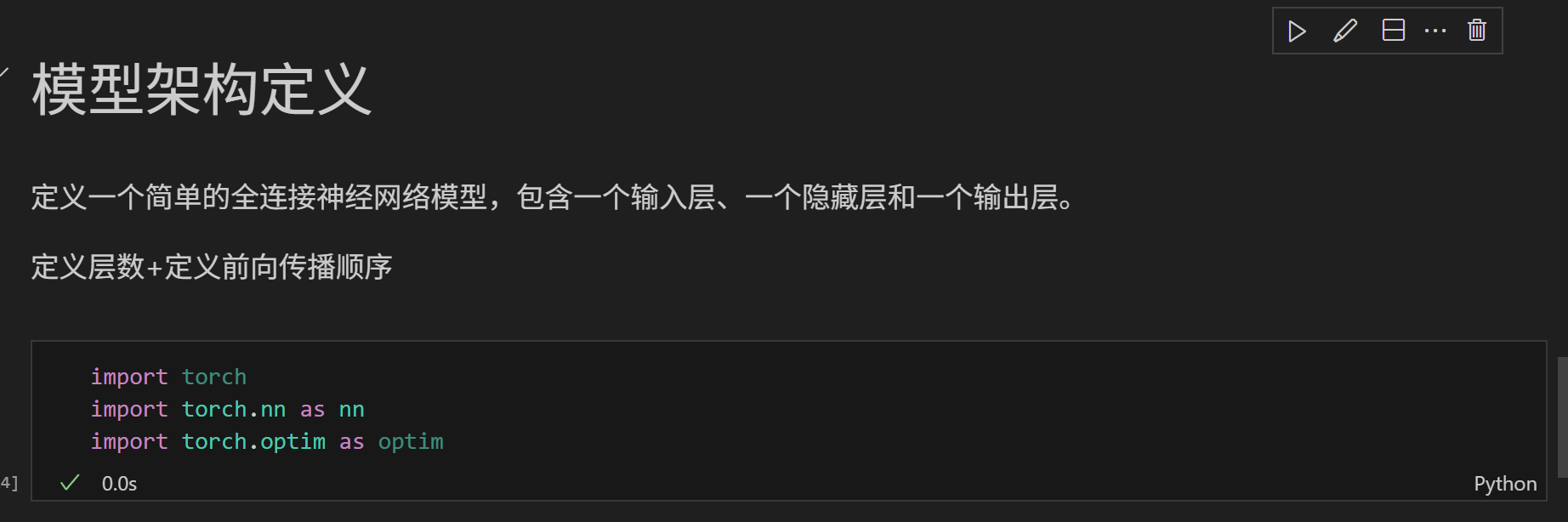

定义一个简单的全连接神经网络模型,包含一个输入层、一个隐藏层和一个输出层。

定义层数+定义前向传播顺序

import torch

import torch.nn as nn

import torch.optim as optimclass MLP(nn.Module): # 定义一个多层感知机(MLP)模型,继承父类nn.Moduledef __init__(self): # 初始化函数super(MLP, self).__init__() # 调用父类的初始化函数# 前三行是八股文,后面的是自定义的self.fc1 = nn.Linear(4, 10) # 输入层到隐藏层self.relu = nn.ReLU()self.fc2 = nn.Linear(10, 3) # 隐藏层到输出层

# 输出层不需要激活函数,因为后面会用到交叉熵函数cross_entropy,交叉熵函数内部有softmax函数,会把输出转化为概率def forward(self, x):out = self.fc1(x)out = self.relu(out)out = self.fc2(out)return out# 实例化模型

model = MLP()其实模型层的写法有很多,relu也可以不写,在后面前向传播的时候计算下即可,因为relu其实不算一个层,只是个计算而已。

# def forward(self,x): #前向传播# x=torch.relu(self.fc1(x)) #激活函数# x=self.fc2(x) #输出层不需要激活函数,因为后面会用到交叉熵函数cross_entropy# return x模型训练(CPU版本)

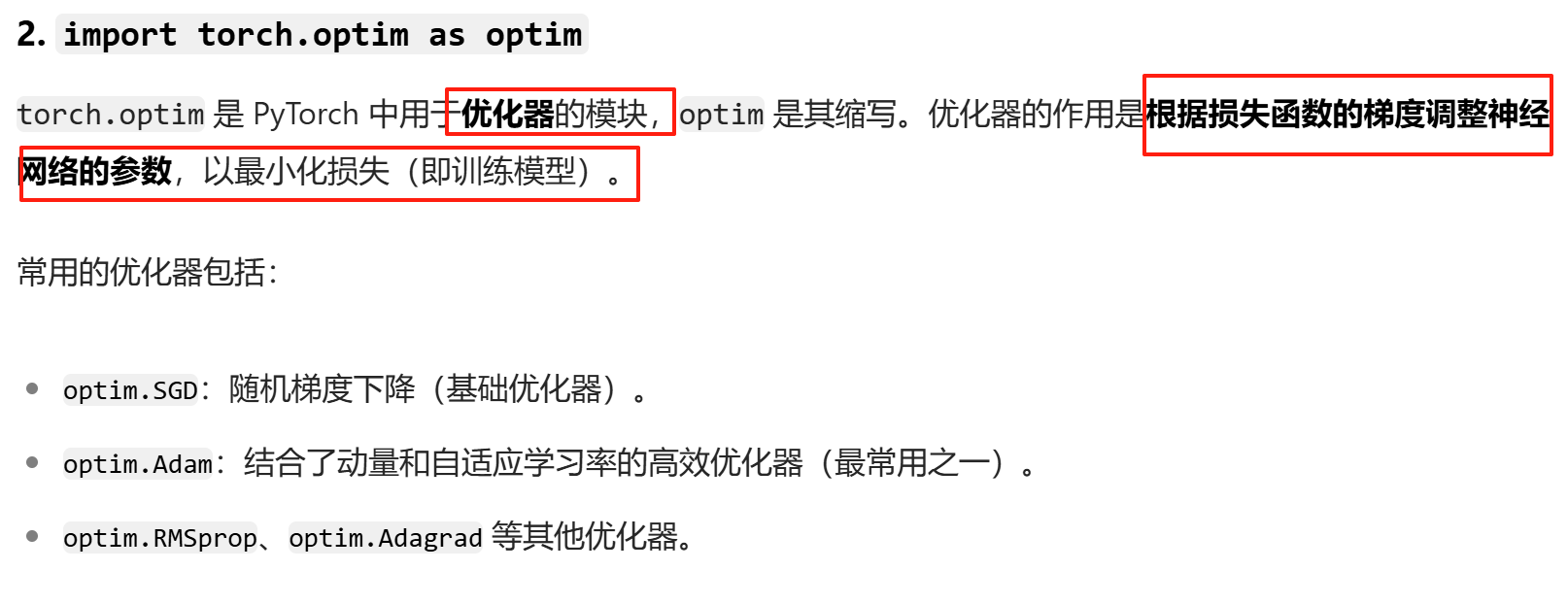

定义损失函数和优化器

# 分类问题使用交叉熵损失函数

criterion = nn.CrossEntropyLoss()# 使用随机梯度下降优化器

optimizer = optim.SGD(model.parameters(), lr=0.01)# # 使用自适应学习率的化器

# optimizer = optim.Adam(model.parameters(), lr=0.001)开始循环训练

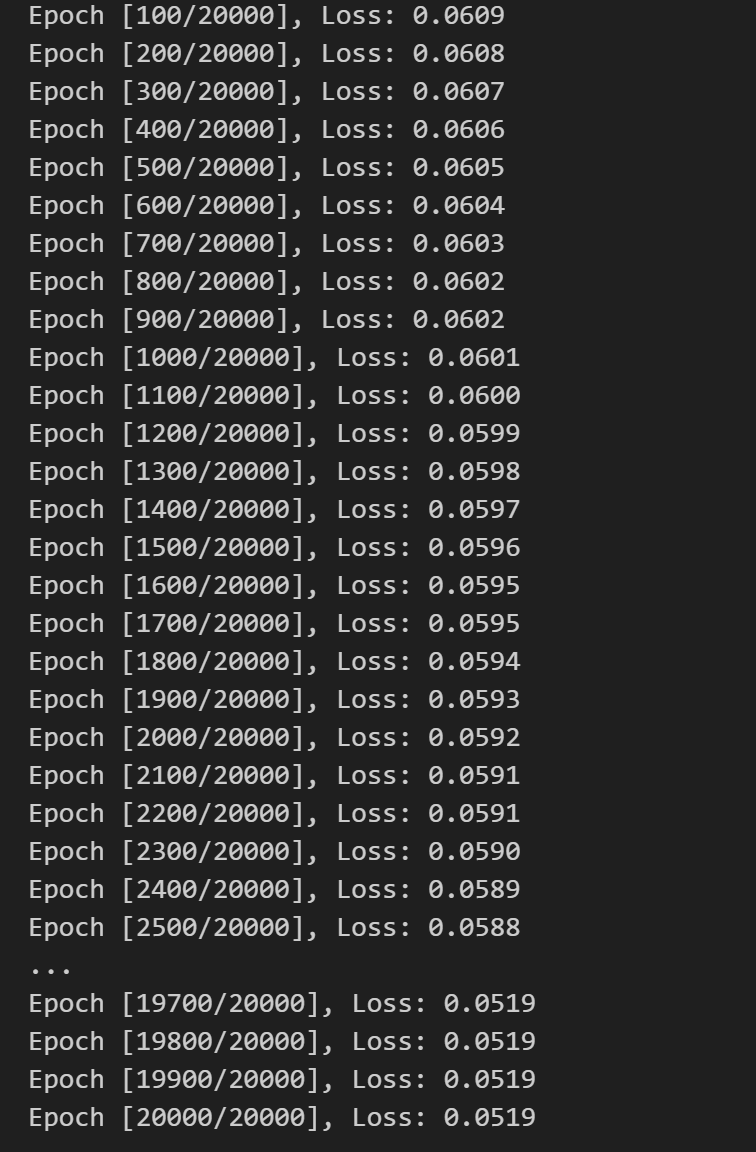

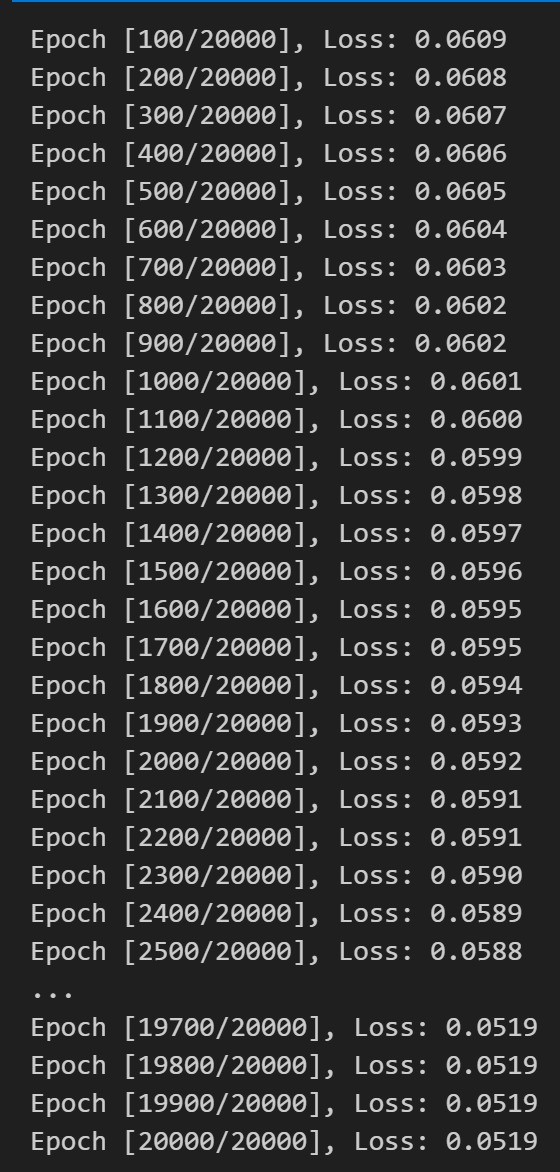

实际上在训练的时候,可以同时观察每个epoch训练完后测试集的表现:测试集的loss和准确度

# 训练模型

num_epochs = 20000 # 训练的轮数# 用于存储每个 epoch 的损失值

losses = []for epoch in range(num_epochs): # range是从0开始,所以epoch是从0开始# 前向传播outputs = model.forward(X_train) # 显式调用forward函数# outputs = model(X_train) # 常见写法隐式调用forward函数,其实是用了model类的__call__方法loss = criterion(outputs, y_train) # output是模型预测值,y_train是真实标签# 反向传播和优化optimizer.zero_grad() #梯度清零,因为PyTorch会累积梯度,所以每次迭代需要清零,梯度累计是那种小的bitchsize模拟大的bitchsizeloss.backward() # 反向传播计算梯度optimizer.step() # 更新参数# 记录损失值losses.append(loss.item())# 打印训练信息if (epoch + 1) % 100 == 0: # range是从0开始,所以epoch+1是从当前epoch开始,每100个epoch打印一次print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}')

如果你重新运行上面这段训练循环,模型参数、优化器状态和梯度会继续保留,导致训练结果叠加,模型参数和优化器状态(如动量、学习率等)不会被重置。这会导致训练从之前的状态继续,而不是从头开始

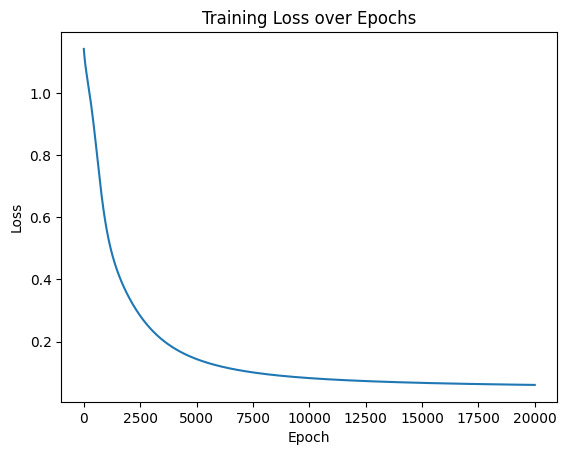

可视化结果

import matplotlib.pyplot as plt

# 可视化损失曲线

plt.plot(range(num_epochs), losses)

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.title('Training Loss over Epochs')

plt.show()

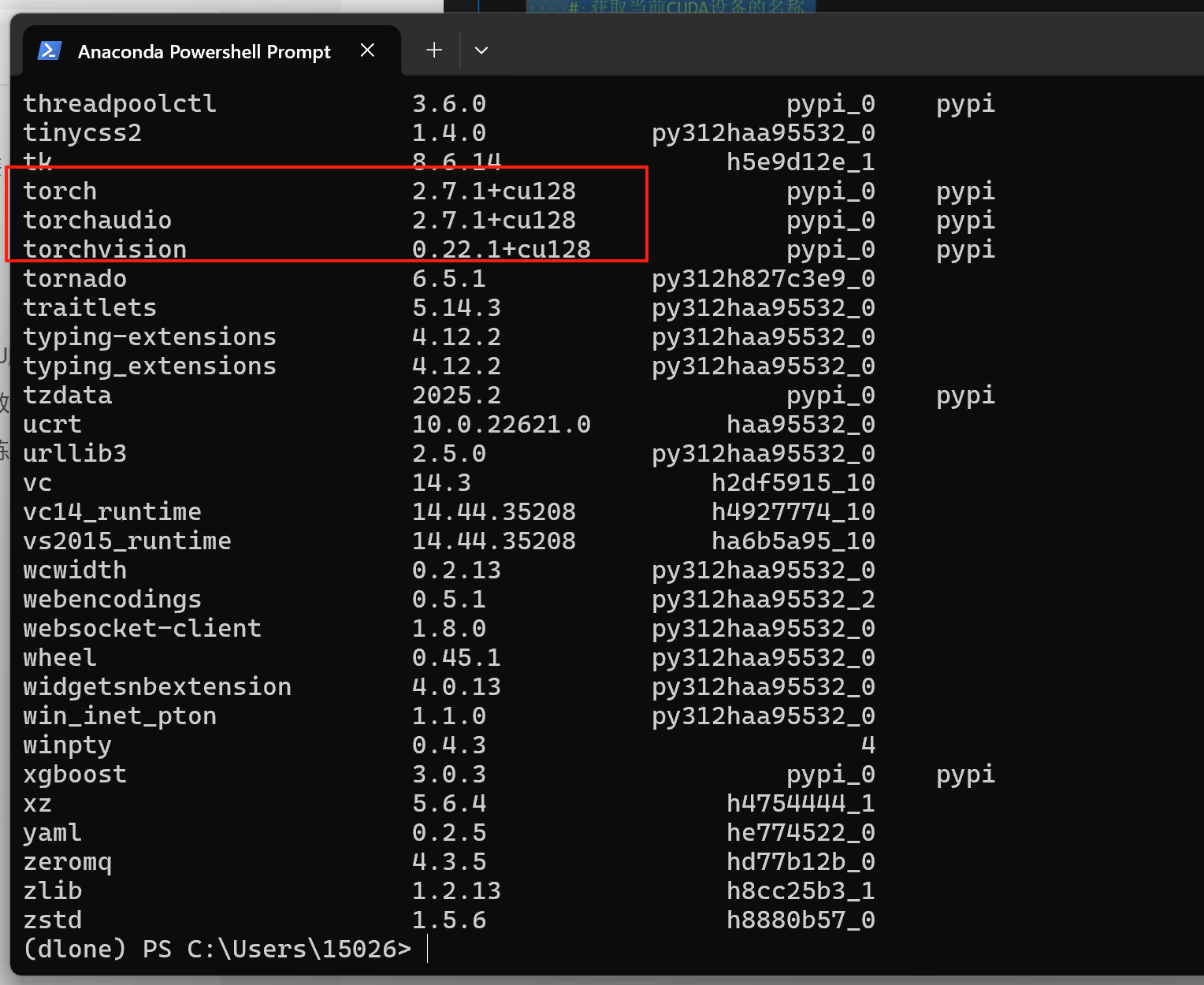

一.自己安装cuda+cudnn+pytorch

在第0节知识点的学习中,老师有分享安装教程。但是那个安装教程对于部分显卡有存在一些问题。

1.如果你是10系显卡比如我的老电脑是16年买的游戏本。是gtx1060并且我的驱动才393吧,那老师提供的安装教程,你不用看了。驱动版本太低,你可能连查支持cuda最高版本的指令nvidia-smi,你都查不出来。我这里推荐给大家一个教程讲的很详细。GTX1060+win10+CUDA11.3+cudnn8.2+pytorch1.11.0——个人配置踩坑日记

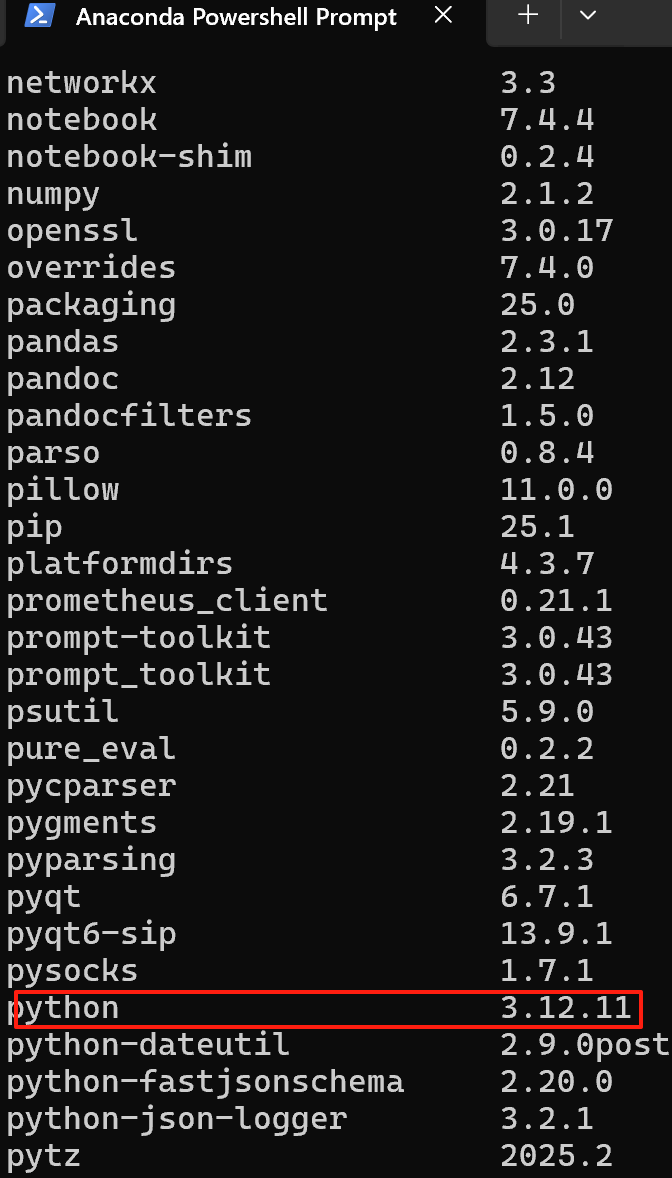

2.我老电脑显卡驱动版本393,太低了。想更新驱动,但是老电脑win10好久没更新怕换完驱动出现问题我也不想重装系统了,看到有些人换驱动后会有蓝屏啊各种烦心事加上老电脑有一些小毛病又笨重读研不方便。所以我买了个新电脑。是50系显卡,50系也要注意,如果你用教程的12.0或者老师的11.3是不兼容的。RTX50系显卡+CUDA+torch+python对应关系,我的python版本是3.12,必须>=3.9。老师推荐的教程可以看,但是装的cuda版本,请看我推荐的链接。

然后再装什么jupyter,numpy,pandas,seaborn等库(就和老师复试班环境配置那一节装的包一样)

2.自己对于代码学习的笔记

2.1数据准备

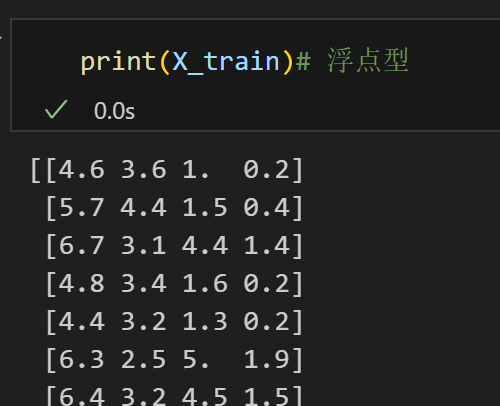

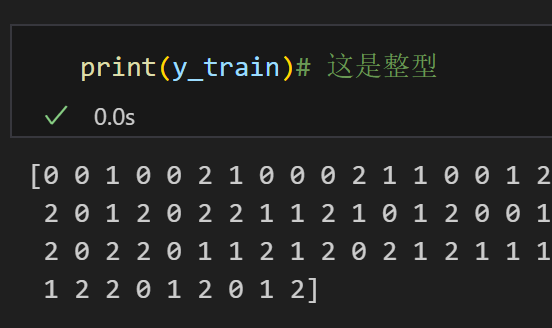

2.2通过print知道X都是浮点型,而y是整型

2.3归一化

# 归一化数据,神经网络对于输入数据的尺寸敏感,归一化是最常见的处理方式

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test) #确保训练集和测试集是相同的缩放

# fit_transform.对 X_train 进行归一化(或标准化,取决于 scaler 类型)处理,并将处理后的结果覆盖原来的 X_train 变量。2.4将数据转换为张量,数据的类型查看可以用2.2节的print语句看

# 将数据转换为 PyTorch 张量,因为 PyTorch 使用张量进行训练

# y_train和y_test是整数,所以需要转化为long类型,如果是float32,会输出1.0 0.0

X_train = torch.FloatTensor(X_train)

y_train = torch.LongTensor(y_train)

X_test = torch.FloatTensor(X_test)

y_test = torch.LongTensor(y_test)2.5定义一个简单的全连接神经网络

2.6定义一个MLP模型,并实例化。这段代码要去理解一下 self.fc1,self.relu,self.fc2里的含义

class MLP(nn.Module): # 定义一个多层感知机(MLP)模型,继承父类nn.Moduledef __init__(self): # 初始化函数super(MLP, self).__init__() # 调用父类的初始化函数# 前三行是八股文,后面的是自定义的self.fc1 = nn.Linear(4, 10) # 输入层到隐藏层self.relu = nn.ReLU()self.fc2 = nn.Linear(10, 3) # 隐藏层到输出层

# 输出层不需要激活函数,因为后面会用到交叉熵函数cross_entropy,交叉熵函数内部有softmax函数,会把输出转化为概率def forward(self, x):out = self.fc1(x)out = self.relu(out)out = self.fc2(out)return out# 实例化模型

model = MLP()self.fc1 = nn.Linear(4, 10) # 输入层到隐藏层

参数 (4, 10) 表示:

第一个数字 4:输入特征的维度(即输入层的神经元数量为 4)。这意味着该网络要求输入数据的每个样本必须是 4 维的(假设处理的是包含 4 个特征的数据,如鸢尾花数据集的 4 个特征)就是前面的x_train.shape这个函数输出结果的第二列。

第二个数字 10:输出特征的维度(即隐藏层的神经元数量为 10)。经过这个全连接层后,数据会从 4 维转换为 10 维。

这一行代码实现了输入层到隐藏层的映射。

self.relu = nn.ReLU()

nn.ReLU() 是激活函数(Rectified Linear Unit),作用是给神经网络引入非线性特性。

它的计算规则很简单:ReLU(x) = max(0, x)(即保留正数,负数变为 0)。

在全连接层之后加入激活函数,能让网络学习更复杂的非线性关系(如果没有激活函数,多层线性层的叠加等价于单层线性层,无法拟合复杂数据)。

self.fc2 = nn.Linear(10, 3)

这是第二个全连接层,实现隐藏层到输出层的映射。

参数 (10, 3) 表示:

第一个数字 10:输入特征的维度(与上一层的输出维度一致,即隐藏层的 10 个神经元)。

第二个数字 3:输出特征的维度(即输出层的神经元数量为 3)。这通常对应任务的类别数(例如,鸢尾花数据集有 3 个类别,输出层的 3 个神经元可分别表示每个类别的预测概率)。如果是2分类问题,就是2或者1。

2.7模型的训练

# 分类问题使用交叉熵损失函数

criterion = nn.CrossEntropyLoss()# 使用随机梯度下降优化器

optimizer = optim.SGD(model.parameters(), lr=0.01)

# model.parameters() 会返回神经网络中所有可学习的参数(如权重 w 和偏置 b),这些参数是优化器需要调整的对象。# # 使用自适应学习率的化器

# optimizer = optim.Adam(model.parameters(), lr=0.001)# 训练模型

num_epochs = 20000 # 训练的轮数# 用于存储每个 epoch 的损失值

losses = []for epoch in range(0,num_epochs): # range是从0开始,所以epoch是从0开始# 前向传播outputs = model.forward(X_train) # 显式调用forward函数# outputs = model(X_train) # 常见写法隐式调用forward函数,其实是用了model类的__call__方法loss = criterion(outputs, y_train) # output是模型预测值,y_train是真实标签# 反向传播和优化optimizer.zero_grad() #梯度清零,因为PyTorch会累积梯度,所以每次迭代需要清零,梯度累计是那种小的batchsize模拟大的batchsizeloss.backward() # 反向传播计算梯度optimizer.step() # 更新参数# 记录损失值losses.append(loss.item())# 打印训练信息if (epoch + 1) % 100 == 0: # range是从0开始,所以epoch+1是从当前epoch开始,每100个epoch打印一次print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}')

我的loss比起老师的示例要小很多,因为我跑了好几次了。