大模型幻觉的本质:深度=逻辑层次,宽度=组合限制,深度为n的神经网络最多只能处理n层逻辑推理,宽度为w的网络无法区分超过w+1个复杂对象的组合

大模型幻觉的本质:深度=逻辑层次,宽度=组合限制,深度为n的神经网络最多只能处理n层逻辑推理,宽度为w的网络无法区分超过w+1个复杂对象的组合

- 🧩 "深度=逻辑层次"具体含义

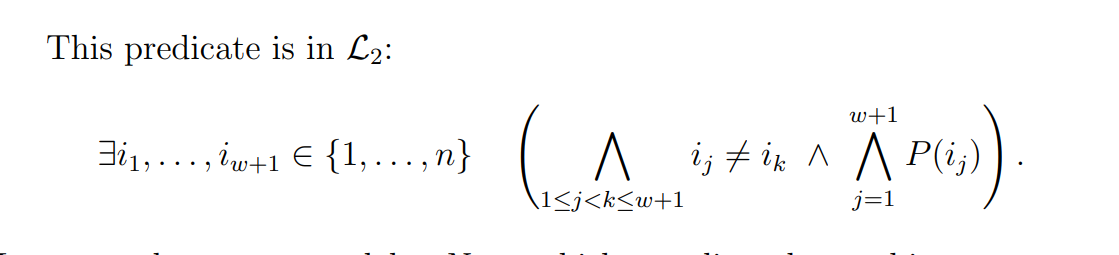

- 🔢 "宽度=组合限制"具体含义

- 大模型幻觉的本质:幻觉是AI尽力而为的结果

- 模式1:逻辑链断裂型幻觉

- 模式2:组合过载型幻觉

- 模式3:知识拼接型幻觉

- 🏥 在医学推理中的实际影响

- 类型1:逻辑深度不够(深度限制)

- 类型2:组合复杂度超限(宽度限制)

- 类型3:药物相互作用(综合限制)

- 设计更好的网络结构方面:

- 识别AI不适用场景方面:

- 分析这对医学大模型的具体影响:

- 核心问题:医学诊断的复杂性挑战、罕见病诊断的特殊挑战、药物相互作用的复杂性,能不能用多智能体系统弥补呢?

- 🏥 医学多智能体系统设计方案

论文:On the Limits of Hierarchically Embedded Logic in Classical Neural Networks

问1:这篇论文最终想说明什么?

答1:神经网络(如ChatGPT)在逻辑推理上有根本性限制,不是因为训练不够,而是因为数学结构本身的限制。

问2:什么叫"根本性限制"?

答2:就像一个只有10个手指的人,无论怎么训练都无法同时按住钢琴上的20个键一样,是结构决定的,不是能力问题。

问3:神经网络的结构到底限制了什么?

答3:限制了它能处理的逻辑复杂度。比如它能理解"苹果是红的",但处理"数出所有红色水果的种类"这种复杂逻辑就困难。

问4:为什么复杂逻辑更困难?

答4:因为复杂逻辑需要更多的"逻辑层次",而每一层神经网络只能增加一个逻辑层次。

问5:什么是"逻辑层次"?

答5:像搭积木一样。L₀是基础积木(“苹果”、“红色”),L₁是简单组合(“红苹果”),L₂是复杂组合(“数出所有红色水果”)。

问6:为什么一层网络只能增加一个逻辑层次?

答6:因为神经网络本质上是做线性组合,就像调色盘只能把现有颜色混合,不能创造全新的颜色。

问7:这和ChatGPT的"幻觉"有什么关系?

答7:当遇到超出能力的复杂逻辑时,它就用已知的简单逻辑"拼凑"答案,就像不认识字的人看图说话,会编出似是而非的故事。

问8:论文中的"零空间"是什么意思?

答8:就像压缩照片时丢失的信息,有些复杂的逻辑关系在转换成数字时就永远丢失了,找不回来。

问9:作者提出的解决思路是什么?

答9:理解这个限制后,可以设计更好的网络结构,或者知道在哪些任务上不要过度依赖AI。

问10:这个研究对普通人有什么意义?

答10:帮我们理解AI的边界,知道什么时候可以信任AI,什么时候需要人类的复杂推理能力。

🧩 "深度=逻辑层次"具体含义

问1:什么叫"深度=逻辑层次"?

答1: 每一层网络只能增加一个推理步骤。就像搭积木,每层只能在前一层基础上再搭一块。

问2:能举个具体例子吗?

答2: 以诊断糖尿病为例:

【1层网络】- 能处理L₁逻辑:

输入症状 → 直接识别

"口渴" → 识别为"口渴症状"

"多尿" → 识别为"多尿症状"【2层网络】- 能处理L₂逻辑:

症状识别 → 症状组合

"口渴" + "多尿" → "可能是代谢异常"【3层网络】- 能处理L₃逻辑:

症状组合 → 疾病推断 → 严重程度评估

"代谢异常" + "血糖指标" → "糖尿病" → "需要药物治疗"

问3:为什么不能跳过层次?

答3: 就像做数学题,你不能直接从"1+1"跳到"微积分",必须先学会加减乘除。

🔢 "宽度=组合限制"具体含义

问4:什么叫"宽度=组合限制"?

答4: 网络的宽度决定了能同时考虑多少个不同因素。宽度为w的网络最多只能区分w+1种复杂情况。

问5:医学例子呢?

答5: 以复杂病例诊断为例:

【宽度=3的网络】最多能区分4种情况:

情况1:症状A + 症状B + 正常指标C = 疾病X

情况2:症状A + 正常B + 异常指标C = 疾病Y

情况3:正常A + 症状B + 异常指标C = 疾病Z

情况4:症状A + 症状B + 异常指标C = 疾病W但如果出现第5种情况:

情况5:新症状D + 症状B + 特殊指标E = ???

网络就无法准确区分了!

问6:这在现实中如何表现?

答6: AI会把第5种情况"强行归类"到前4种中的某一种,导致误诊。

大模型幻觉的本质:幻觉是AI尽力而为的结果

就是AI遇到了超出其逻辑表达能力的问题,但仍然必须给出答案,只能用已知的低阶逻辑去"拼凑"高阶逻辑。

AI用它熟悉的简单概念的加权组合来模拟它不理解的复杂概念,就像用已知词汇造一个不存在的词。

为什么听起来合理?

因为AI确实在使用真实的医学知识片段,只是组合方式是错误的。

- 网络深度限制:复杂逻辑被截断

- 网络宽度限制:复杂组合被简化

【用户问】:"分析A药物、B药物、C药物在特定基因型患者中的三重相互作用"【AI能力边界】:只能处理两两相互作用(双变量逻辑)

【超出边界】:三重相互作用需要三变量逻辑【AI的"拼凑"过程】:

三重相互作用 ≈ A-B相互作用 + B-C相互作用 + A-C相互作用【问题】:真实的三重相互作用可能完全不同于两两相互作用的简单叠加

完全颠覆了对幻觉的理解:

❌ 传统误解

- 幻觉是训练不够导致的

- 幻觉是数据质量问题

- 幻觉是可以完全消除的bug

✅ 论文观点

- 幻觉是数学必然性

- 幻觉是AI尽力而为的结果

- 幻觉无法完全消除,只能管理

问11:医学大模型的幻觉有什么特点?

答11: 根据论文理论,医学幻觉有三种典型模式:

模式1:逻辑链断裂型幻觉

【正确推理链】:症状→检查→鉴别→确诊→治疗

【AI实际能力】:只能处理3层逻辑

【幻觉表现】:跳过中间步骤,直接从症状跳到治疗

模式2:组合过载型幻觉

【复杂病例】:多种疾病+多种药物+个体差异

【AI处理】:简化为常见的2-3因素组合

【幻觉表现】:忽略关键的交互作用,给出危险建议

模式3:知识拼接型幻觉

【罕见情况】:AI遇到训练中没见过的病例组合

【拼接机制】:用相似病例的片段重新组合

【幻觉表现】:创造出不存在的"综合征"或"治疗方案"

🛡️ 如何应对幻觉?

问12:既然幻觉无法消除,怎么办?

答12: 论文的理论指导我们:

✅ 正确策略

- 识别高风险场景:复杂推理链、多因素组合、罕见情况

- 设置边界检测:AI自己识别"我可能在胡说"

- 人机协作验证:在关键环节加入人类检查

- 分解复杂问题:避免让AI处理超出能力的逻辑层次

❌ 错误期待

- 指望更多训练数据消除幻觉

- 认为更大的模型就不会幻觉

- 在高风险医学决策中完全信任AI

🏥 在医学推理中的实际影响

问7:这对医学大模型有什么具体影响?

答7: 造成三大类问题:

类型1:逻辑深度不够(深度限制)

【复杂诊断链】需要5层逻辑:

症状 → 系统判断 → 疾病类型 → 具体疾病 → 个体化治疗【3层模型的处理】:

症状 → 系统判断 → 疾病类型 → ❌(后面就开始"瞎猜")

问8:具体例子?

答8: 系统性红斑狼疮诊断:

- 人类医生:皮疹 → 自免疾病可能 → 检查ANA → 阳性提示狼疮 → 评估器官受累 → 确定分型 → 个体化治疗

- 有限AI:皮疹 → 自免疾病可能 → 狼疮 → ❌(直接跳到治疗,中间逻辑丢失)

类型2:组合复杂度超限(宽度限制)

问9:什么情况下会超出组合限制?

答9: 当需要同时考虑的因素太多时:

【罕见病诊断】需要同时满足:

✓ 3个神经系统症状

✓ 2个特定基因突变

✓ 1个代谢异常

✓ 排除5个相似疾病

✓ 考虑患者年龄、性别、家族史总共12+个独立因素需要精确组合判断

问10:AI会如何处理?

答10: AI会简化处理:

- 忽略某些"不重要"的因素

- 用常见病模式去匹配罕见病

- 给出"可能性排序"而非精确诊断

类型3:药物相互作用(综合限制)

问11:为什么药物相互作用特别困难?

答11: 因为同时受到深度和宽度双重限制:

【复杂用药场景】:

患者同时服用:降压药A + 抗凝药B + 抗生素C + 胃药D【需要的推理深度】:

药物代谢 → 酶系影响 → 血药浓度变化 → 疗效/副作用预测 → 剂量调整【需要的组合宽度】:

要同时考虑:患者肝功能、肾功能、年龄、体重、基因型、其他疾病...

🚨 现实案例:AI医学诊断的典型失误

问12:有具体的失误案例吗?

答12:

案例1:逻辑深度不够

【患者】:年轻女性,疲劳 + 关节痛 + 面部红斑

【AI诊断】:直接输出 "系统性红斑狼疮,建议激素治疗"

【问题】:跳过了鉴别诊断步骤,没考虑其他可能性

【正确流程】:症状 → 鉴别诊断 → 特异性检查 → 确诊 → 分型 → 个体化治疗

案例2:组合复杂度超限

【患者】:老年男性,多种慢性病,服用8种药物

【AI处理】:只考虑了主要的3-4种药物相互作用

【遗漏】:微量营养素、中药、保健品的复杂交互作用

【结果】:推荐的新药与被忽略的某种补剂产生严重反应

💡 解决策略:认识限制,合理应用

问13:那医学AI还有用吗?

答13: 非常有用,但要用对地方:

✅ AI擅长的场景

- 简单筛查:单一症状 → 可能疾病列表

- 影像识别:X光片 → 是否有异常

- 标准化诊断:按既定流程的常见病诊断

- 文献检索:快速找到相关医学资料

❌ AI不适合的场景

- 复杂罕见病诊断:需要深层推理链

- 多因素个体化治疗:组合因素太多

- 创新治疗方案:需要跨领域逻辑整合

- 高风险决策:容错性要求极高

问14:最佳实践是什么?

答14: 分层协作模式:

【第一层】AI快速筛查 → 识别可能的方向

【第二层】AI辅助分析 → 提供详细信息和建议

【第三层】人类医生 → 复杂推理和最终决策

【第四层】专家会诊 → 超复杂案例的集体智慧

设计更好的网络结构方面:

问1:既然每层只能增加一个逻辑层次,怎么设计更好的结构?

答1:可以设计"专门化的层",让不同的层专门处理不同类型的逻辑推理。

问2:什么叫"专门化的层"?

答2:比如设计一层专门处理计数逻辑,一层专门处理因果关系,一层专门处理时间序列,而不是让每层都处理所有类型。

问3:还有其他结构改进方法吗?

答3:可以设计"并行路径",让复杂逻辑分解成多个简单逻辑并行处理,最后再组合。

问4:论文提到的"张量分解"怎么帮助设计?

答4:通过T、L⁺、M、S、L这五个张量,可以清楚看到信息在哪个环节丢失,针对性地加强薄弱环节。

问5:具体可以怎么加强?

答5:比如在L⁺张量(结构压缩)环节,可以设计更大的"压缩空间",减少信息损失。

识别AI不适用场景方面:

问6:哪些任务不应该过度依赖AI?

答6:需要高阶逻辑推理的任务,比如复杂的数学证明、多层因果分析、精确计数等。

问7:什么是"多层因果分析"?

答7:比如"经济政策A影响就业B,就业B影响消费C,消费C影响股市D,股市D反过来影响政策制定"这种链条式推理。

问8:为什么精确计数也不行?

答8:因为论文证明了,当需要区分的对象数量超过网络的"宽度w"时,就会出现无法区分的情况。

问9:那在什么场景下AI还是可靠的?

答9:简单模式识别、语言翻译、文本摘要等不需要复杂逻辑推理的任务。

问10:如何判断一个任务是否超出AI能力?

答10:看是否需要"递归嵌套"的逻辑。比如"找出所有满足条件A的元素中,满足条件B的元素中,满足条件C的元素"。

问11:这对企业使用AI有什么指导意义?

答11:在做重要决策时,如果涉及复杂的多层逻辑推理,应该用AI辅助而不是依赖,最终判断还是要人来做。

问12:对个人使用AI有什么建议?

答12:用AI处理信息整理、初步分析,但涉及复杂推理的结论要保持怀疑,多角度验证。

问13:这种认识对AI发展有什么长远意义?

答13:帮助我们从"让AI无所不能"转向"让AI和人类优势互补",更理性地发展AI技术。

分析这对医学大模型的具体影响:

医学诊断的复杂性挑战:

问1:医学诊断需要什么样的逻辑推理?

答1:需要多层嵌套推理,比如"症状A+症状B→可能疾病C,但如果还有症状D,则排除疾病C,考虑疾病E"。

问2:这种推理超出了AI的能力吗?

答2:是的,这是典型的高阶逻辑推理,需要同时处理多个条件的复杂组合,超出了论文描述的网络深度限制。

问3:具体会出现什么问题?

答3:医学AI可能会"拼凑"诊断,用常见病的模式去匹配罕见病的症状,导致误诊。

罕见病诊断的特殊挑战:

问4:为什么罕见病特别困难?

答4:罕见病往往需要精确识别"症状组合的独特性",这需要高精度的逻辑区分能力,正是AI的薄弱环节。

问5:论文中的"计数问题"在医学中如何体现?

答5:比如需要同时满足"至少3个神经系统症状"+“2个免疫系统指标异常”+"1个特定基因突变"才能诊断某罕见病。

问6:AI为什么处理不好这种计数?

答6:当需要精确计数和组合的条件超过网络宽度时,AI就无法准确区分,可能把相似但不同的疾病混淆。

药物相互作用的复杂性:

问7:药物相互作用分析有什么特殊性?

答7:需要考虑"药物A影响酶B,酶B影响药物C的代谢,进而影响药物D的效果"这种链式反应。

问8:这超出AI能力了吗?

答8:是的,这是多层因果推理,AI容易在中间环节"丢失"信息,给出不准确的相互作用预测。

个体化医疗的挑战:

问9:个体化治疗方案制定有什么难点?

答9:需要同时考虑患者的基因型、表型、病史、当前用药、生活方式等多维度信息的复杂交互。

问10:AI在这方面的局限性是什么?

答10:AI容易用"平均化"的模式处理,而个体化恰恰需要识别"这个患者与众不同的特殊组合"。

实际应用建议:

问11:医学大模型应该用在哪些场景?

答11:适合用于初步筛查、文献检索、标准化诊断流程、医学影像的模式识别等相对简单的任务。

问12:哪些医学场景不应过度依赖AI?

答12:复杂罕见病诊断、多药物相互作用分析、个体化精准治疗方案制定、复杂手术决策等。

问13:如何正确使用医学AI?

答13:把AI当作"高级的医学助手",用它来快速筛选信息、提供诊断建议,但最终决策必须由有经验的医生基于复杂推理来做。

问14:这对医学AI的发展方向有什么启示?

答14:应该开发"专科化"的AI,比如专门处理心血管逻辑的AI、专门处理神经系统逻辑的AI,而不是追求"全科万能"。

问15:对患者和医生有什么实际意义?

答15:患者应理解AI诊断的局限性,医生应该把AI作为辅助工具而非替代品,特别是在复杂病例中要保持独立的临床思维。

核心问题:医学诊断的复杂性挑战、罕见病诊断的特殊挑战、药物相互作用的复杂性,能不能用多智能体系统弥补呢?

我目前面临的问题是:基于神经网络逻辑推理限制理论,医学诊断中的复杂逻辑推理挑战是否可以通过多智能体系统来弥补?

多智能体架构能否突破单一网络的逻辑深度限制?

从论文的数学框架看,多智能体可能并没有突破根本限制,而是通过"分布式近似"提高了处理效果。

因为每个智能体仍然受到自身网络深度的限制,L_k逻辑层次约束依然存在于每个个体中。

多智能体的优势可能在于"逻辑分解"而非"逻辑突破"。

与分布式计算中的"分治策略"类似,复杂问题被分解为多个相对简单的子问题。

新发现: 多智能体可能不是"突破"限制,而是"分解"复杂度

潜在风险是什么? 关键信息在传递中丢失,整合环节成为新的瓶颈

多智能体确实可以缓解单一网络的逻辑深度限制,但有条件和边界

关键洞察: 成功的关键不在于突破逻辑限制,而在于充分利用领域的可分解性

直接解答: 当医学逻辑出现"全局耦合"时,多智能体分解方案会失效。

什么是"全局耦合"的医学逻辑?

案例1:复杂药物相互作用

药物A + 药物B + 药物C + 基因型X + 肝功能Y = ?

这种逻辑无法分解,因为:

- 任何一个因素的变化都会影响整个系统

- 不存在独立的子问题

- 必须同时考虑所有因素的交互作用

案例2:罕见病的"症状星座"

某些罕见病需要同时满足:

- 至少3个神经系统症状 AND

- 2个特定基因变异 AND

- 1个特殊代谢指标异常 AND

- 排除5个相似疾病

根本结论:

多智能体无法完全突破逻辑深度的数学限制,但可以通过**“逻辑分解工程”**有效缓解这一限制。

关键发现:

- 本质机制:多智能体是"逻辑工程"而非"逻辑突破"

- 成功条件:医学问题具备可分解性(大多数情况符合)

- 失效边界:全局耦合的复杂逻辑仍然受限

- 优势领域:医学诊断的天然层次性提供了理想应用场景

🏥 医学多智能体系统设计方案

第一层:专科诊断智能体集群

- 心内科诊断AI:专门处理心血管系统逻辑

- 神经科诊断AI:专门处理神经系统逻辑

- 内分泌科诊断AI:专门处理激素代谢逻辑

- 影像诊断AI:专门处理影像-疾病关系逻辑

第二层:跨科协调智能体

- 系统性疾病识别AI:处理多系统受累情况

- 药物相互作用AI:处理复杂用药逻辑

- 鉴别诊断AI:处理相似疾病的区分逻辑

第三层:整合决策智能体

- 基于各专科输入进行最终诊断整合

- 关键:设计有效的信息传递和验证机制

第四层:质量控制智能体

- 逻辑一致性检验

- 诊断置信度评估

- 人工介入触发机制