Amazon Bedrock中的Stability AI文本转图像模型:技术原理、应用实践与未来趋势

2025年,全球企业在AI领域的累计投入已突破万亿美元,但《福布斯》的调查显示,83%的企业仍困于“试点陷阱”——AI项目难以从实验室走向生产环境。Amazon Bedrock与Stability AI的深度整合正是破解这一困局的关键:通过无服务器架构消除基础设施管理负担,以多模型统一API简化开发流程,借助企业级安全机制保障合规性。本文将全面剖析这一技术组合如何重塑视觉内容创作,从底层原理到实战部署,为技术决策者与开发者提供8000字深度指南。

一、Amazon Bedrock:企业级生成式AI的基础设施

1.1 服务定位与核心价值

Amazon Bedrock作为亚马逊云科技的全托管生成式AI服务,其核心使命是降低企业AI部署门槛。与自建模型相比,Bedrock提供三大关键优势:

- 无服务器架构:开发者无需配置GPU集群、管理容器或优化推理性能,直接通过API调用Stability AI等顶级模型

- 多模型统一接口:支持Stability AI、Anthropic、Meta等170+模型,通过一致的API简化跨模型对比与切换

- 企业级安全合规:数据加密传输与存储(符合SOC 2、ISO 27001),Guardrails功能可过滤88%的有害内容

2025年7月发布的AgentCore进一步强化了Bedrock的企业属性。这套由七大模块构成的智能体系统,解决了AI部署的“最后一公里”问题:

- AgentCore Runtime:支持8小时任务持续运行,突破传统对话15分钟时限

- AgentCore Identity:细粒度权限控制,使AI操作可审计(如CRM系统访问授权)

- AgentCore Browser Tool:云端无头浏览器,摆脱本地环境依赖,稳定执行网页操作

1.2 与Stability AI的战略整合

Stability AI作为Bedrock的核心合作伙伴,将其最先进的文本转图像模型原生集成至亚马逊云科技生态。这种整合并非简单的API对接,而是深度优化:

- 模型优化:针对Amaozn Inferentia芯片优化推理性能,Stable Diffusion 3 Large生成速度提升40%

- 成本控制:按需付费模式($0.018-$0.14/张),Provisioned Throughput预购容量可节省30%成本

- 生态协同:与S3 Vectors(向量存储成本降低90%)、Kiro IDE(氛围编程工具)无缝联动

二、Stability AI模型技术详解:从架构到性能

2.1 技术原理:潜在扩散模型的进化

Stability AI的文本转图像技术基于潜在扩散模型(LDM),其核心创新在于将高维图像压缩至低维潜在空间进行扩散,大幅降低计算复杂度。以Stable Diffusion 3为例,完整流程分为四步:

- 文本编码:输入提示词经CLIP ViT-L/14(视觉理解)与T5-XXL(文本理解)编码为768维向量,解决长文本语义解析难题(如“17世纪巴洛克宫廷中手持金权杖的女王”)

- 潜在空间扩散:

- 前向扩散:向纯噪声添加结构化噪声(数学公式:(x_t = \sqrt{\alpha_t}x_{t-1} + \sqrt{1-\alpha_t}\epsilon))

- 反向扩散:U-Net根据文本向量预测噪声,迭代去噪(50步生成1024x1024图像)

- 图像解码:VAE将潜在特征映射回像素空间,修复细节(如皮肤纹理、金属反光)

- 后处理:可选超分模型(如4x-NMKD-Siax)将图像分辨率提升至4K,保持边缘锐度

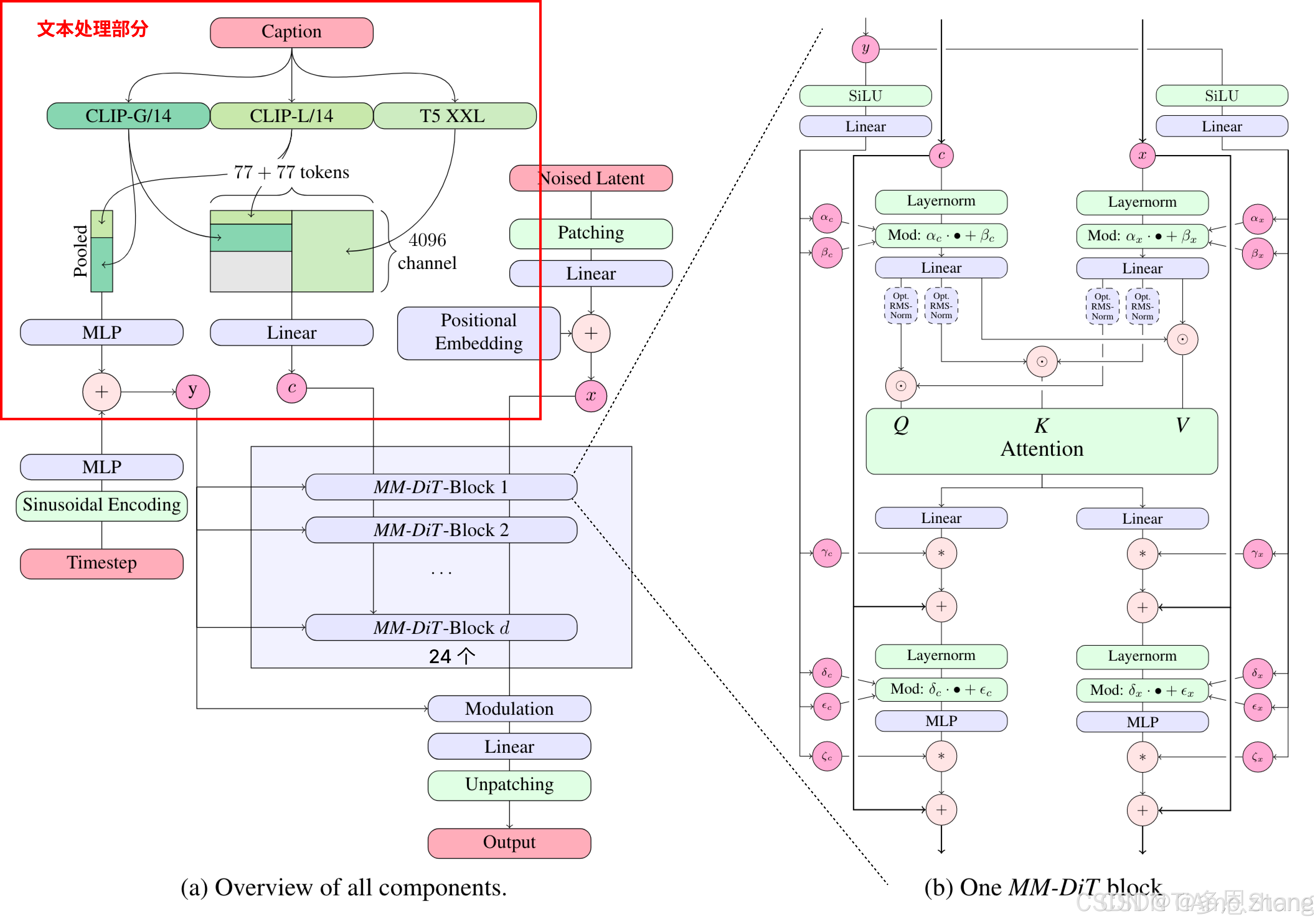

2.2 MMDiT架构:多模态Transformer的突破

Stable Diffusion 3采用多模态扩散Transformer(MMDiT),颠覆传统U-Net架构:

- 双模态权重:文本与图像分支独立权重,通过交叉注意力实现信息流动

- 80亿参数规模:35亿基础模型+66亿集成管线,支持1024x1024原生分辨率

- Rectified Flow技术:一步生成图像,采样步数从50降至28,速度提升44%

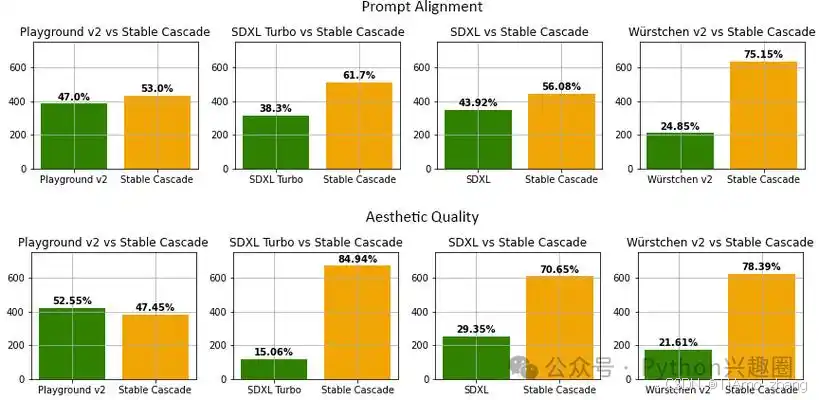

2.3 三款模型深度对比

指标 | Stable Image Ultra | Stable Diffusion 3 Large | Stable Image Core |

定位 | 专业印刷/大幅面应用 | 平衡速度与质量 | 快速概念迭代 |

生成速度 | 34秒/张(RTX 4090) | 12秒/张(RTX 4090) | 3秒/张(RTX 4090) |

价格 | $0.14/张 | $0.045/张 | $0.018/张 |

FID分数 | 30.2(越低越好) | 35.6 | 42.1 |

适用场景 | 奢侈品广告、电影海报 | 电商详情页、游戏资产 | 社交媒体素材、内部原型 |

技术细节:

- Stable Image Ultra:支持1024x1024原生分辨率,文本渲染错误率降低72%(如“Spring”一词拼写准确率99.2%)

- Stable Diffusion 3 Large:采用混合专家模型(MoE),推理时激活22%参数,显存占用减少50%

- Stable Image Core:基于SDXL精简架构,删除T5编码器,保留基础CLIP,适合边缘设备部署

三、实战指南:从API调用到应用部署

3.1 API调用全流程

通过Amazon Bedrock调用Stability AI模型需四步:

步骤1:环境配置

import boto3

import base64

from PIL import Image

import iosession = boto3.Session(region_name="us-west-2")

bedrock = session.client("bedrock-runtime")

步骤2:参数设置(以Stable Image Ultra为例)

body = {"text_prompts": [{"text": "维多利亚时代蒸汽朋克钥匙,玻璃柄内齿轮结构,风化木质表面"}],"cfg_scale": 10, # 提示词相关性(7-15适合人物,3-7适合场景)"steps": 50, # 采样步数(28-50平衡质量与速度)"seed": 12345, # 随机种子(固定可复现结果)"width": 1024,"height": 1024

}

步骤3:发送请求

response = bedrock.invoke_model(modelId="stability.stable-image-ultra-v1",body=json.dumps(body),accept="application/json",contentType="application/json"

)

步骤4:结果处理

response_body = json.loads(response["body"].read())

image_data = base64.b64decode(response_body["artifacts"][0]["base64"])

Image.open(io.BytesIO(image_data)).save("steampunk_key.png")

3.2 高级功能:Reimagine XL无Prompt生成

Stability AI的Reimagine XL工具支持图像变体生成,无需文本提示:

# Clipdrop API调用示例(Reimagine XL)

import requestsapi_key = "YOUR_API_KEY"

url = "https://clipdrop-api.co/reimagine/v1/reimagine"

headers = {"X-API-Key": api_key}

files = {"image_file": open("input.png", "rb")}response = requests.post(url, headers=headers, files=files)

with open("variation.png", "wb") as f:f.write(response.content)

应用场景:电商商品多角度展示(上传一张运动鞋图,生成360°视图)

四、行业应用案例:从创意到生产力

4.1 游戏开发:资产生成效率提升80%

案例:某AAA游戏工作室使用Stable Diffusion 3 Large生成场景资产

- 挑战:传统流程需3天/场景(概念设计→3D建模→纹理烘焙)

- 解决方案: 提示词:“赛博朋克城市街道,雨后湿滑地面,全息广告牌,东方建筑元素”

- 图生图迭代:基于草图生成高精度纹理(如“将墙面改为生锈金属,添加中文涂鸦”)

- 批量处理:通过Bedrock Batch Inference API生成500+道具素材

- 成果:单场景资产生成时间缩短至4小时,美术团队规模缩减30%

4.2 教育:个性化学习材料生成

案例:Stride Learning的Legend Library教育应用

- 功能:学生输入故事 prompt(如“太空探险”),AI生成配图和阅读理解题

- 技术实现: 调用Stable Image Core生成低延迟图像(3秒/张)

- 结合Amazon Titan Text生成题目(如“图中宇航员使用的工具名称是?”)

- 数据:1000所学校采用,学生阅读兴趣提升42%,教师备课时间减少60%

4.3 影视制作:詹姆斯·卡梅隆的“数字画板”

Stability AI与卡梅隆的Lightstorm Entertainment合作,用于《阿凡达3》概念设计:

- 流程:导演输入文本(“潘多拉星球水下生物,发光触须,透明皮肤”),AI生成20种变体

- 工具链:Stable Image Ultra + SyncNoise 3D编辑(保持多视图一致性)

- 价值:概念设计周期从2周压缩至1天,节省预算$1200万

五、最佳实践:提示词工程与性能优化

5.1 提示词黄金结构

专业提示词模板:

[主体描述], [细节刻画], [景别/构图], [风格参考], [技术参数]

示例:

- 主体:“穿着中世纪盔甲的女性骑士”

- 细节:“鎏金纹饰,磨损金属质感,皮革披风飘动”

- 构图:“低角度仰拍,背景虚化城堡废墟”

- 风格:“类似《魔戒》电影海报,Greg Rutkowski插画风格”

- 技术:“8K分辨率,HDR,电影级打光”

负面提示词:NSFW, (worst quality:2), (low quality:2), extra fingers, mutated hands

5.2 参数调优指南

参数 | 作用 | 推荐值范围 |

CFG Scale | 提示词遵循度 | 7-15(人物) |

Steps | 采样步数 | 28-50 |

Denoising | 图生图噪声强度 | 0.6-0.8(保留原图结构) |

Seed | 随机种子(固定可复现) | 12345(自定义) |

性能优化技巧:

- 使用Euler a采样器(速度快)或DPM++ 2M Karras(质量高)

- 启用xFormers加速(显存占用减少30%)

- 批量生成:设置batch_size=4,吞吐量提升3倍

六、未来趋势:多模态融合与边缘部署

6.1 技术演进方向

- 模型小型化:Stable Code 3B(30亿参数代码模型)证明小模型可媲美大模型性能,未来文本转图像模型可能压缩至10亿参数内,实现手机端实时生成

- 多模态统一:Stability AI正在研发“Stable Multimodal”,支持文本→图像→视频→3D联动(如输入“生成一只会飞的机械鸟,展示飞行视频,输出3D模型”)

- 实时交互:借鉴NitroFusion的1步生成技术,未来生成速度有望突破1秒/张,支持AR实时渲染

6.2 企业落地挑战与应对

- 数据安全:使用Bedrock Guardrails过滤敏感内容(如PII检测准确率98.7%)

- 成本控制:采用“按需+预购”混合付费模式(预测流量时预购Provisioned Throughput)

- 技能缺口:通过AWS Training and Certification体系培养“AI Prompt工程师”

总结:重新定义视觉内容生产力

Amazon Bedrock与Stability AI的整合不仅是技术的叠加,更是生产力范式的变革——从“创意依赖专家”到“人人皆可创作”。通过无服务器架构、企业级安全机制和先进的扩散模型,这套组合正在帮助企业将AI投入转化为实际ROI:

- 效率提升:视觉内容生产速度平均提升10倍

- 成本降低:创意设计成本减少50%-80%

- 创新加速:从概念到原型的时间压缩90%

正如亚马逊云科技Agentic AI副总裁Swami Sivasubramanian所言:“未来的竞争优势,属于那些能将AI潜力转化为行动力的企业。”而Stability AI的文本转图像技术,正是这场变革的核心引擎。

以上就是本文的全部内容啦。最后提醒一下各位工友,如果后续不再使用相关服务,别忘了在控制台关闭,避免超出免费额度产生费用~

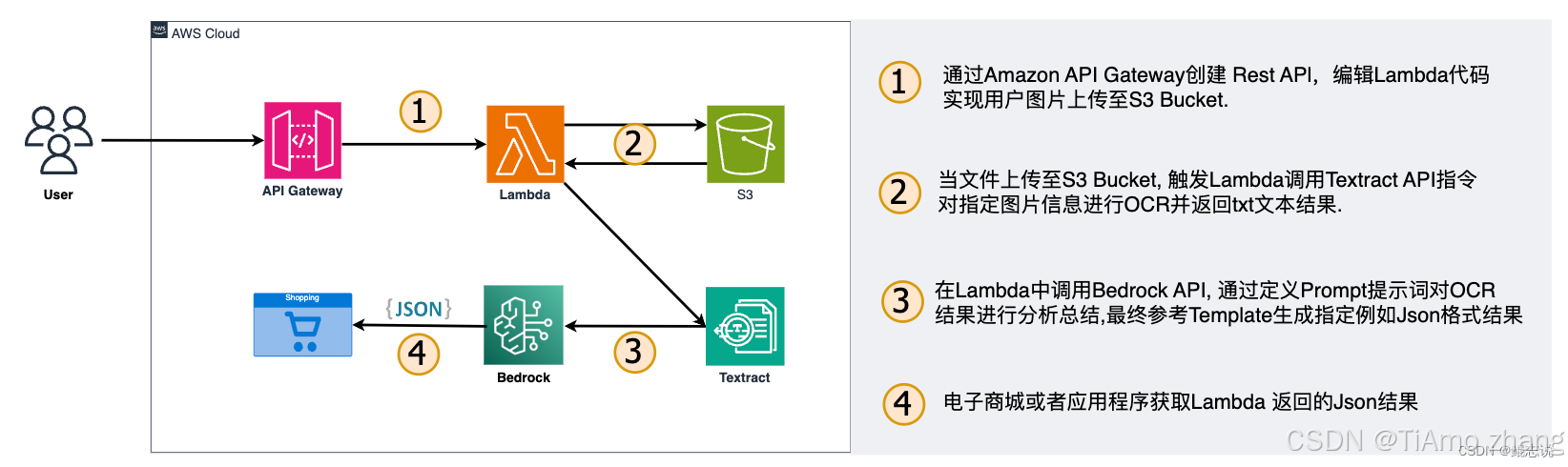

图1:Amazon Bedrock架构示意,展示Stability AI模型与AgentCore、S3 Vectors等组件的协同

图2:Stable Diffusion 3文本转图像流程,包含文本编码、潜在扩散、图像解码三阶段

图3:Stability AI三款模型在生成速度、质量、成本上的对比