大语言模型系列(1): 3分钟上手,在骁龙AI PC上部署DeepSeek!

重磅发布 | 高通开源神器 QAI AppBuilder:让本地AI部署触手可及!

QAI AppBuilder,是一款专为骁龙平台打造的 AI 应用开发利器,让你轻松在 Windows AI PC上部署并运行本地AI模型,具备以下核心优势:

- 极简开发体验: 自动批处理安装,无AI经验开发者2个小时就可以上手。

- 多语言支持: 同时支持 Python 与 C++ 开发。

- 深度集成底层SDK: 基于 Qualcomm® AI Runtime SDK,简化本地 AI 模型部署流程。

- 本地部署,隐私优先: 无需依赖云端,数据都在本地,确保内容安全可控的同时,具备低延迟,高响应,完全免费等特点。

- 兼容 OpenAI API: 支持通用的 API 接口调用本地大语言模型,调用方式与云端完全一致

本文后续将详细介绍如何使用 QAI AppBuilder 在骁龙AI PC上部署一个大语言模型,并通过其兼容的 OpenAI WebAPI 接口进行本地推理。你将学会:

- 如何在骁龙AI PC上本地部署大语言模型

- 如何通过兼容的 OpenAI WebAPI 接口,实现与云端一致的调用体验

3 分钟搞定 本地智能助手!

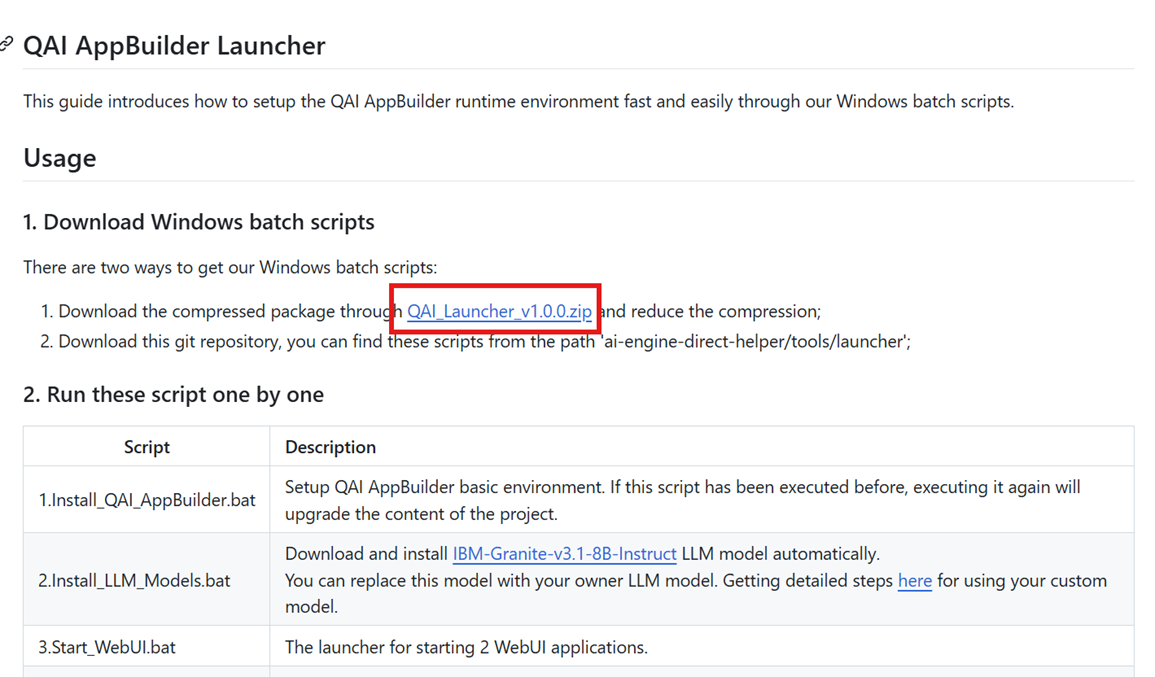

一、下载自动化安装脚本

访问https://github.com/quic/ai-engine-direct-helper/tree/main/tools/launcher

在“Download Windows batch scripts”中,点击 “qai_launcher_v1.0.0.zip”下载相关文件

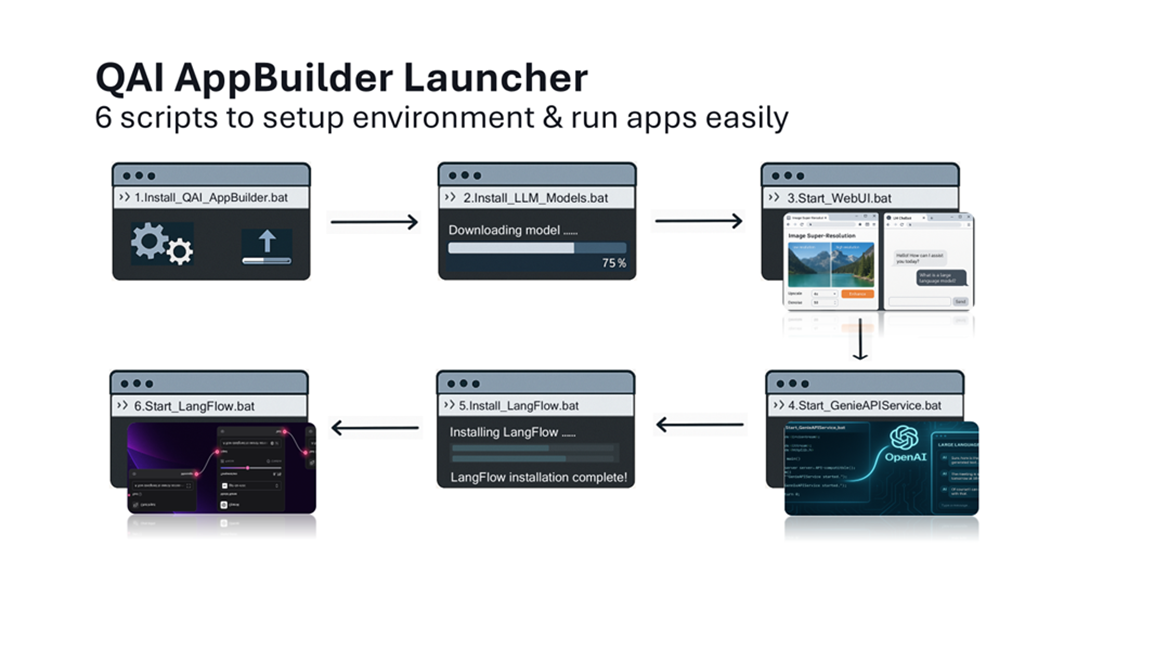

下载完成后解压缩,得到最新的批处理脚本,批处理脚本一共6个,分别是

二、安装依赖项

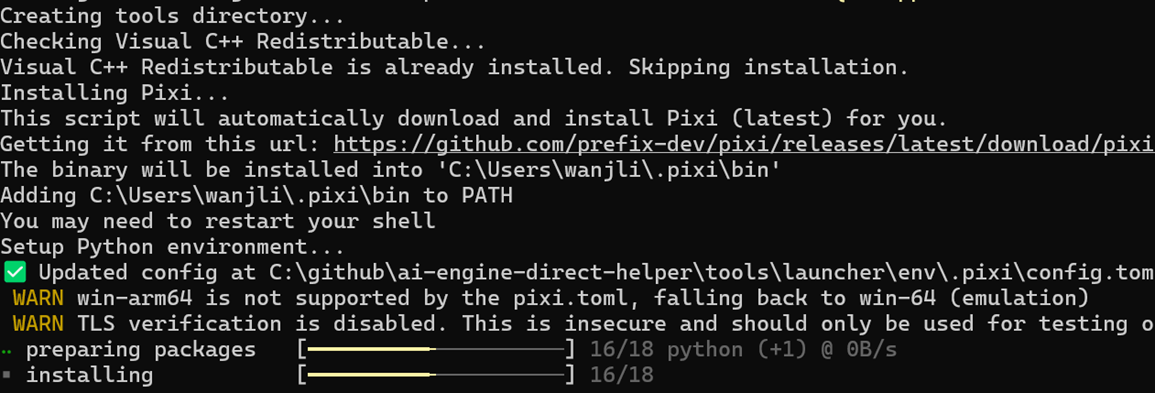

运行以下批处理脚本以自动安装所需依赖:

.\1.Install_QAI_AppBuilder.bat

安装成功后出现

“Install successfully. Press any key to exit...”

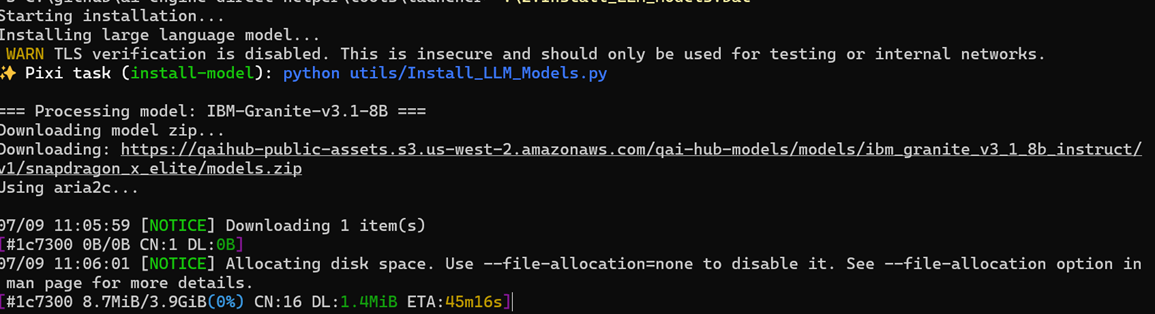

三、安装测试用大语言模型

运行批处理脚本

.\2.Install_LLM_Models.bat

默认情况下,脚本将安装 IBM-Granite-v3.1-8B-Instruct 大语言模型

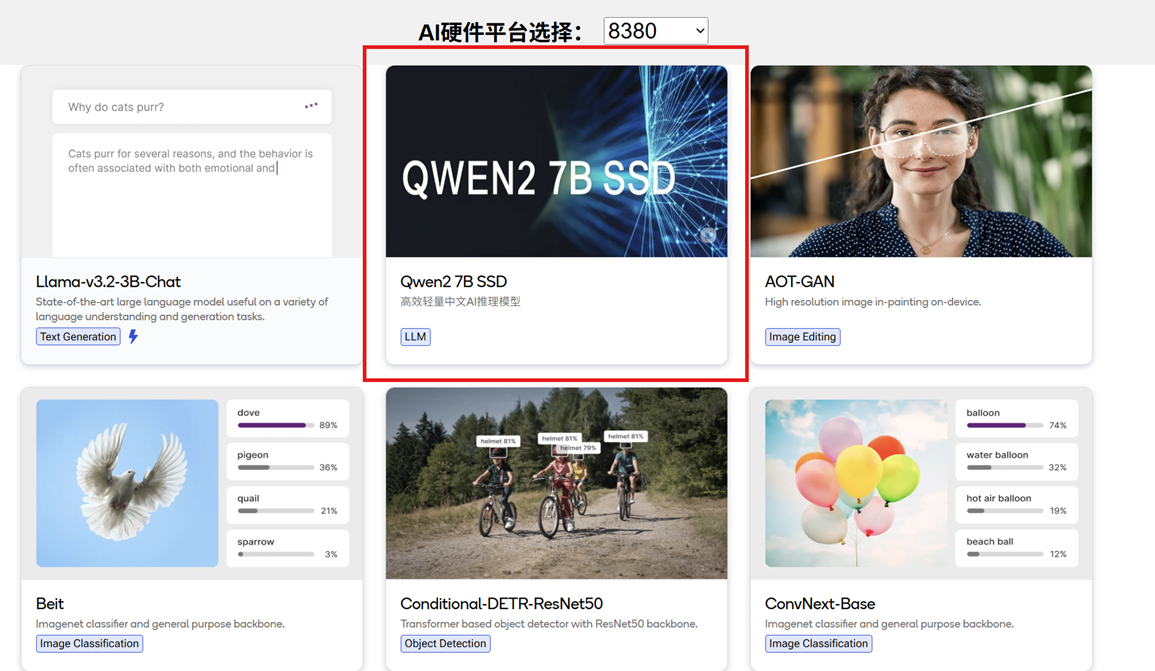

对于中文使用场景,推荐使用 Qwen2-7B-SSD 作为基座模型。Qwen2-7B-SSD 是一个专门优化用于中文处理的大语言模型,能够更准确地理解和生成中文文本。参考以下步骤使用模型

1. 访问模型库 模型门户下载转换好的模型权重

打开”Qwen2 7B SSD”的模型卡片

2. 点击下载

3. 下载后得到“qwen2_7b_ssd.zip”的压缩包

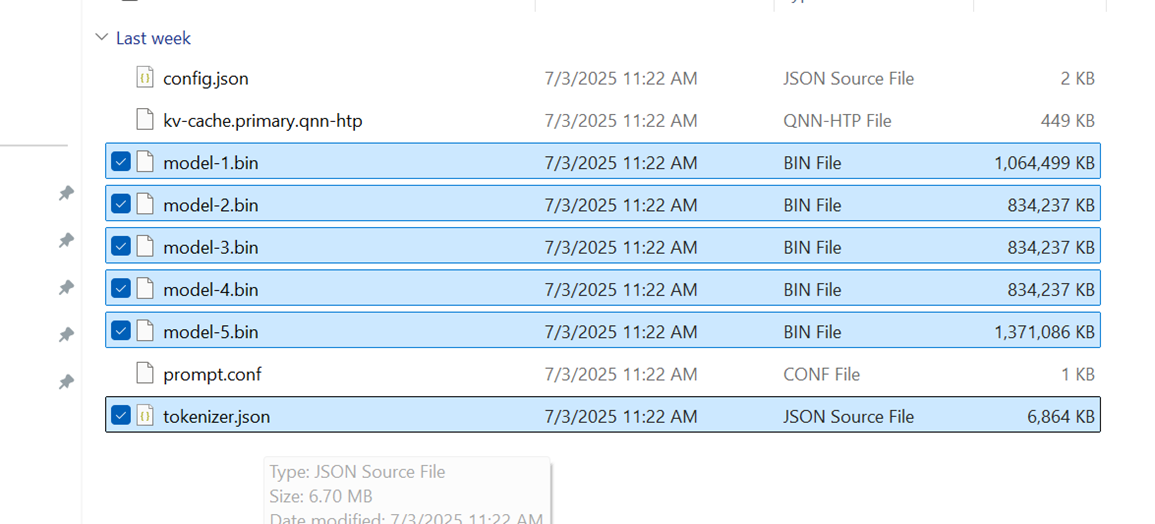

解压缩 qwen2_7b_ssd.zip

4. 拷贝所有的model-*.bin文件以及tokenizer.json件放入下面的目录:

ai-engine-direct-helper\samples\genie\python\models\ Qwen2.0-7B-SSD

四、启动本地聊天应用

QAI AppBuilder 工具包内置了一个本地部署的聊天程序,结合骁龙芯片的 AI 算力,提供强大的推理能力。

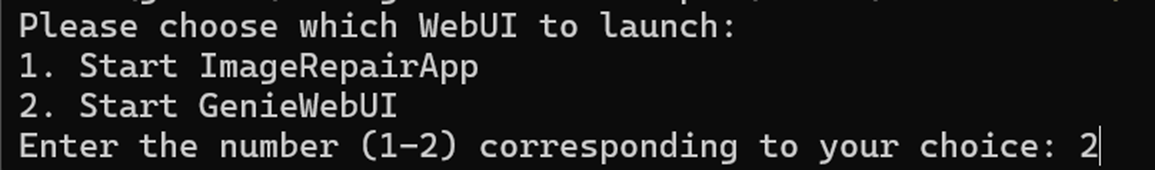

运行以下脚本启动 Web UI。

运行.\3.Start_WebUI.bat 批处理启动运行聊天应用,选择2 “Start GenieWebUI”

在启动过程中,选择选项 2 - Start GenieWebUI,以启动 GenieWebUI 工具。

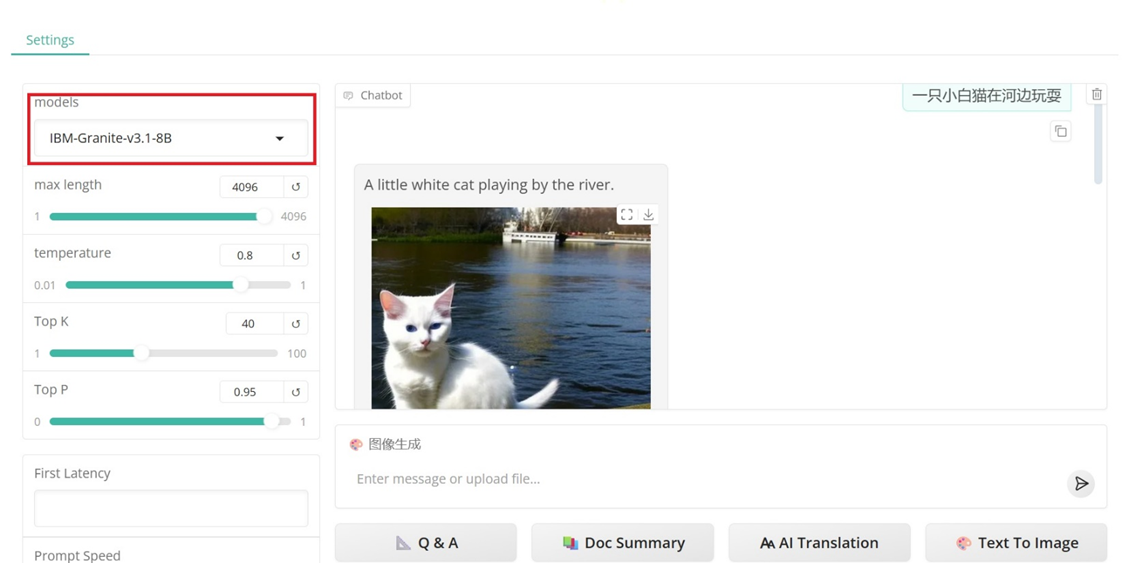

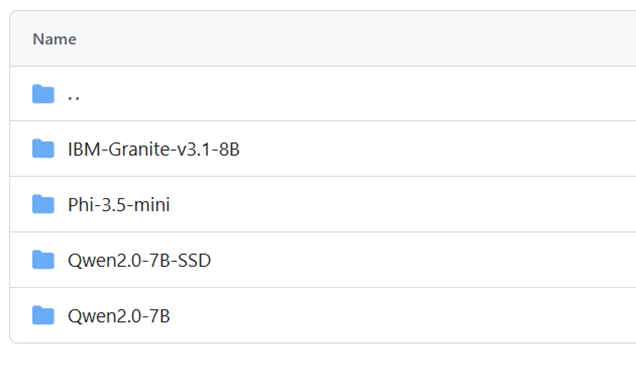

GenieWebUI 支持文字生成图像、文档总结、翻译等功能。默认使用的模型为 IBM-Granite-v3.1-8B-Instruct,支持所有转换成高通QNN格式的大语言模型。QAI AppBuilder预制了IBM-Granite-v3.1-8B,Phi-3.5-mini,Qwen2.0-7B-SSD, Qwen2.0-7B的模型配置信息,只要下载对应的模型权重放置到目录下就可以直接使用。

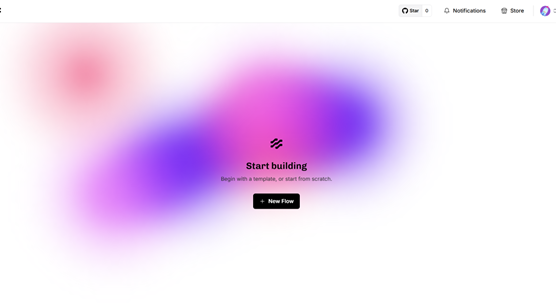

五、可视化 AI 工作流:LangFlow

在现代 AI 开发中,效率和直观性是关键。QAI AppBuilder 集成了基于开源框架 LangFlow 的可视化 AI 工作流工具,让你能够通过简单的拖拽操作,快速构建强大的 AI 应用工作流。以下是如何启动和使用 LangFlow 的步骤:

首先,依次运行以下脚本:

.\4.Start_GenieAPIService.bat

.\5.Install_LangFlow.bat

.\6.Start_LangFlow.bat

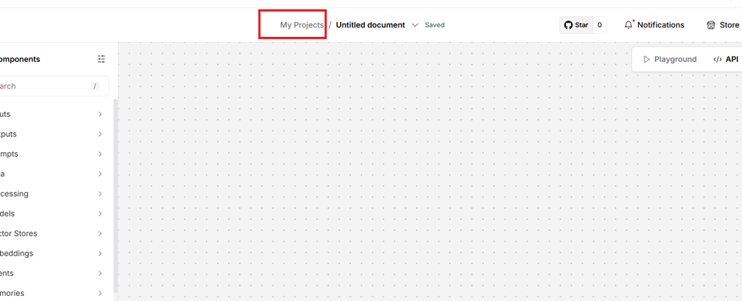

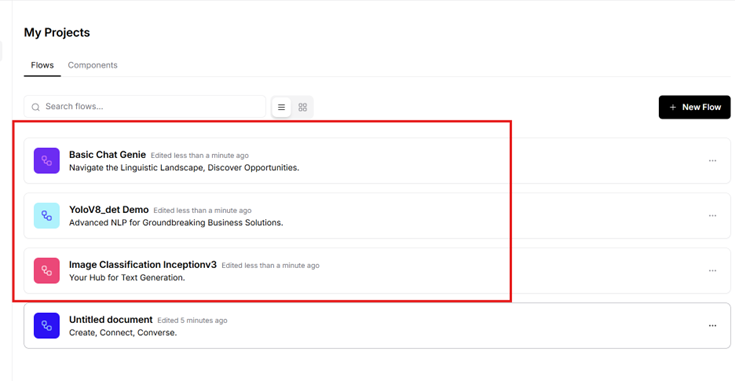

启动后,你将看到 LangFlow 的入口界面

点击“New Flow”

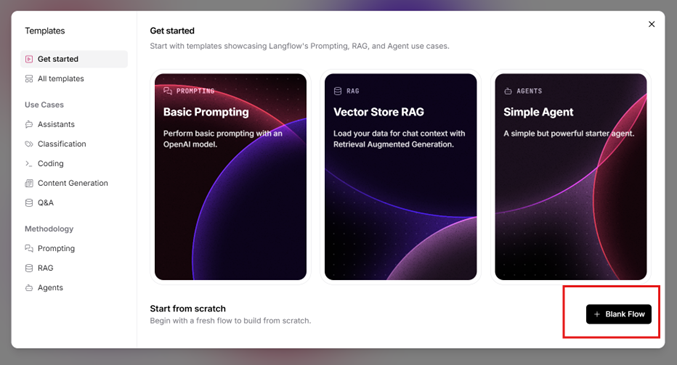

点击“Blank Flow”进入Flow Design的页面

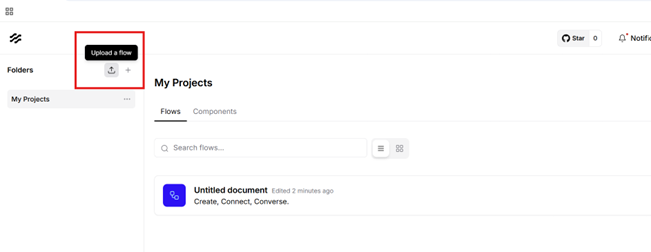

点击“My Projects” 管理项目

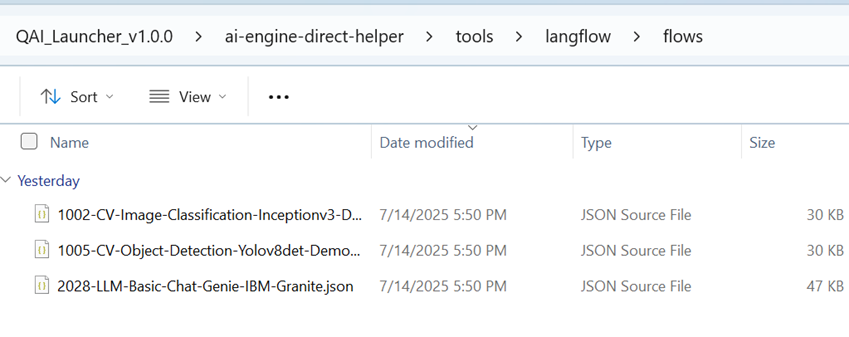

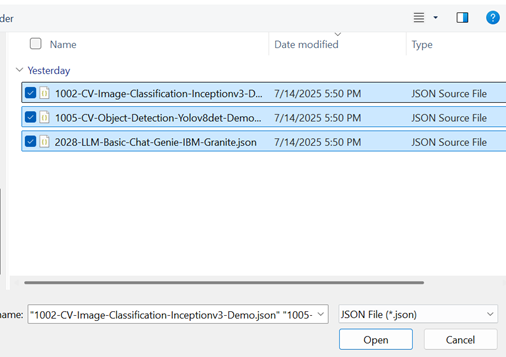

然后在左侧点击“Upload a Flow”的图标上传已经配置好的Flow模板,这些模板的路径在

QAI_Launcher_v1.0.0\ai-engine-direct-helper\tools\langflow\flows

全选后点击Open

你将看到三个示例 Flow:

- Basic Chat Genie 一个基于本地大语言模型的对话聊天Flow

- Yolov8_det Demo 一个基于Yolov8目标检测的Flow

- Image Classification Inception V3 一个基于Inception V3图片分类的Flow

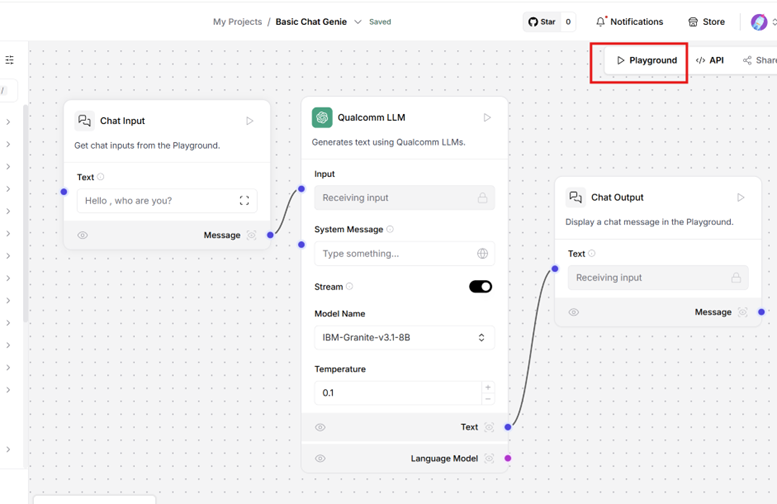

让我们以 Basic Chat Genie 聊天 Flow 为例。点击进入后,你会看到 Flow 的详细设计。

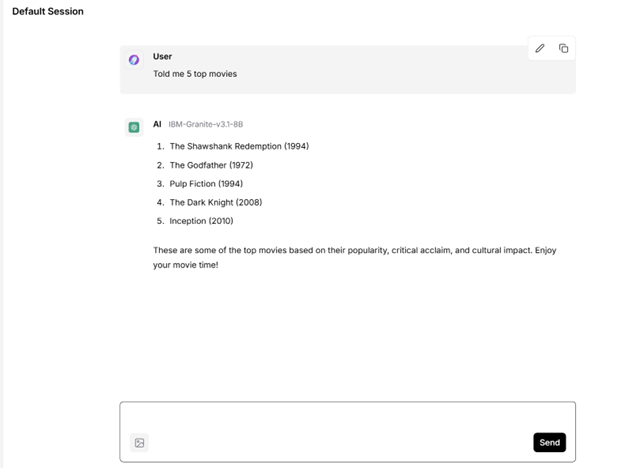

接下来,点击 Playground,你就可以使用本地 AI 模型进行互动聊天了

写在最后:本地 AI,从现在开始

通过本文的引导,你已经完成了 QAI AppBuilder 的环境配置,为本地部署大语言模型打下了坚实基础。无论你是想构建一个离线智能助手,还是打造一个无需联网的 AI 应用框架,本地推理都将是未来的重要方向。

QAI AppBuilder 的极简设计和强大兼容性,让本地部署不再是“高门槛”的技术挑战,而是每一位开发者都能轻松上手的实战技能。

作者

戴忠忠(Zhongzhong Dai),高通工程师