部署本地大模型 Ollama + LLaMA3

一、什么是 Ollama?

Ollama 是一个轻量级的大模型本地部署平台,提供如下特性:

📦 一行命令即可安装和运行大模型(支持 macOS、Linux、Windows WSL)

🧠 支持主流开源模型(如 LLaMA3、Mistral、Gemma、Code LLaMA 等)

🔌 自带 REST API(如 http://localhost:11434/api/generate)便于接入现有系统

🖥️ 可在消费级 PC、本地服务器甚至 M1/M2/M3 Mac 上运行

📁 模型数据完全本地,无需联网

二、什么是 LLaMA3?

LLaMA 3 是 Meta(Facebook 母公司)于 2024 年发布的开源大语言模型:

🌟 提供 8B、70B 参数量版本(8B 可本地运行)

🧠 在多个开源模型基准上性能优异,堪比 GPT-3.5

🆓 开源免费使用,适合企业定制开发

🔍 强调可控性、安全性与开放性

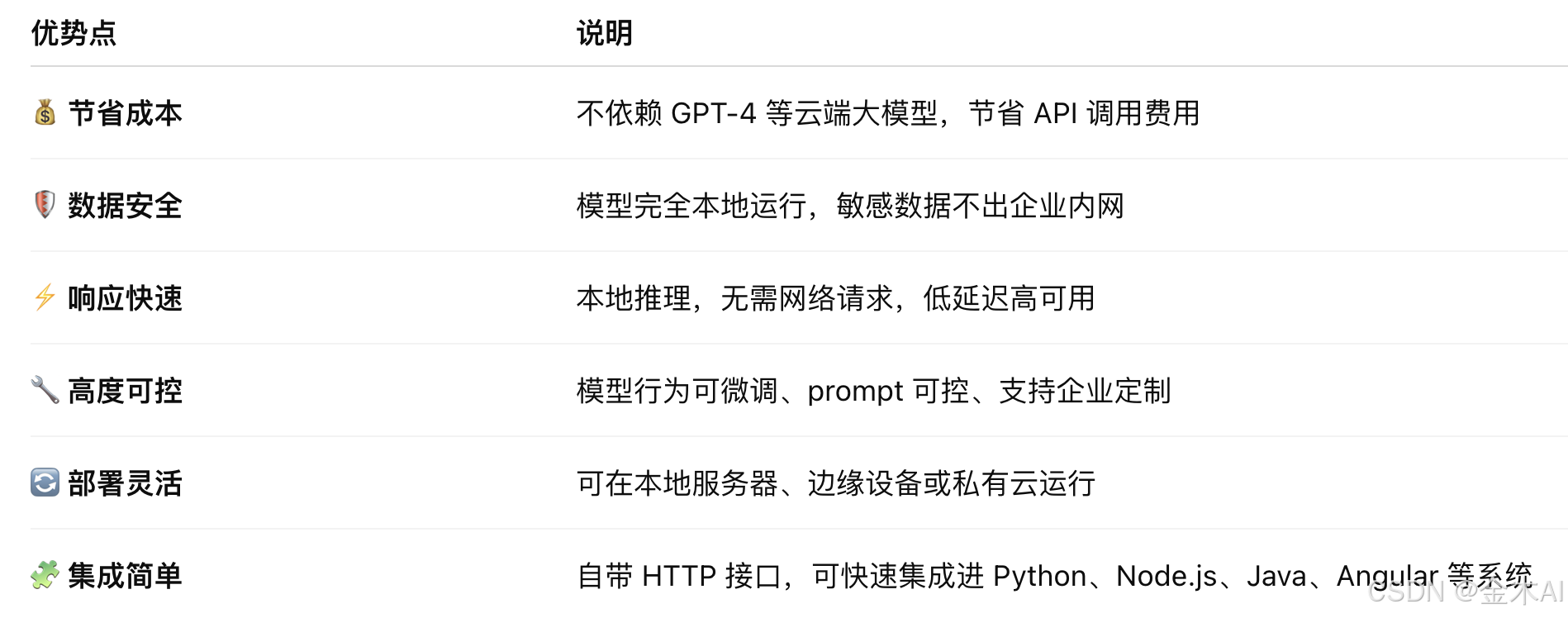

三、为什么推荐企业使用 Ollama + LLaMA3?

四、适合的企业应用场景

📄 内部文档总结、问答、检索增强(RAG)

📊 财报分析、业务汇总、智能报表

🧠 知识库问答、客服机器人

🧾 合同审核、法律助手

💬 企业微信机器人、SaaS 侧边 AI 助手

🔒 涉及隐私或敏感数据(如医疗、金融、政务)场景

五、如何部署?

在 macOS 上本地部署 Ollama + LLaMA3 非常简单,以下是完整步骤:

1、系统要求

(1).macOS 12+

(2).芯片支持 Intel 或 Apple Silicon(M1/M2/M3)

(3).建议内存至少 8GB,推荐 16GB+

2、安装 Ollama(官方推荐)

方式一:使用命令行安装(推荐)

curl -fsSL https://ollama.com/install.sh | sh

方式二:使用 GUI 安装(点击安装包)

访问官网:https://ollama.com

下载 .dmg 安装包并安装

3、安装后验证

ollama --version

如果安装成功,应该返回 Ollama 的版本信息。

4、下载并运行 LLaMA3 模型

- 下载模型(例如 LLaMA 3 8B)

ollama pull llama3

- 启动模型进行聊天:

ollama run llama3

5、以 API 服务方式运行(推荐)

ollama serve

默认监听地址是: http://localhost:11434

6、使用 Python 调用本地模型

import requestsdef get_completion_ollama(prompt: str, model: str = "llama3"):url = "http://localhost:11434/api/chat"headers = {"Content-Type": "application/json"}data = {"model": model,"messages": [{"role": "user", "content": prompt}],"stream": False # 如果想逐字流式输出,改为 True}response = requests.post(url, headers=headers, json=data)result = response.json()return result["message"]["content"]if __name__ == "__main__":prompt = "你好,能不能介绍一下你自己?"result = get_completion_ollama(prompt)print("LLaMA3 回复:", result)print(res.json()["response"])7、常用命令

# 查看当前模型列表

ollama list# 删除模型

ollama rm llama3# 更新 ollama

ollama update