【论文阅读】Defensive Few-shot Learning

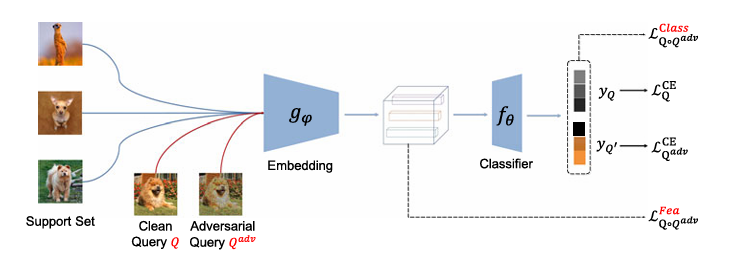

摘要:本文研究了一个新的具有挑战性的问题,称为防御性 Few-shot 学习,以学习一种针对对抗性攻击的稳健 Few-shot 模型。简单地将现有的对抗性防御方法应用于小样本学习并不能有效地解决这个问题。这是因为在小样本设置中无法再满足通常假设的训练集和测试集之间的样本级分布一致性。为了解决这种情况,我们开发了一个通用的防御性小样本学习 (DFSL) 框架来回答以下两个关键问题:(1) 如何将对抗性防御知识从一个样本分布转移到另一个样本分布?(2) 在小镜头设置下如何缩小干净样本和对抗样本之间的分布差距?为了回答第一个问题,我们提出了一种基于剧集的对抗训练机制,通过假设任务级别的分布一致性来更好地传递对抗防御知识。至于第二个问题,在每个小样本任务中,我们设计了两种分布一致性标准,分别从特征和预测的角度缩小干净样本和对抗样本之间的分布差距。广泛的实验表明,所提出的框架可以有效地使现有的小镜头模型对对抗性攻击具有鲁棒性。

这篇文章的核心内容是关于一种新的挑战性问题——防御性少样本学习(Defensive Few-Shot Learning, DFSL),旨在训练出能够抵御对抗性攻击的少样本学习模型。文章首先指出,现有的对抗性防御方法不能直接应用于少样本学习场景,因为少样本学习中训练集和测试集之间的样本级分布一致性假设不再成立。为了解决这一问题,文章提出了一个通用的DFSL框架,并设计了两种分布一致性标准来缩小干净样本和对抗性样本之间的分布差距。通过广泛的实验验证了该框架的有效性,并提供了丰富的基线结果,为未来的研究提供了便利。