上海人工智能实验室的书生·浦语大模型学习笔记(第二期第三课——上篇)

书生·浦语是上海人工智能实验室和商汤科技联合研发的一款大模型,这次有机会参与试用,特记录每次学习情况。

一、课程笔记

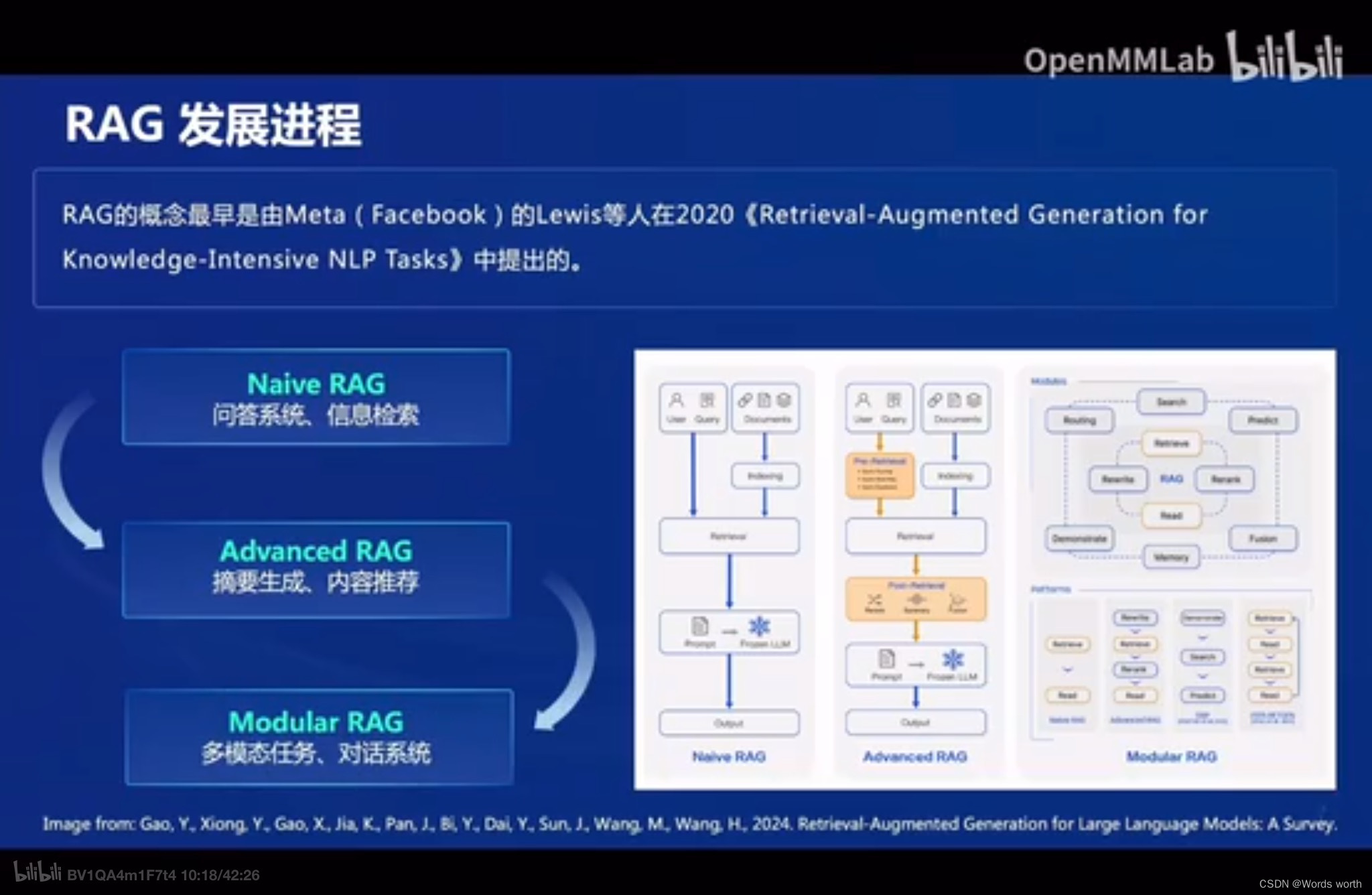

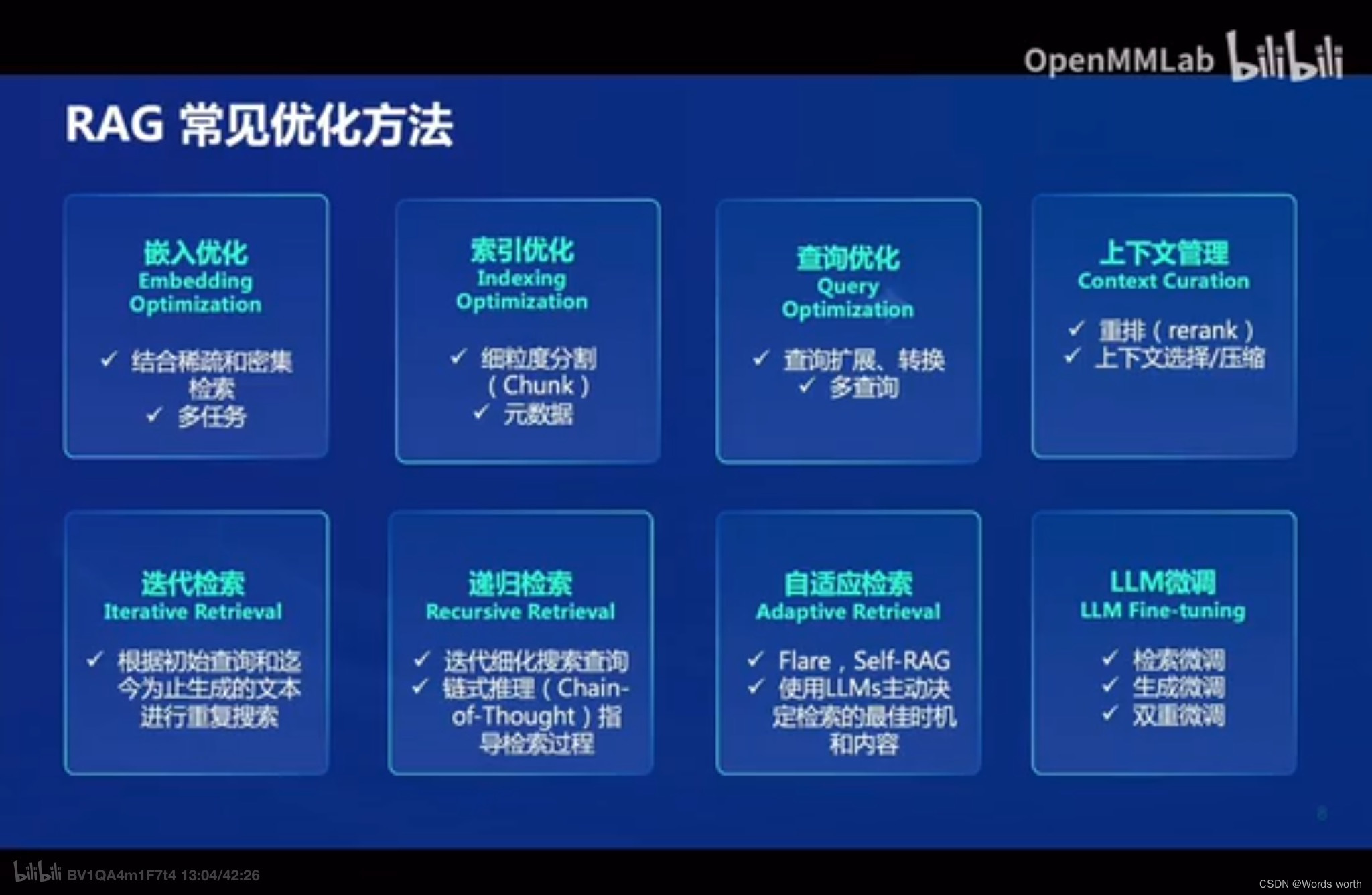

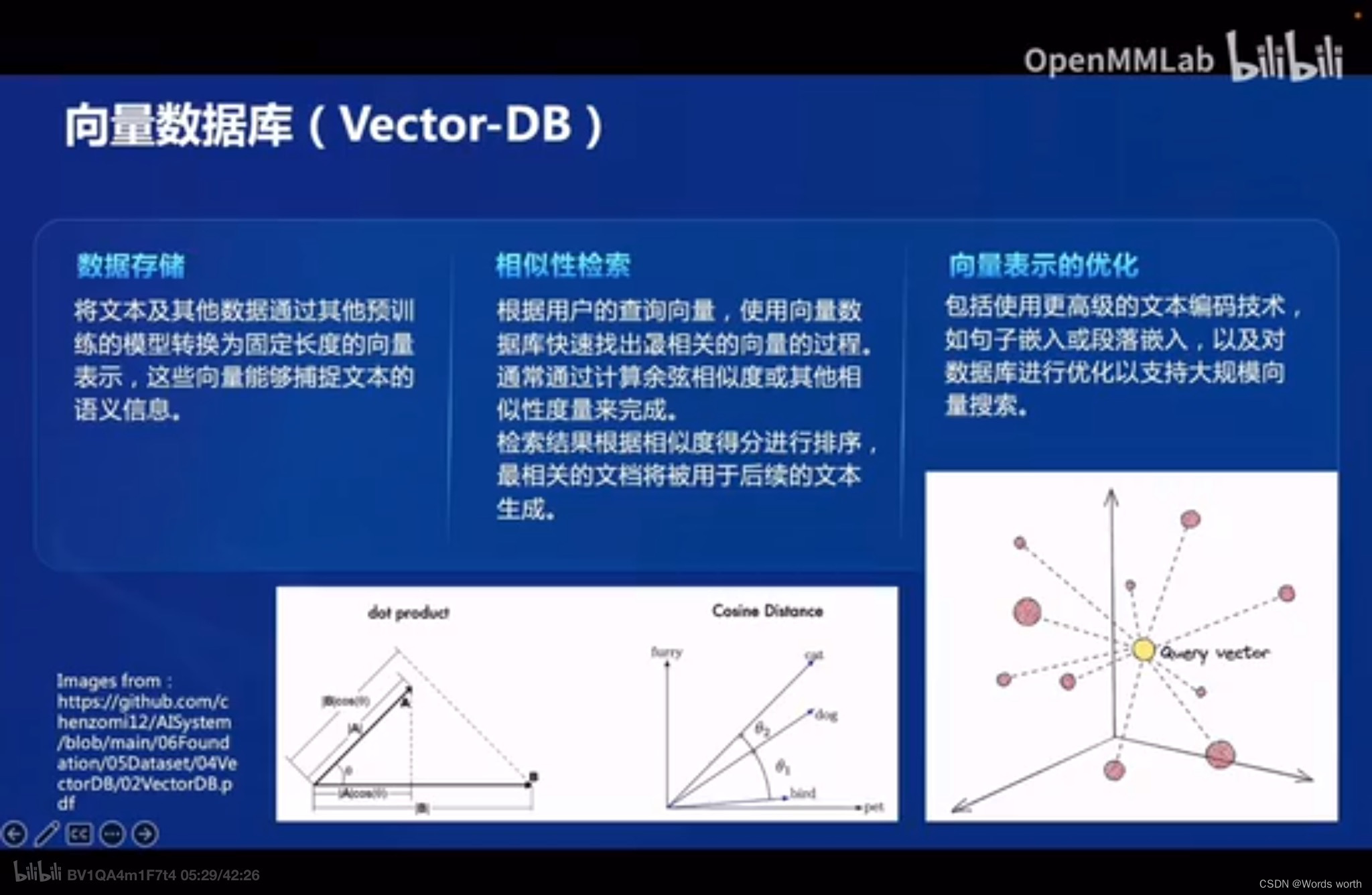

本次学习的是RAG(Retrieval Augmented Generation)技术,它是通过检索与用户输入相关的信息片段,并结合外部知识库来生成更准确、更丰富的回答。解决 LLMs 在处理知识密集型任务时可能遇到的挑战, 如幻觉、知识过时和缺乏透明、可追溯的推理过程等。提供更准确的回答、降低推理成本、实现外部记忆。

RAG 能够让基础模型实现非参数知识更新,无需训练就可以掌握新领域的知识。本次课程选用的茴香豆应用,就应用了 RAG 技术,可以快速、高效的搭建自己的知识领域助手。

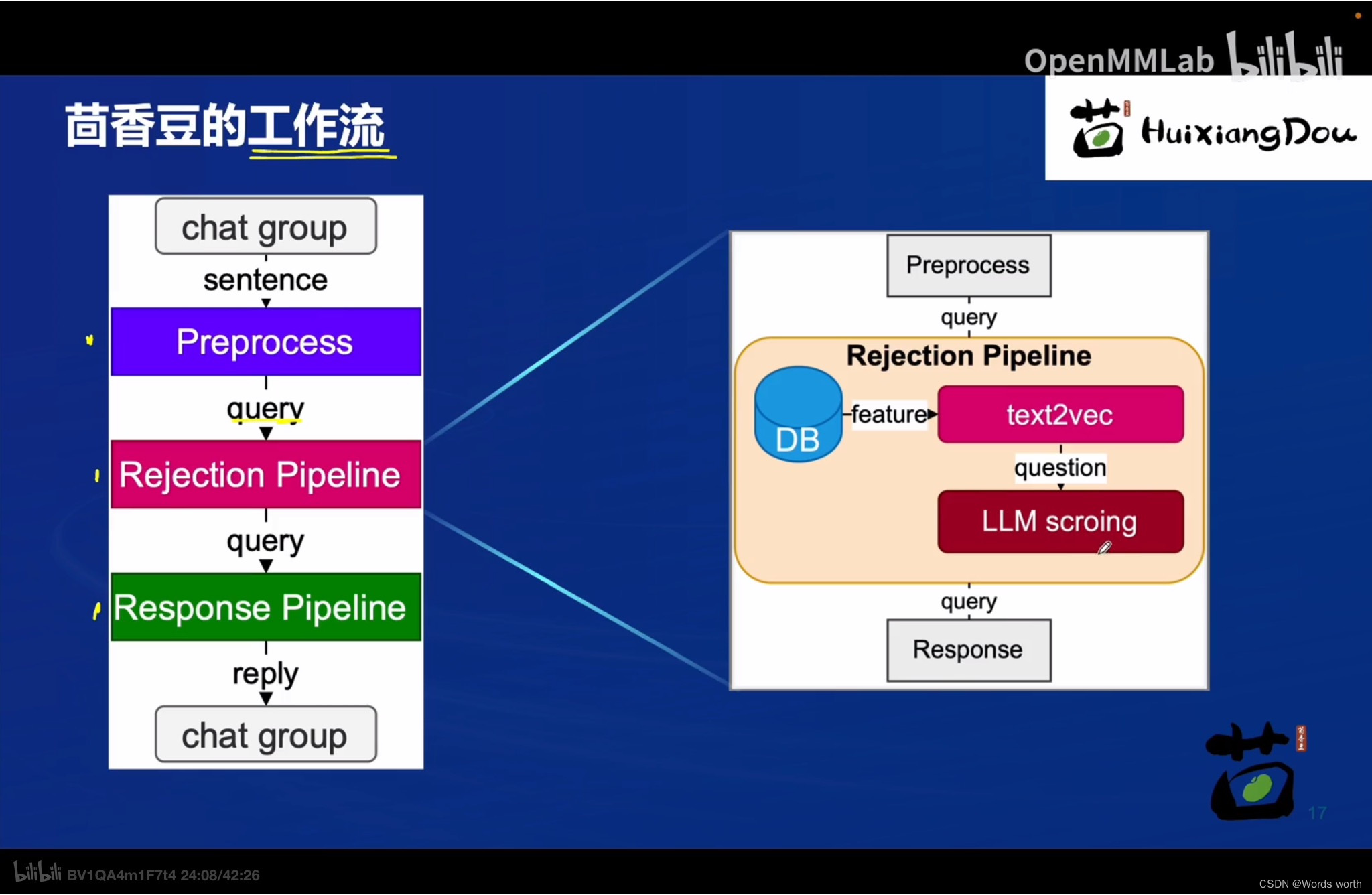

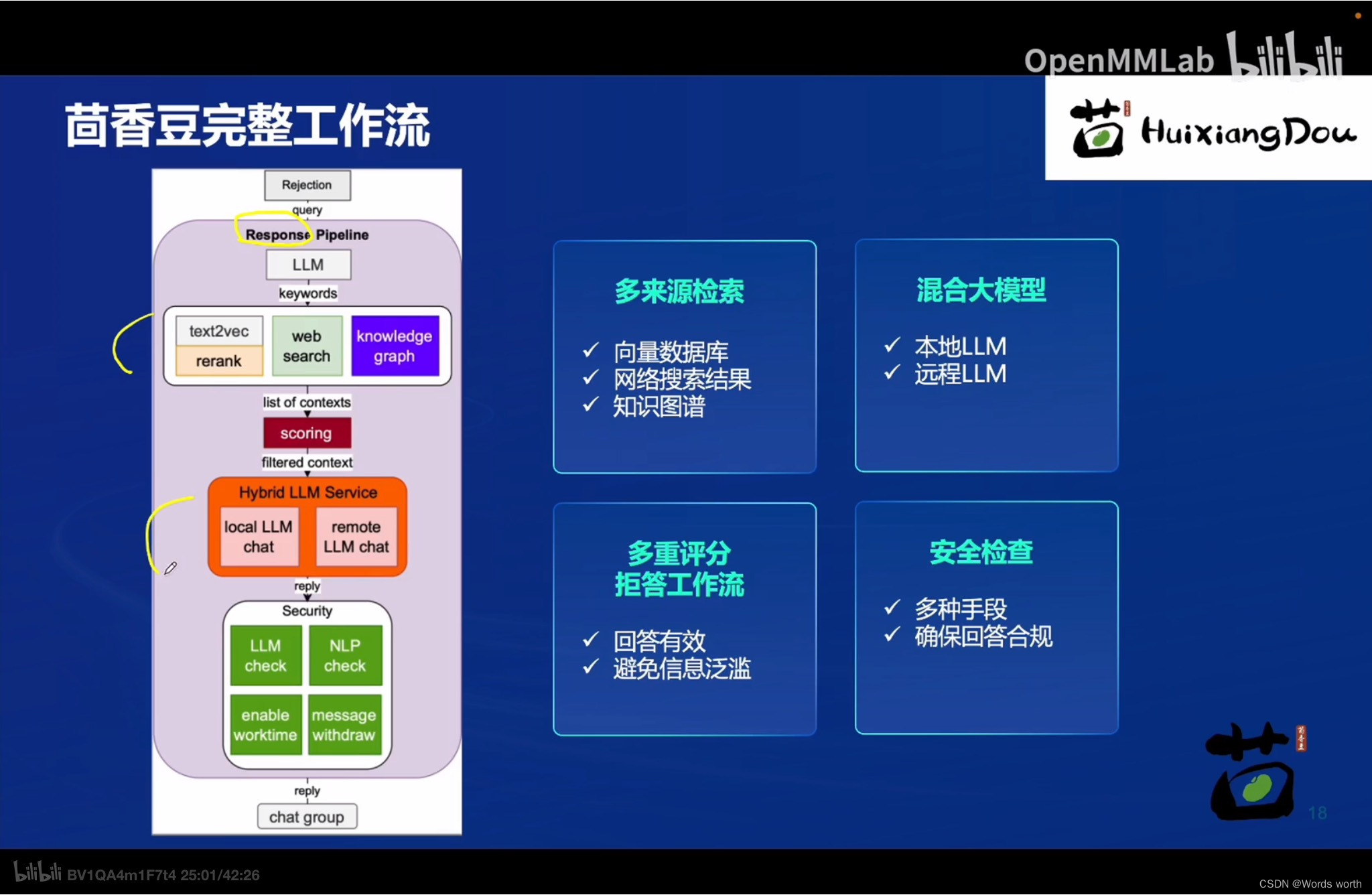

“茴香豆”是一个基于 LLM 的领域知识助手。特点:

“茴香豆”是一个基于 LLM 的领域知识助手。特点:

- 应对群聊这类复杂场景,解答用户问题的同时,不会消息泛滥

- 提出一套解答技术问题的算法 pipeline

- 部署成本低,只需要 LLM 模型满足 4 个 trait 即可解答大部分用户问题

二、作业

(一)基础作业

1、在

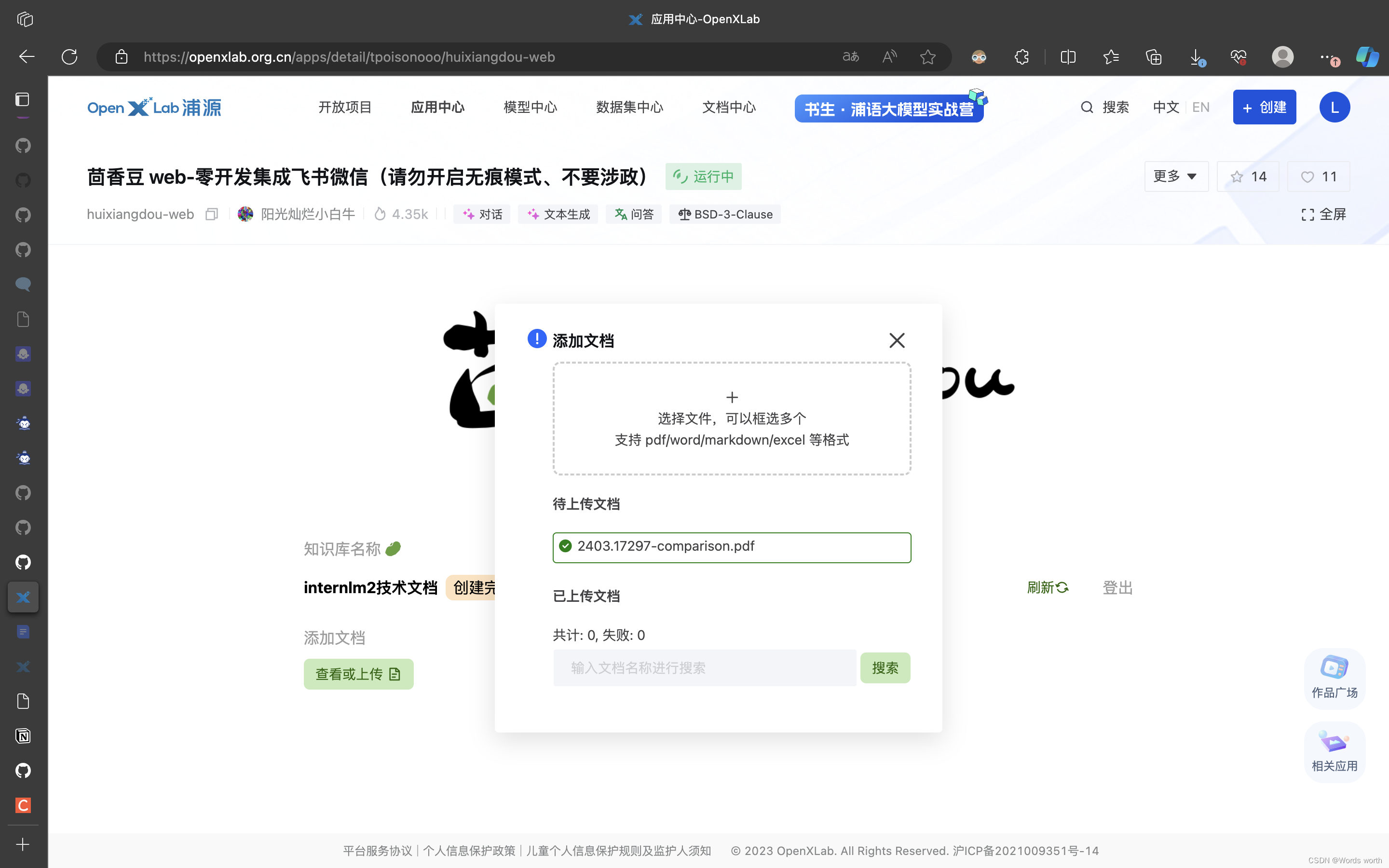

茴香豆web版中创建自己领域的知识问答助手

(1)登陆茴香豆web版OpenXLab浦源 - 应用中心应用中心提供应用托管的服务,用户只需遵循平台规范,通过简单的前端封装组件(Gradio)即可构建模型推理应用演示demo,应用中心提供免费应用部署的能力,普通用户也可在应用中心中交互式体验模型的能力,更好帮助用户寻找想要的学术模型或应用服务。通过前端封装组件和平台的SDK工具,帮助AI开发者简单快速构建人工智能应用。 https://openxlab.org.cn/apps/detail/tpoisonooo/huixiangdou-web

https://openxlab.org.cn/apps/detail/tpoisonooo/huixiangdou-web

(2)在网页页面输入自己的知识数据库的账号密码。

第一次使用的时候,它会自动生成一个账号。

账号生成成功。

(3)上传文档

上传InterML技术报告

上传文档成功。 截止现在,一切顺利,操作简单。

(3)在问答区中作答。

提问一:请介绍InternLM2模型

提问二:InternLM2模型是由哪个组织开发的?

提问三:除了上海人工智能实验室,还有哪些机构参与撰写了这篇论文?

提问四:介绍InternLM2模型的评测结果

提问五:InternLM2模型采用了哪些预训练技术?