datax导入到hive的数据量翻倍

现象 mysql->hive 或者oracle->hdfs

源表数据100w 结果hive表数据200w。

这个现象很容易发生,只要你同一时间调度这个json两次。

原因

"writeMode" : "append", "nonconflict","truncate"

* append,写入前不做任何处理,data-ingestion hdfswriter直接使用filename写入,并保证文件名不冲突。 * truncate 会把filename的文件的删掉 * nonConflict,如果目录下有fileName前缀的文件,直接报错。

那么问题出在哪里呢?

因为hive的数据底层就是文件,有文件就有数据,这中间并没有像mysql这种插入一条数据这种事务关系。

例如 append 你执行了两次肯定double

truncate为什么会double呢?

因为datax的执行逻辑是

1.先删除文件

2. 在stageing目录写数据文件

3.最后rename到目标目录。

其中2->3少的有十几秒,多的有几十分钟。

在这段时间内 如果我又执行了一个这个任务,会发生什么呢?

1.删文件,结果前面的都删完了,那我就不删了呗

2. 在stageing目录写数据文件

3.最后rename到目标目录。

2和3步骤重复运行了两次。按道理来说第二次应该把第一次的数据文件删除,可是别人也没跑完,而且还不在同一个目录。怎么删

只好将错就错,到最后就有了两份文件。

所以问题很清楚。解决办法也很简单

1.在我rename的之前我再删一次。

2.在我rename之前我发现突然又有文件了,那我就把自己删了

前者属于删别人,后者属于删自己

个人觉得后者好。

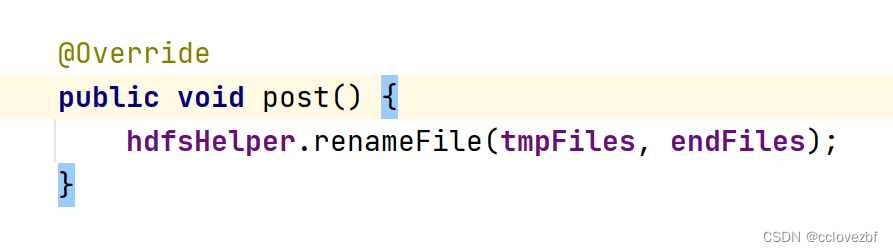

就是在这里rename之前 判断目录下是否有文件,有文件就删除!!