卷积神经网络-池化层和激活层

2.池化层

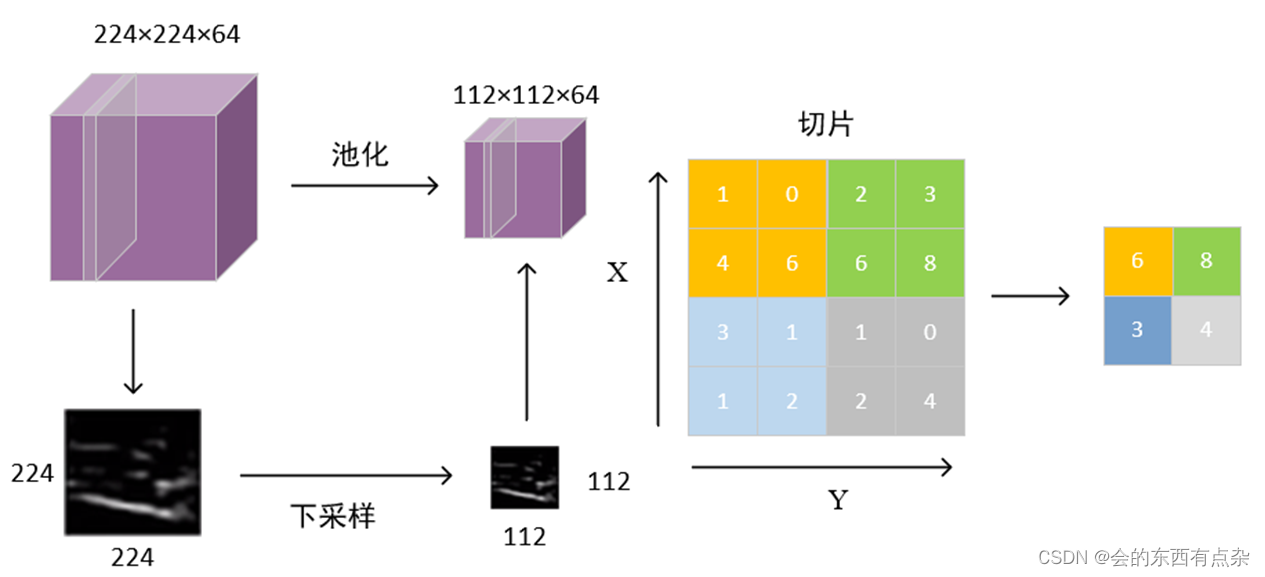

根据特征图上的局部统计信息进行下采样,在保留有用信息的同时减少特征图的大小。和卷积层不同的是,池化层不包含需要学习的参数。最大池化(max-pooling)在一个局部区域选最大值作为输出,而平均池化(average pooling)计算一个局部区域的均值作为输出。局部区域池化中最大池化使用更多,而全局平均池化(global average pooling)是更常用的全局池化方法。

池化的核通常采用2×2的大小,平均池化就是计算2×2范围内的平均值,最大池化就是取该范围内的最大值。目前比较常用的是最大池化。在经过池化后,原图像的channel是不发生改变的。

池化层的作用:

3.激活层

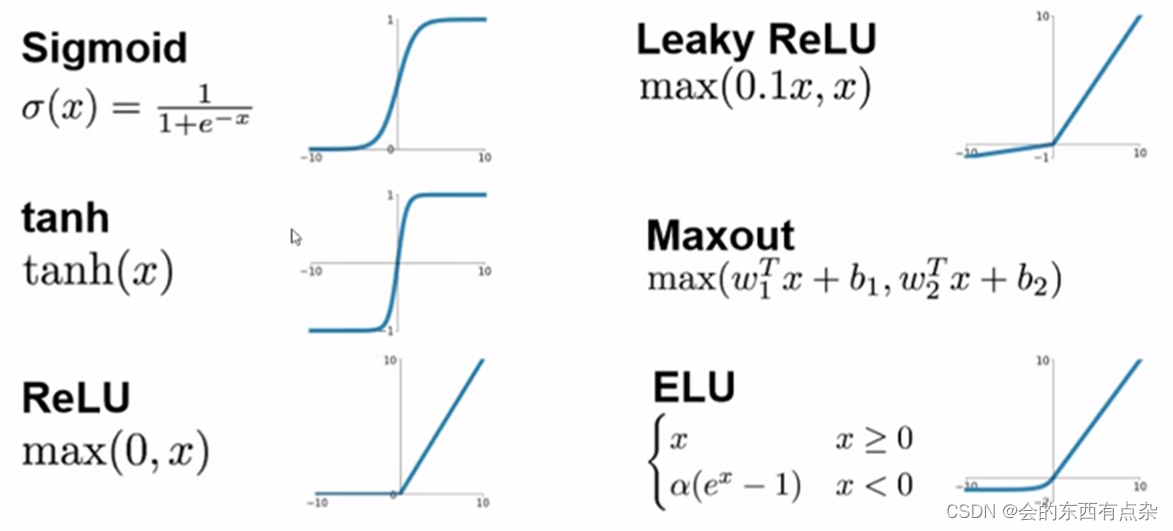

激活层的作用在于将前一层的线性输出,通过非线性的激活函数进行处理,这样用以模拟任意函数,从而增强网络的表征能力。激活层常用的函数包括sigmoid和ReLu(Rectified-Linear Unit,修正线性单元)等。激活函数是一些非线性的函数,这些函数的特性有所不同:

1.sigmoid函数可以将数值压缩到[0, 1]的区间。

2.tanh可以将数值压缩到[-1, 1]的区间。

3.ReLu函数实现一个取正的效果,所有负数的信息都抛弃。

4.LeakyReLu是一种相对折中的ReLu,认为当数值为负的时候可能也存在一定有用的信息,那么就乘以一个系数0.1(可以调整或自动学习),从而获取负数中的一部分信息。

5.Maxout使用两套参数,取其中值大的一套作为输出。

6.ELU类似于LeakyReLu,只是使用的公式不同。

以Tensorflow为例学习如何搭建这些层的方法:

卷积层:tf.nn.conv2d(input, filter, strides, padding)

激活层:tf.nn.relu()

池化层:tf.nn.max_pool()(最大池化)