搭建ELK+Filebead+zookeeper+kafka实验

部署 Zookeeper 集群

准备 3 台服务器做 Zookeeper 集群

192.168.10.17

192.168.10.21

192.168.10.22

1.安装前准备

关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

安装 JDK

yum install -y java-1.8.0-openjdk java-1.8.0-openjdk-devel

java -version

下载安装包

官方下载地址:https://archive.apache.org/dist/zookeeper/

2.安装 Zookeeper

![]()

![]()

![]()

修改配置文件

![]()

vim zoo.cfg

tickTime=2000 #通信心跳时间,Zookeeper服务器与客户端心跳时间,单位毫秒

initLimit=10 #Leader和Follower初始连接时能容忍的最多心跳数(tickTime的数量),这里表示为10*2s

syncLimit=5 #Leader和Follower之间同步通信的超时时间,这里表示如果超过5*2s,Leader认为Follwer死掉,并从服务器列表中删除Follwer

dataDir=/usr/local/zookeeper-3.5.7/data ●修改,指定保存Zookeeper中的数据的目录,目录需要单独创建

dataLogDir=/usr/local/zookeeper-3.5.7/logs ●添加,指定存放日志的目录,目录需要单独创建

clientPort=2181 #客户端连:接端口

#添加集群信息

server.1=192.168.88.50:3188:3288

server.2=192.168.88.60:3188:3288

server.3=192.168.88.70:3188:3288

拷贝配置好的 Zookeeper 配置文件到其他机器上

scp /usr/local/zookeeper-3.5.7/conf/zoo.cfg 192.168.88.60:/usr/local/zookeeper-3.5.7/conf/

scp /usr/local/zookeeper-3.5.7/conf/zoo.cfg 192.168.88.70:/usr/local/zookeeper-3.5.7/conf/ 因为用了全体输入的工具,这步可以省略

在每个节点上创建数据目录和日志目录

![]()

在每个节点的dataDir指定的目录下创建一个 myid 的文件 echo 1 > /usr/local/zookeeper-3.5.7/data/myid 50服务器myid为1

echo 2 > /usr/local/zookeeper-3.5.7/data/myid 60服务器myid为2

echo 3 > /usr/local/zookeeper-3.5.7/data/myid 70服务器myid为3

配置 Zookeeper 启动脚本

![]()

设置开机自启

![]()

分别启动 Zookeeper

查看当前状态

此时60为leader

安装 Kafka

![]()

![]()

修改配置文件

![]()

![]()

![]()

21行,broker的全局唯一编号,每个broker不能重复,因此要在其他机器上配置 broker.id=1、broker.id=2

![]()

![]()

![]()

listeners=PLAINTEXT://192.168.10.17:9092 ●31行,指定监听的IP和端口,如果修改每个broker的IP需区分开来,也可保持默认配置不用修改

![]()

log.dirs=/usr/local/kafka/logs #60行,kafka运行日志存放的路径,也是数据存放的路径

![]()

123行,配置连接Zookeeper集群地址

修改环境变量

![]()

![]()

配置 Zookeeper 启动脚本

![]()

设置开机自启

![]()

分别启动 Kafka

![]()

3.Kafka 命令行操作

//创建topic

查看当前服务器中的所有 topic

查看某个 topic 的详情

在50发布消息

在60或70消费消息

2.部署 Filebeat

#添加输出到 Kafka 的配置

output.kafka:

enabled: true

hosts: ["192.168.88.50:9092","192.168.88.60:9092","192.168.88.70:9092"] #指定 Kafka 集群配置

topic: "httpd" #指定 Kafka 的 topic

部署 Filebeat

![]()

刷新几下就会有日志进行传输

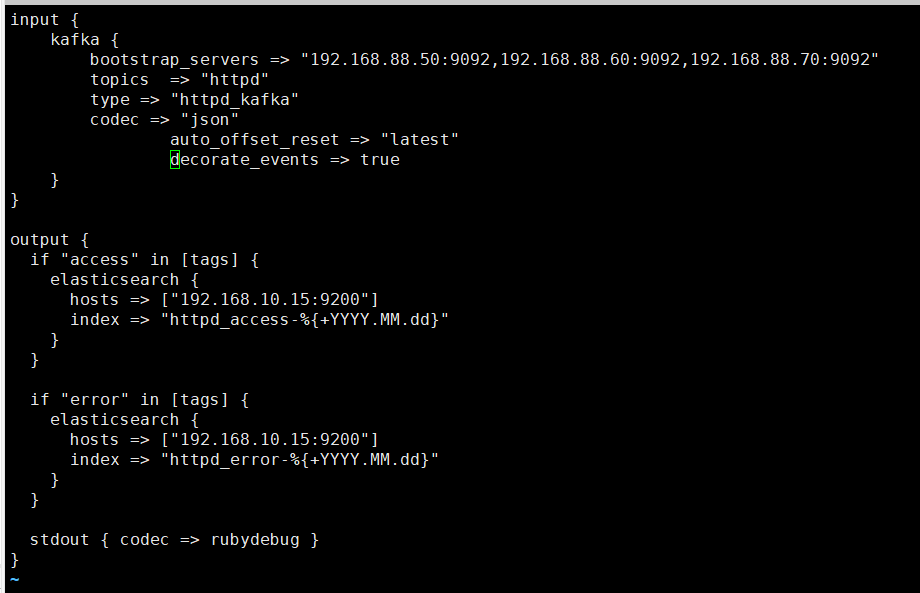

在logstash服务中进行操作30机器