8.18 机器学习-决策树(1)

决策树

1. 树模型本质

分类/回归:数据从根节点→叶子节点逐步决策,最终落在叶子节点。

2. 树的组成

根节点:第一个分裂的选择点。

非叶子节点:中间判断条件的过程。

叶子节点:最终决策的结果。

3. 训练 vs 测试

训练阶段:用训练集选择特征、切分节点。

测试阶段:按已建好的树路径直接进行预测。

4. 特征选择标准

熵:衡量数据不确定性(熵越低→数据不确定性越小)。

信息增益:特征分裂后熵的不确定减少的程度(增益越大→特征越优)。

5. 构造实例(以“14天打球”为例)

步骤:

计算原始熵(9打球/5不打球 → 熵=0.940)。

计算各特征(如Outlook)的条件熵和信息增益。

选增益最大的特征作为根节点,递归生成子树。

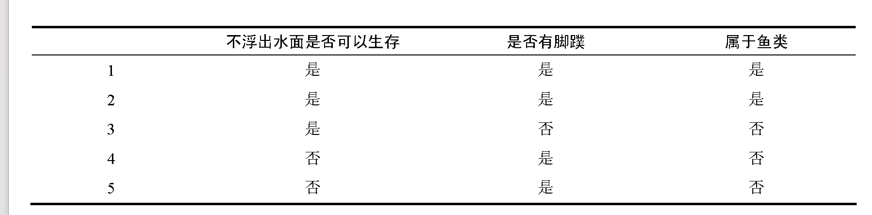

课堂练习:通过数据集构造决策树

1、总熵:

E(D)=−k∑plog2(p)

(属于鱼类=是):2个(1、2)

(属于鱼类=否):3个(3、4、5)

熵≈0.971

2、信息增益

是:3(1、2、3)

熵:−(32log232+31log231)≈0.918

否:2(4、5)

熵:0

信息增益=0.420