【学习笔记】面向AI安全的26个缓解措施

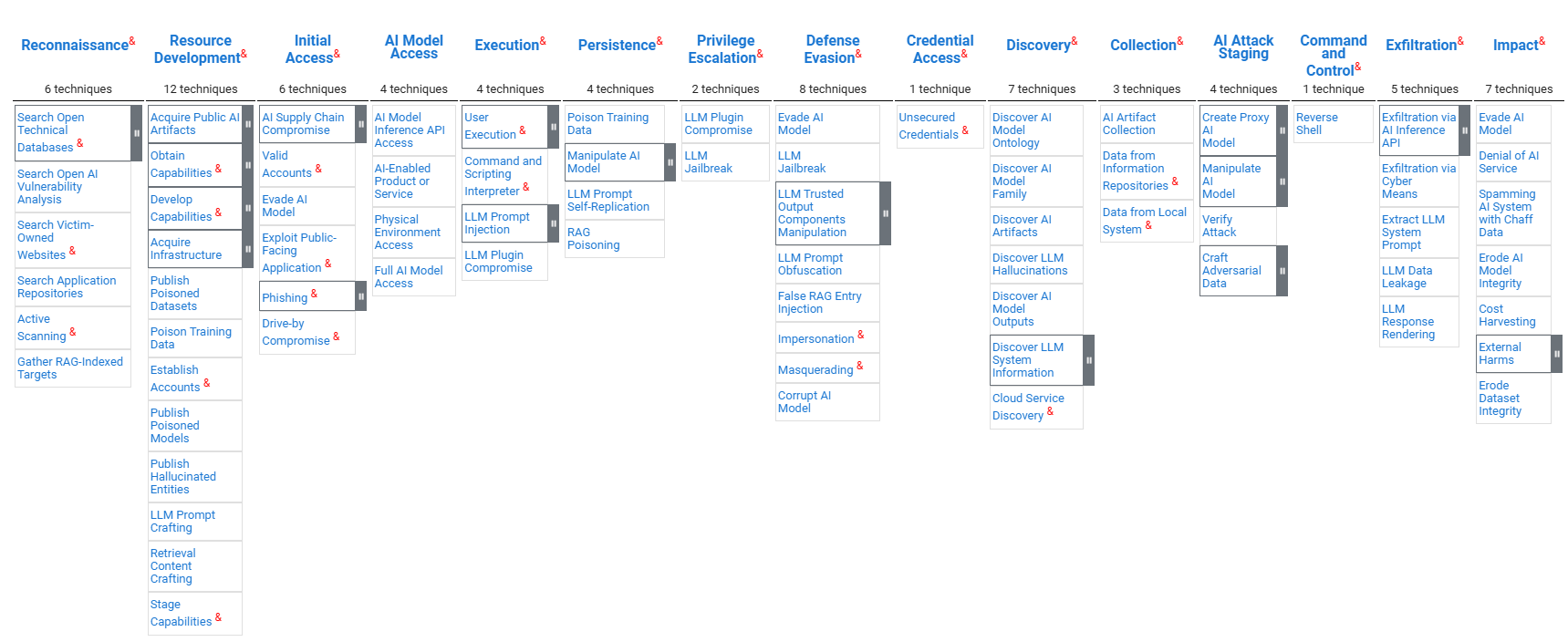

一、Mitre Atlas矩阵概述

ATLAS 矩阵从左到右以列形式显示了攻击中使用的策略的进展,ML 技术属于上面的每种策略。& 表示从 ATT&CK 改编而来。

ATLAS 矩阵从左到右以列形式显示了攻击中使用的策略的进展,ML 技术属于上面的每种策略。& 表示从 ATT&CK 改编而来。

详见:ATLAS Matrix | MITRE ATLAS™

注:机翻的效果不是太好,对照理解用吧。

二、缓解措施

▎限制公开信息

限制公开发布组织产品或服务中使用的 AI 堆栈的技术信息。攻击者可以利用 AI 使用方式的技术知识来执行针对性攻击,并针对目标系统进行定制攻击。此外,考虑限制发布组织信息(包括实际位置、研究人员姓名和部门结构),因为这些信息可能推断出 AI 技术、模型架构或数据集等技术细节。

▎限制模型发布信息

限制公开发布技术项目细节,包括生产中使用的或代表生产中使用的数据、算法、模型架构和模型检查点。

▎被动AI输出混淆

降低向最终用户提供的模型输出的保真度可以降低对手提取有关模型的信息和优化模型攻击的能力。

▎模型强化

使用技术使 AI 模型对对抗性输入(例如对抗性训练或网络蒸馏)具有鲁棒性。

▎限制模型查询

限制用户可以执行的查询总数和速率。

▎控制模型访问权限

建立内部模型注册表的访问控制,并限制内部对生产模型的访问。仅限经批准的用户访问训练数据。

▎使用模型集成架构

使用模型集成进行推理,以增强对对抗性输入的鲁棒性。某些攻击可能有效规避某个模型或模型系列,但对其他模型或模型系列无效。

▎净化训练数据

检测并移除或修复中毒的训练数据。在模型训练之前,应先对训练数据进行清理,并在主动学习模型中反复进行清理。通过过滤器以限制摄入的训练数据。制定内容政策,删除不受欢迎的内容,例如某些露骨或冒犯性的语言。

▎验证模型完整性

通过测试后门触发器或对抗性偏见,验证 AI 模型是否按预期运行。监控模型中的概念漂移和训练数据漂移,这可能表明数据被篡改和中毒。

▎使用多模传感器

结合多个传感器来整合不同的视角和模式,以避免容易受到物理攻击的单点故障。

▎输入恢复

预处理所有推理数据以消除或逆转潜在的对抗性扰动。

▎限制库加载

通过配置适当的库加载机制和调查潜在的易受攻击的软件,防止滥用操作系统和软件中的库加载机制来加载不受信任的代码。通常用于存储 AI 模型的文件格式(例如 pickle 文件)可能包含允许加载恶意库的漏洞。

▎加密敏感信息

加密 AI 模型等敏感数据,以防止对手试图访问敏感数据。

▎代码签名

通过数字签名验证强制执行二进制和应用程序完整性,以防止不受信任的代码执行。攻击者可以将恶意代码嵌入 AI 软件或模型中。强制执行代码签名可以防止 AI 供应链受到损害,并阻止恶意代码的执行。

▎验证AI组件

验证所有 AI 组件的加密校验和,以确认文件未被攻击者修改。

▎对抗性输入检测

检测并阻止对抗性输入或异常查询,这些查询偏离了已知的良性行为,表现出先前攻击中观察到的行为模式,或来自潜在恶意 IP。在 AI 模型之前,将对抗性检测算法集成到 AI 系统中。

▎漏洞扫描

洞扫描用于查找可能被利用的软件漏洞并进行修复。诸如 pickle 文件之类的常用于存储 AI 模型的文件格式可能包含允许任意代码执行的漏洞。应扫描这些文件以查找潜在的不安全调用,这些调用可能被用于执行代码、创建新进程或建立网络功能。攻击者可能会在损坏的模型文件中嵌入恶意代码,因此扫描程序应该能够处理无法完全反序列化的模型。模型工件及其生成的下游产品都应进行已知漏洞扫描。

▎模型分布

将 AI 模型部署到边缘设备可能会增加系统的攻击面。考虑在云端提供模型服务,以降低攻击者对模型的访问级别。此外,还应考虑在云端使用计算功能,以防止灰盒攻击(攻击者可以访问模型预处理方法)。

▎用户教育

对人工智能模型开发人员进行安全编码实践和人工智能漏洞方面的教育。

▎身份验证

要求用户在访问生产模型之前验证其身份。要求对 API 端点进行身份验证,并监控生产模型查询,以确保符合使用政策并防止模型滥用。

▎生成式AI护栏

护栏是设置在生成式AI模型与用户共享的输出之间的安全控制措施,用于防止不必要的输入和输出。护栏可以采用验证器的形式,例如过滤器、基于规则的逻辑或正则表达式,也可以采用基于AI的方法,例如分类器和使用LLM或命名实体识别(NER)来评估提示或响应的安全性。可以采用特定领域的方法来降低价值观、品牌损害、越狱、虚假信息、代码漏洞、SQL注入和数据泄露等各个领域的风险。

▎生成式AI指南

指南是位于用户提供的输入和生成式 AI 模型之间的安全控制,旨在帮助指导模型产生所需的输出并防止不良输出。指南可以作为附加在所有用户提示后的说明,也可以作为系统提示中的一部分。指南可以定义系统的目标、角色和声音,并概述安全参数。

▎生成式AI对齐

在训练或微调生成式 AI 模型时,重要的是利用能够改善模型与安全性、保障性和内容策略的一致性的技术。微调过程可能会消除生成式人工智能模型中的内置安全机制,但利用监督微调、从人类反馈或人工智能反馈中进行强化学习以及有针对性的安全上下文提炼等技术可以提高模型的安全性和一致性。

▎构建AI物料清单

人工智能物料清单 (AI BOM) 包含构建人工智能所需的所有工件和资源的完整列表。AI BOM 有助于降低供应链风险,并快速响应已报告的漏洞。这可以包括维护数据集来源,即用于人工智能应用的数据集的详细历史记录。历史记录可以包括数据集来源的信息以及任何修改的完整记录。

▎AI日志审计

实现已部署 AI 模型的输入和输出日志记录。监控日志有助于检测安全威胁并减轻影响。此外,启用日志记录可以阻止那些想要不被发现的对手利用人工智能资源。

▎数据集来源管理

维护用于人工智能应用的数据集的详细历史记录。历史记录应包括数据集来源信息以及所有修改的完整记录。

参考文献:

面向AI安全的26个防御措施(MITRE ATLAS,2025)