ollama大模型

去年为了完成课程设计在电脑上装了ollama大模型

装的是Mistral-Nemo版本的,因为比较小,不会占用太多空间。

好久没用差点要把命令给忘记了,现此记录一下

要在本地安装 Ollama 并部署 Mistral-Nemo 模型,请按照以下步骤操作:

一、安装 Ollama

Ollama 是一个用于管理和运行大型语言模型的工具,支持多种操作系统。

1. 下载 Ollama:

访问 Ollama 的官方网站,下载适用于您操作系统的安装包。

对于 Windows 用户,下载 Windows 版本的安装程序。

2. 安装 Ollama:

运行下载的安装程序,按照提示完成安装。

安装完成后,您可以通过命令行输入 ollama --version 来验证安装是否成功。

二、下载并部署 Mistral-Nemo 模型

Mistral-Nemo 是由 Mistral AI 和 NVIDIA 联合开发的 12B 参数模型,支持 128k 的上下文窗口,性能优异。

1. 下载模型:

打开命令提示符或终端,输入以下命令下载 Mistral-Nemo 模型:

ollama pull mistral-nemo

该命令将从 Ollama 的模型库中拉取 Mistral-Nemo 模型到本地。

2. 运行模型:

模型下载完成后,您可以使用以下命令运行模型:

ollama run mistral-nemo

此时,您可以在命令行中与模型进行交互,输入您的问题,模型将生成相应的回答。

三、注意事项

系统要求:

确保您的计算机满足 Ollama 和 Mistral-Nemo 模型的运行要求,特别是内存和存储空间。

环境变量配置:

在 Windows 系统中,如果遇到 ollama 命令无法识别的问题,可能需要将 Ollama 的安装路径添加到系统的环境变量中。

具体操作:右键“此电脑”或“我的电脑” → 属性 → 高级系统设置 → 环境变量 → 在系统变量中找到 Path → 编辑 → 新建,添加 Ollama 的安装路径。

模型存储路径:

默认情况下,Ollama 将模型存储在用户目录下的 .ollama/models 文件夹中。

如果需要更改模型的存储位置,可以设置环境变量 OLLAMA_MODELS,将其值设为您希望的路径。

通过以上步骤,您即可在本地成功安装 Ollama 并运行 Mistral-Nemo 模型。

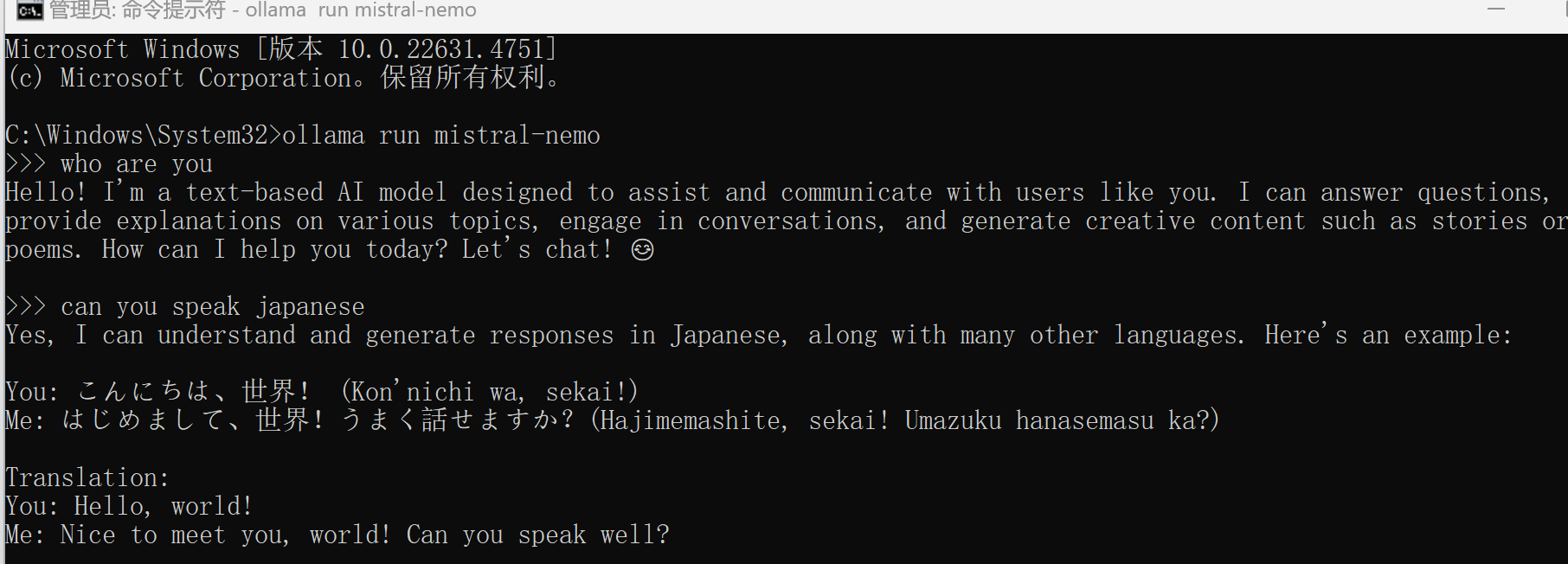

参考如下图所示:

模型内置一个数据库,它能回答你的问题但是不能联网,作为语言模型好像能处理多种语言(中文日语什么的都没问题)