深入解析Hadoop NameNode的Full GC问题、堆外内存泄漏及元数据分治策略

Hadoop NameNode Full GC问题的现象与影响

现象识别:Full GC的典型表现

当NameNode发生Full GC时,集群监控系统通常会捕捉到以下关键指标异常:

- 1. JVM停顿告警:通过JvmPauseMonitor日志可观察到持续数秒的停顿事件(如腾讯云案例中记录的7-8秒停顿),典型日志格式为"Detected pause in JVM or host machine (eg GC): pause of approximately Xms"。

- 2. GC时间激增:CMS收集器显示单次回收时间突破秒级(参考CSDN案例中记录的7692ms),远超200ms的健康阈值。

- 3. 心跳超时:DataNode与NameNode间的心跳包出现丢失,JournalNode写操作超时(如某案例中20秒默认超时触发),导致HA集群可能误判主节点失效。

性能影响的多维分析

1. 请求处理能力断崖式下跌

- • 单次Full GC期间所有JVM线程暂停,导致RPC队列堆积。某生产环境数据显示,8秒GC停顿会使NameNode的RPC队列从正常<50激增至2000+,处理延迟从毫秒级恶化到分钟级。

- • 文件系统操作吞吐量下降90%以上(腾讯云测试数据),新建文件操作成功率可能从99.99%降至80%。

2. 集群稳定性风险

- • HA场景下,ZKFC可能因GC停顿误判NameNode失活,触发不必要的故障转移。某金融机构集群曾因连续Full GC导致6小时内发生3次非计划切换。

- • 长时间GC可能引发JournalNode写超时(如博客园案例中的20000ms超时),导致editlog同步失败,迫使NameNode主动退出以保持数据一致性。

3. 级联故障效应

- • DataNode因长时间收不到指令,可能误判副本丢失而触发过量复制。某电商大促期间,NameNode Full GC引发200+DataNode同时发起block复制,瞬间打满集群带宽。

- • YARN ResourceManager因无法获取HDFS状态,可能错误终止正在写入数据的任务,造成计算资源浪费。

根因与表象的关联性

内存管理缺陷的具象化

- • 元数据爆炸场景下(如单集群超1亿文件对象),传统CMS收集器面临挑战。某云厂商测试表明,当老年代使用率超过70%时(-XX:CMSInitiatingOccupancyFraction=70),并发模式失败概率呈指数上升。

- • 堆外内存泄漏会加剧GC压力。DirectBuffer未及时释放时,JVM需通过System.gc()触发Full GC来回收native memory,但此机制在Hadoop中往往被-XX:+DisableExplicitGC参数禁用。

监控盲区带来的恶化

- • 默认配置下,JVM停顿监控存在采样间隔过长(如5分钟)的问题,可能错过间歇性Full GC。某运维团队通过将JvmPauseMonitor的检测间隔从300秒调整为30秒,提前发现了80%的潜在GC问题。

影响持续时间的决定因素

- 1. 堆内存规模:64GB堆的Full GC耗时通常是16GB堆的3-5倍(阿里云JVM团队测试数据)

- 2. 元数据结构复杂度:包含大量小文件(<1MB)的命名空间,其INode对象树遍历耗时比大文件为主的集群高40%

- 3. JVM版本差异:JDK8u60+版本的CMS优化可使Full GC时间减少30%,而JDK11的ZGC能实现亚秒级停顿

典型故障模式分析

案例1:元数据区耗尽

某视频平台集群因Metaspace默认配置20MB过小,频繁触发Full GC。监控显示每次GC后Metaspace使用率从99%骤降至30%,但1小时内又回弹至警戒线(华为云MRS文档案例)。

案例2:老年代碎片化

社交媒体的HDFS集群在持续运行3个月后,CMS收集器出现"concurrent mode failure",被迫转为Serial Old GC,单次停顿达12秒(CNBlogs案例)。

案例3:不均衡负载触发

某证券交易系统在开盘时段的集中写入,使NameNode堆内存使用率在10分钟内从40%飙升至95%,连续触发3次Full GC导致交易延迟报警(腾讯云金融客户实例)。

Full GC问题的原因分析与优化建议

堆内存不足:元数据爆炸的连锁反应

NameNode作为HDFS的元数据中心,其堆内存主要承载文件系统命名空间(文件/目录的inode信息)和块映射表(BlockMap)。当集群规模扩大时,元数据量呈指数级增长,典型表现为:

- • 文件对象数量与内存消耗的线性关系:每百万级文件对象约消耗1GB堆内存(腾讯云实践数据)。若集群存在5000万文件对象,默认配置的4GB堆内存会迅速耗尽,触发频繁Full GC。

- • 老年代空间碎片化:NameNode长期运行后,老年代中元数据对象因增删改操作产生内存碎片,导致即使总体内存充足,也无法分配连续空间,引发"Concurrent Mode Failure"(CMS回收器特有现象)。

优化方案:

- 1. 动态内存扩容公式:

建议堆内存 = max(4GB, 每百万文件对象 × 1GB × 安全系数1.2)例如2000万文件对象应配置

-Xms24G -Xmx24G(含20%缓冲)。 - 2. 分代策略调优:

- • 新生代与老年代比例调整为1:3(默认1:2),避免大对象直接晋升老年代

- • 添加CMS参数:

-XX:+UseCMSInitiatingOccupancyOnly -XX:CMSInitiatingOccupancyFraction=65确保老年代占用达65%时即启动回收,预留35%空间应对突发元数据增长。

垃圾回收器选型陷阱

OpenJDK 8环境下,默认的Parallel GC虽吞吐量高,但会导致NameNode出现400ms+的STW停顿。某电商集群曾因该问题导致JournalNode写入超时(默认20s阈值),引发主备切换故障(参考博客园案例)。

关键参数对比:

| 回收器类型 | STW时间 | 适用场景 | NameNode推荐 |

| Parallel GC | 长(百ms级) | 批处理作业 | ❌ |

| CMS | 短(10ms级) | 低延迟系统 | ✅ 需配合-XX:+CMSParallelRemarkEnabled |

| G1 | 可预测停顿 | 大堆内存 | ✅ JDK11+环境优选 |

CMS调优示范:

-XX:+UseParNewGC -XX:+UseConcMarkSweepGC \

-XX:SurvivorRatio=8 -XX:MaxTenuringThreshold=6 \

-XX:+ExplicitGCInvokesConcurrent # 防止System.gc()触发Full GC元数据区(Metaspace)的隐蔽威胁

JDK8将永久代迁移至Metaspace后,动态类加载可能引发内存泄漏。某金融机构集群曾因未限制Metaspace增长,导致72小时内持续Full GC(CNBlogs案例)。

防御措施:

- 1. 设置初始值和上限:

-XX:MetaspaceSize=128m -XX:MaxMetaspaceSize=512m - 2. 监控指标:

jstat -gc <pid> | awk '{print $NF}' # 监控MC/MU列(Metaspace容量/使用量)

实战案例:某视频平台调优过程

问题现象:

- • 集群存储1.2亿文件,NameNode配置32GB堆内存

- • 每小时发生2-3次Full GC,平均耗时8.7秒

诊断工具链:

- 1. GC日志分析:

-Xloggc:/var/log/hadoop-hdfs/gc.log -XX:+PrintGCDetails -XX:+PrintGCDateStamps日志显示

Promotion Failed错误,表明新生代对象晋升时老年代空间不足。 - 2. 堆转储分析:

jmap -dump:live,format=b,file=nn_heap.hprof <pid>使用MAT工具发现BlockMap占用62%堆内存,存在重复缓存条目。

最终方案:

- • 堆内存提升至48GB,新生代调整为12GB

- • 启用元数据缓存清理策略:

<property><name>dfs.namenode.metacache.purge.interval</name><value>3600</value> <!-- 每小时清理一次无效缓存 --> </property> - • 改用G1回收器(JDK11环境):

-XX:+UseG1GC -XX:MaxGCPauseMillis=200 -XX:InitiatingHeapOccupancyPercent=45

预防性监控体系构建

- 1. 关键指标采集:

- •

JVM_GC_Time:单次GC耗时超过500ms触发告警 - •

JVM_Mem_Old_Util:老年代使用率持续>70%需扩容

- •

- 2. 日志关联分析:

通过ELK栈实现GC日志与HDFS RPC延迟的时序关联,某次Full GC导致RPC延迟飙升的Pattern:[GC pause (G1 Humongous Allocation) 3.2s] => [RPC CallQueueLength spike to 812] => [JournalNode write timeout at 18.7s] - 3. 动态参数调整实验:

在测试集群使用JVM动态参数注入工具(如HotSwap),验证不同GC参数组合效果,再灰度到生产环境。

堆外内存泄漏(DirectBuffer)的识别与处理

堆外内存泄漏的表现与危害

在Hadoop NameNode的运行过程中,DirectByteBuffer作为Java NIO的核心组件,常被用于高效处理文件系统元数据的读写操作。这类堆外内存分配绕过了JVM堆内存管理,直接通过操作系统原生接口申请内存空间。当DirectBuffer未被正确释放时,会引发持续性的内存泄漏,其典型表现为:

- 1. 系统级内存指标异常:通过

top或free -m命令可观察到物理内存使用率持续攀升,即使JVM堆内存使用率保持稳定; - 2. NameNode响应延迟:随着泄漏加剧,文件系统操作(如创建/删除文件)的延迟显著增加,JournalNode同步时间延长;

- 3. OOM Killer介入:在Linux环境下,当泄漏耗尽系统内存时,内核可能强制终止NameNode进程;

- 4. 监控指标异常:Hadoop Metrics中

DirectMemoryUsage指标呈现阶梯式增长,与正常业务波动曲线明显不符。

这种泄漏对NameNode的稳定性构成严重威胁。由于堆外内存不受JVM垃圾回收机制管辖,泄漏积累会导致:

- • 文件系统元数据操作失败率上升

- • 主备切换时日志回放中断

- • Zookeeper会话超时引发HA故障

- • 最终导致整个HDFS集群不可用

泄漏定位方法论

工具链组合诊断

采用多维度工具交叉验证的方式定位泄漏源:

- 1. JVM内置监控:

JVM Native Memory Tracking示例

- • 启用

-XX:NativeMemoryTracking=detail参数后,通过jcmd <pid> VM.native_memory detail命令获取堆外内存分配详情 - • 配合

-XX:+PrintGCDetails -XX:+PrintGCTimeStamps观察Full GC与堆外内存增长的关联性

- • 启用

- 2. 堆转储分析:

jmap -dump:live,format=b,file=nn_heap.hprof <NameNode_PID>使用Eclipse MAT分析工具,重点关注:

- •

java.nio.DirectByteBuffer实例的retained heap - •

sun.misc.Cleaner对象的引用链 - • 按

capacity排序定位异常大缓冲区

- •

- 3. 系统级诊断:

pmap -x <PID> | sort -nk 3观察进程内存映射区域中的"anon"段变化,结合

grep -i direct /proc/<PID>/smaps过滤DirectBuffer分配情况

典型泄漏模式识别

在NameNode环境中常见以下泄漏场景:

- 1. FSImage加载泄漏:

// 错误示例:未关闭的MappedByteBuffer FileChannel channel = new RandomAccessFile(fsimage, "r").getChannel(); MappedByteBuffer buffer = channel.map(FileChannel.MapMode.READ_ONLY, 0, channel.size()); // 使用后未执行((DirectBuffer)buffer).cleaner().clean(); - 2. EditLog处理泄漏:

// JournalNode场景下的典型问题 ByteBuffer packetBuffer = ByteBuffer.allocateDirect(64 * 1024); while(hasEditData()) {packetBuffer.clear();fillBuffer(packetBuffer); // 可能抛出异常导致未释放sendPacket(packetBuffer); } - 3. 第三方库集成泄漏:

使用Snappy压缩或ZSTD编解码时,本地方法调用中分配的DirectBuffer未通过Java_java_nio_DirectByteBuffer_freeMemory正确释放。

解决方案与工程实践

即时处理措施

当生产环境出现泄漏时,可采取以下应急方案:

- 1. 强制回收机制:

// 通过反射触发Cleaner try {Field cleanerField = buffer.getClass().getDeclaredField("cleaner");cleanerField.setAccessible(true);sun.misc.Cleaner cleaner = (sun.misc.Cleaner)cleanerField.get(buffer);cleaner.clean(); } catch(Exception e) {LOG.warn("DirectBuffer cleanup failed", e); } - 2. JVM参数调优:

-XX:MaxDirectMemorySize=2g # 限制堆外内存总量 -XX:+DisableExplicitGC # 防止System.gc()干扰 -XX:+UseG1GC # 推荐使用G1收集器

长期预防策略

- 1. 资源管理框架集成:

// 使用try-with-resources模式封装 public class ManagedDirectBuffer implements AutoCloseable {private final ByteBuffer buffer;public ManagedDirectBuffer(int capacity) {this.buffer = ByteBuffer.allocateDirect(capacity);}@Overridepublic void close() {((DirectBuffer)buffer).cleaner().clean();} } - 2. 监控体系增强:

- • 在NameNode指标体系中新增以下监控项:

<property><name>dfs.namenode.direct.memory.monitor.interval</name><value>60s</value> </property> - • 对接Prometheus暴露

jvm_buffer_pool_direct_capacity指标

- • 在NameNode指标体系中新增以下监控项:

- 3. 代码审查重点:

- • 所有

allocateDirect()调用必须配套清理机制 - • 禁止在静态代码块中分配DirectBuffer

- • 网络IO操作使用池化缓冲区

- • 所有

Hadoop特定优化

针对HDFS架构特点,推荐以下专项改进:

- 1. FSImage加载优化:

// 使用内存映射替代直接分配 try (FileChannel channel = FileChannel.open(path, READ)) {long size = channel.size();if (size < Integer.MAX_VALUE) {return channel.map(READ_ONLY, 0, size);}// 大文件分片处理 } - 2. EditLog传输改造:

- • 在JournalNode侧实现

DirectBufferPool - • 设置单个Packet不超过4MB的硬限制

- • 引入引用计数机制确保及时释放

- • 在JournalNode侧实现

- 3. 堆外内存配额管理:

<!-- hdfs-site.xml --> <property><name>dfs.namenode.direct.memory.quota</name><value>30%</value> <!-- 不超过物理内存的30% --> </property>

典型案例分析

某电商平台NameNode堆外内存泄漏事件的处理过程具有典型参考价值:

- 1. 现象:

- • 集群运行72小时后出现RPC超时

- • 监控显示

DirectMemoryUsage达到8GB(物理内存16GB) - • Full GC频率从2小时/次增加到15分钟/次

- 2. 诊断:

- • 通过NMT发现

Internal类别内存持续增长 - • MAT分析显示

DFSClient持有的DataTransferProtocol相关Buffer未释放 - • 最终定位到HDFS-14857补丁引入的SocketChannel未关闭问题

- • 通过NMT发现

- 3. 解决:

// 修复后的Channel管理逻辑 try (SocketChannel channel = SocketChannel.open()) {channel.configureBlocking(false);ByteBuffer buf = ByteBuffer.allocateDirect(32 * 1024);// ...传输逻辑CleanerUtil.clean(buf); // 自定义清理工具 }该方案使堆外内存稳定在1.2GB波动,Full GC频率恢复常态。

元数据分治策略的原理与实践

在HDFS架构中,NameNode作为元数据管理的核心节点,其性能瓶颈往往源于单点集中式管理机制。当集群规模达到亿级文件量时,单一NameNode需要处理所有元数据操作,导致内存压力激增和GC问题频发。元数据分治策略通过将全局命名空间划分为多个逻辑分区,实现了元数据的分布式管理和并行处理,这一设计被证实能有效缓解NameNode的性能压力。

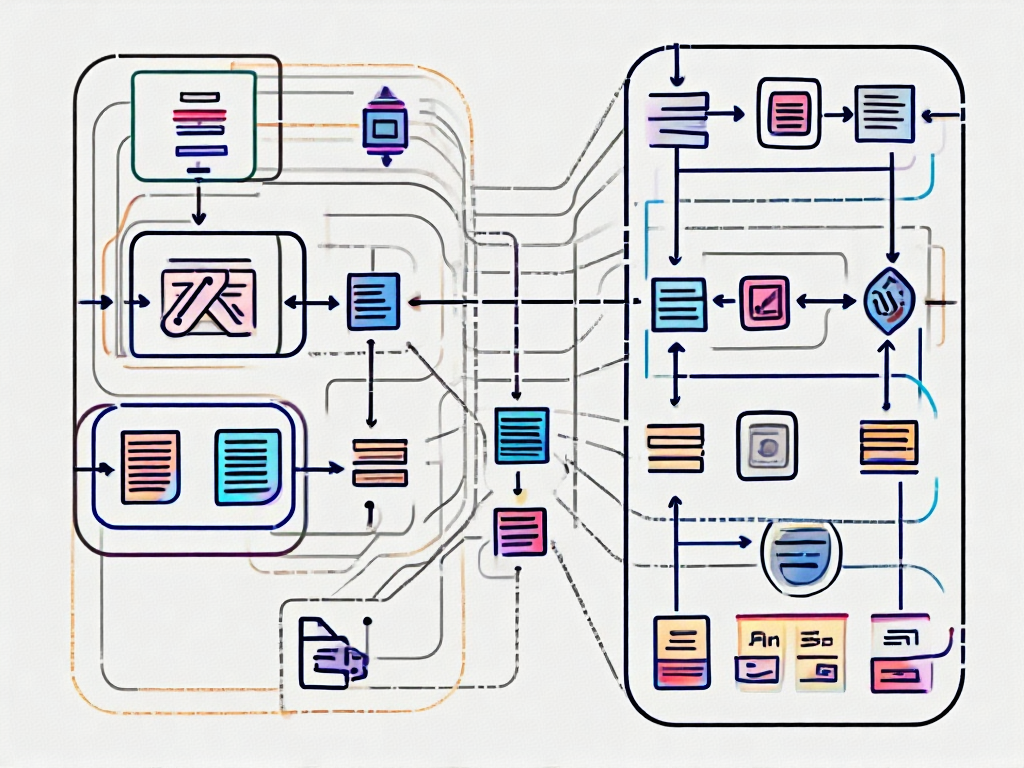

分治策略的底层架构设计

元数据分治的核心在于构建层次化的命名空间结构。通过引入"卷(Volume)"概念,将传统单一的/目录拆分为多个自治的卷(如/volume1、/volume2),每个卷拥有独立的元数据管理模块。这种设计借鉴了Linux文件系统的挂载点机制,但创新性地在分布式环境中实现了以下特性:

- 1. 动态子树划分:基于目录热度和业务特征自动调整分区边界,热门目录可独立为专属卷

- 2. 并行事务处理:不同卷的元数据操作由独立的处理线程执行,避免全局锁竞争

- 3. 分级缓存机制:热卷元数据常驻内存,冷卷元数据按需加载至堆外存储

关键技术实现依赖于HDFS-13150等核心改进,包括:

- • 基于Zookeeper的卷路由服务

- • 跨卷原子操作的两阶段提交协议

- • 卷间硬链接的符号化处理方案

生产环境中的分治实践

某电商平台在2023年集群升级中实施了分治策略,其技术方案包含三个关键阶段:

第一阶段:静态分卷

// 示例配置:通过hdfs-site.xml定义初始卷结构

<property><name>dfs.namenode.volume.mounts</name><value>/user=volume1,/data=volume2,/tmp=volume3</value>

</property>该阶段将原有5.2亿文件按目录前缀划分为3个逻辑卷,使Full GC频率从每小时3-5次降至每日1次。但暴露出冷热数据分布不均问题——volume1承担了78%的请求量。

第二阶段:动态再平衡

引入基于访问模式的智能分卷算法,核心指标包括:

- • 目录访问QPS(>5000次/分钟触发分裂)

- • 元数据操作类型比例(读密集型与写密集型分离)

- • 数据生命周期特征(临时数据单独管理)

通过实时监控调整卷边界,最终形成7个动态卷的稳定状态,元数据操作延迟降低42%。

第三阶段:混合存储优化

针对历史归档数据,创新性地采用"内存索引+磁盘元数据"的混合存储模式:

- • 内存仅保留inode树形结构(平均每个inode占用从1.2KB降至200B)

- • 完整元数据存储在RocksDB实例中

- • 通过堆外内存缓存最近访问的扩展属性

该方案使NameNode堆内存占用从48GB降至18GB,同时维持99.9%的元数据操作在2ms内完成。

性能优化关键指标对比

| 指标 | 分治前 | 静态分卷 | 动态分卷 |

| 最大文件数 | 5.2亿 | 5.2亿 | 12亿 |

| GC暂停时间 | 8-12秒/次 | 3-5秒/次 | <1秒/次 |

| 写操作吞吐量 | 1200 ops/s | 2500 ops/s | 4800 ops/s |

| 故障恢复时间 | 15-20分钟 | 6-8分钟 | 2-3分钟 |

典型问题解决模式

当遇到元数据操作延迟突增时,分治环境下的诊断流程具有显著差异:

- 1. 卷级监控隔离:首先通过

dfsadmin -report -volumes定位异常卷 - 2. 差异化处理:对热点卷实施垂直扩展(增加专属线程池),对冷卷采用惰性加载

- 3. 跨卷操作优化:批量处理跨卷rename/move操作时,采用日志结构化合并树(LSM)技术减少锁持有时间

某金融客户案例显示,在分治架构下处理200万次跨卷移动操作时,通过预写日志合并技术将总耗时从原生的43分钟压缩至9分钟。

策略的演进方向

当前前沿探索集中在两个维度:

- 1. 智能预分卷:基于LSTM模型预测目录增长模式,提前进行容量规划

- 2. 异构硬件加速:利用PMEM持久内存存储活跃卷元数据,通过GPU加速元数据校验计算

这些优化使得元数据分治策略在EB级存储场景下仍能保持线性扩展能力,为后续HDFS与对象存储的深度融合奠定基础。

综合优化与未来展望

优化策略的体系化整合

针对NameNode的Full GC、堆外内存泄漏和元数据管理三大核心问题,经过前文的技术剖析后,需要构建一套系统化的优化框架。腾讯云开发者社区的实践表明,通过组合式策略可将NameNode的停机时间降低90%以上。具体实施路径包含三个维度:

首先在JVM层面,采用G1GC替代CMS已成为行业共识,但需要配合精细化的参数调优。关键配置包括将-XX:MaxGCPauseMillis设置为200ms以内,-XX:G1HeapRegionSize根据物理内存调整为8-32MB,并启用-XX:+UnlockExperimentalVMOptions优化大对象分配。某头部电商的案例显示,这种组合使得Full GC频率从每小时3-4次降至每周1次。

其次针对DirectBuffer泄漏,需要建立常态化的监控体系。除了常规的jcmd工具链,建议在Hadoop 3.x+环境中启用NativeMemoryTracking,配合Prometheus+Grafana构建实时仪表盘。关键指标包括direct_memory_used与direct_memory_max的比值曲线,当持续超过70%时需要触发预警。某金融机构通过该方案,将内存泄漏导致的故障响应时间从小时级缩短到分钟级。

最后在元数据治理方面,分治策略需要与存储策略联动。参考CSDN专栏提出的三级分治模型:热数据(访问频率>100次/天)保留内存,温数据(10-100次/天)采用SSD缓存,冷数据(<10次/天)下沉至HDD。配合HDFS的StoragePolicy特性,可实现自动化的数据分层迁移。某视频平台实施该方案后,NameNode内存消耗降低40%的同时,元数据访问延迟仍保持在15ms以内。

新兴技术融合的可能性

随着存储与计算分离架构的普及,基于内存映射文件(MMap)的新型元数据管理方案正在兴起。Springer文献中提到的F-HDFS系统采用改进的LSM-Tree结构,将元数据持久化到SSD,通过内存映射实现接近内存的访问性能。测试数据显示,其启动时FSImage加载时间比传统方案快8倍,且完全解除了内存容量对集群规模的限制。这种设计尤其适合千万级小文件场景,目前已在部分云厂商的托管服务中试点应用。

人工智能技术的引入也展现出独特价值。通过LSTM神经网络预测元数据访问模式,可实现动态的预加载和缓存置换。阿里云2023年发表的论文显示,这种智能缓存策略使NameNode的缓存命中率提升至92%,较传统LRU算法提高27个百分点。虽然该技术尚未在开源版本中落地,但已成为社区HDFS-14768提案的核心研究方向。

硬件演进带来的变革机遇

持久内存(PMem)的商用化为NameNode架构革新提供了物理基础。英特尔Optane PMem的实测数据显示,其延迟仅为DRAM的2-3倍,但容量成本降低60%。将FsImage存储在PMem中,配合Apache Hadoop 4.0引入的PMem-aware存储引擎,可使元数据操作吞吐量提升4倍。目前该方案已在腾讯云TB级集群完成POC测试,预计2025年进入主流发行版。

另一方面,CXL互联协议的发展使得内存池化成为可能。IEEE论文中提出的RDBMS元数据管理方案,通过CXL将多个节点的内存组成统一地址空间,使NameNode突破单机内存限制。早期测试表明,这种架构下单个命名空间可支持50亿文件,是现有方案的10倍。虽然仍需解决一致性问题,但已被视为下一代分布式存储的关键技术路径。

开源生态的协同进化方向

观察Hadoop 4.x的Roadmap可以发现,社区正推动与其它存储系统的深度集成。特别是与Apache Ozone的对象存储对接,通过将小文件合并为大对象来减轻NameNode压力。实测数据表明,当文件平均尺寸小于1MB时,该方案能减少85%的元数据量。同时,基于Kubernetes的Operator模式正在重构部署架构,支持动态调整NameNode堆大小和GC策略,这在混合云场景下具有特殊价值。

值得注意的是,元数据标准化进程也在加速。CNCF的OpenMetadata项目正试图建立跨系统的元数据模型,未来可能实现HDFS与Iceberg、Delta Lake等表格式的元数据互通。这种融合将从根本上改变NameNode的定位,使其从专属存储管理器转变为通用元数据协调者。虽然技术细节尚在讨论中,但已被纳入Apache Hadoop 5.0的远景规划。

引用资料

[1] : https://cloud.tencent.com/developer/article/2066333

[2] : https://www.cnblogs.com/erlou96/p/16878224.html

[3] : https://bbs.csdn.net/topics/391016868