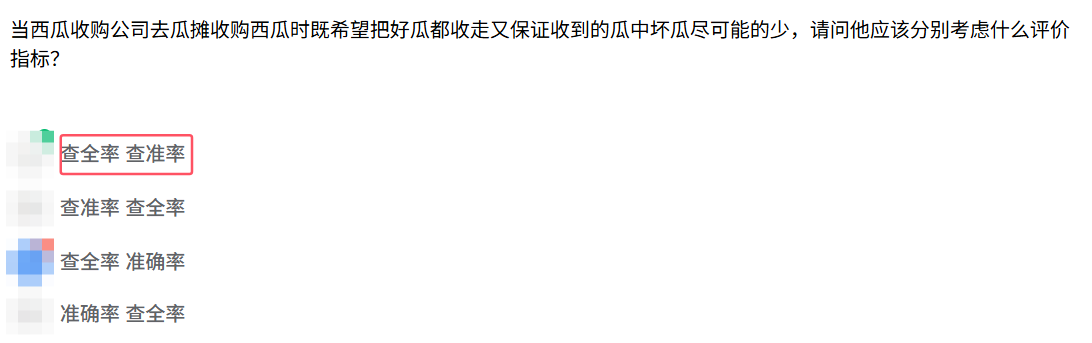

机器学习中Precision(查准率)和Recall(查全率)

TP(True Positive):真正例(实际为正且预测为正)

FP(False Positive):假正例(实际为负但预测为正)

FN(False Negative):假负例(实际为正但预测为负)

查准率

预测为正类的样本中,真实为正类的比例(衡量预测的准确性)。

若模型预测100个样本为正类,其中80个真实为正类(TP),20个为负类(FP),则:

查全率

真实为正类的样本中,被正确预测为正类的比例(衡量覆盖的全面性)。

若真实有100个正类样本,模型正确预测了75个,漏检25个,则:

两者之间的矛盾

提高查准率可能降低查全率,反之亦然。

举例:

在二分类模型中(如逻辑回归、SVM),调整分类阈值(Threshold)可以改变预测结果:

提高阈值(如从0.5→0.8):

Precision↑:只有置信度极高的样本被预测为正类,FP减少。

Recall↓:许多真实正类样本因阈值过高被漏掉(FN增加)。

例子:疾病诊断中,仅对高度疑似病例确诊(减少误诊,但可能漏诊轻症患者)。

降低阈值(如从0.5→0.3):

Recall↑:更多真实正类样本被覆盖,FN减少。

Precision↓:许多负类样本被误判为正类(FP增加)。

例子:垃圾邮件过滤中,放宽规则以捕获更多垃圾邮件(但可能误判正常邮件)。

调和指标(F1 Score):综合两者平衡,公式为:

当两者均为1时,F1=1(理想情况)。

一些场景

更看重Precision的任务:

减少误报(False Positive, FP),即确保预测为正类的样本尽可能准确。

垃圾邮件分类:宁可漏判(Recall低),也不能将正常邮件误判为垃圾邮件(FP代价高)垃圾邮件是正类,非垃圾邮件是负类

金融风控:误将正常交易标记为欺诈(FP)可能导致客户投诉或流失 非正常交易是正类,正常交易是负类

推荐系统:推荐内容必须精准(Precision高),否则用户会失去信任。

更看重Recall的任务 减少漏报(False Negative, FN),即尽可能覆盖所有真实正类样本。

疾病筛查:宁可误诊(FP高),也不能漏诊患者(FN代价高,如癌症早期检测)。

安全监控:漏掉真实威胁(FN)比误报警(FP)更危险。

搜索引擎:需尽量返回所有相关结果(Recall高),即使包含部分不相关结果。

需平衡Precision和Recall的任务

在误报和漏报之间找到平衡。

人脸识别:既要减少误识别(FP),也要避免漏识别(FN)。

广告点击预测:需平衡精准投放(Precision)和覆盖潜在用户(Recall)。