模型上下文协议(MCP)的工作流程、安全威胁与未来发展方向

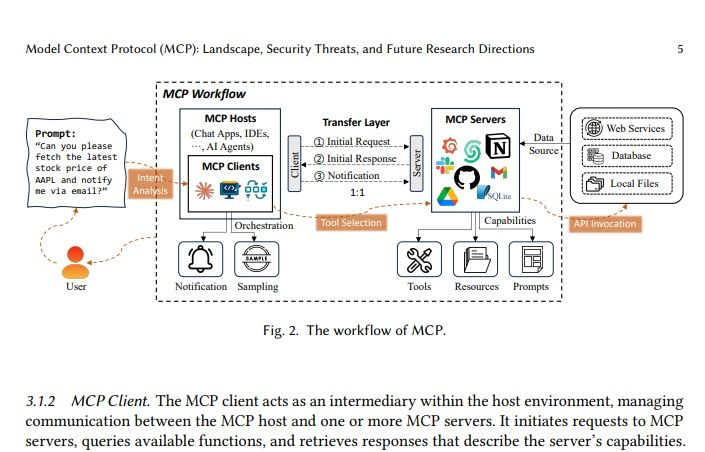

在人工智能日益渗透我们生活的今天,如何高效、安全地管理和利用AI模型的上下文信息变得至关重要。模型上下文协议(Model Context Protocol, MCP) 正是一种旨在解决这些挑战的框架。上图清晰地展示了MCP的工作流程,为我们理解其运作机制提供了直观的视角。

MCP 工作流程详解

MCP 的工作流程可以被概括为客户端与服务器之间的协同互动,其核心在于理解用户意图并协调多种资源以满足需求。

-

用户请求与意图分析

一切始于用户的请求。如图所示,一个用户提出了一个具体的提示:“Can you please fetch the latest stock price of AAPL and notify me via email?”(请问你能获取苹果公司最新的股票价格并通过邮件通知我吗?)。这个提示首先会经过 “意图分析” 模块。这是 MCP 流程的关键第一步,旨在准确理解用户的真实需求,识别出其中的关键信息,例如“获取股票价格”和“邮件通知”。 -

MCP 客户端

意图分析的结果随后传递给 MCP 客户端。MCP 客户端是整个协议的“中间人”,它部署在宿主环境(MCP Hosts)中,这些宿主可以是各种应用程序,如聊天应用、集成开发环境(IDEs)或 AI 代理。客户端的主要职责包括:- 管理与 MCP 宿主和 MCP 服务器之间的通信。

- 发起对 MCP 服务器的请求。

- 查询可用的功能。

- 检索描述服务器能力的响应。

- 协调“通知”和“采样”等辅助功能,确保用户及时获得反馈或系统进行有效的数据收集。

-

传输层

MCP 客户端与 MCP 服务器之间通过 “传输层” 进行通信,该层确保请求和响应的可靠传输。这个过程是一个一对一的交互,包括:- 初始请求(Initial Request):客户端将处理后的请求发送给服务器。

- 初始响应(Initial Response):服务器根据请求返回初步响应,可能包含其能力列表。

- 通知(Notification):在整个流程中,系统会根据需要向用户发送通知,例如操作进展或结果。

-

MCP 服务器与能力匹配

MCP 服务器 是协议的核心处理单元,它拥有并管理着丰富的 “能力(Capabilities)”,这些能力可以分为:- 工具(Tools):例如,用于执行特定任务的脚本或程序(如获取股票数据的工具)。

- 资源(Resources):例如,模型、算法、或数据处理管道。

- 提示(Prompts):用于引导 AI 模型行为的预设指令或模板。

服务器根据客户端的请求,在传输层完成初始交互后,会进行 “工具选择(Tool Selection)”,从其能力库中识别并选择最适合满足用户意图的工具和资源。

-

数据源与 API 调用

MCP 服务器为了完成任务,需要访问各种 “数据源(Data Source)”,包括:- Web 服务(Web Services):通过网络 API 获取信息,例如股票行情 API。

- 数据库(Database):访问结构化数据。

- 本地文件(Local Files):读取本地存储的数据。

一旦选定了合适的工具和数据源,MCP 服务器会进行 “API 调用(API Invocation)”,触发相应的操作以获取所需数据或执行特定任务(例如,调用一个 API 来查询 AAPL 的股票价格)。

总结与展望

整个 MCP 工作流程形成了一个闭环,从用户发出请求开始,经过客户端的意图分析和协调,通过传输层与服务器通信,服务器利用其丰富的工具和数据源完成任务,最终将结果通过通知机制反馈给用户。这种模块化、可扩展的设计,使得 MCP 能够有效地管理复杂的 AI 应用上下文,为用户提供更智能、更个性化的服务。

虽然上图主要展示了工作流程,但一个健壮的协议如 MCP,必然会面临安全威胁,如数据泄露、未授权访问等,这些都将是未来研究的重要方向。同时,如何进一步优化意图识别、提高工具选择的准确性、增强多模态数据的处理能力,也将是 MCP 持续演进的关键。