vllm本地部署qwen3-4b

vllm部署qwen3-4b

文章目录

- vllm部署qwen3-4b

- 一、环境

- 1.1 虚拟环境创建

- 二、下载

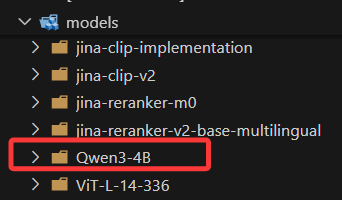

- 2.1 下载模型到本地路径models/Qwen3-4B

- 2.2 测试大模型是否下载成功

- 三、启动 vLLM 的 OpenAI 兼容服务

一、环境

系统环境及GPU:ubuntu24.04+GPU 型号是 NVIDIA GeForce RTX 3090+cuda12.8

1.1 虚拟环境创建

conda create -n vllm python=3.10

激活虚拟环境并下载vllm

conda activate vllm

pip install vllm

二、下载

2.1 下载模型到本地路径models/Qwen3-4B

#huggingface网站的国内镜像网址

import os

os.environ['HF_ENDPOINT'] = 'https://hf-mirror.com'from huggingface_hub import snapshot_download

snapshot_download(repo_id="Qwen/Qwen3-4B",cache_dir="./cache", local_dir="models/Qwen3-4B")

print("======download successful=====")