MiniCPM-Llama3-V-2_5-int4

MiniCPM-Llama3-V-2_5-int4大模型部署使用环境:

python3.8+cuda11.8其它要求,按照安装文档要求下载即可

我是在算力平台用4090跑的, GPU 显存(8GB)可以部署推理 int4 量化版本,如果推理非量化版本需要更高显存

MiniCPM-V 仓库文件下载

openbmb/MiniCPM-Llama3-V-2_5-int4 模型文件下载

MiniCPM-Llama3-V-2_5 非量化模型文件地址

AutoDL算力平台

cpolar官方地址

MiniCPM-V-2.5 部署应用等

在算力平台AutoDL遇到的报错:

root@autodl-container-cffc47b4c5-4a5f97c0:~/tf-logs# conda activate minicpmv2 CommandNotFoundError: Your shell has not been properly configured to use 'conda activate'. To initialize your shell, run

需要运行:

conda init bash

显示文件大小

ls -lh example.zipdf -h /root/autodl-tmptar -xvf 解压rar文件

# 更新包列表

sudo apt-get update# 安装 unrar

sudo apt-get install unrar# 解压 MiniCPM-Llama3-V-2_5-int4.rar

unrar x MiniCPM-Llama3-V-2_5-int4.rar# 查看解压后的文件

ls -lunrar x xxx.rarunrar x查看磁盘空间大小

df -h /dev/sda1安装

- 克隆我们的仓库并跳转到相应目录

git clone https://github.com/OpenBMB/MiniCPM-V.git

cd MiniCPM-V2. 创建 conda 环境

conda create -n minicpmv2.5 python=3.8 -yconda activate minicpmv2.53. 安装依赖

pip install -r requirements.txt -i https://pypi.mirrors.ustc.edu.cn/simple pip install gradio==3.40.0 -i https://pypi.mirrors.ustc.edu.cn/simple下载模型文件

git clone https://www.modelscope.cn/OpenBMB/MiniCPM-Llama3-V-2_5-int4.git参考以下代码进行推理

from chat import OmniLMMChat, img2base64

torch.manual_seed(0)chat_model = OmniLMMChat('openbmb/MiniCPM-Llama3-V-2_5')im_64 = img2base64('./assets/airplane.jpeg')# First round chat

msgs = [{"role": "user", "content": "Tell me the model of this aircraft."}]inputs = {"image": im_64, "question": json.dumps(msgs)}

answer = chat_model.chat(inputs)

print(answer)# Second round chat

# pass history context of multi-turn conversation

msgs.append({"role": "assistant", "content": answer})

msgs.append({"role": "user", "content": "Introduce something about Airbus A380."})inputs = {"image": im_64, "question": json.dumps(msgs)}

answer = chat_model.chat(inputs)

print(answer)python web_demo_2.5.py以下是做内网穿透需要安装的(如只是部署自己电脑或使用其它方式进入公网则不需要如下)

2.1 安装cpolar

在Ubuntu上打开终端,执行命令

首先,我们需要安装curl:

sudo apt-get install curl | sudo bash

- 国内安装(支持一键自动安装脚本)

curl -L https://www.cpolar.com/static/downloads/install-release-cpolar.sh | sudo bash

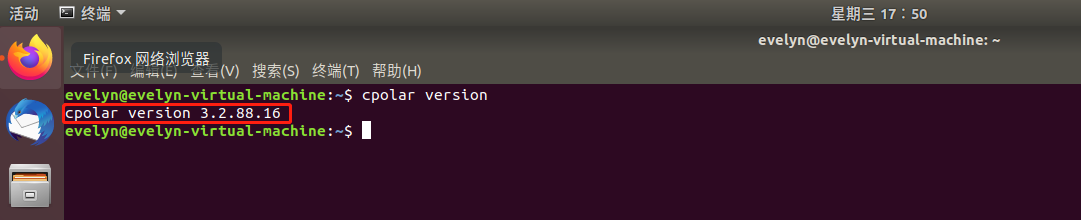

2.2 正常显示版本号即安装成功

cpolar version

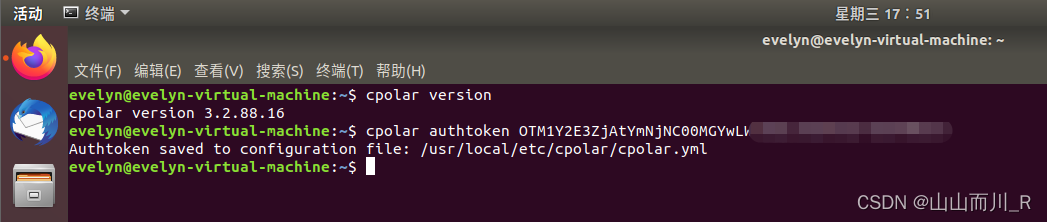

2.3 token认证

登录cpolar官网后台,点击左侧的验证,查看自己的认证token,之后将token贴在命令行里

cpolar authtoken xxxxxxx

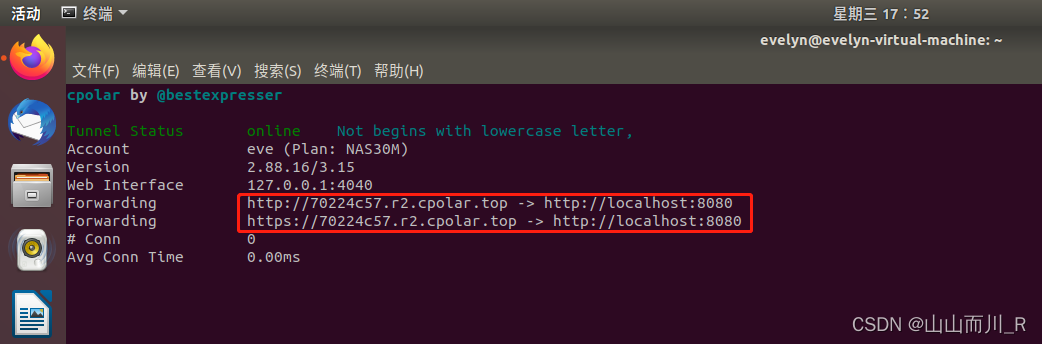

2.4 简单穿透测试一下

cpolar http 8080

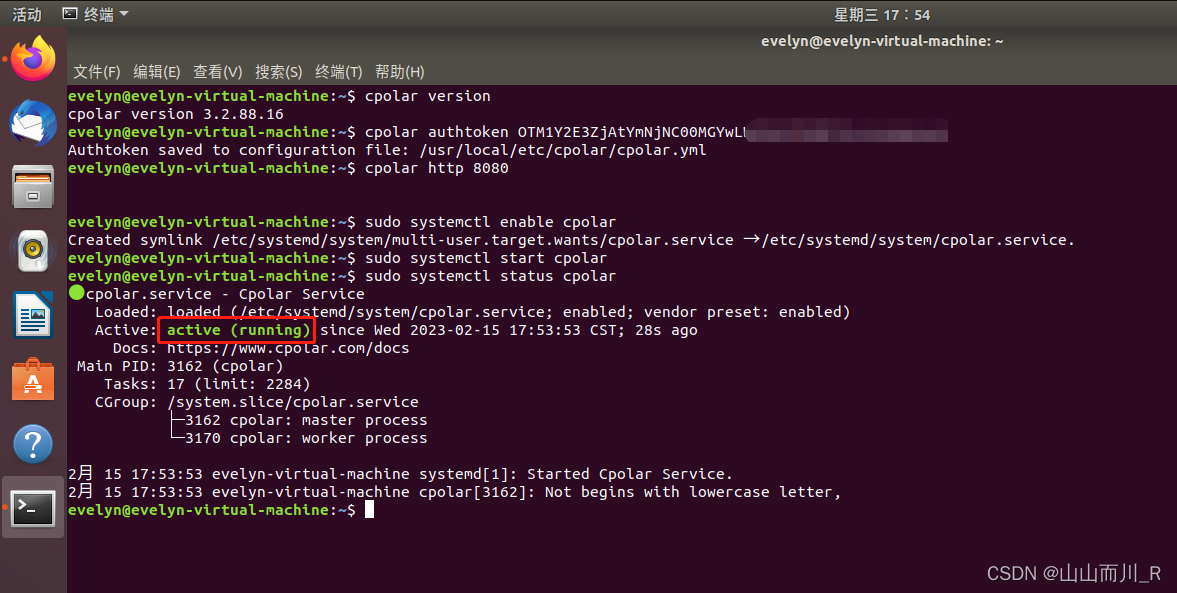

2.5 将cpolar配置为后台服务并开机自启动

sudo systemctl enable cpolar

2.6 启动服务

sudo systemctl start cpolar

2.7 查看服务状态

sudo systemctl status cpolar

正常显示为active,为正常在线状态