AutoModelForCausalLM.from_pretrained 函数调用本地权重报错

文章目录

- 1、代码报错的位置(前情提要)

- finetune_lora.sh

- fintune_clm_lora.py

- 2、报错截图

- 2.1、huggingfaces上的 meta-llama/Llama-2-7b-chat-hf

- 2.2、服务器上模型文件路径

- 3、特别注意事项

1、代码报错的位置(前情提要)

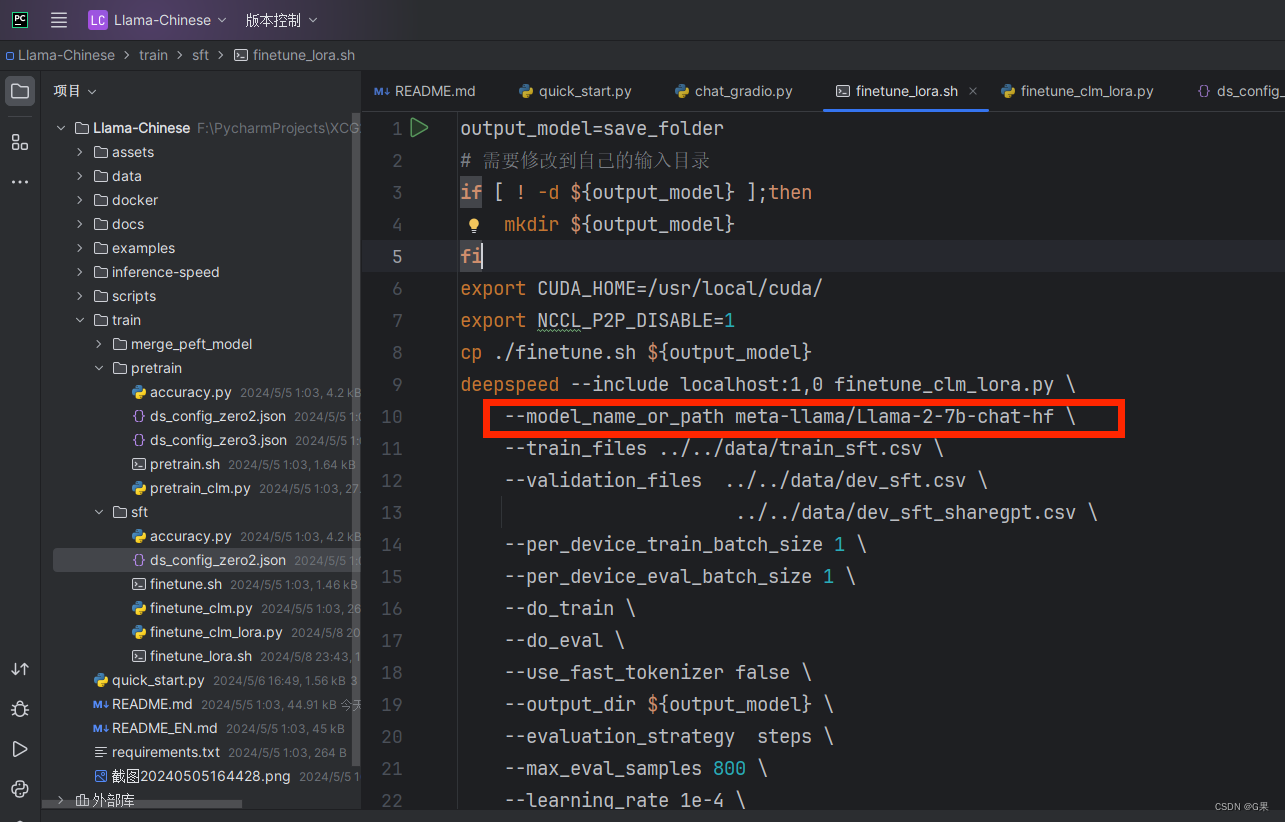

在终端直接运行finetune_lora.sh文件,–model_name_or_path该参数是指定加载的模型权重,可以是huggingface上的model_name,也可以使本地保存模型权重的路径。

使用默认的模型参数配置是(meta-llama/Llama-2-7b-chat-hf),该情况下模型权重会直接去huggingface官网上去下载。

finetune_lora.sh

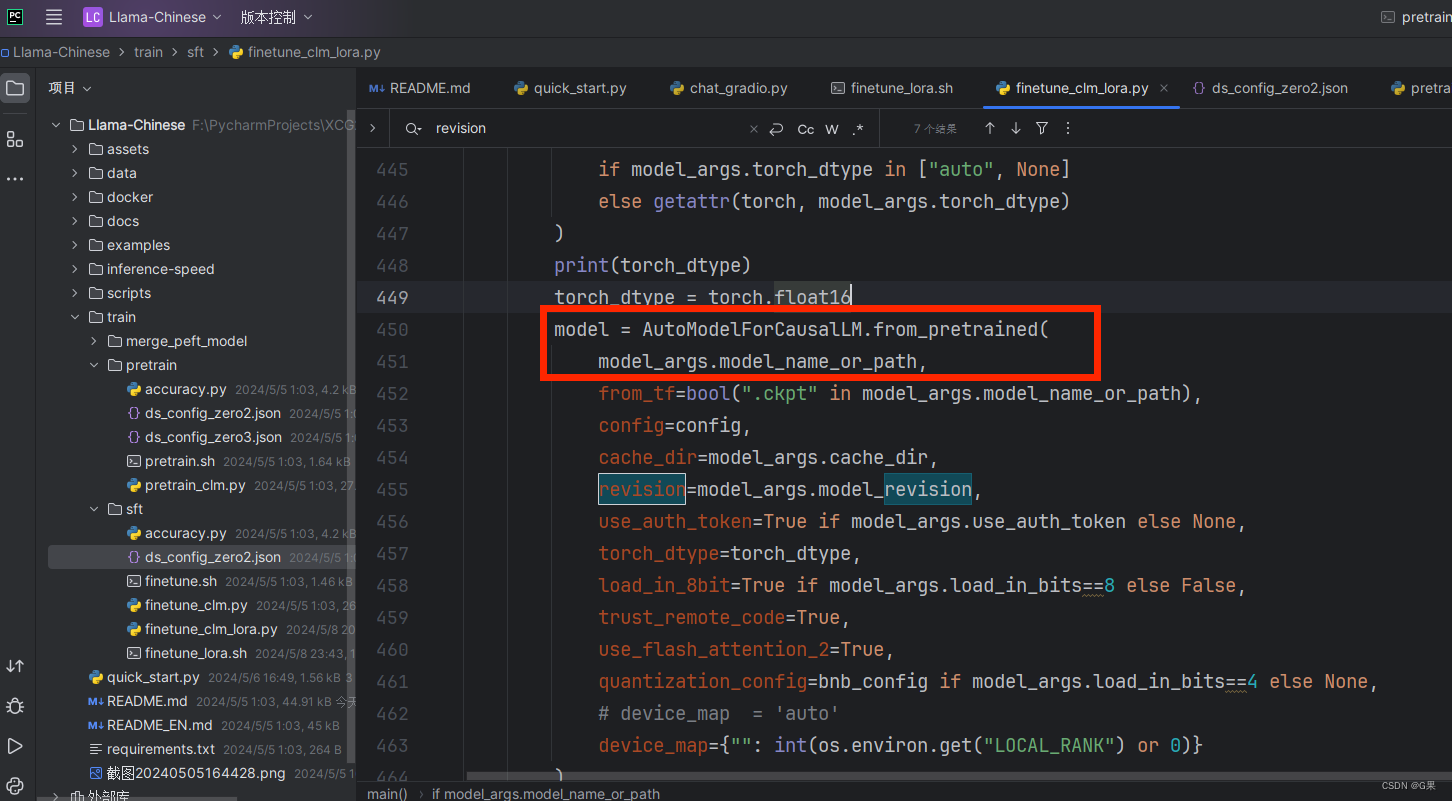

fintune_clm_lora.py

–model_name_or_path 参数会在这里作为 AutoModelForCausalLM.from_pretrained 函数的参数

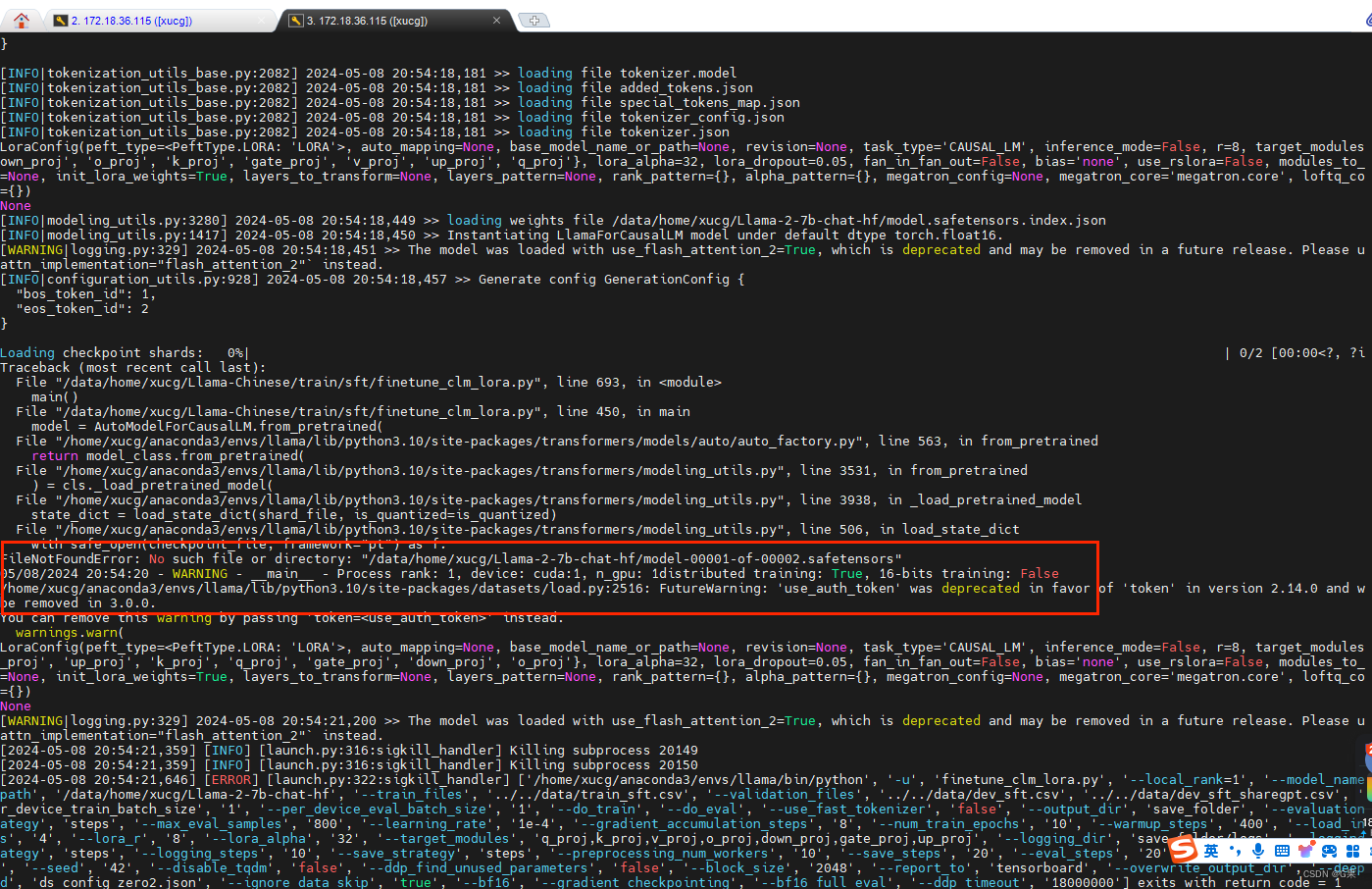

2、报错截图

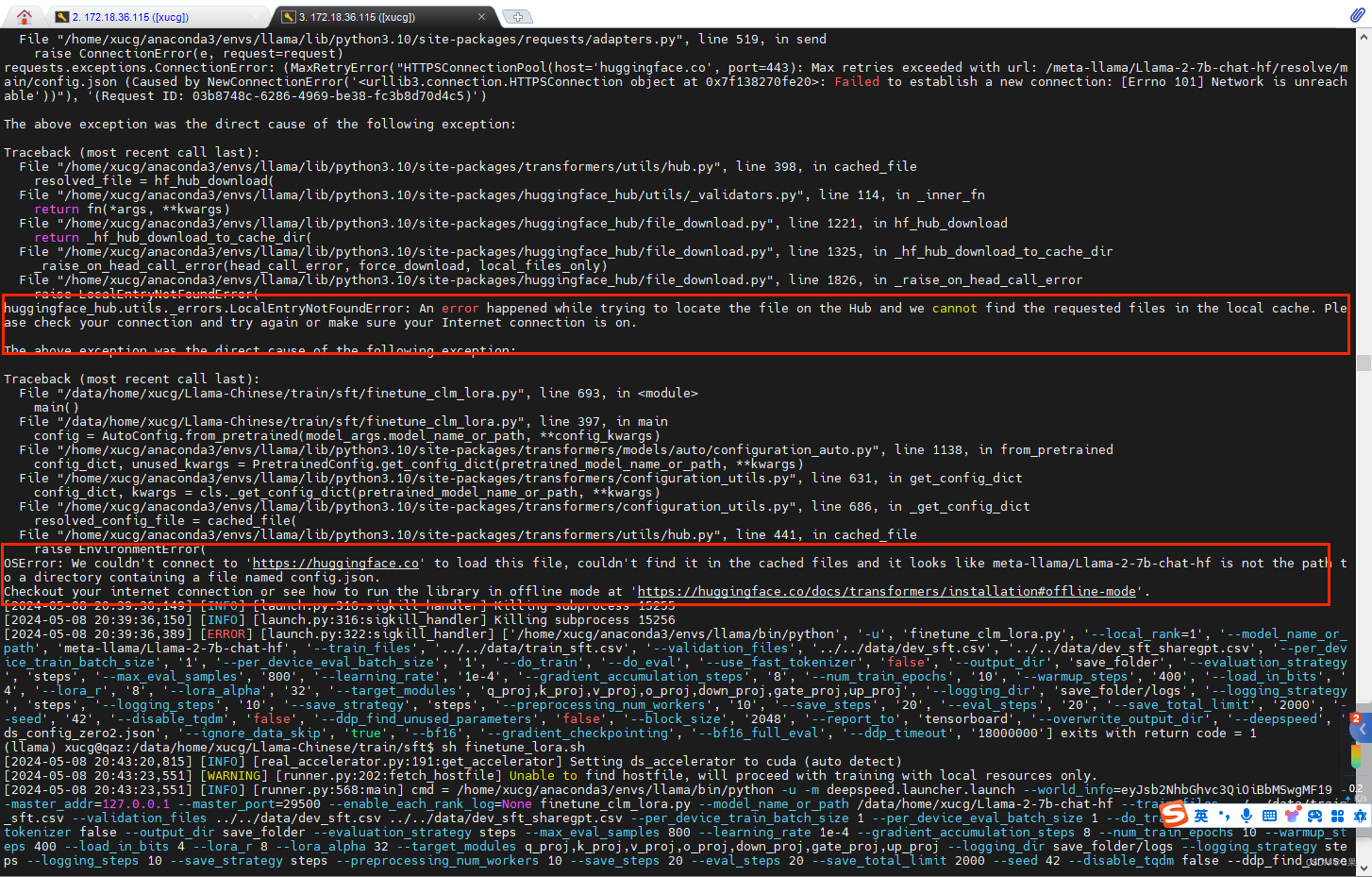

服务器无法直接访问huggingface网站,因此只能采用指定本地模型路径的方法。(需要先申请并下载模型权重)

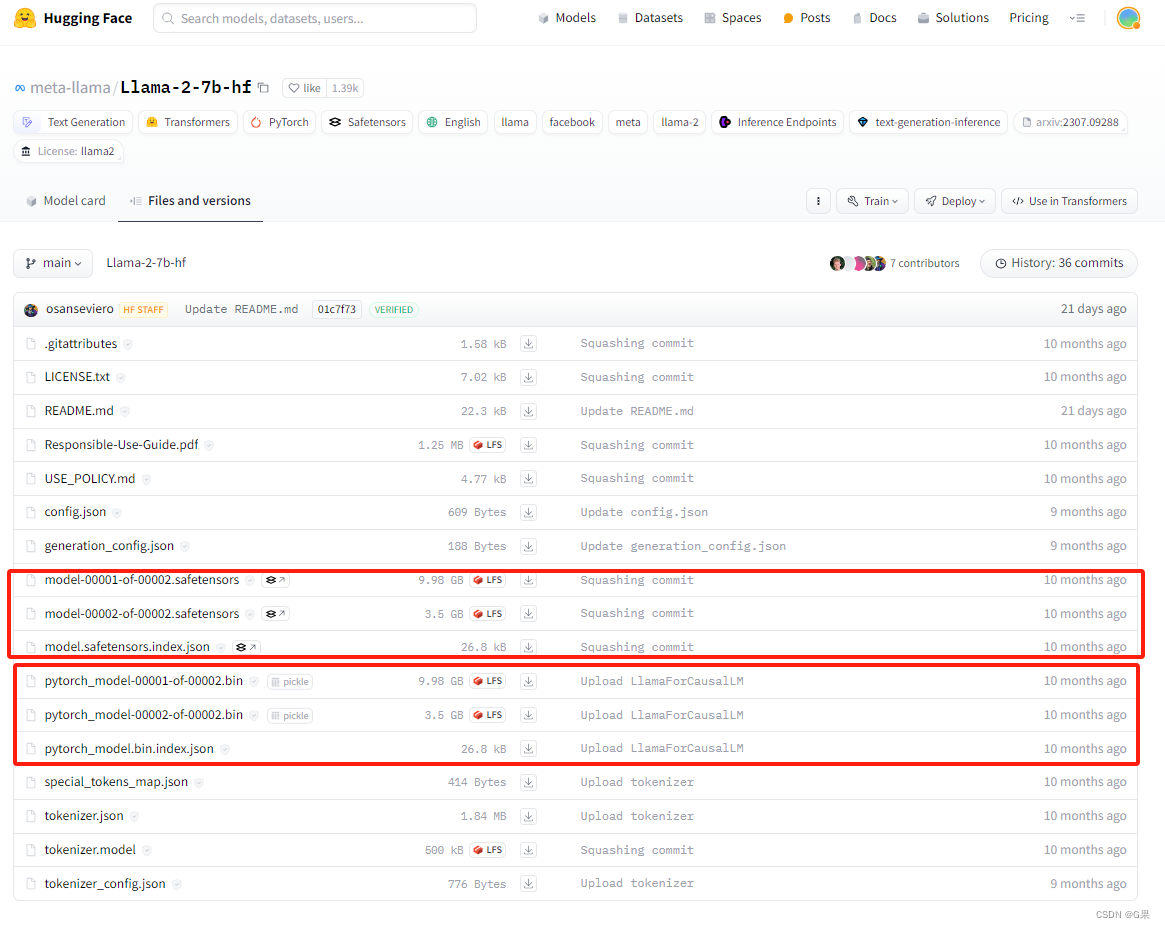

2.1、huggingfaces上的 meta-llama/Llama-2-7b-chat-hf

这个是需要去meta website申请之后,再在huggingface的meta_llama项目下再提交一次信息才可以查看和下载这些信息

权重文件有【.safetensor】 【.bin】两种,默认是加载.safetensor权重文件

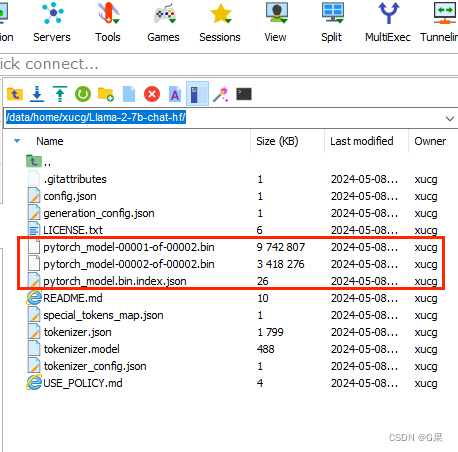

2.2、服务器上模型文件路径

两种权重其实都可以使用,大小都一致,要想只使用.bin权重文件,需要删除.safetensor文件和对应的.safetensor.index.json文件才可以。

3、特别注意事项

若只想使用.bin权重文件,但是.bin.index.json文件有残留,运行就会报错找不到.safetensor权重文件。

可以侧面看出AutoModelForCausalLM.from_pretrained 函数是根据json文件进行读取对应的权重文件(同门李伟发现!)