阅读笔记 | Transformers in Time Series: A Survey

阅读论文:

Wen, Qingsong, et al. “Transformers in time series: A survey.” arXiv preprint arXiv:2202.07125 (2022).

这篇综述主要对基于Transformer的时序建模方法进行介绍。论文首先简单介绍了Transformer的基本原理,包括位置编码、多头注意力机制、前馈全连接网络等模块。接着提出了从网络结构和应用领域两个角度对时序Transformer进行分类。

-

从网络结构角度,总结了在模块级别和架构级别对Transformer进行的改进,以适应时序建模的特点

- 位置编码模块

- 简单位置编码:经典Transformer中用到的,手工设计,能提取位置信息但无法充分利用时序数据的重要特征

- 可学习位置编码:使用别的模型或增加Transformer嵌入层来学习时序的位置编码的向量表示,获得更灵活更expressive的位置编码

- 时间戳编码:在Informer和Autoformer里将年月日时分秒和节假日等作为额外的位置编码信息,通过可学习位置编码方法得到其向量表示

- 注意力模块

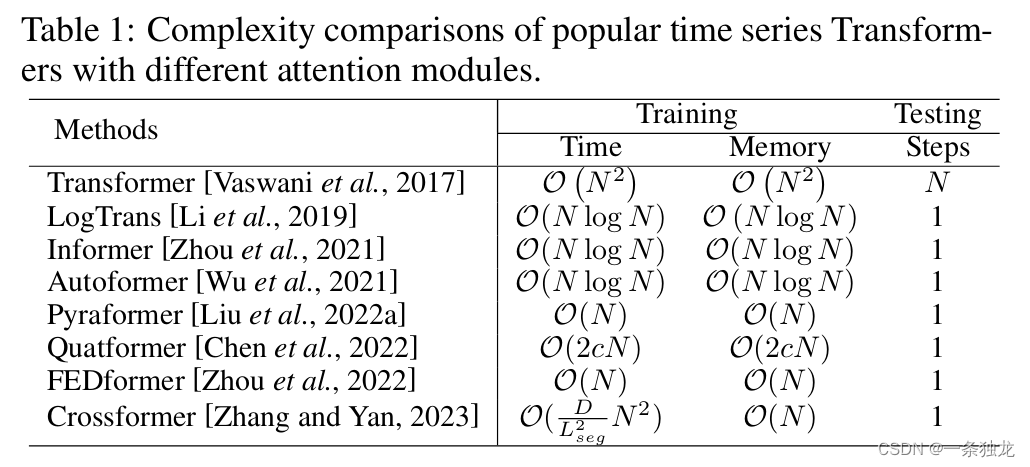

- 引入稀疏偏差到注意力机制来降低普通注意力机制的平方复杂度

- 探索自注意力矩阵的低秩特性来加速计算(例如Informer和FEDformer)

- 分层架构设计

- 基于max-pooling下采样实现分辨率折半(Informer)

- 基于C叉树以不同分辨率序列作为节点,并设计相同分辨率尺度和不同分辨率尺度间的注意力机制以捕获其分辨率尺度间的时间依赖(Pyraformer)

- 位置编码模块

-

从应用角度,概述了Transformer在预测、异常检测和分类任务中的不同变体的应用情况。

-

预测

-

时序预测

-

模块级的变体

-

设计新的注意力模块(占大部分研究)

- LogTrans:提出卷积自注意力,使用因果卷积来生成自注意力层的queries和keys,并引入稀疏bias和Logsparse mask到自注意力层

- Informer:根据queries和keys相似度选择主要的queries,还设计了生成式的decoder来避免在长期预测时做单步自回归预测的累积误差

- AST:使用生成对抗编码器-解码器框架训练稀疏Transformer模型做时序预测,也可以避免累积误差

- Pyraformer:设计了一个分层金字塔状注意力模块,基于上述的C叉树捕获不同分辨率时序的时间依赖

- Quatformer:基于四元数提出learning-to-rotate注意力,引入了可学习的周期和相位信息使得模型可以学习到复杂的时序周期模式

- FEDformer:通过傅里叶变换和小波变换在频域实现注意力操作以降低计算与存储复杂度

-

增强可解释性

- TFT:设计了一个针对多种输入数据优化的multi-horizon预测模型,通过合并全局、时序依赖和事件来实现可解释性

- ProTran:Transformer和状态空间模型(SSM)结合,实现基于变分推理的生成建模和推理

- SSDNet:Transformer和SSM结合,用Transformer学习时间模式并估计SSM参数,再用SSM对时序数据进行季节性趋势分解以实现可解释性

-

探索新的时序数据标准化方法

- 目前只有Non-stationary Transformer:探索了时序预测任务中的过度平稳化问题,并实现了用于序列平稳化和去平稳化的插件模块

-

利用token输入的偏差

- Autoformer:基于分段表示机制,设计了季节性趋势分解架构。

- PatchTST:利用通道无关实现多通道序列embedding共享,子序列patch设计分割时序数据为子序列patch作为Transformer输入

- Crossformer:利用了跨维度依赖进行多元时序预测,通过维度分段embedding将输入嵌入到二维向量以保留时间和维度信息,并用两阶段注意力层来捕获这种跨维度依赖。

-

-

架构级的变体

- Triformer:三角树形结构,轻量且线性复杂度

- Scaleformer:提出多时间尺度架构,并可通过在多尺度上共享参数地迭代细化预测时间序列来提高性能

-

-

时空预测

- Traffic Transformer:加上图神经网络模块捕获空间依赖性

- Spatial-temporal Transformer:在前者基础上加上了空间的Transformer block和图卷积神经网络来更好捕获空间依赖性

- Spatio-temporal graph Transformer:设计了基于注意力的图卷积机制来学习复杂时空注意力模式

- Earthformer:提出立方体注意力机制,将数据分解为立方体并应用该机制

-

事件预测(不规则且时间间距不等的事件序列)

- 在传统时间点过程(TPP)方法上结合Transformer,通过嵌入所有可能时间和时间来扩展该方案

-

-

异常检测(可用于电力数据的跳变异常点检测)

- TranAD提出使用对抗训练来放大重建误差,增强Transformer的异常检测能力。

- MT-RVAE 设计了多尺度Transformer,同时整合全局和局部时序信息。

- TransAnomaly将Transformer与VAE结合,实现训练成本的大幅降低。

- GTA 借鉴图神经网络思想,模拟变量之间的影响传播机制。

- AnomalyTrans通过建模先验关联和序列关联的方式增强异常点的区分度。

-

分类任务

- GTN使用双塔结构分别建模时间步和通道注意力,通过可学习加权融合特征,在多元时间序列分类任务上取得SOTA

- [Rußwurm and Körner, 2020] 应用基于自注意力的Transformer获得了卫星图像时间序列分类的SOTA

- TARNet设计了学习任务相关数据重构的Transformer,利用mask和重构时间步的注意力机制提升了分类性能

- [Yuan and Lin, 2020] 在卫星图像时间序列分类中应用了自监督预训练的Transformer来缓解数据不足

- [Zerveas et al., 2021] 提出了无监督预训练框架,使用比例mask数据进行模型预训练后微调

- [Yang et al., 2021] 使用预训练语音模型进行时间序列分类任务迁移学习,在多个数据集上获

-

该论文还通过实验分析了 Transformer在时序建模中的鲁棒性、模型大小和季节性分解等多个方面。作者在ETTm2数据集上针对不同配置的时序Transformer进行了实验分析,以研究它们在时序建模中的工作方式。

鲁棒性分析表明,许多仔细设计的Transformers在输入序列加长时,性能快速恶化。这使它们在长期预测中实际效果有限。需要更多工作来充分利用长序列输入。

模型大小分析发现,增加Transformer层数并不一定改善预测效果,3-6层的Transformer通常效果更好。这提出了如何设计更深层Transformer架构的问题。

季节性-趋势分解分析发现,这种分解可以显著提升Transformer在时序预测中的表现,不同模块提升幅度在50-80%。这一发现值得进一步研究设计更高级的分解方案。

最后文章提出了未来可能的研究方向,包括为时序Transformer引入先验偏置、与图神经网络结合、预训练模型、架构级变体设计和神经架构搜索等。

个人思考

- 该调研在时空预测方面的调研启发了对图神经网络的利用,而在电力负荷预测中的某些场景,也许可以对电网结构进行考虑,将电网的拓扑结构、输电距离和输电损耗等等要素加以考虑,并以立方体Transformer等方法将空间信息数据的embedding向量放到Transformer进行处理。

- 在Transformer应用于异常检测的方面,无监督Transformer被广泛研究。但在考虑进一步应用落地到电力行业时,例如用于电负荷突变点等异常点检测时,可能需要考虑到如TFT中对多种数据源的利用,特别是未来可知数据的输入。能否将无监督重建任务范式与TFT中这种输入数据模式进行结合是一个值得思考的问题。