常见激活函数Activation Function的选择

Activation Function激活函数一般会神经网络中隐层和输出层上,其中作用在输出层主要用于适配输出,比如sigmoid函数可用于生成[0,1]之间的概率估计值。而作用于隐层主要用于增加神经网络的非线性,增加了网络的表达能力,本文主要介绍隐层的激活函数的选择。

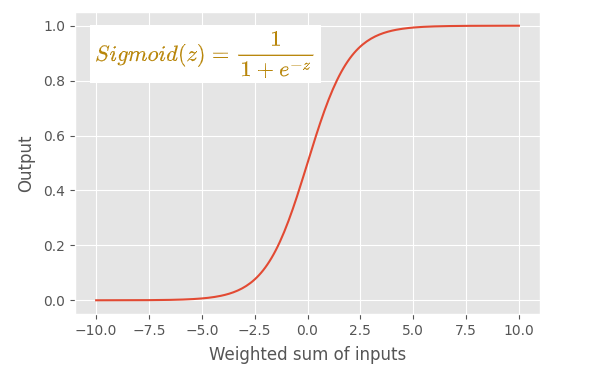

1. Sigmoid激活函数

sigmoid函数会将输入转化到0~1之间的范围,数据分布以0.5为中间,其主要的优点是处处连续可导,当输入值较大或较小时其梯度值极小,因此容易造成梯度消失的问题,特别是随着网络层数增加,各层权重参数叠加会导致问题加剧,虽然可能BatchNorm等方法可以解决这类问题,但在多数情况下,应用sigmoid激活函数并不会带来较大收益,现在更常用Relu函数等取代。

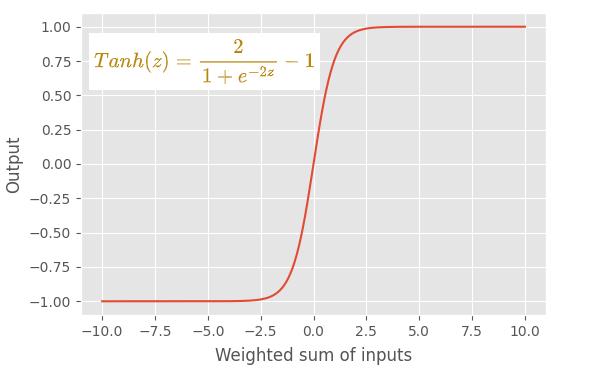

2. Tanh激活函数

tanh函数会将输入转化到-1~1之间的范围,数据分布以0为中间,其也是处处连续可导,但当输入值较大或较小时其梯度值极小,也会出现梯度消失的问题,另外由于其数据分布是以0为中心的,因此更容易收敛,在某些特定网络结构(如RNN)中,这种以0为中心对称分布,同时包含了负数值的激活函数是有帮助的。

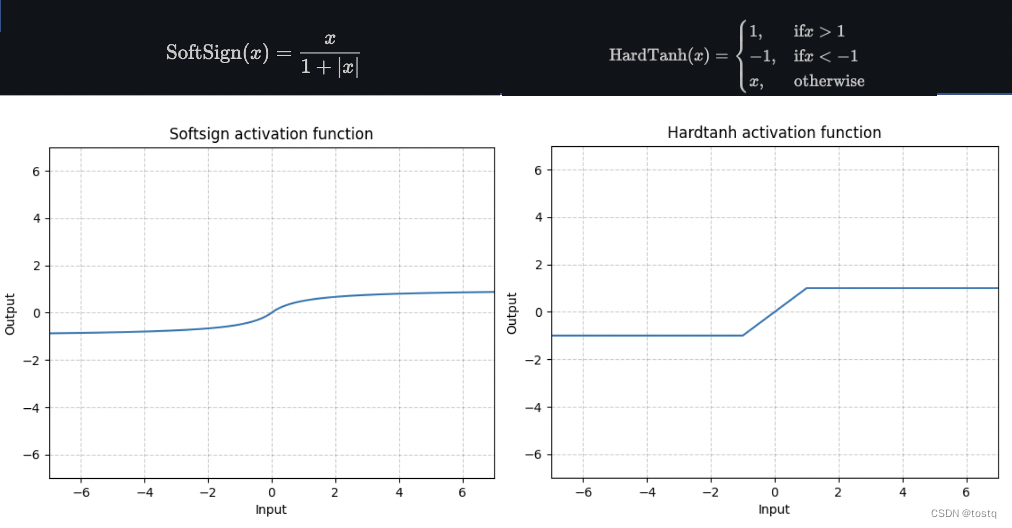

3. 类Tanh激活函数

上图的两个函数类似于tanh函数,其值范围在-1~1之间, 数据分布以0为中间,只是softsign函数更为平滑在一定程度上能减少tanh函数的梯度消失问题,会带来更为高效的训练,但其梯度计算相较于tanh更为复杂。hardtanh函数的梯度计算更为简单,但其分布偏硬,当权重参数值保持在一个偏小范围时,其也会有非常好的收敛效果(否则更容易陷入梯度消失问题)。

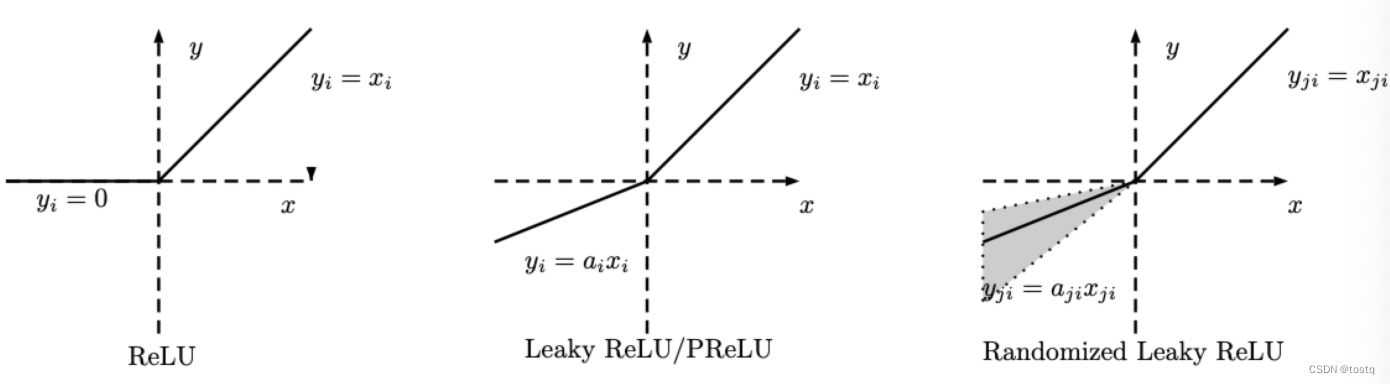

4. ReLU激活函数

Relu函数是更为常用的激活函数,很多人认为当不知道应该选择什么激活函数时,relu函数是默认的选择。relu函数首先的优点是其梯度计算很简单,梯度在大于0的情况下处处为1,可以加速模型的训练,另外其也不会存在梯度消费的问题。

但是其当小于0时输出为0,会造成神经元死亡现象(dying ReLU problem),可能会减少神经元的表达,同时会阻断梯度的回传,可能会造成训练困难,但从另一方面来说,其类似于L1正则化,增加了模型的稀疏性,会带来dropout相似的效果,增加模型的泛化性。

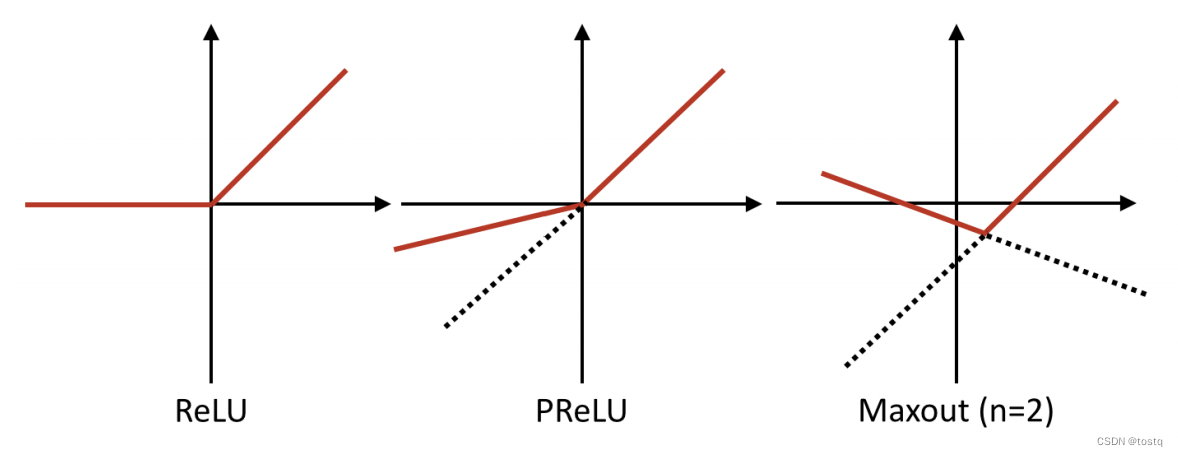

5. ReLU激活函数的变种

上图ReLU函数的一系列变种函数,其解决ReLU神经元死亡现象(dying ReLU problem),对于输入值小于0时,添加了一个a<1的线性系数,其中Leaky ReLU函数这个系数a值是固定的较小值,而PRelu这个系数a值是一个模型可训练的参数,RReLU函数这个系数a值是随机采样得到的。

特别是对于小型网络,应用Leaky ReLU函数是很有必要的,能让输出值小于0部分梯度也能回传,可以帮忙模型更好的训练。

与PReLU函数类似的是Maxout函数,其提供了更多可学习参数,号称可以拟合任何的凸激活函数,但是其带来了更多的参数,增加了模型的学习难度。

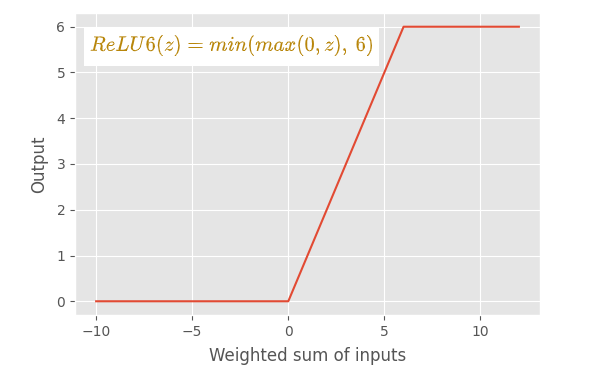

ReLU函数另一个变种是对ReLU函数做了向上截断(如下),这是因为ReLU系列函数存在scale-invariant的特性即当输入增加10倍,输出也会增加10倍,由于其只输出大于0的值,因此当各层权重值加大时,其输出值会累计膨胀,称之为bias shift,造成学习上的困难。

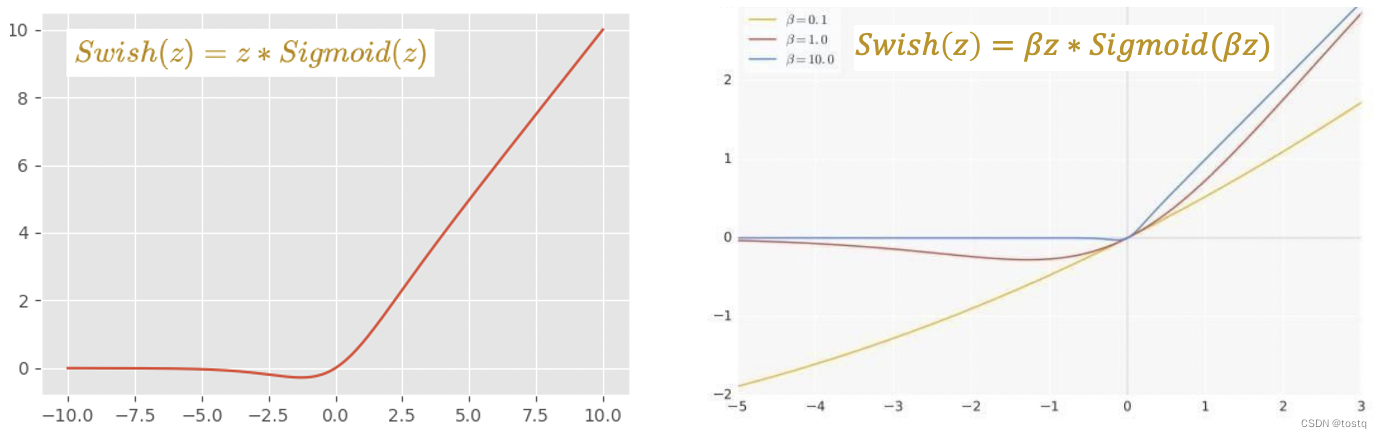

ReLU另一个类似的激活函数是Swish函数, 其是由sigmoid函数再乘以输入变量得到,但在图形上类似于ReLU但为平滑,同时通过引入变量,当

值越大其越趋近于ReLU函数,当其值越小,其越趋近于线性函数,这个

可以作为一个可以训练学习的参数,一些研究通过实验表明特别在大规模深度神经网络中,其能取得比ReLU更好的效果。

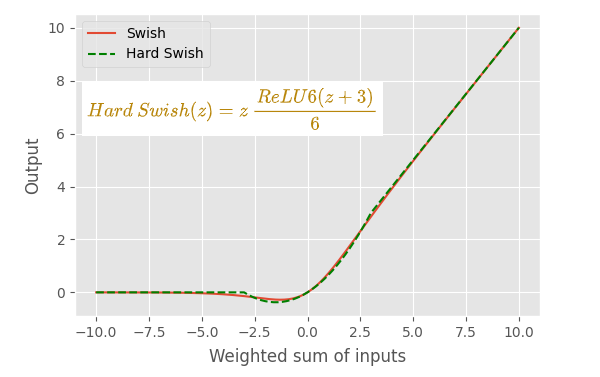

Swish函数另一个主要的问题是其梯度计算更为复杂,因此另一类似的激活函数hardSwish提供了更为简单的版本。

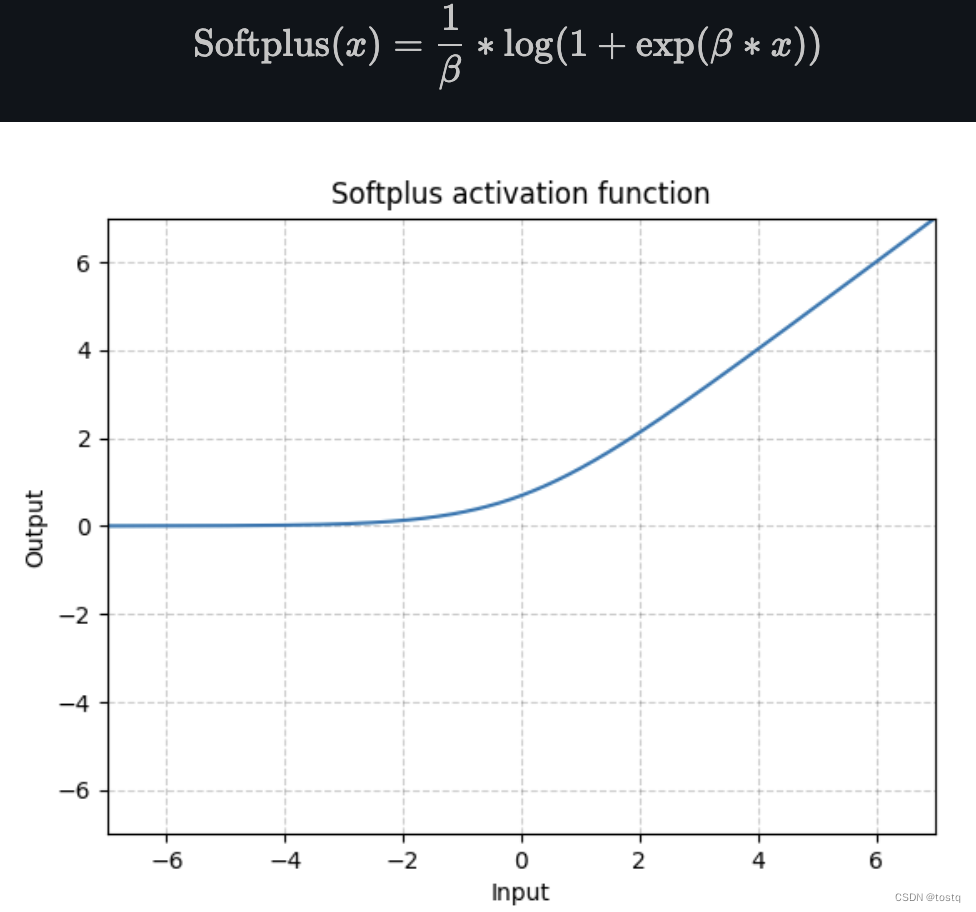

6. Softplus激活函数

softplus激活函数可以视为ReLU函数的平滑版本,当值越大其越趋近于ReLU函数,但是虽然其处处连续可导,但在实际上其并没有比ReLu更好的效果,一方面其计算梯度更为复杂,另外可能是Relu所带来的稀疏性对模型本身会增益。

7. ELU类激活函数

前文提到ReLU函数存在bias shift的问题,PReLU等变种激活函数可以解决这个问题,但是其存在线性负轴,因此对于噪声缺乏稳健性(神经元缺乏不激活状态),而ELU类激活函数更为平滑,函数处处连续可导,同时保证输出的均值为0,因此在训练时的收敛速度要高于ReLU,也不存在ReLU神经元死亡现象(dying ReLU problem),但是ELU函数的计算复杂度要高于ReLU,所以在测试时计算速度要大于ReLU。

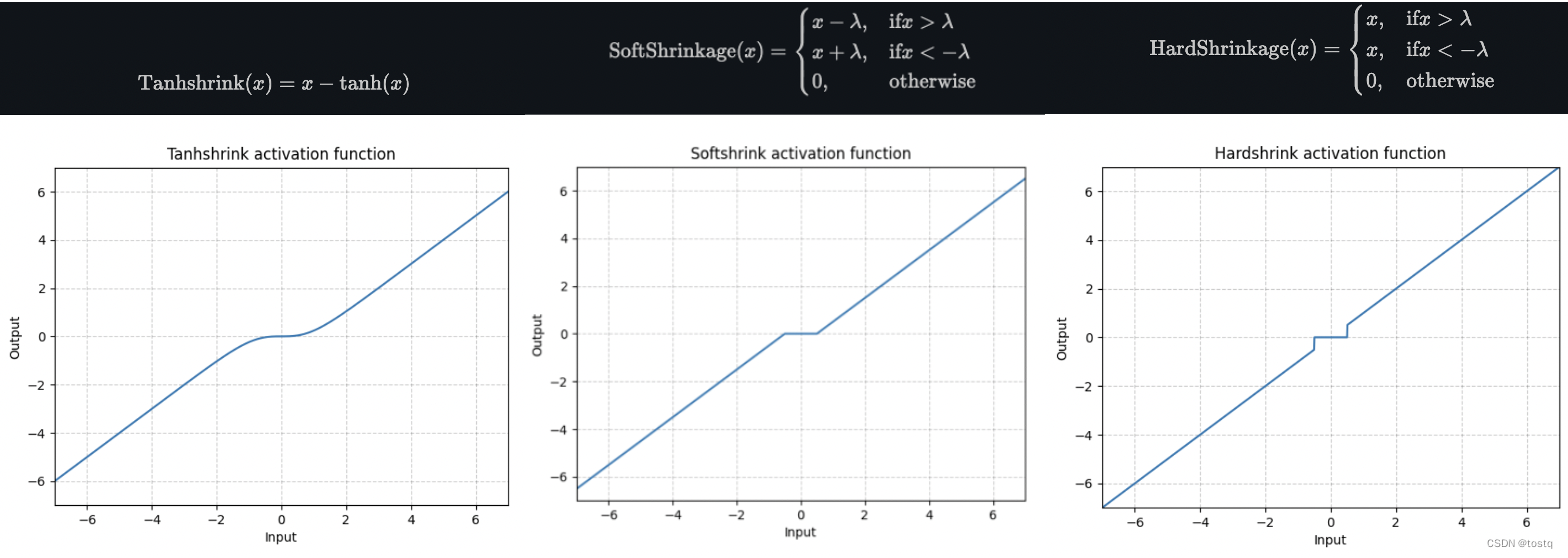

8. shrink类激活函数

shrink类函数几乎是很少用于隐层激活函数,其类似于一个线性函数,只不过在0附近有一个段非激活区域,在某些场景下会有用,比如用于软L1正则项的计算,或者在稀疏编码sparse coding,可以用于计算稀疏的潜在变量。

shrink类函数几乎是很少用于隐层激活函数,其类似于一个线性函数,只不过在0附近有一个段非激活区域,在某些场景下会有用,比如用于软L1正则项的计算,或者在稀疏编码sparse coding,可以用于计算稀疏的潜在变量。

总结:

对于激活函数的选择并没有放之四海皆准的法则,一般都需要根据模型需要去尝试。很多学者建议在初始情况下选择ReLU作为默认激活函数,之后可以尝试PReLU、Maxout、Swish等类ReLU函数进行优化,但这些方法都可能会增加模型的训练难度。

另外,sigmoid、tanh等其他类激活函数由于存在梯度消失等问题,很多学者并不推荐使用,但是通过结合BatchNorm等方法,在部分场景下会更适合,比如tanh函数适合某些需要负值输出的情况。