第七章.深度学习

第七章.深度学习

7.1 深度学习

深度学习是加深了层的深度神经网络。

1.加深层的好处

1).可以减少网络的参数数量

-

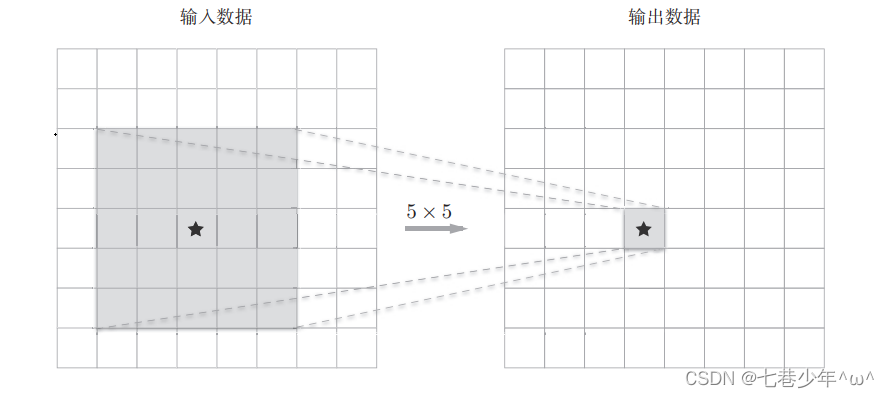

5*5的卷积运算示例:

-

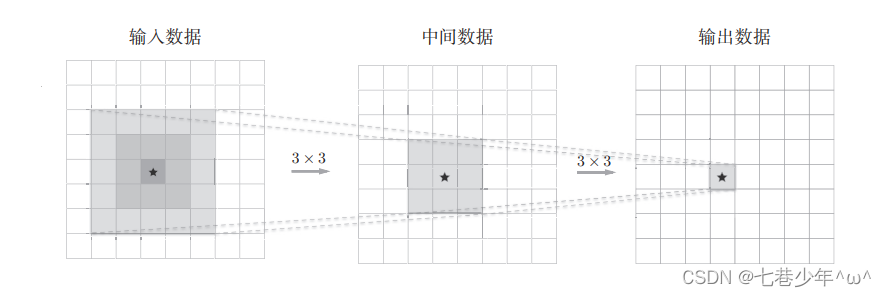

重复两次3*3的卷积层示例:

-

图像说明:

①.一次5 * 5的卷积运算的区域可以由两次3 * 3的卷积运算抵消,前者的参数数量25(55),后者的参数数量18(23*3),通过叠加卷积层,参数数量减少了。

②.叠加小型滤波器来加深网络的好处是可以减少参数的数量,扩大感受野(给神经元施加变化的某个局部空间区域)。

2).使学习更加高效

- 通过加深层,可以减少学习数据,从而高效的进行学习。(加深层可以分层次的传递信息)

2.深度学习网络

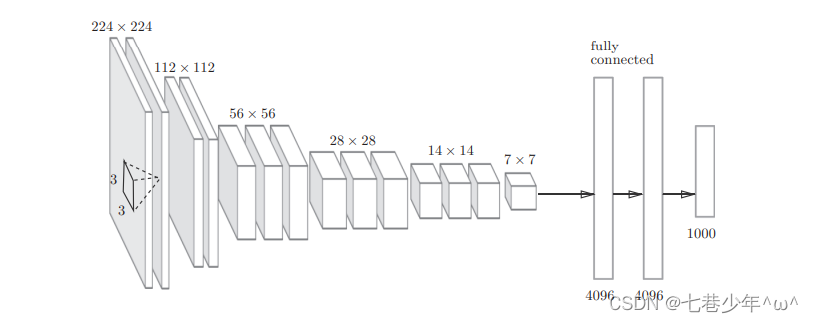

1).VGG

- VGG是由卷积层和池化层构成的基础CNN,它的特点在于将有权重的层(卷积层或全连接层)叠加至16层或19层。

- 注意:

VGG是基于3*3的小型滤波器卷积层运算是连续进行的,通过重复进行“卷积层重叠两次到四次,在通过池化层减半的”处理,最后经由全连接层输出结果。

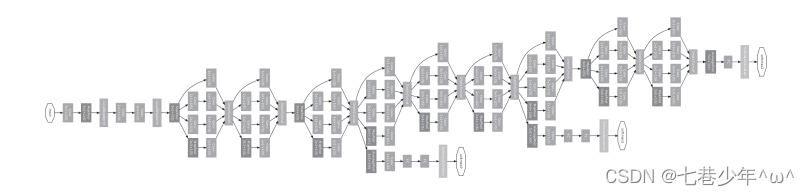

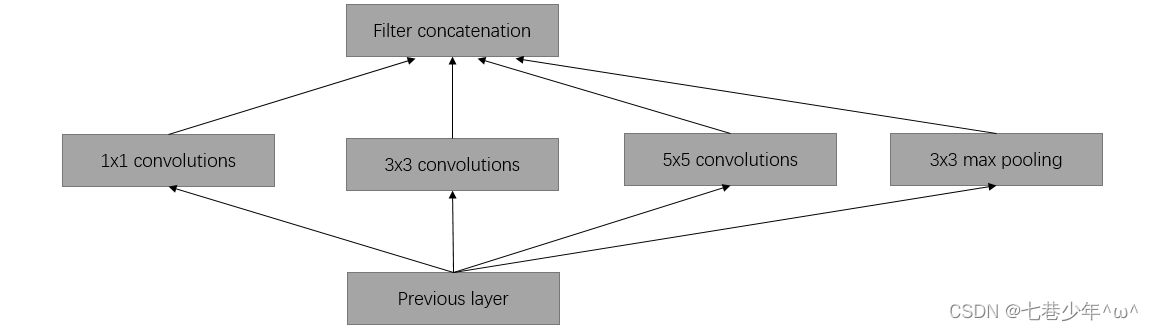

2).GoogLeNet

- 图中的矩形表示卷积层和池化层

- GoogLeNet的特征:网络不仅在纵向上有深度,在横向上也有广度(广度也称为“Inception结构”),Inception结构使用了多个大小不同的滤波器(和池化),最后再合并他们的结果。

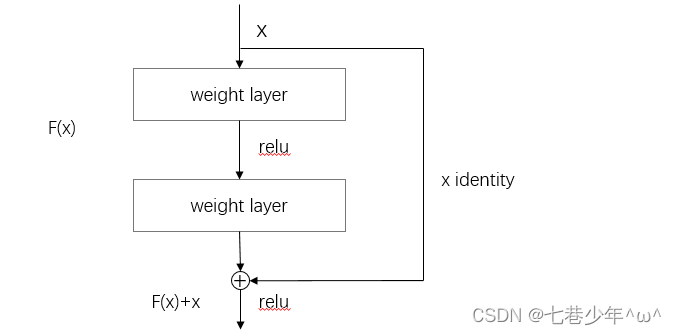

3).ResNet

- 在深度学习中,过度使用加深层的话,很多情况下学习将不能顺利进行,导致最终性能不佳,在ResNet中,为了解决这个问题,导入了“快捷结构”,导入这个结构后,就可以随着层的加深而不断提升性能。

- 图像说明:

在连续2层的卷积层中,将输入x跳转至两层后的输出,通过“快捷结构”,原来的2层卷积层的输出F(x)变成了F(x)+x,即使加深层,也能高效的学习,这是因为,通过快捷结构,反向传播时信号可以无衰减的传递。