每日学术速递4.30

CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Subjects: cs.CV

1.Masked Frequency Modeling for Self-Supervised Visual Pre-Training(ICLR 2023)

标题:用于自监督视觉预训练的掩蔽频率建模

作者:Jiahao Xie, Wei Li, Xiaohang Zhan, Ziwei Liu, Yew Soon Ong, Chen Change Loy

文章链接:https://arxiv.org/abs/2206.07706

项目代码:https://github.com/Jiahao000/MFM

摘要:

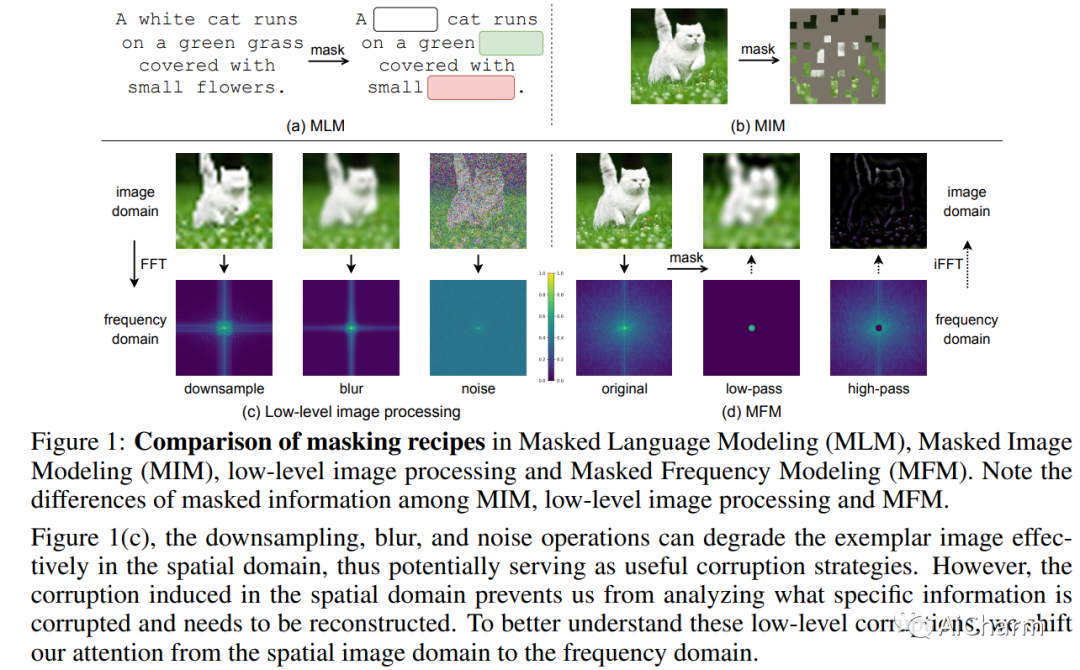

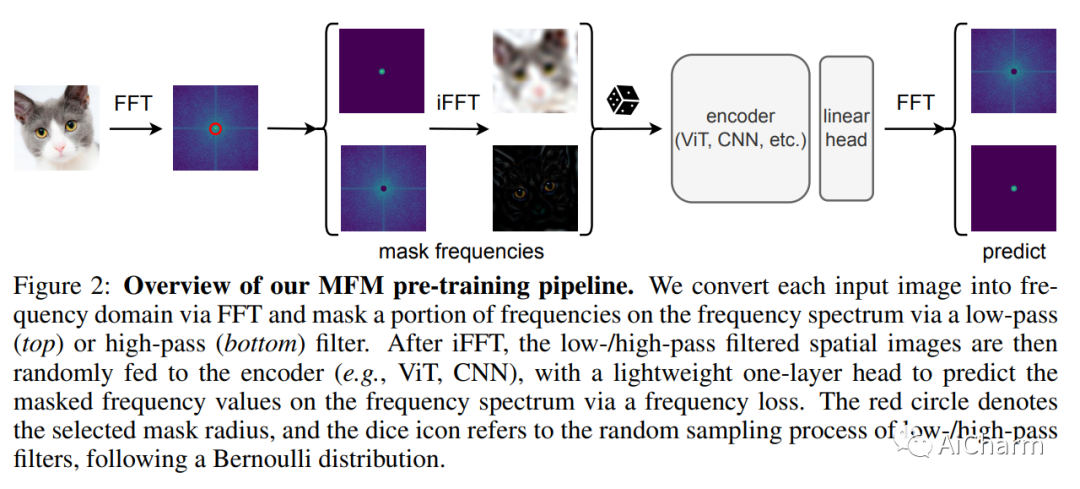

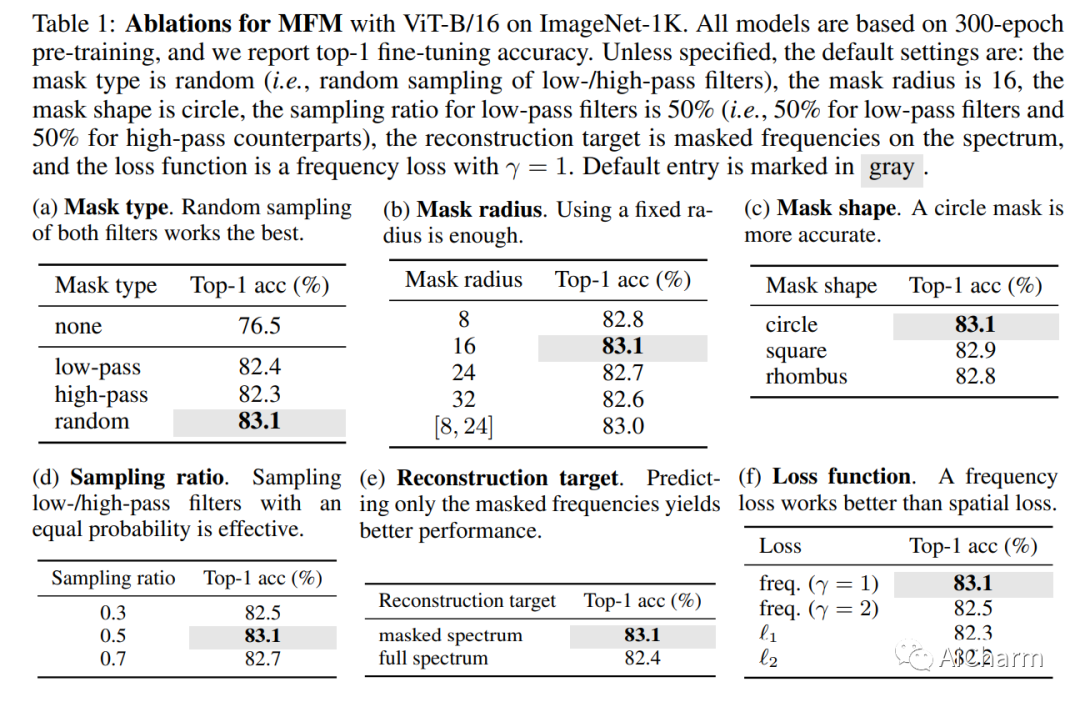

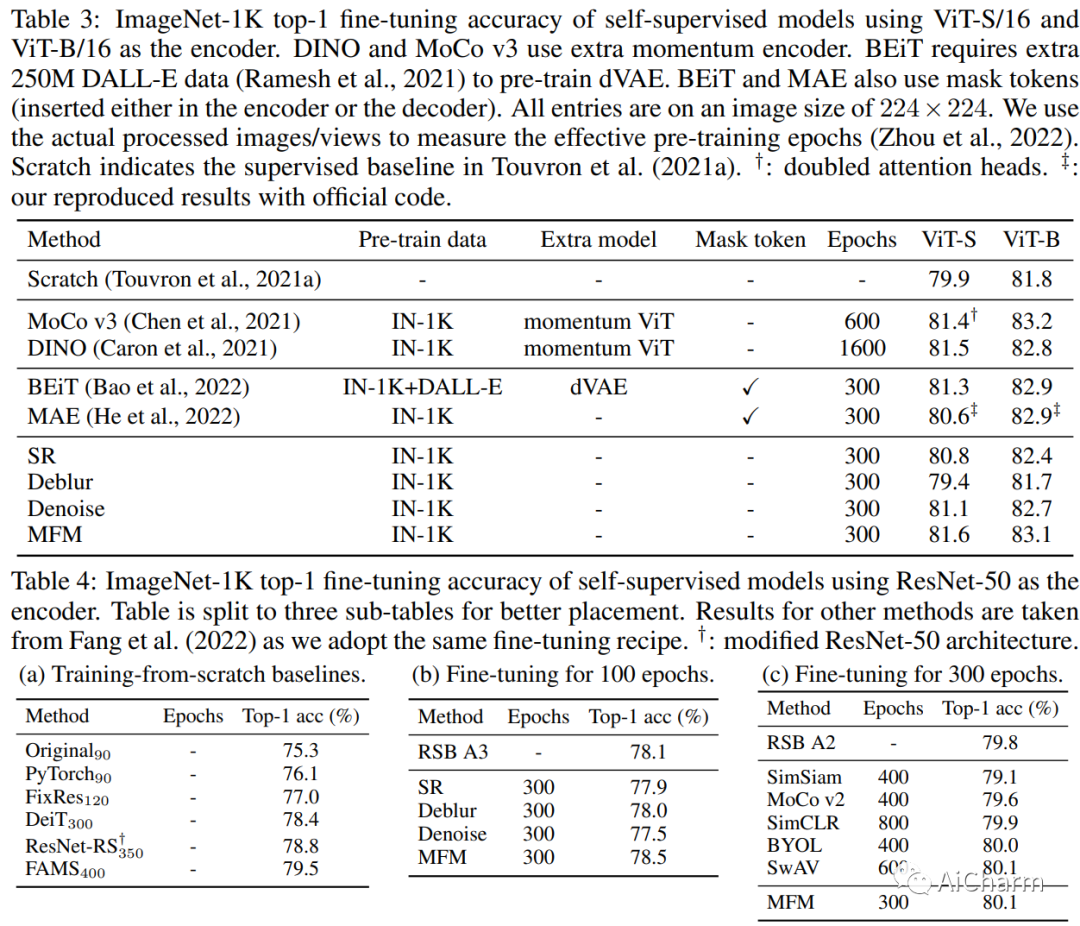

我们提出了掩蔽频率建模 (MFM),这是一种基于频域的统一方法,用于视觉模型的自监督预训练。在本文中,我们没有将掩码标记随机插入到空间域的输入嵌入中,而是将视角转移到频域。具体来说,MFM 首先屏蔽掉输入图像的一部分频率分量,然后预测频谱上缺失的频率。我们的主要见解是,由于存在大量空间冗余,预测频域中的掩码分量更适合揭示底层图像模式,而不是预测空间域中的掩码块。我们的研究结果表明,通过正确配置掩码和预测策略,高频成分中的结构信息和低频对应物之间的低级统计信息都有助于学习良好的表示。MFM 首次证明,对于 ViT 和 CNN,即使不使用以下任何一种,一个简单的非 Siamese 框架也可以学习有意义的表示:(i)额外数据,(ii)额外模型,(iii)mask token。图像分类和语义分割的实验结果,以及几个鲁棒性基准测试表明,与最近的蒙版图像建模方法相比,MFM 具有竞争力的性能和先进的鲁棒性。此外,我们还从统一频率的角度全面研究了经典图像恢复任务对表示学习的有效性,并揭示了它们与我们的 MFM 方法的有趣关系。

Subjects: cs.LG

2.AudioGPT: Understanding and Generating Speech, Music, Sound, and Talking Head

标题:AudioGPT:理解和生成语音、音乐、声音和说话头

作者:Rongjie Huang, Mingze Li, Dongchao Yang, Jiatong Shi, Xuankai Chang

文章链接:https://arxiv.org/abs/2304.12995

项目代码:https://github.com/AIGC-Audio/AudioGPT

摘要:

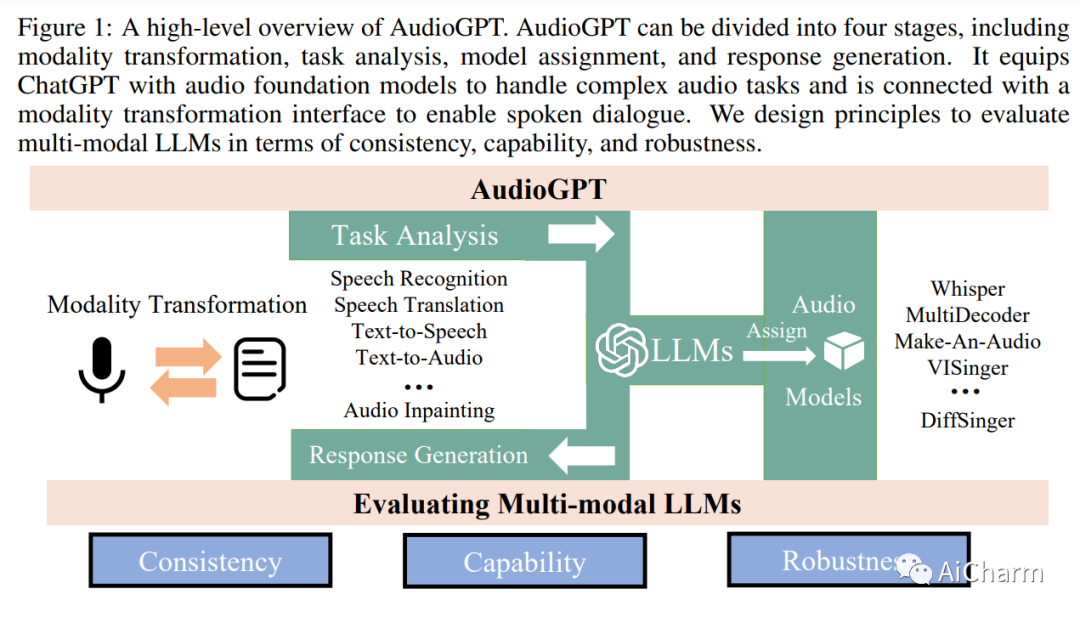

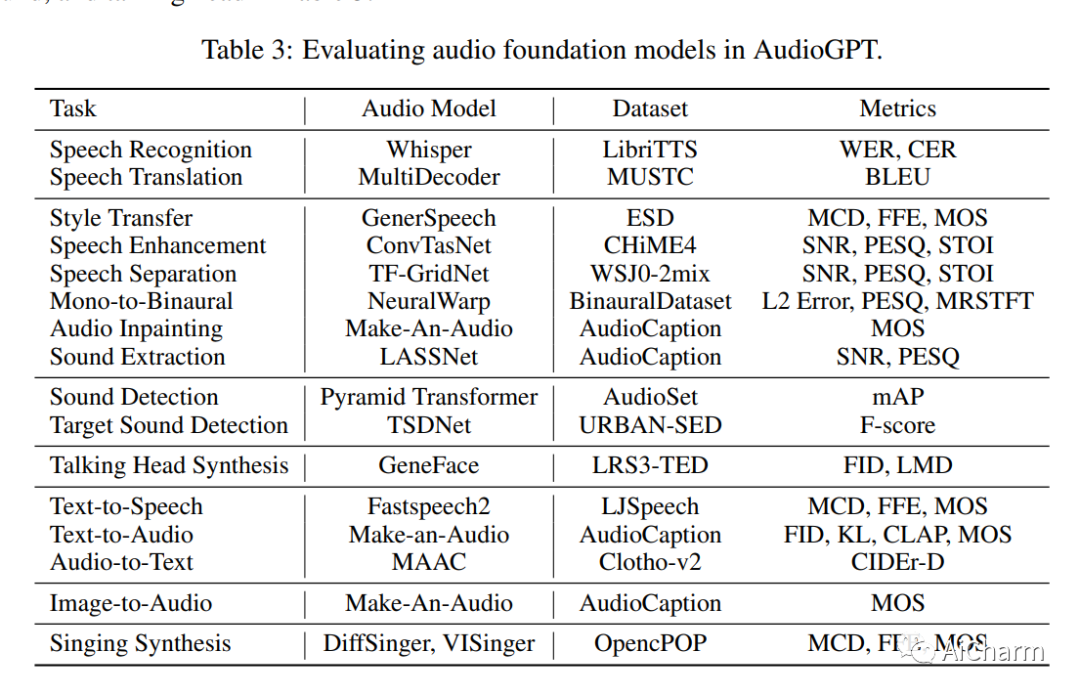

大型语言模型 (LLM) 在各种领域和任务中展现出非凡的能力,挑战着我们对学习和认知的理解。尽管最近取得了成功,但目前的 LLM 无法处理复杂的音频信息或进行口头对话(如 Siri 或 Alexa)。在这项工作中,我们提出了一个名为 AudioGPT 的多模态 AI 系统,它通过 1) 基础模型来补充 LLM(即 ChatGPT),以处理复杂的音频信息并解决大量的理解和生成任务;2) 支持语音对话的输入/输出接口(ASR、TTS)。随着对评估人类意图理解和与基础模型合作的多模式 LLM 的需求不断增加,我们概述了原则和过程,并在一致性、能力和稳健性方面测试了 AudioGPT。实验结果证明了 AudioGPT 在解决 AI 任务方面的能力,包括在多轮对话中理解和生成语音、音乐、声音和说话的头部,这使人类能够前所未有地轻松创建丰富多样的音频内容。

Subjects: cs.CL

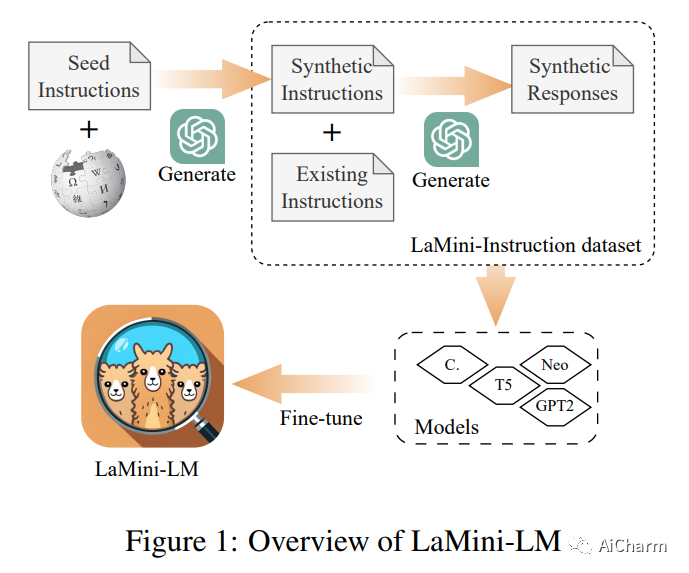

3.LaMini-LM: A Diverse Herd of Distilled Models from Large-Scale Instructions

标题:LaMini-LM:来自大规模指令的各种提炼模型

作者:Minghao Wu, Abdul Waheed, Chiyu Zhang, Muhammad Abdul-Mageed, Alham Fikri Aji

文章链接:https://arxiv.org/abs/2304.14402

项目代码:https://github.com/mbzuai-nlp/LaMini-LM

摘要:

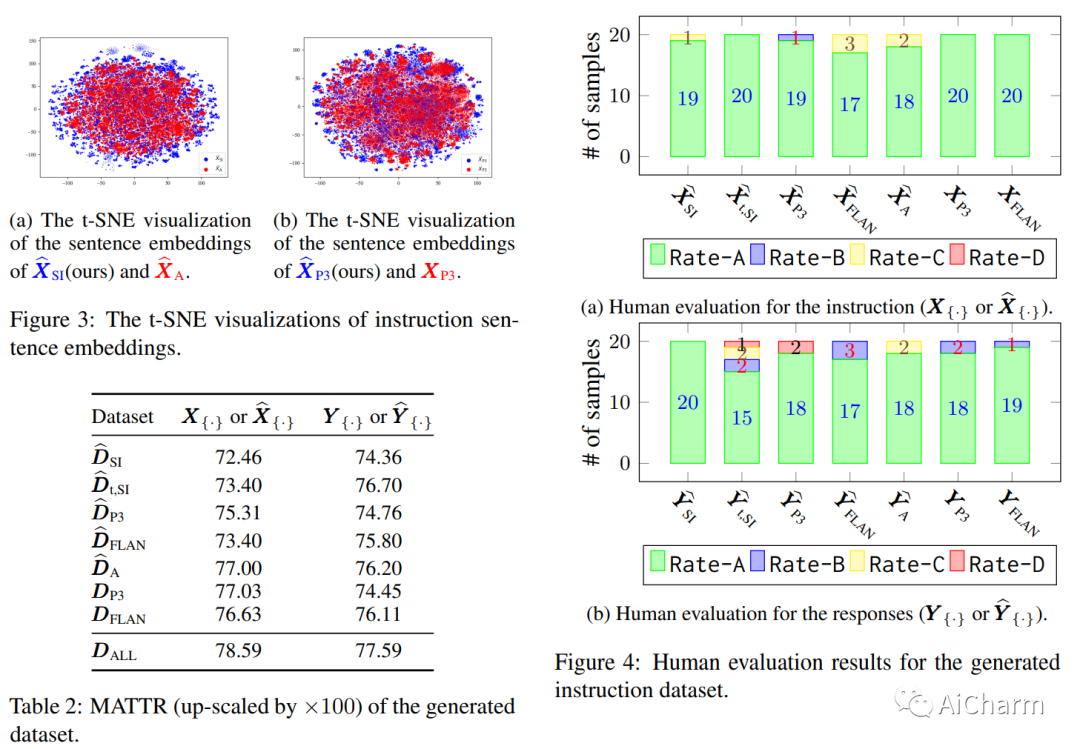

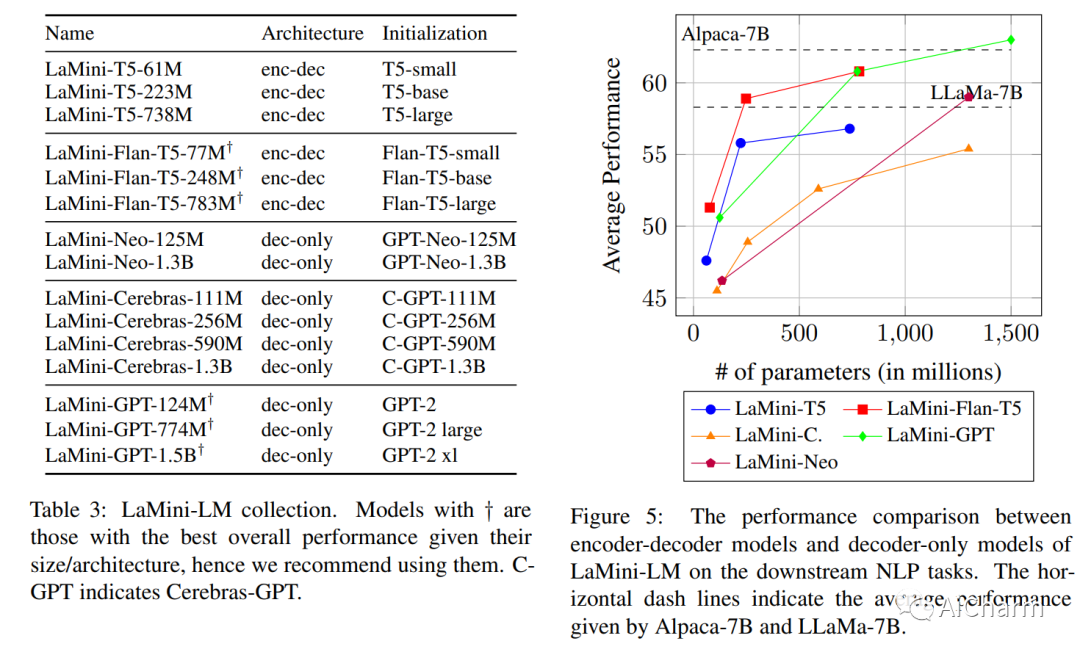

具有指令微调的大型语言模型 (LLM) 展示了卓越的生成能力。然而,这些模型是资源密集型的。为了缓解这个问题,我们探索从指令调整的 LLM 中提炼知识到更小的 LLM。为此,我们基于现有指令和新生成的指令精心开发了大量 2.58M 指令集。除了规模庞大之外,我们还设计了涵盖广泛主题的说明以确保。对我们的指令数据的彻底调查证明了它们的多样性,我们使用 gpt-3.5-turbo 为这些指令生成响应。然后,我们利用这些指令来调整大量模型,称为 LaMini-LM,大小不一,来自编码器-解码器以及仅解码器系列。我们自动(在 15 个不同的 NLP 基准测试中)和手动评估我们的模型。结果表明,我们提出的 LaMini-LM 与竞争基线相当,但尺寸却小了近 10 倍。

更多Ai资讯:公主号AiCharm