自建知识库,向量数据库 体系建设(二)之BERT 与.NET 8

在.NET 4.8 中集成 BERT:基于ML.NET与 ONNX 的实践指南

using System;

using System.Collections.Generic;

using System.Linq;

using Microsoft.ML;

using Microsoft.ML.Transforms.Onnx;namespace BertDotNet48Integration

{class Program{// BERT模型路径(请替换为实际的ONNX模型路径)private const string BertModelPath = @"D:\pretrained_models\bert-base-uncased.onnx";// 测试文本private const string TestText = "BERT is a powerful natural language processing model.";static void Main(string[] args){try{// 1. 初始化ML上下文var mlContext = new MLContext();// 2. 定义输入输出数据结构// BERT输入包含三个关键向量public class BertInput{[ColumnName("input_ids")]public long[] InputIds { get; set; }[ColumnName("attention_mask")]public long[] AttentionMask { get; set; }[ColumnName("token_type_ids")]public long[] TokenTypeIds { get; set; }}// BERT输出(最后一层隐藏状态)public class BertOutput{[ColumnName("last_hidden_state")]public float[,] LastHiddenState { get; set; }}// 3. 创建BERT处理管道var pipeline = mlContext.Transforms.ApplyOnnxModel(outputColumnNames: new[] { "last_hidden_state" },inputColumnNames: new[] { "input_ids", "attention_mask", "token_type_ids" },modelFile: BertModelPath,gpuDeviceId: 0, // 0表示使用第一个GPU,-1表示使用CPUfallbackToCpu: true // 当GPU不可用时自动切换到CPU);// 4. 文本预处理(生成符合BERT要求的输入向量)var (inputIds, attentionMask, tokenTypeIds) = PreprocessText(TestText);// 5. 准备输入数据var inputData = new BertInput{InputIds = inputIds,AttentionMask = attentionMask,TokenTypeIds = tokenTypeIds};var dataView = mlContext.Data.LoadFromEnumerable(new[] { inputData });// 6. 执行BERT推理var transformer = pipeline.Fit(dataView);var result = transformer.Transform(dataView);// 7. 提取并展示结果var output = mlContext.Data.CreateEnumerable<BertOutput>(result, reuseRowObject: false).First();Console.WriteLine($"原始文本: {TestText}");Console.WriteLine($"BERT输出维度: {output.LastHiddenState.GetLength(0)} × {output.LastHiddenState.GetLength(1)}");Console.WriteLine($"[CLS]向量前5个值: {string.Join(", ", Enumerable.Range(0, 5).Select(i => output.LastHiddenState[0, i].ToString("F4")))}");}catch (Exception ex){Console.WriteLine($"执行出错: {ex.Message}");}}/// <summary>/// 文本预处理:将文本转换为BERT所需的输入向量/// 实际应用中建议使用Python的Hugging Face分词器生成这些向量/// </summary>private static (long[] inputIds, long[] attentionMask, long[] tokenTypeIds) PreprocessText(string text){// 这里是简化示例,实际应用需使用BERT分词器// 以下值为"[CLS] bert is a powerful natural language processing model . [SEP]"的编码结果return (inputIds: new long[] { 101, 14324, 2003, 1037, 2471, 3019, 2653, 3673, 2460, 1012, 102 },attentionMask: new long[] { 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1 },tokenTypeIds: new long[] { 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0 });}}

}

BERT 模型作为自然语言处理领域的革命性突破,其强大的上下文理解能力已被广泛应用于文本分类、情感分析、命名实体识别等场景。对于仍在使用.NET 4.8 框架的开发团队而言,借助ML.NET和 ONNX Runtime 工具,无需迁移至.NET Core 即可实现 BERT 模型的集成。本文将基于实际代码示例,详细介绍在.NET 4.8 环境中使用 BERT 的完整流程。

一、技术选型与环境准备

.NET 4.8 对 BERT 的支持得益于其对.NET Standard 2.0 的兼容,这使得现代机器学习库能够直接集成。实践中主要依赖两个核心工具:

- ML.NET:微软推出的跨平台机器学习框架,提供了

BertOnnxTransformer组件专门处理 BERT 模型 - ONNX Runtime:用于加载和运行 ONNX 格式模型的高性能引擎,支持 CPU/GPU 加速

环境配置步骤:

- 确保安装.NET Framework 4.8 开发环境(Visual Studio 2019 及以上版本)

- 通过 NuGet 安装必要包:

Microsoft.ML(1.5 + 版本)Microsoft.ML.OnnxTransformer- (可选)

Microsoft.ML.OnnxRuntime.Gpu(如需 GPU 加速)

- 准备 ONNX 格式的 BERT 模型:可从 Hugging Face 下载预训练模型后,使用

transformers.onnx工具转换为 ONNX 格式

二、基于ML.NET的 BERT 集成实现

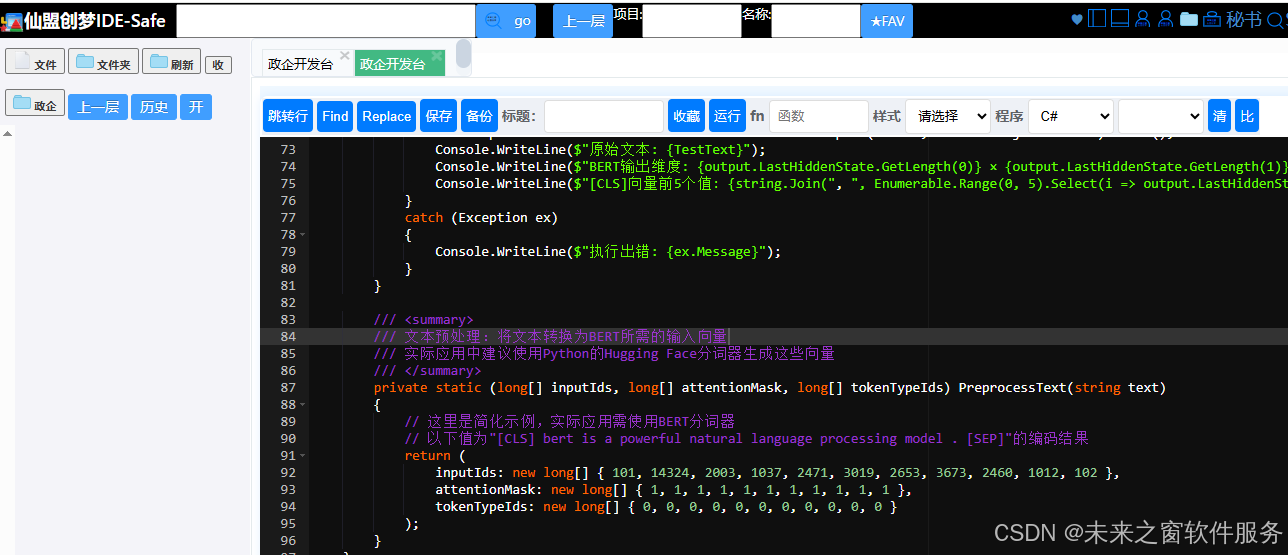

ML.NET提供了高层封装,简化了 BERT 模型的调用流程。以下是完整实现代码,包含数据结构定义、模型加载和推理过程:

使用ML.NET在.NET 4.8中集成BERT

V1

创建时间:19:45

代码解析

上述实现包含三个核心环节:

-

数据结构定义:

BertInput类对应 BERT 模型的三个标准输入(输入 ID、注意力掩码、段落 ID),BertOutput类用于接收模型输出的隐藏状态向量。 -

管道构建:

ApplyOnnxModel方法配置了 ONNX 模型路径、输入输出列映射及硬件加速选项,实现了 BERT 模型的加载与推理配置。 -

文本预处理:将原始文本转换为 BERT 可识别的数字向量(实际应用中建议通过 Python 的

transformers库完成,再传递给 C# 程序)。

三、基于 ONNX Runtime 的直接调用方案

对于需要更精细控制推理过程的场景,可直接使用 ONNX Runtime 调用 BERT 模型,代码如下:

使用ONNX Runtime直接调用BERT

V1

创建时间:19:45

与ML.NET方案的对比

- 灵活性:ONNX Runtime 方案允许直接操作张量,适合需要自定义推理流程的场景

- 性能:省去ML.NET的封装层,在高并发场景下可能有微幅性能优势

- 复杂度:需要手动管理张量维度和模型输入输出映射,对开发者要求更高

四、实践中的关键注意事项

-

模型预处理:BERT 对输入格式有严格要求(如最大序列长度、特殊标记 [CLS] 和 [SEP]),建议使用 Python 的

transformers库完成分词和向量生成,再传递给.NET 程序处理。 -

硬件加速配置:

- GPU 加速需安装对应版本的 CUDA 和 cuDNN,并使用

Microsoft.ML.OnnxRuntime.Gpu包 - 生产环境建议通过配置文件动态切换 CPU/GPU 模式,避免硬件依赖冲突

- GPU 加速需安装对应版本的 CUDA 和 cuDNN,并使用

-

性能优化:

- 模型加载成本高(约 1-2 秒),建议应用启动时初始化一次并全局复用

- 批量处理文本可显著提升吞吐量,将多个句子打包为一个批次输入

-

模型选择:对于资源有限的环境,可选择蒸馏版 BERT(如 DistilBERT),在精度损失较小的情况下减少 50% 的参数量和推理时间。

结语

.NET 4.8 凭借对.NET Standard 2.0 的支持,为 BERT 等现代 NLP 模型的集成提供了可行路径。通过ML.NET或 ONNX Runtime,开发者可以在不升级框架的情况下,为现有系统赋予强大的自然语言处理能力。实际应用中需根据项目需求选择合适的集成方案,并重点关注预处理准确性和硬件资源配置,以实现性能与功能的平衡。对于有长期维护需求的系统,迁移至.NET 6 + 将获得更完善的生态支持和性能优化,但在过渡期内,上述方案足以满足大多数 BERT 集成需求。

阿雪技术观

在科技发展浪潮中,我们不妨积极投身技术共享。不满足于做受益者,更要主动担当贡献者。无论是分享代码、撰写技术博客,还是参与开源项目维护改进,每一个微小举动都可能蕴含推动技术进步的巨大能量。东方仙盟是汇聚力量的天地,我们携手在此探索硅基生命,为科技进步添砖加瓦。

Hey folks, in this wild tech - driven world, why not dive headfirst into the whole tech - sharing scene? Don't just be the one reaping all the benefits; step up and be a contributor too. Whether you're tossing out your code snippets, hammering out some tech blogs, or getting your hands dirty with maintaining and sprucing up open - source projects, every little thing you do might just end up being a massive force that pushes tech forward. And guess what? The Eastern FairyAlliance is this awesome place where we all come together. We're gonna team up and explore the whole silicon - based life thing, and in the process, we'll be fueling the growth of technology.